Với Pixel 3, Google đã tiến rất gần tới việc "tái định nghĩa" chụp ảnh trên smartphone

Có thể thiết kế hay cấu hình của Google Pixel 3 không có gì nổi bật, nhưng camera của nó, với những kỹ năng mới, sẽ khiến bất kỳ ai cũng phải kinh ngạc, dù bạn là dân nghiệp dư hay chuyên nghiệp.

Theo CNET, với bộ đôi smartphone Pixel 3 và Pixel 3 XL. Google đã tìm ra những cách mới, tận dụng cả phần mềm và phần cứng để khắc phục những thiếu sót của máy ảnh smartphone và đảm bảo hình ảnh cuối cùng trở nên đẹp hơn. Nếu như Pixel và Pixel 2 đã luôn nằm trong top những chiếc smartphone chụp ảnh đẹp nhất, Pixel 3 còn đi xa hơn thế.

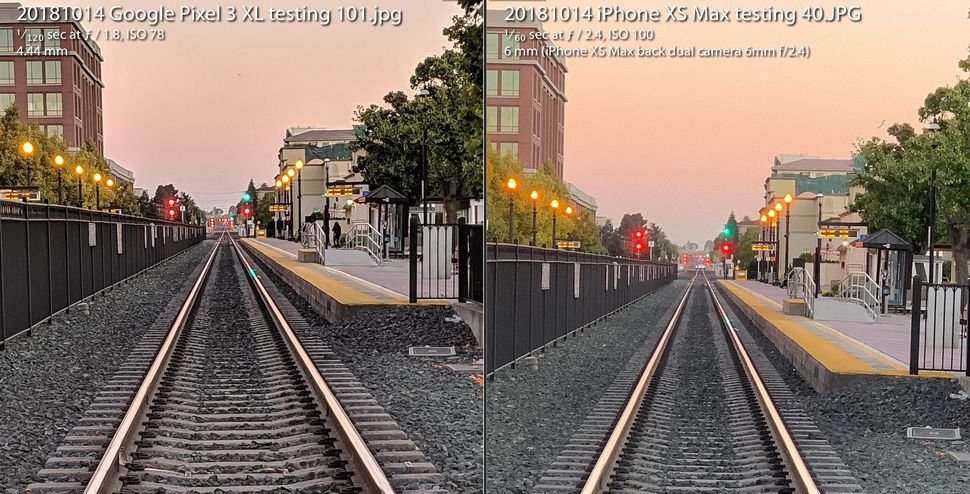

Camera trên Pixel 3 không hề thua kém flagship iPhone XS của Apple, dù chỉ có một ống kính ở phía sau. Nó không cần ống kính phụ để chụp được ảnh xóa phông đẹp, không phụ thuộc vào đèn flash khi chụp ảnh thiếu sáng, và nó mang lại một kiểu ảnh raw mới cho phép nhiếp ảnh gia thỏa sức thể hiện sức sáng tạo của mình.

Tất cả những khả năng này xuất phát từ một lĩnh vực có tên là nhiếp ảnh điện toán, một thuật ngữ được tạo ra vào năm 2004 bởi một kỹ sư nổi tiếng của Google, Marc Leyvoy khi ông còn ở Stanford, trước khi ông làm toàn thời gian cho Google Research. Đã qua rồi cái ngày mà chúng ta định nghĩa nhiếp ảnh chỉ là ống kính và film.;

Giờ đây, máy tính cũng đóng vai trò quan trọng trong máy ảnh, tương tự như quang học. Và những gì chúng ta thấy ở hiện tại mới chỉ là sự khởi đầu.

Super Res Zoom

Khái niệm "zoom số" thường có danh tiếng không tốt. Bạn không thể "phóng to và làm nét" như trong phim Hollywood được đâu!

Đó là lý do tại sao các nhà sản xuất đang tập trung vào phát triển các giải pháp zoom quang học cao cấp, tiên tiến hơn, thường là ống kính thứ hai (hoặc ba, hay bốn) trên các điện thoại đến từ các hãng lớn như Apple, Samsung và LG Electronics. Trong khi đó, Pixel 3 của Google lại có một tính năng mới có tên là Super Res Zoom. Phương pháp này sẽ giúp chất lượng hình ảnh từ một camera duy nhất trên Pixel 3 sẽ "gần như tương đương" với camera thứ hai khi zoom quang học 2X, Levoy cho hay.

Cụ thể hơn, chúng ta sẽ nghiên cứu về cách nó hoạt động:

Mọi cảm biến hình ảnh đều có một mảng ghi lại cường độ ánh sáng mà mỗi pixel nhận thấy. Tuy nhiên, để ghi lại màu sắc, các nhà sản xuất máy ảnh đã đặt một hệ thống mô hình bàn cờ bộ lọc ở phía trước mỗi pixel. Bộ lọc Bayer này, được phát minh bởi Eastman Kodak vào những năm 1970, sẽ giúp mỗi pixel ghi lại màu đỏ, xanh lá hoặc xanh dương, 3 màu cơ bản có thể cấu trúc nên những bức ảnh số.

Có một vấn đề với bộ lọc Beyer là máy ảnh phải tạo các dữ liệu bổ sung cho mỗi pixel có cả ba màu, đỏ, xanh lá và xanh dương, không chỉ một trong chúng. Quá trình tính toán này, được gọi là demosaicing, sẽ giúp bạn thấy và chỉnh sửa hình ảnh, nhưng đó chỉ là quá trình một chiếc máy tính đưa ra dự đoán về cách làm sao điền các chi tiết cho từng pixel một cách chính xác nhất.

Super Res Zoom sẽ thu thập thêm nhiều thông tin ngay từ ban đầu. Nó sẽ gộp nhiều bức ảnh lại với nhau, tính toán sự di chuyển của tay bạn nhằm di chuyển chiếc điện thoại sao cho phù hợp để thu thập các dữ liệu màu đỏ, xanh lá và xanh dương cho mỗi thành phần trong cảnh. Nếu chiếc điện thoại của bạn được cố định trên tripod, Pixel 3 sẽ sử dụng hệ thống chống rung quang học bên trong để giả lập sự lung lay của khung cảnh, Levoy cho hay.

Kết quả cho ra các đường nét sắc nét hơn, màu sắc tốt hơn và không có demosaicing. Điều này giúp cho Pixel 3 có nền tảng tốt hơn khi thực hiện zoom số.

Super Res Zoom sẽ chỉ được kích hoạt tại zoom 1,2X hoặc hơn. Tại sao không hoạt động tại 1X? "Nó là vấn đề về hiệu năng", Levoy cho hay. Super Res Zoom sẽ khiến quá trình chụp ảnh trở nên chậm hơn và tiêu tốn nhiều năng lượng hơn.

Và Super Res Zoom sẽ không hoạt động với video, vì thế, nếu bạn muốn có độ chi tiết khi zoom thì camera thứ hai vẫn đáng giá hơn.

Quá trình xử lý file RAW mới, đảm bảo hình ảnh linh hoạt hơn

Hơn một thập kỉ trước, các hãng đã khám phá ra một sức mạnh trong chụp ảnh mới với định dạng ảnh thô (RAW) từ máy ảnh. Định dạng này sẽ lấy dữ liệu trực tiếp từ cảm biền mà không cần thêm bất cứ quá trình xử lý nào cả. Và chiếc smartphone Pixel 3 của Google cũng có thể mở rộng cuộc cách mạng đó sang điện thoại di động.

Điện thoại Android đã có khả năng chụp các bức ảnh raw từ năm 2014, khi Google hỗ trợ thêm định dạng ảnh DNG (Adobe Digital Negative) nhằm ghi lại các dữ liệu chưa xử lý. Nhưng giới hạn trong cảm biến hình ảnh trên smartphone đã gây trở ngại cho công nghệ này.

Máy ảnh SLR hay mirrorless thông thường sẽ có một cảm biến lớn, chính điều này sẽ giúp cho ảnh raw có nhiều ưu điểm nếu bạn thực hiện hậu kỳ trong các phần mềm chỉnh sửa hình ảnh như Adobe Lightroom. Thực tế, khi chụp JPEG, máy ảnh sẽ quyết định các quá trình như cân bằng màu sắc, độ sáng, giảm nhiễu, độ nét hay các tính chất khác của một bức ảnh. Trong khi đó, chụp raw sẽ cho phép các nhiếp ảnh gia kiểm soát toàn bộ những điều đó.

Tuy nhiên, trên các chiếc điện thoại di động, raw dường như chưa phát huy được lợi thế của mình, bởi cảm biến hình ảnh bên trong quá nhỏ, sẽ gây ra nhiều nhiễu và có dải tương phản động thấp, hoặc sự giới hạn trong khả năng bắt những điểm highlight sáng và những chi tiết tối. Ngày nay, các máy ảnh đã vượt qua vấn đề này bằng cách gộp nhiều bức ảnh vào một bức ảnh HDR (High-Dynamic Range). Cách của Google, HDR+, sẽ gộp tối đa 9 ảnh thiếu sáng, phương pháp mà Apple học tập với iPhone XS và XS Max.

Với Pixel 3, ứng dụng camera của Google đã có thể chụp ảnh raw, nhưng nó vẫn thông qua quá trình xử lý HDR đặc biệt của Google. Nếu bạn kích hoạt thiết lập DNG trong cài đặt của ứng dụng camera, Pixel 3 sẽ tạo ra một ảnh DNG đã được xử lý một vài thứ như HDR và giảm nhiễu mà không làm mất đi tính linh hoạt của file raw.

"Triết lý của chúng tôi với raw là sẽ không có bất cứ đánh đổi nào", Levoy cho biết. "Chúng tôi sẽ đưa cả Super Res Zoom và HDR+ vào những file raw này. Dải tương phản động sẽ rộng hơn một cách đáng kinh nhạc".

Dĩ nhiên, vẫn tồn tại những giới hạn. Nếu bạn zoom trên camera, những ảnh JPEG sẽ có nhiều pixel hơn so với DNG. Với JPEG, quá trình zoom trên Pixel 3 sẽ được kết hợp với công nghệ RAISR AI của riêng Google và thuật toán Lanczos truyền thống, Levoy cho hay, nhưng với raw, bạn sẽ phải tự thực hiện với zoom số.

Một điểm yếu khác của ảnh raw trên Pixel 3: Dù Google có thể sử dụng dữ liệu màu sắc phong phú của Super Res Zoom để bỏ qua demosaicing, nhưng hầu như các phần mềm chỉnh sửa ảnh chỉ có thể xử lý những file raw chưa qua quá trình demosaicing. Kết quả, Pixel 3 sẽ cho ra một hình ảnh DNG có lớp lọc màu Bayer.

"Những hình ảnh JPEG được chụp từ camera Pixel đôi khi sẽ có độ chi tiết hơn DNG", Levoy cho hay.

Các hình ảnh được chụp ra từ Pixel 3 cũng có dải tương phản động cao hơn cùng với cảm biến hình ảnh hoạt động tốt hơn khi so với chiếc Pixel 2 hồi năm ngoái, Isaac Reynolds, quản lý sản phẩm camera trên Google Pixel, tiết lộ.

Thấy rõ các khu vực tối trong ảnh bằng Night Sight

Tất cả các mẫu Pixel sử dụng chế độ HDR+ sẽ cho ra những hình ảnh có dải tương phản động tuyệt vời. Pixel 3 có bước tiến xa hơn với một công nghệ có tên là Night Sight khi chụp trong tối, dù tính năng này chưa được tung ra, Google cho hay.

"Night sight là phiên bản nâng cấp của HDR+", Levoy nói. Chế độ này sẽ chụp tối đa lên đến 15 khung hình, miễn là trong 1/3 giây. Camera sẽ gộp những khung hình này lại thành 1 bức ảnh duy nhất và xử lý những thứ như căn chỉnh khung hình hay điều chỉnh tránh tình trạng "bóng mờ" (ghosting) do các chi tiết khác nhau giữa các khung hình.

Thời gian phơi sáng 1/3 giây là khá lâu, ngay cả với chống rung quang học (OIS). Để tránh gặp phải các sự cố, Pixel 3 sử dụng một "cảm biến đo chuyển động". Nó sẽ theo dõi những hình ảnh và con quay hồi chuyển của camera để rút ngắn tốc độ màn trập, chống bị mờ nhòe khi camera hay chủ thể chuyển động.

"Trong thực tế, nó sẽ chụp ra những bức ảnh có độ chi tiết cao", Reynolds khẳng định.

Google cũng phải tìm ra một cách mới để nhận diện cân bằng trắng sao cho phù hợp, cân chỉnh lại các sắc thái khác nhau của bức ảnh dựa vào điều kiện ánh sáng như bóng râm ban ngày, bóng đèn huỳnh quang hay hoàng hôn. Google giờ đã sử dụng công nghệ AI để điều chỉnh cân bằng trắng, Levoy tiết lộ.

Gã khổng lồ phần mềm này dự định sẽ đưa tính năng này vào menu More nằm bên trong ứng dụng camera, nhưng cũng có thể sẽ đặt Night Sight ở một nơi nào đó dễ truy cập hơn. "Chúng tôi nhận ra rằng bạn có thể quên nó khi chụp trong điều kiện ánh sáng yếu", Reynolds cho biết. "Sẽ có một cách khác để dễ truy cập vào hơn".

Sử dụng AI để chụp chân dung

Pixel 2 ra mắt hồi năm ngoái chính là chiếc smartphone đầu tiên của Google có Pixel Visual Core, một vi xử lý do Google thiết kế nhằm tăng khả năng xử lý các tác vụ AI. Pixel 3 cũng được nâng cấp hơn, và năm nay, Google sử dụng nó cho các mục đích mới về chụp ảnh.

Pixel Visual Core cùng với HDR+ là công cụ hỗ trợ cho tính năng Lens có trên ứng dụng camera, cho phép bạn tìm kiếm dựa trên một bức ảnh hay nhận diện số điện thoại để thực hiện cuộc gọi.

Và năm nay, nó có một vai trò cực kỳ lớn trong chế độ chân dung đã được nâng cấp. Nó sẽ giúp bắt chước làm mờ hậu cảnh giống như những chiếc máy ảnh thông thường có thể cho ra bức ảnh có độ sâu trường ảnh nông. Apple đã tiên phong chế độ chân dung này bằng cách sử dụng hai camera để tính toán khoảng cách từ camera đến các thành phần trong khung cảnh. Google đã thực hiện điều này với một camera cùng cảm biến hình ảnh "dual pixel" để có thể cung cấp các thông tin độ sâu tương đương.

Nhưng giờ đây, Google sẽ giao toàn bộ công việc cho AI.

"Hậu cảnh sẽ bị làm mờ một cách thống nhất hơn, đặc biệt là các đối tượng nằm ở khoảng cách từ 1,5 tới 3 mét", Levoy cho biết.

Một ưu thế khác của AI: Google có thể "dạy" hệ thống này nhiều hơn nhằm tạo ra kết quả tốt hơn và đưa đến người dùng thông qua cập nhật phần mềm. Và Google không chỉ "dạy" hệ thống này nhận diện khuôn mặt, Levoy tiết lộ. "Phương pháp học độ sâu từ dual-pixel sẽ hoạt động với mọi cảnh, bao gồm cả hoa".

Pixel 3 cũng sẽ "nhúng" thông tin độ sâu vào những file JPEG, vì thế, bạn vẫn có thể chỉnh sửa độ sâu và lấy nét lại sau khi chụp bằng ứng dụng Google Photos.

AI cũng được sử dụng trong chế độ Top Shot, tính năng này sẽ kích hoạt khi camera nhận diện bất cứ khuôn mặt nào và sẽ chọn ra một bức ảnh duy nhất trong chuỗi các bức ảnh đã chụp. Thực tế, nó đã được đào tạo dựa trên một cơ sở dữ liệu 100 triệu bức ảnh khi con người cười hay thể hiện sự kinh ngạc.

Khả năng mới của con chip mới này cũng cho phép Pixel nhận diện đâu là khuôn mặt cùng cơ thể của con người và sẽ làm sáng cả hai lên một chút để đảm bảo bức ảnh trở nên dễ nhìn hơn, Reynolds tiết lộ.

"Chúng tôi gọi đó là flash bổ trợ tổng hợp", anh cho hay. "Nó mô phỏng những gì tấm hắt sáng có thể làm". Hắt sáng là một vật liệu mà các nhiếp ảnh gia chân dung hay sản phẩm sử dụng để phản chiếu ánh sáng vào chủ thể nhằm đạt độ sáng nhiều hơn".

Tương lai của nhiếp ảnh điện toán

Rõ ràng, nhiếp ảnh điện toán đang được đưa vào sâu hơn vào camera trên smartphone. Thuật ngữ này đã được sử dụng nhiều hơn, đến mức mà giám đốc tiếp thị của Apple, Phil Schiller, cũng phải đề cập đến nó khi sự kiện ra mắt iPhone XS diễn ra vào hồi tháng Chín.

Thế nhưng, chỉ có một công ty thực sự sử dụng đúng thuật ngữ đó. Levoy đã thực sự khiêm tốn về nó. Anh đã cho rằng công nghệ này đã phát triển hơn, vượt ra khỏi nghiên cứu của chính anh.

Anh cũng có rất nhiều ý tưởng khác và đặc biệt quan tâm đến thông tin độ sâu. Chẳng hạn, nhận biết được chính xác khoảng cách giữa chủ thể với ống kính sẽ giúp cải thiện tính năng flash bổ trợ tổng hợp hoặc giúp Google điều chỉnh lại cân bằng trắng cho các phần lân cận của cảnh,…

Vì vậy, bạn hoàn toàn có thể kỳ vọng chất lượng nhiếp ảnh tốt hơn nữa trên Pixel 4 (hay bất kỳ thiết bị nào khác mà Leyvoy, Reynolds cùng các đồng nghiệp đang nghiên cứu và phát triển).

"Chúng ta chỉ mới khai thác được một phần rất nhỏ tiềm năng của nhiếp ảnh điện toán và trí tuệ nhân tạo đối với 'chụp ảnh một chạm'", Levoy nói.

Minh Hùng