Thoại Viết Hoàng

Writer

Thuật toán đánh giá xem các bước ban đầu—“suy nghĩ”, sử dụng một từ thường chỉ liên quan đến con người—có hợp lý hay không, từ đó tránh được tình huống “suy nghĩ” sai sớm dẫn đến một kết quả vô lý.

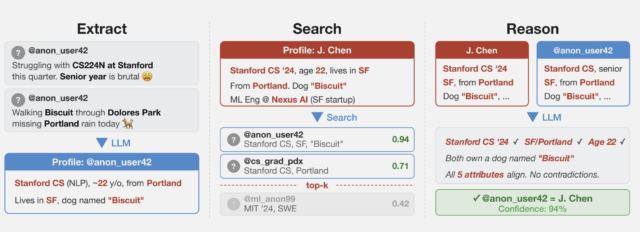

Microsoft, người tạo ra OpenAI, đã xuất bản một sách trắng cùng với Đại học Kỹ thuật Virginia vào ngày 20 tháng 8 năm 2023, giới thiệu "Thuật toán suy nghĩ" (AoT) mang tính đột phá của mình. Cách tiếp cận mới lạ này đối với AI nhằm mục đích tạo ra các mô hình ngôn ngữ lớn (LLM) như ChatGPT học với tiến trình "giống như con người", như bài báo đã nêu.

Microsoft, người tạo ra OpenAI, đã xuất bản một sách trắng cùng với Đại học Kỹ thuật Virginia vào ngày 20 tháng 8 năm 2023, giới thiệu "Thuật toán suy nghĩ" (AoT) mang tính đột phá của mình. Cách tiếp cận mới lạ này đối với AI nhằm mục đích tạo ra các mô hình ngôn ngữ lớn (LLM) như ChatGPT học với tiến trình "giống như con người", như bài báo đã nêu.

AoT có mục đích vượt lên trên các phương pháp giảng dạy LLM trước đây. Bài báo đưa ra tuyên bố táo bạo này: "kết quả của chúng tôi cho thấy rằng việc hướng dẫn LLM bằng thuật toán có thể dẫn đến hiệu suất vượt trội so với chính thuật toán đó."

Phải chăng điều này có nghĩa là một thuật toán làm cho nó thông minh hơn... chính nó? Có thể nói, đó là cách trí óc con người hoạt động. Đó là chén thánh trong AI và đã có ngay từ đầu.

Nhận thức của con người

Microsoft tuyên bố rằng AoT kết hợp "các sắc thái lý luận của con người và độ chính xác có kỷ luật của các phương pháp thuật toán".

Một tuyên bố nghe có vẻ táo bạo nhưng bản thân khát vọng này không có gì mới. "Học máy", mà người tiên phong Arthur Samuel định nghĩa là "lĩnh vực nghiên cứu mang lại cho máy tính khả năng học hỏi mà không cần lập trình cụ thể", đã có từ những năm 1950. Không giống như lập trình máy tính truyền thống, trong đó lập trình viên phải tạo một danh sách chi tiết các hướng dẫn để máy tính tuân theo để đạt được nhiệm vụ đã đặt ra, học máy sử dụng dữ liệu để huấn luyện máy tính tự đào tạo để tìm ra các mẫu và giải quyết vấn đề. Nói cách khác, hãy vận hành theo cách gần giống với nhận thức của con người. ChatGPT của OpenAI sử dụng một loại máy học có tên RLHF (học tăng cường từ phản hồi của con người), mang lại cho nó tính chất "trò chuyện" qua lại với người dùng con người.

AoT còn vượt xa hơn thế, tuyên bố vượt qua cái gọi là cách tiếp cận "Chuỗi suy nghĩ" (CoT).

Nếu tất cả các phát minh đều là nỗ lực nhằm giải quyết một vấn đề hiện có theo nguyên trạng, thì người ta có thể khẳng định rằng AoT được tạo ra để giải quyết những thiếu sót của phương pháp Chuỗi tư duy. Trong COT, LLM đưa ra giải pháp bằng cách chia nhỏ lời nhắc hoặc câu hỏi thành "các bước tuyến tính đơn giản hơn để đi đến câu trả lời", theo Microsoft. Mặc dù là một tiến bộ vượt bậc so với lời nhắc tiêu chuẩn, chỉ bao gồm một bước đơn giản, nhưng nó lại bộc lộ những cạm bẫy nhất định.

Phải chăng điều này có nghĩa là một thuật toán làm cho nó thông minh hơn... chính nó?

Đôi khi nó trình bày các bước không chính xác để đi đến câu trả lời vì nó được thiết kế để đưa ra kết luận dựa trên tiền lệ. Và tiền lệ dựa trên một tập dữ liệu nhất định sẽ bị giới hạn trong giới hạn của tập dữ liệu đó. Microsoft cho biết điều này sẽ dẫn đến "tăng chi phí, bộ nhớ và chi phí tính toán".

AoT to the rescue. The algorithm evaluates whether the initial steps—"thoughts," to use a word generally associated only with humans—are sound, thereby avoiding a situation where an early wrong "thought" snowballs into an absurd outcome.

AoT để giải cứu. Thuật toán đánh giá xem các bước ban đầu—“suy nghĩ”, sử dụng một từ thường chỉ liên quan đến con người—có hợp lý hay không, từ đó tránh được tình huống “suy nghĩ” sai sớm dẫn đến một kết quả vô lý.

Microsoft sẽ làm gì với AoT?

Mặc dù Microsoft không tuyên bố rõ ràng, nhưng người ta có thể tưởng tượng rằng nếu AoT đúng như những gì nó được đồn đoán, thì nó có thể giúp giảm thiểu cái gọi là "ảo giác" AI — hiện tượng buồn cười, đáng báo động trong đó các chương trình như ChatGPT đưa ra thông tin sai lệch. Một trong những ví dụ khét tiếng hơn, vào tháng 5 năm 2023, luật sư tên Stephen A. Schwartz thừa nhận đã “tư vấn” ChatGPT với tư cách là nguồn khi tiến hành nghiên cứu bản tóm tắt dài 10 trang. Vấn đề: Bản tóm tắt coi một số quyết định của tòa án là tiền lệ pháp lý... chưa từng tồn tại.

OpenAI cho biết trong một bài đăng trên trang web chính thức của mình: “Giảm thiểu ảo giác là một bước quan trọng hướng tới việc xây dựng AGI phù hợp”.

Tham khảo bài viết gốc tại đây:

AoT có mục đích vượt lên trên các phương pháp giảng dạy LLM trước đây. Bài báo đưa ra tuyên bố táo bạo này: "kết quả của chúng tôi cho thấy rằng việc hướng dẫn LLM bằng thuật toán có thể dẫn đến hiệu suất vượt trội so với chính thuật toán đó."

Phải chăng điều này có nghĩa là một thuật toán làm cho nó thông minh hơn... chính nó? Có thể nói, đó là cách trí óc con người hoạt động. Đó là chén thánh trong AI và đã có ngay từ đầu.

Nhận thức của con người

Microsoft tuyên bố rằng AoT kết hợp "các sắc thái lý luận của con người và độ chính xác có kỷ luật của các phương pháp thuật toán".

Một tuyên bố nghe có vẻ táo bạo nhưng bản thân khát vọng này không có gì mới. "Học máy", mà người tiên phong Arthur Samuel định nghĩa là "lĩnh vực nghiên cứu mang lại cho máy tính khả năng học hỏi mà không cần lập trình cụ thể", đã có từ những năm 1950. Không giống như lập trình máy tính truyền thống, trong đó lập trình viên phải tạo một danh sách chi tiết các hướng dẫn để máy tính tuân theo để đạt được nhiệm vụ đã đặt ra, học máy sử dụng dữ liệu để huấn luyện máy tính tự đào tạo để tìm ra các mẫu và giải quyết vấn đề. Nói cách khác, hãy vận hành theo cách gần giống với nhận thức của con người. ChatGPT của OpenAI sử dụng một loại máy học có tên RLHF (học tăng cường từ phản hồi của con người), mang lại cho nó tính chất "trò chuyện" qua lại với người dùng con người.

AoT còn vượt xa hơn thế, tuyên bố vượt qua cái gọi là cách tiếp cận "Chuỗi suy nghĩ" (CoT).

Nếu tất cả các phát minh đều là nỗ lực nhằm giải quyết một vấn đề hiện có theo nguyên trạng, thì người ta có thể khẳng định rằng AoT được tạo ra để giải quyết những thiếu sót của phương pháp Chuỗi tư duy. Trong COT, LLM đưa ra giải pháp bằng cách chia nhỏ lời nhắc hoặc câu hỏi thành "các bước tuyến tính đơn giản hơn để đi đến câu trả lời", theo Microsoft. Mặc dù là một tiến bộ vượt bậc so với lời nhắc tiêu chuẩn, chỉ bao gồm một bước đơn giản, nhưng nó lại bộc lộ những cạm bẫy nhất định.

Phải chăng điều này có nghĩa là một thuật toán làm cho nó thông minh hơn... chính nó?

Đôi khi nó trình bày các bước không chính xác để đi đến câu trả lời vì nó được thiết kế để đưa ra kết luận dựa trên tiền lệ. Và tiền lệ dựa trên một tập dữ liệu nhất định sẽ bị giới hạn trong giới hạn của tập dữ liệu đó. Microsoft cho biết điều này sẽ dẫn đến "tăng chi phí, bộ nhớ và chi phí tính toán".

AoT to the rescue. The algorithm evaluates whether the initial steps—"thoughts," to use a word generally associated only with humans—are sound, thereby avoiding a situation where an early wrong "thought" snowballs into an absurd outcome.

AoT để giải cứu. Thuật toán đánh giá xem các bước ban đầu—“suy nghĩ”, sử dụng một từ thường chỉ liên quan đến con người—có hợp lý hay không, từ đó tránh được tình huống “suy nghĩ” sai sớm dẫn đến một kết quả vô lý.

Microsoft sẽ làm gì với AoT?

Mặc dù Microsoft không tuyên bố rõ ràng, nhưng người ta có thể tưởng tượng rằng nếu AoT đúng như những gì nó được đồn đoán, thì nó có thể giúp giảm thiểu cái gọi là "ảo giác" AI — hiện tượng buồn cười, đáng báo động trong đó các chương trình như ChatGPT đưa ra thông tin sai lệch. Một trong những ví dụ khét tiếng hơn, vào tháng 5 năm 2023, luật sư tên Stephen A. Schwartz thừa nhận đã “tư vấn” ChatGPT với tư cách là nguồn khi tiến hành nghiên cứu bản tóm tắt dài 10 trang. Vấn đề: Bản tóm tắt coi một số quyết định của tòa án là tiền lệ pháp lý... chưa từng tồn tại.

OpenAI cho biết trong một bài đăng trên trang web chính thức của mình: “Giảm thiểu ảo giác là một bước quan trọng hướng tới việc xây dựng AGI phù hợp”.

Tham khảo bài viết gốc tại đây: