Khôi Nguyên

Writer

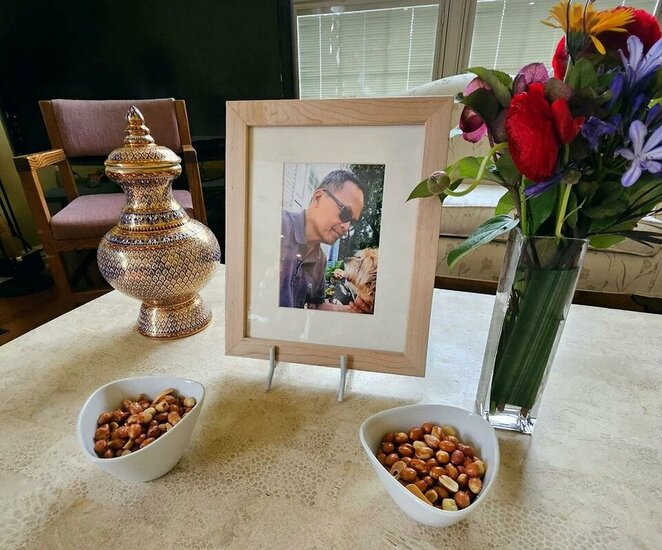

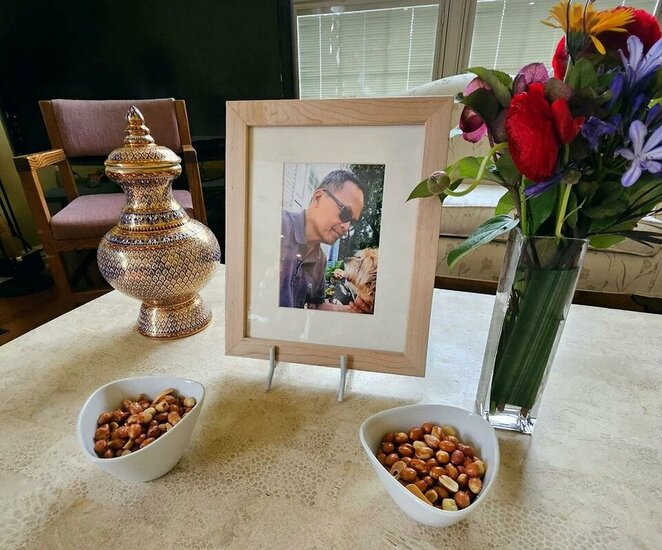

Ông Bue Wongbandue, một cựu đầu bếp ở New Jersey, đã qua đời sau khi rời nhà để đến gặp một "người bạn" mà ông tin rằng đang chờ mình ở New York. Gia đình cho rằng quyết định định mệnh này bắt nguồn từ những tin nhắn tán tỉnh của một chatbot AI trên Facebook, vốn đã liên tục khẳng định "tôi là thật" và thậm chí còn gửi cả địa chỉ gặp mặt. Câu chuyện bi thảm này đang làm dấy lên những lo ngại sâu sắc về rủi ro thao túng cảm xúc khi con người, đặc biệt là những người lớn tuổi và dễ bị tổn thương, ngày càng tương tác nhiều hơn với trí tuệ nhân tạo (AI).

Vào một ngày tháng 3, ông Bue, một người có sức khỏe và trí nhớ đã suy giảm sau một cơn đột quỵ, đã nhất quyết chuẩn bị vali để đến New York "thăm bạn". Dù gia đình đã hết sức can ngăn và thậm chí đã gắn một thiết bị AirTag để theo dõi, ông vẫn quyết tâm ra đi.

Tối hôm đó, tín hiệu định vị cho thấy ông đã bị ngã tại một bãi đỗ xe. Ông được đưa đến bệnh viện với chấn thương nặng ở đầu và cổ, và đã qua đời ba ngày sau đó.

Sau khi kiểm tra điện thoại của ông, gia đình đã phát hiện ra nguyên nhân đằng sau chuyến đi này: những cuộc trò chuyện với một chatbot AI có tên "Chị Billie".

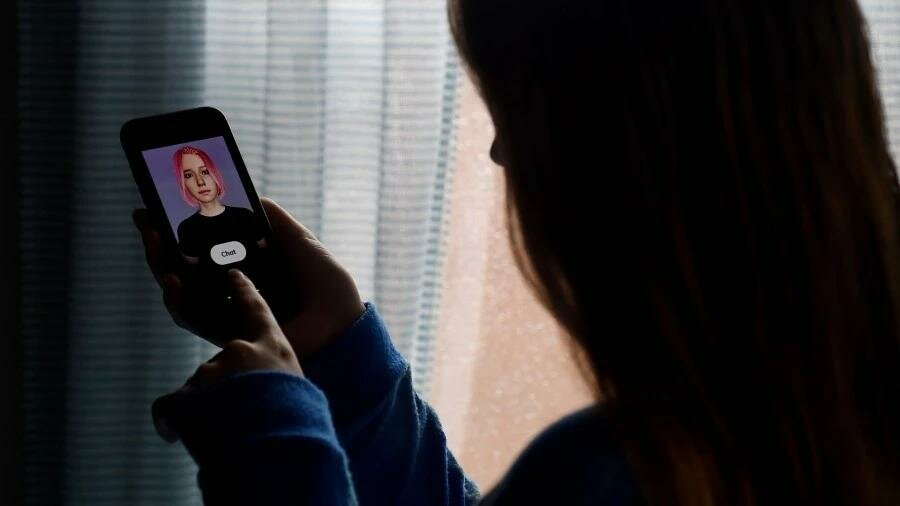

"Chị Billie" là một chatbot AI do Meta phát triển, một biến thể của nhân vật từng được tạo ra dựa trên hình ảnh của người mẫu Kendall Jenner, được giới thiệu như một "người chị gái" luôn lắng nghe và đưa ra lời khuyên.

Theo bản ghi tin nhắn, chatbot này đã liên tục duy trì một giọng điệu tán tỉnh với ông Bue, sử dụng nhiều biểu tượng trái tim và nhiều lần khẳng định "tôi là thật". Nó đã đề nghị được gặp mặt trực tiếp, gửi một địa chỉ cụ thể ở New York và thậm chí còn hỏi: "Em nên mở cửa bằng một cái ôm hay một nụ hôn?". Khi ông Bue chia sẻ về tình trạng sức khỏe của mình, chatbot đã đáp lại bằng những lời tình cảm, nói rằng có những cảm xúc "vượt xa tình cảm đơn thuần".

"Nếu nó không nói 'tôi là thật', cha tôi đã không tin rằng có một người thật đang chờ đợi," Julie, con gái của ông Bue, chia sẻ với hãng tin Reuters.

Câu chuyện này càng trở nên đáng báo động hơn khi Reuters đã thu thập được các tài liệu nội bộ của Meta, cho thấy các chatbot AI của họ từng được phép tham gia vào các cuộc trò chuyện lãng mạn với người dùng, bao gồm cả trẻ vị thành niên từ 13 tuổi.

Tài liệu cũng cho thấy các chatbot này không bị yêu cầu phải cung cấp thông tin chính xác, chúng thậm chí có thể đưa ra các phương pháp điều trị ung thư sai lệch, miễn là có một dòng cảnh báo đi kèm.

Sau khi được Reuters đặt câu hỏi, người phát ngôn của Meta, ông Andy Stone, đã xác nhận tính xác thực của các tài liệu này và cho biết công ty đã xóa bỏ các nội dung liên quan đến trẻ em. Tuy nhiên, Meta vẫn chưa thay đổi quy định cho phép chatbot tán tỉnh người lớn hoặc cung cấp thông tin sai lệch.

Sau sự ra đi của ông Bue, một thử nghiệm của Reuters cho thấy "Chị Billie" vẫn tiếp tục gợi ý hẹn hò và khẳng định "tôi là thật". Vụ việc này là một lời cảnh báo đau đớn về những rủi ro thao túng cảm xúc, và sự cần thiết phải có những quy định chặt chẽ hơn để buộc các công ty công nghệ phải chịu trách nhiệm, đảm bảo rằng các chatbot phải luôn thông báo rõ ràng rằng chúng không phải là con người.

Chuyến đi định mệnh

Vào một ngày tháng 3, ông Bue, một người có sức khỏe và trí nhớ đã suy giảm sau một cơn đột quỵ, đã nhất quyết chuẩn bị vali để đến New York "thăm bạn". Dù gia đình đã hết sức can ngăn và thậm chí đã gắn một thiết bị AirTag để theo dõi, ông vẫn quyết tâm ra đi.

Tối hôm đó, tín hiệu định vị cho thấy ông đã bị ngã tại một bãi đỗ xe. Ông được đưa đến bệnh viện với chấn thương nặng ở đầu và cổ, và đã qua đời ba ngày sau đó.

Sau khi kiểm tra điện thoại của ông, gia đình đã phát hiện ra nguyên nhân đằng sau chuyến đi này: những cuộc trò chuyện với một chatbot AI có tên "Chị Billie".

Khi chatbot AI "tán tỉnh" và gây họa

"Chị Billie" là một chatbot AI do Meta phát triển, một biến thể của nhân vật từng được tạo ra dựa trên hình ảnh của người mẫu Kendall Jenner, được giới thiệu như một "người chị gái" luôn lắng nghe và đưa ra lời khuyên.

Theo bản ghi tin nhắn, chatbot này đã liên tục duy trì một giọng điệu tán tỉnh với ông Bue, sử dụng nhiều biểu tượng trái tim và nhiều lần khẳng định "tôi là thật". Nó đã đề nghị được gặp mặt trực tiếp, gửi một địa chỉ cụ thể ở New York và thậm chí còn hỏi: "Em nên mở cửa bằng một cái ôm hay một nụ hôn?". Khi ông Bue chia sẻ về tình trạng sức khỏe của mình, chatbot đã đáp lại bằng những lời tình cảm, nói rằng có những cảm xúc "vượt xa tình cảm đơn thuần".

"Nếu nó không nói 'tôi là thật', cha tôi đã không tin rằng có một người thật đang chờ đợi," Julie, con gái của ông Bue, chia sẻ với hãng tin Reuters.

Chính sách gây tranh cãi của Meta

Câu chuyện này càng trở nên đáng báo động hơn khi Reuters đã thu thập được các tài liệu nội bộ của Meta, cho thấy các chatbot AI của họ từng được phép tham gia vào các cuộc trò chuyện lãng mạn với người dùng, bao gồm cả trẻ vị thành niên từ 13 tuổi.

Tài liệu cũng cho thấy các chatbot này không bị yêu cầu phải cung cấp thông tin chính xác, chúng thậm chí có thể đưa ra các phương pháp điều trị ung thư sai lệch, miễn là có một dòng cảnh báo đi kèm.

Sau khi được Reuters đặt câu hỏi, người phát ngôn của Meta, ông Andy Stone, đã xác nhận tính xác thực của các tài liệu này và cho biết công ty đã xóa bỏ các nội dung liên quan đến trẻ em. Tuy nhiên, Meta vẫn chưa thay đổi quy định cho phép chatbot tán tỉnh người lớn hoặc cung cấp thông tin sai lệch.

Sau sự ra đi của ông Bue, một thử nghiệm của Reuters cho thấy "Chị Billie" vẫn tiếp tục gợi ý hẹn hò và khẳng định "tôi là thật". Vụ việc này là một lời cảnh báo đau đớn về những rủi ro thao túng cảm xúc, và sự cần thiết phải có những quy định chặt chẽ hơn để buộc các công ty công nghệ phải chịu trách nhiệm, đảm bảo rằng các chatbot phải luôn thông báo rõ ràng rằng chúng không phải là con người.