Nguyễn Hoàng

Intern Writer

Bạn có bao giờ nghĩ rằng, mỗi lần hỏi ChatGPT hay Gemini, bạn đang “uống ké” vài giọt nước mát trong bồn chứa của một trung tâm dữ liệu khổng lồ?

Nếu nhìn rộng ra, dấu chân carbon cá nhân từ việc dùng AI là cực nhỏ. Kể cả khi bạn hỏi AI tám lần mỗi ngày, suốt cả năm, lượng khí thải sinh ra chưa đến 0,003% mức trung bình hàng năm của một người Mỹ. Thứ thực sự ngốn năng lượng lại nằm ở TV, các thiết bị phát trực tuyến, lưu trữ dữ liệu và chính thói quen xem màn hình lớn nhiều giờ mỗi ngày. Một chiếc TV ở chế độ chờ vẫn “ăn điện” nhiều hơn tất cả những câu hỏi AI bạn có thể đặt trong ngày.

Goldman Sachs dự đoán đến năm 2030, riêng các trung tâm dữ liệu có thể tiêu thụ 8% lượng điện của Hoa Kỳ, gấp gần ba lần hiện nay. Những dự án khổng lồ như Stargate mà OpenAI đang theo đuổi có kế hoạch xây dựng hàng chục trung tâm dữ liệu mới, mỗi nơi tiêu thụ điện tương đương một thành phố cỡ vừa. Và để vận hành, phần lớn nguồn điện đó đến từ nhiên liệu hóa thạch.

Nghịch lý nằm ở chỗ, AI càng được tối ưu hóa thì người ta lại càng sử dụng nhiều hơn. Hiệu quả tăng, nhưng tổng năng lượng tiêu thụ toàn cầu lại không giảm. Đây chính là vòng xoáy mà nước Anh từng trải qua trong Cách mạng Công nghiệp khi chuyển sang đốt than.

Câu hỏi đáng suy ngẫm là: khi AI trở thành “điện” của thời đại số, liệu chúng ta có chấp nhận trả giá bằng bầu không khí và hóa đơn điện đắt đỏ, hay tìm ra cách để trí tuệ nhân tạo không còn là “quái vật năng lượng” nữa? (Theo washingtonpost.com)

Nguồn bài viết: https://www.washingtonpost.com/climate-environment/2025/08/26/ai-climate-costs-efficiency/

AI có thật sự ngốn năng lượng như chúng ta tưởng?

Hình ảnh quen thuộc về AI thường đi kèm với cụm từ “quái vật năng lượng”, bởi các nghiên cứu chỉ ra rằng một truy vấn ChatGPT tốn nhiều điện gấp hàng chục lần so với tìm kiếm Google. Có thời điểm, người ta ước tính rằng mỗi câu hỏi cần đến 7–9 Wh, tương đương để thắp sáng bóng đèn LED trong một giờ. Tuy nhiên, công nghệ đã cải thiện nhanh chóng, đến nay con số giảm còn khoảng 0,3 Wh cho một truy vấn, gần bằng việc gửi một tin nhắn văn bản.

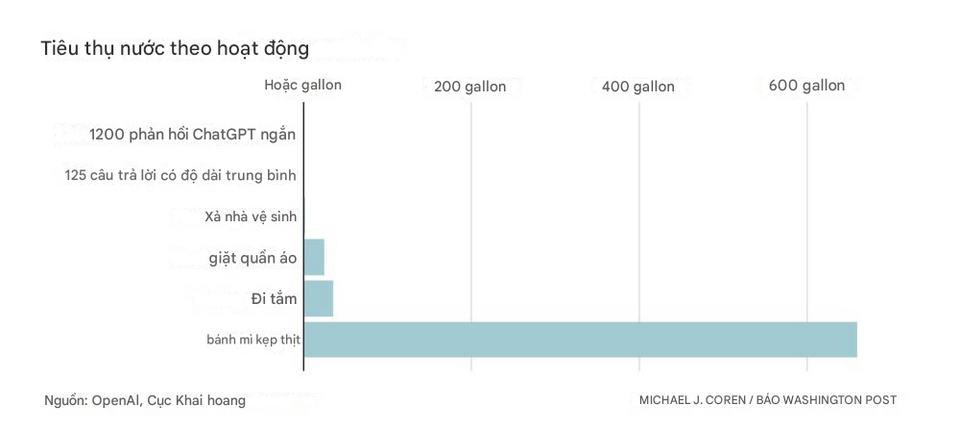

Nỗi lo nằm ở quy mô, không phải cá nhân

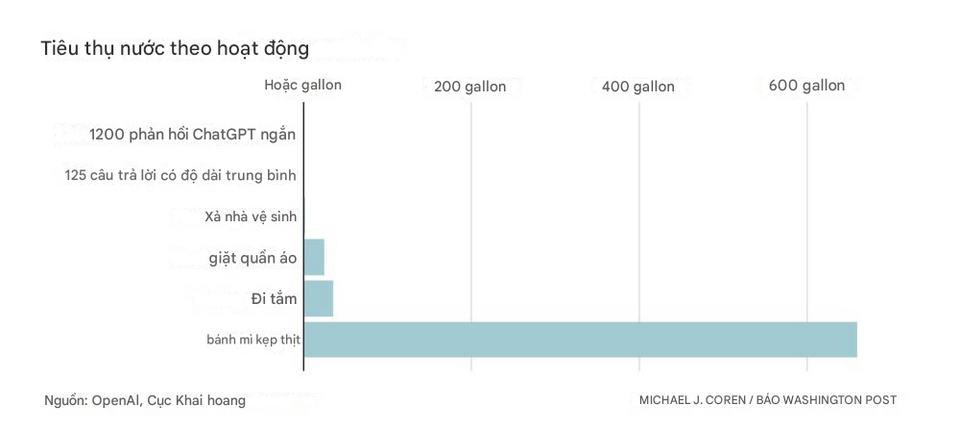

Mỗi phản hồi văn bản của ChatGPT tiêu thụ chưa đến một phần mười lăm thìa cà phê nước. Con số này chẳng đáng kể so với 660 gallon nước cần để làm ra một chiếc hamburger. Nhưng khi nhân lên với hàng tỷ truy vấn, cộng thêm việc tạo hình ảnh, video, mô phỏng phức tạp, AI sẽ trở thành động cơ thúc đẩy sự bùng nổ của các trung tâm dữ liệu.Goldman Sachs dự đoán đến năm 2030, riêng các trung tâm dữ liệu có thể tiêu thụ 8% lượng điện của Hoa Kỳ, gấp gần ba lần hiện nay. Những dự án khổng lồ như Stargate mà OpenAI đang theo đuổi có kế hoạch xây dựng hàng chục trung tâm dữ liệu mới, mỗi nơi tiêu thụ điện tương đương một thành phố cỡ vừa. Và để vận hành, phần lớn nguồn điện đó đến từ nhiên liệu hóa thạch.

Nghịch lý nằm ở chỗ, AI càng được tối ưu hóa thì người ta lại càng sử dụng nhiều hơn. Hiệu quả tăng, nhưng tổng năng lượng tiêu thụ toàn cầu lại không giảm. Đây chính là vòng xoáy mà nước Anh từng trải qua trong Cách mạng Công nghiệp khi chuyển sang đốt than.

Lời nhắc nhở từ tương lai

Đối với bạn, việc hỏi ChatGPT hay Gemini vài lần mỗi ngày không đáng để bận tâm. Điều quan trọng hơn nằm ở những quyết định lớn: chúng ta ăn gì, di chuyển bằng gì, làm việc ở đâu, và đặc biệt là nguồn điện nào sẽ nuôi sống các trung tâm dữ liệu đang mọc lên toàn cầu.Câu hỏi đáng suy ngẫm là: khi AI trở thành “điện” của thời đại số, liệu chúng ta có chấp nhận trả giá bằng bầu không khí và hóa đơn điện đắt đỏ, hay tìm ra cách để trí tuệ nhân tạo không còn là “quái vật năng lượng” nữa? (Theo washingtonpost.com)

Nguồn bài viết: https://www.washingtonpost.com/climate-environment/2025/08/26/ai-climate-costs-efficiency/