A-Train The Seven

...'cause for once, I didn't hate myself.

"Mục tiêu của xAI là có được 50 triệu đơn vị sức mạnh tính toán AI tương đương H100 (nhưng hiệu quả năng lượng tốt hơn nhiều) hoạt động trực tuyến trong vòng 5 năm," Elon Musk đã viết trên X.

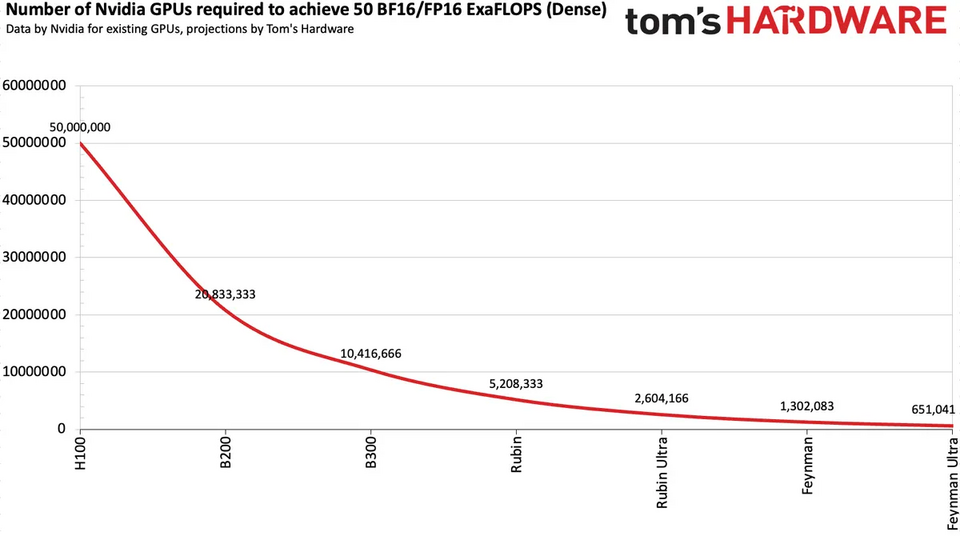

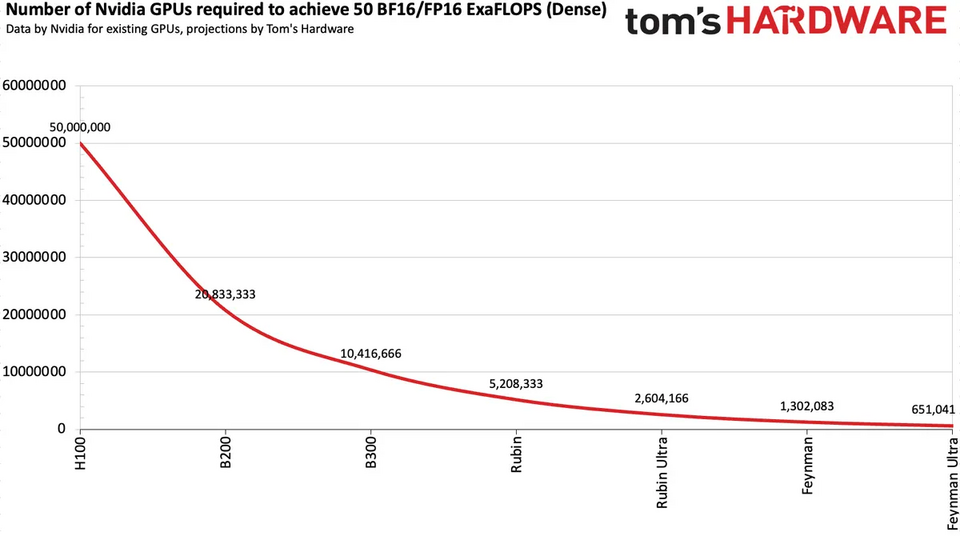

Để anh em dễ hình dung, 1 GPU Nvidia H100 có thể cung cấp khoảng 1.000 TFLOPS cho việc huấn luyện AI. Do đó, 50 triệu máy gia tốc AI như vậy sẽ phải cung cấp tới 50 ExaFLOPS cho việc huấn luyện AI vào năm 2030. Đây là 1 con số không thể nào tưởng tượng nổi.

Nhưng liệu con số 50 triệu GPU có phải là thực tế? Câu trả lời là không hẳn. Với tốc độ cải thiện hiệu suất chóng mặt của các thế hệ GPU mới, việc đạt được mục tiêu 50 ExaFLOPS này hoàn toàn có thể thực hiện được với số lượng GPU ít hơn rất nhiều. Dựa trên các dự đoán, mục tiêu này có thể đạt được bằng cách sử dụng 1,3 triệu GPU vào năm 2028 hoặc chỉ cần 650.000 GPU vào năm 2029.

Và xAI của Elon Musk đang chứng tỏ họ không hề nói suông. Công ty này đã là một trong những công ty nhanh nhất trong việc triển khai các máy gia tốc GPU AI mới nhất. Họ đã vận hành siêu cụm Colossus 1 với 200.000 máy gia tốc H100/H200 và 30.000 đơn vị GB200. Hơn nữa, họ đang đặt mục tiêu xây dựng cụm Colossus 2, bao gồm 550.000 nút GB200/GB300 (mỗi nút có hai GPU, tức là hơn một triệu GPU), với những nút đầu tiên sẽ đi vào hoạt động trong vài tuần tới.

Nvidia và các công ty khác gần đây đã chuyển sang chu kỳ phát hành máy gia tốc AI mới hàng năm, một mô hình gợi nhớ đến mô hình "Tick-Tock" của Intel ngày xưa. Cách tiếp cận này đảm bảo sự gia tăng hiệu suất đáng kể hàng năm. Ví dụ, Nvidia tuyên bố Blackwell B200 của họ mang lại hiệu suất suy luận cao hơn 20.000 lần so với Pascal P100 của năm 2016.

Với tốc độ tăng hiệu suất huấn luyện AI gấp đôi sau mỗi thế hệ mới, việc đạt được 50 ExaFLOPS với khoảng 650.000 GPU thế hệ "Feynman Ultra" vào năm 2029 là hoàn toàn khả thi. Tuy nhiên, có một câu hỏi lớn hơn, một "con voi trong phòng" mà không ai có thể lờ đi: 1 siêu cụm máy tính như vậy sẽ tiêu thụ bao nhiêu điện năng? Và sẽ cần bao nhiêu nhà máy điện hạt nhân để nuôi sống nó?

Một máy gia tốc H100 tiêu thụ 700W, vì vậy 50 triệu bộ xử lý này sẽ tiêu thụ tới 35 gigawatt (GW), tương đương với công suất phát điện của 35 nhà máy điện hạt nhân. Đây là một con số không thực tế ở thời điểm hiện tại. Ngay cả khi sử dụng các thế hệ GPU hiệu quả hơn trong tương lai, một cụm máy tính 50 ExaFLOPS vẫn sẽ cần một lượng điện năng khổng lồ.

Để anh em dễ hình dung, 1 GPU Nvidia H100 có thể cung cấp khoảng 1.000 TFLOPS cho việc huấn luyện AI. Do đó, 50 triệu máy gia tốc AI như vậy sẽ phải cung cấp tới 50 ExaFLOPS cho việc huấn luyện AI vào năm 2030. Đây là 1 con số không thể nào tưởng tượng nổi.

Nhưng liệu con số 50 triệu GPU có phải là thực tế? Câu trả lời là không hẳn. Với tốc độ cải thiện hiệu suất chóng mặt của các thế hệ GPU mới, việc đạt được mục tiêu 50 ExaFLOPS này hoàn toàn có thể thực hiện được với số lượng GPU ít hơn rất nhiều. Dựa trên các dự đoán, mục tiêu này có thể đạt được bằng cách sử dụng 1,3 triệu GPU vào năm 2028 hoặc chỉ cần 650.000 GPU vào năm 2029.

Và xAI của Elon Musk đang chứng tỏ họ không hề nói suông. Công ty này đã là một trong những công ty nhanh nhất trong việc triển khai các máy gia tốc GPU AI mới nhất. Họ đã vận hành siêu cụm Colossus 1 với 200.000 máy gia tốc H100/H200 và 30.000 đơn vị GB200. Hơn nữa, họ đang đặt mục tiêu xây dựng cụm Colossus 2, bao gồm 550.000 nút GB200/GB300 (mỗi nút có hai GPU, tức là hơn một triệu GPU), với những nút đầu tiên sẽ đi vào hoạt động trong vài tuần tới.

Nvidia và các công ty khác gần đây đã chuyển sang chu kỳ phát hành máy gia tốc AI mới hàng năm, một mô hình gợi nhớ đến mô hình "Tick-Tock" của Intel ngày xưa. Cách tiếp cận này đảm bảo sự gia tăng hiệu suất đáng kể hàng năm. Ví dụ, Nvidia tuyên bố Blackwell B200 của họ mang lại hiệu suất suy luận cao hơn 20.000 lần so với Pascal P100 của năm 2016.

Với tốc độ tăng hiệu suất huấn luyện AI gấp đôi sau mỗi thế hệ mới, việc đạt được 50 ExaFLOPS với khoảng 650.000 GPU thế hệ "Feynman Ultra" vào năm 2029 là hoàn toàn khả thi. Tuy nhiên, có một câu hỏi lớn hơn, một "con voi trong phòng" mà không ai có thể lờ đi: 1 siêu cụm máy tính như vậy sẽ tiêu thụ bao nhiêu điện năng? Và sẽ cần bao nhiêu nhà máy điện hạt nhân để nuôi sống nó?

Một máy gia tốc H100 tiêu thụ 700W, vì vậy 50 triệu bộ xử lý này sẽ tiêu thụ tới 35 gigawatt (GW), tương đương với công suất phát điện của 35 nhà máy điện hạt nhân. Đây là một con số không thực tế ở thời điểm hiện tại. Ngay cả khi sử dụng các thế hệ GPU hiệu quả hơn trong tương lai, một cụm máy tính 50 ExaFLOPS vẫn sẽ cần một lượng điện năng khổng lồ.

- Với thế hệ Rubin Ultra: 9,37 GW (tương đương mức tiêu thụ điện của cả vùng Guiana thuộc Pháp).

- Với thế hệ Feynman Ultra (giả định hiệu suất/watt gấp đôi Rubin): 4,685 GW.