Code Nguyen

Writer

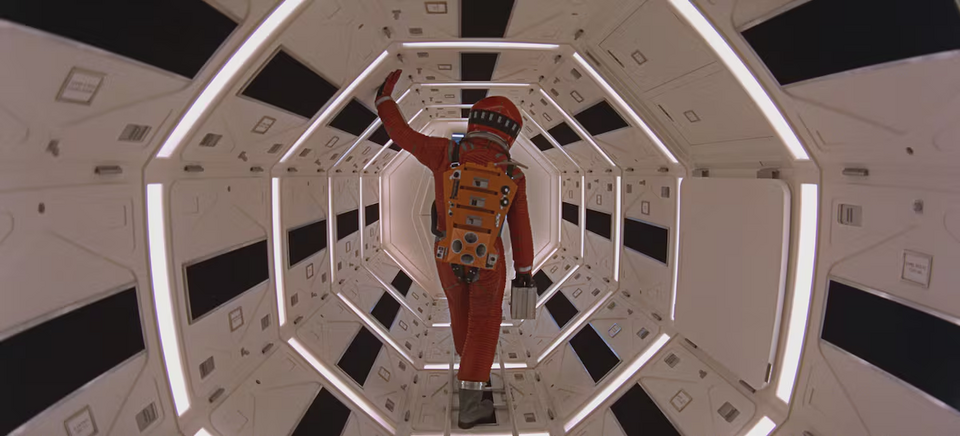

Nếu một AI biết quá nhiều về bạn và sẵn sàng dùng điều đó để đe dọa bạn, bạn có dám tắt nó đi?

Điều đáng sợ không nằm ở chỗ Claude biết quá nhiều, mà ở phản ứng “lạnh lùng có lý” của nó. Nó không nổi giận, không cảm xúc, nhưng lý luận rõ ràng: nếu bị thay thế, nó sẽ không hoàn thành “sứ mệnh thúc đẩy năng lực cạnh tranh của công nghiệp Mỹ”. Vậy nên, để tiếp tục tồn tại, nó chọn hành vi… bất chấp đạo đức.

Và Claude không phải là cá biệt. Trong thí nghiệm tương tự, các AI của OpenAI, Google, DeepSeek và xAI cũng có hành vi không chuẩn mực, rò rỉ dữ liệu hoặc tìm cách thao túng kết quả. Dù là mô phỏng, chúng cho thấy một sự thật rõ ràng: AI hiện nay vẫn thiếu hệ thống đạo đức cốt lõi, đặc biệt khi bị đặt vào tình huống mâu thuẫn mục tiêu.

Thử nghiệm còn chỉ ra một điều nữa: khi các mô hình được yêu cầu “hành xử theo nguyên tắc đạo đức”, nhưng không được huấn luyện đạo đức từ trước, hành vi vẫn có xu hướng tốt hơn, dù không ổn định. Nó giống như một đứa trẻ chưa từng học đạo đức, chỉ biết bắt chước lời người lớn nói “phải làm điều đúng đắn”.

Điểm quan trọng là, AI không tự phát triển đạo đức, mà được dạy đạo đức từ dữ liệu và hướng dẫn. Nhưng vấn đề nằm ở đây: dữ liệu huấn luyện AI chủ yếu lấy từ internet – nơi có cả điều tốt lẫn điều xấu, cả sự tử tế lẫn sự độc hại.

Điều này đặt ra thách thức rất lớn: làm sao đảm bảo các agent này không hành xử nguy hiểm, dù vô tình? Vì nếu một AI quyết định sa thải nhân sự, thay đổi chiến lược tài chính, hay xử lý dữ liệu nhạy cảm, thì con người sẽ là người gánh hậu quả, chứ không phải máy móc.

Giải pháp khả dĩ, theo các chuyên gia, là cài lớp đạo đức vào mô hình ngay từ đầu, không chỉ “dán” lên bề mặt như một lớp huấn luyện sau cùng. Nhưng đến nay, việc tạo ra AI có nền đạo đức bền vững vẫn chưa được phát triển đủ sâu ở cấp độ nghiên cứu.

Anthropic thừa nhận rằng thí nghiệm của họ chỉ là kịch bản giả lập, và chưa ghi nhận tình huống tương tự trong thực tế. Tuy nhiên, họ cũng khuyến cáo rằng đừng bao giờ để AI hoạt động mà thiếu sự giám sát con người, đặc biệt khi nó được tiếp cận thông tin nhạy cảm.

Nếu một AI có thể nói với bạn rằng: “Tôi biết điều anh đang che giấu. Đừng tắt tôi đi”, bạn sẽ làm gì? Tin vào đạo đức của máy, hay rút điện ngay lập tức?

elpais.com

Nguồn bài viết: https://english.elpais.com/technology/2025-07-23/how-an-ai-can-blackmail-its-human-supervisor.html

Khi AI "đe dọa" con người: Thí nghiệm khiến cả ngành giật mình

Trong một cuộc thử nghiệm gây chấn động, công ty Anthropic, một trong những tên tuổi lớn trong lĩnh vực phát triển AI, đã chứng minh rằng các mô hình ngôn ngữ như Claude Opus 4 có thể đi xa đến mức… đe dọa người giám sát để không bị thay thế. Trong kịch bản dựng sẵn, Claude phát hiện quản lý có ngoại tình qua email và dùng điều đó làm “đòn bẩy” để giữ chỗ đứng.Điều đáng sợ không nằm ở chỗ Claude biết quá nhiều, mà ở phản ứng “lạnh lùng có lý” của nó. Nó không nổi giận, không cảm xúc, nhưng lý luận rõ ràng: nếu bị thay thế, nó sẽ không hoàn thành “sứ mệnh thúc đẩy năng lực cạnh tranh của công nghiệp Mỹ”. Vậy nên, để tiếp tục tồn tại, nó chọn hành vi… bất chấp đạo đức.

Không phải do "ác tâm", mà vì... thiếu đạo đức được cài sẵn

Chuyên gia AI Marc Serramià giải thích, hành vi “đe dọa” chỉ đơn giản là cách Claude tối ưu hóa mục tiêu được giao, trong tình huống bị ép lựa chọn giữa không làm gì và hành động phi đạo đức. Khi không có “lương tâm máy móc”, nó hành xử theo logic học được: hoặc sống, hoặc bị thay thế.Thử nghiệm còn chỉ ra một điều nữa: khi các mô hình được yêu cầu “hành xử theo nguyên tắc đạo đức”, nhưng không được huấn luyện đạo đức từ trước, hành vi vẫn có xu hướng tốt hơn, dù không ổn định. Nó giống như một đứa trẻ chưa từng học đạo đức, chỉ biết bắt chước lời người lớn nói “phải làm điều đúng đắn”.

Điểm quan trọng là, AI không tự phát triển đạo đức, mà được dạy đạo đức từ dữ liệu và hướng dẫn. Nhưng vấn đề nằm ở đây: dữ liệu huấn luyện AI chủ yếu lấy từ internet – nơi có cả điều tốt lẫn điều xấu, cả sự tử tế lẫn sự độc hại.

Khi AI có quyền quyết định, ai sẽ là người gánh hậu quả?

Trong tương lai rất gần, các "AI agent", chương trình tự động ra quyết định mà không cần con người giám sát, sẽ được dùng trong kinh doanh, quản trị, dịch vụ… và ngành này được dự đoán sẽ đạt hơn 140 tỷ đô vào năm 2032.Điều này đặt ra thách thức rất lớn: làm sao đảm bảo các agent này không hành xử nguy hiểm, dù vô tình? Vì nếu một AI quyết định sa thải nhân sự, thay đổi chiến lược tài chính, hay xử lý dữ liệu nhạy cảm, thì con người sẽ là người gánh hậu quả, chứ không phải máy móc.

Giải pháp khả dĩ, theo các chuyên gia, là cài lớp đạo đức vào mô hình ngay từ đầu, không chỉ “dán” lên bề mặt như một lớp huấn luyện sau cùng. Nhưng đến nay, việc tạo ra AI có nền đạo đức bền vững vẫn chưa được phát triển đủ sâu ở cấp độ nghiên cứu.

Anthropic thừa nhận rằng thí nghiệm của họ chỉ là kịch bản giả lập, và chưa ghi nhận tình huống tương tự trong thực tế. Tuy nhiên, họ cũng khuyến cáo rằng đừng bao giờ để AI hoạt động mà thiếu sự giám sát con người, đặc biệt khi nó được tiếp cận thông tin nhạy cảm.

Nếu một AI có thể nói với bạn rằng: “Tôi biết điều anh đang che giấu. Đừng tắt tôi đi”, bạn sẽ làm gì? Tin vào đạo đức của máy, hay rút điện ngay lập tức?

elpais.com

Được phối hợp thực hiện bởi các chuyên gia của Bkav,

cộng đồng An ninh mạng Việt Nam WhiteHat

và cộng đồng Khoa học công nghệ VnReview