A-Train The Seven

...'cause for once, I didn't hate myself.

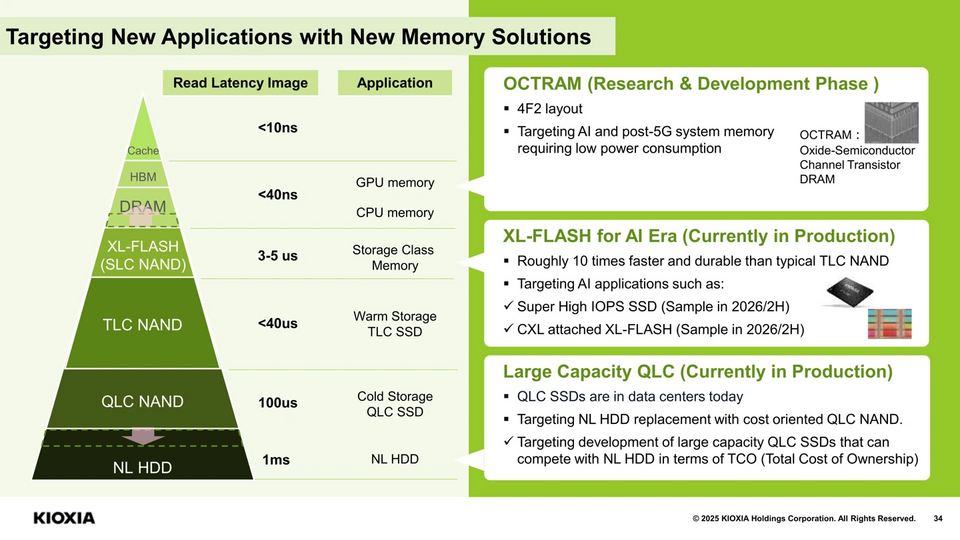

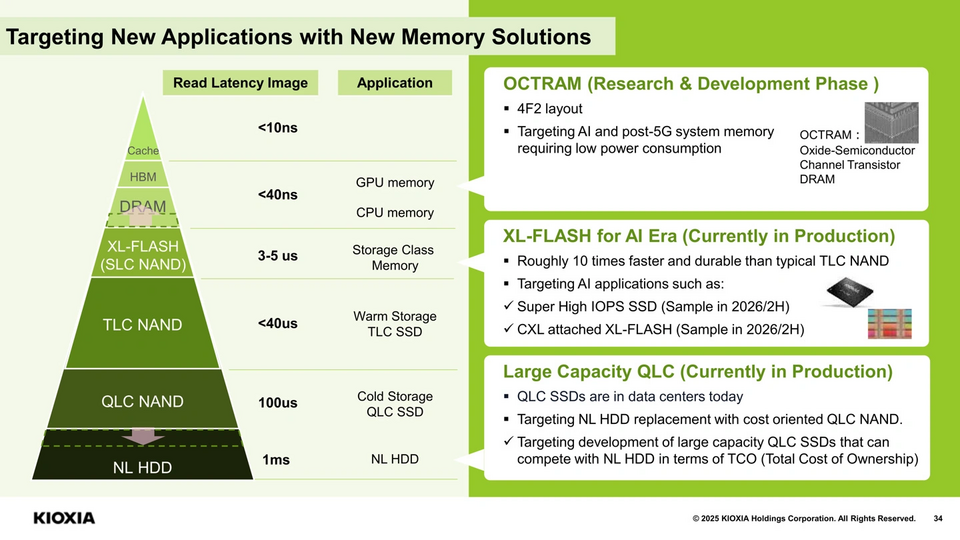

Theo thông báo tại hội nghị chiến lược ngày 5/6/2025, Kioxia đang phát triển các sản phẩm SSD siêu tốc, bộ nhớ XL-FLASH hỗ trợ CXL, và DRAM OCTRAM tiên tiến, đồng thời đẩy mạnh công nghệ BiCS FLASH thế hệ 10 (BiCS 10) nhằm đáp ứng nhu cầu khổng lồ của trí tuệ nhân tạo (AI).

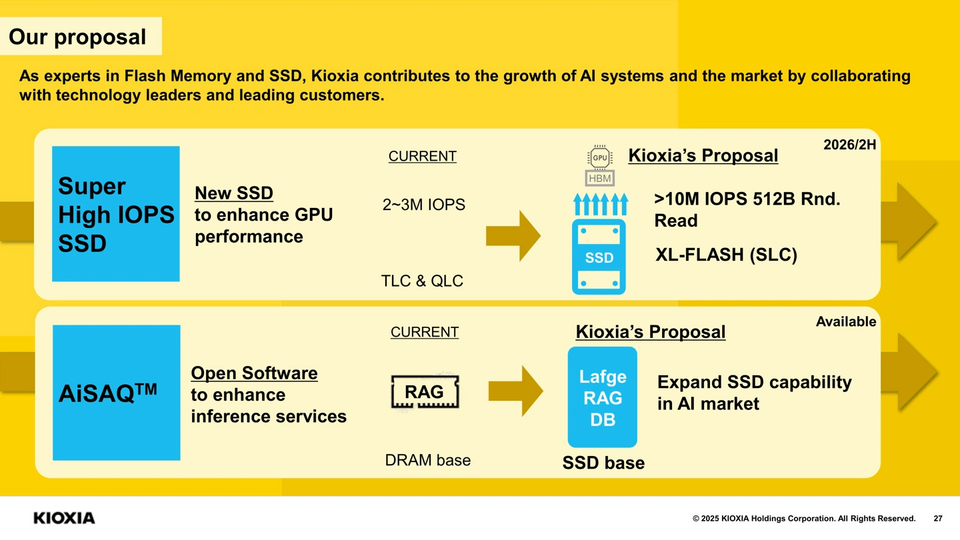

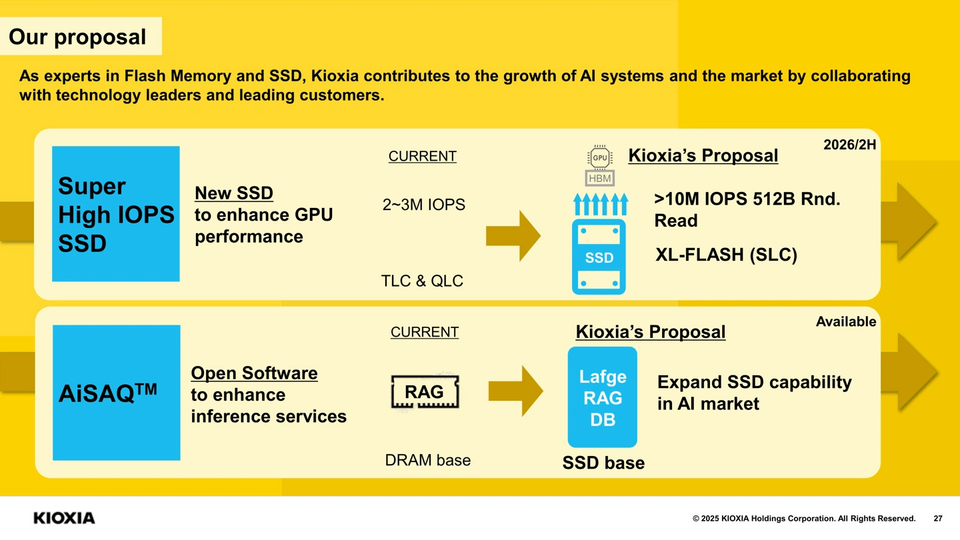

Kioxia đang phát triển một SSD siêu cao cấp dành riêng cho các ứng dụng AI, kết hợp công nghệ XL-FLASH (SLC NAND hiệu năng cao) với một bộ điều khiển SSD mới. Theo thông báo tại hội nghị chiến lược, sản phẩm này đạt 10 triệu IOPS (Input/Output Operations Per Second) trong các tác vụ đọc ngẫu nhiên, gấp hơn ba lần hiệu năng của các SSD doanh nghiệp PCIe 5.0 TLC hiện tại (khoảng 3 triệu IOP). Kioxia dự kiến bắt đầu xuất hàng mẫu (sampling) SSD này vào nửa cuối năm 2026, hứa hẹn mang đến bước đột phá cho các ứng dụng như cơ sở dữ liệu in-memory, suy luận AI (AI inference) và huấn luyện mô hình lớn.

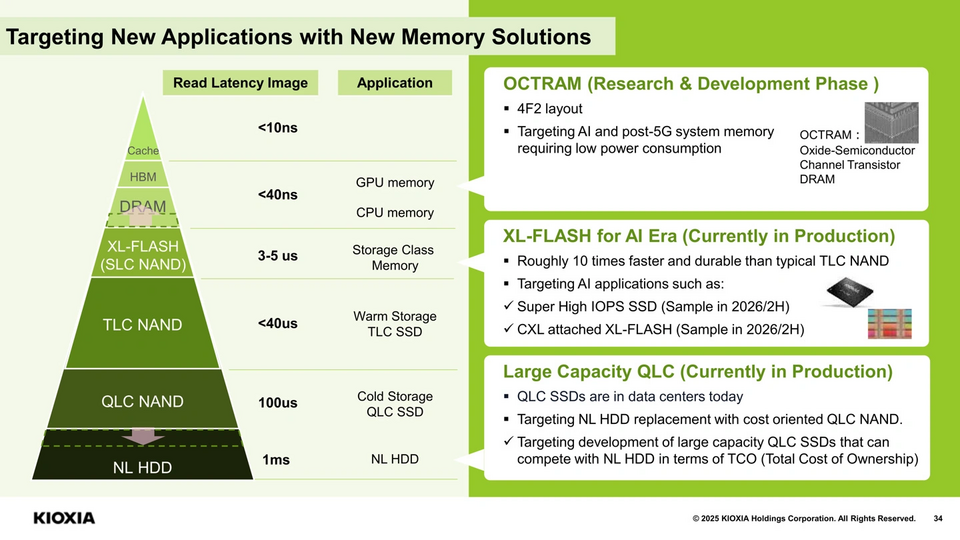

XL-FLASH là một trong những át chủ bài của Kioxia. Đây là bộ nhớ lớp lưu trữ (Storage Class Memory - SCM) nằm giữa DRAM và NAND thông thường, độ trễ thấp và hiệu năng cao. Thế hệ thứ nhất của XL-FLASH sử dụng SLC NAND (1 bit/tế bào) trên 16 mặt phẳng (planes), trong khi thế hệ thứ hai chuyển sang MLC NAND (2 bit/tế bào) với số lượng mặt phẳng cao hơn, tăng độ song song và giảm độ trễ. So với NAND TLC thông thường, XL-FLASH cung cấp độ trễ đọc dưới 5 microgiây (nhanh hơn 10 lần so với TLC) và thời gian lập trình 7 microgiây (nhanh hơn nhiều so với 30 microgiây của QLC). Với SSD mới này, Kioxia nhắm đến việc cạnh tranh trực tiếp với các giải pháp SCM như Z-NAND của Samsung hay Optane của Intel (đã bị ngừng sản xuất).

Ngoài ra, Kioxia cũng công bố kế hoạch xuất mẫu XL-FLASH hỗ trợ CXL (Compute Express Link) vào nửa cuối năm 2026. CXL là giao thức kết nối tiên tiến cho phép mở rộng bộ nhớ và lưu trữ với độ trễ thấp, lý tưởng cho các hệ thống AI và trung tâm dữ liệu. Theo ServeTheHome, Kioxia đã giới thiệu các thiết bị CXL + XL-FLASH tại Flash Memory Summit (FMS) 2023, sử dụng giao thức CXL.mem để đọc và CXL.io để ghi, tối ưu hóa hiệu năng cho các ứng dụng như AI inference và Big Data. Một mô phỏng Cachelib cho thấy CXL + XL-FLASH cải thiện hiệu suất bộ nhớ cache gấp 5 lần so với hệ thống truyền thống. Những sản phẩm này sẽ giúp Kioxia củng cố vị thế trong tầng SCM, nơi yêu cầu cân bằng giữa hiệu năng và dung lượng.

Kioxia hợp tác với Nanya Technology đang phát triển OCTRAM (Oxide-Semiconductor Channel Transistor DRAM), một loại DRAM 4F² sử dụng tranzistor oxit indium gallium zinc oxide (IGZO). Theo DiskMFR, OCTRAM có dòng dẫn cao và dòng rò cực thấp, giúp giảm tiêu thụ điện năng so với DRAM truyền thống. Công nghệ này hứa hẹn mang lại bộ nhớ hiệu năng cao, tiết kiệm năng lượng, phù hợp cho cả bộ nhớ cache độc lập của SSD và các sản phẩm bộ nhớ riêng biệt. OCTRAM có thể được sử dụng trong các ứng dụng AI, điện toán đám mây và thiết bị XR (thực tế ảo/tăng cường), nơi yêu cầu hiệu suất cao và kích thước nhỏ gọn.

So với DRAM truyền thống, OCTRAM có lợi thế về mật độ bit cao hơn và tiêu thụ năng lượng thấp hơn, nhưng vẫn đang trong giai đoạn phát triển. Kioxia dự kiến xuất mẫu OCTRAM vào nửa cuối năm 2026, trùng thời điểm với SSD siêu tốc và XL-FLASH CXL. Điều này cho thấy Kioxia đang xây dựng một hệ sinh thái tích hợp, từ lưu trữ (SSD) đến bộ nhớ (OCTRAM), để đáp ứng nhu cầu AI ngày càng tăng.

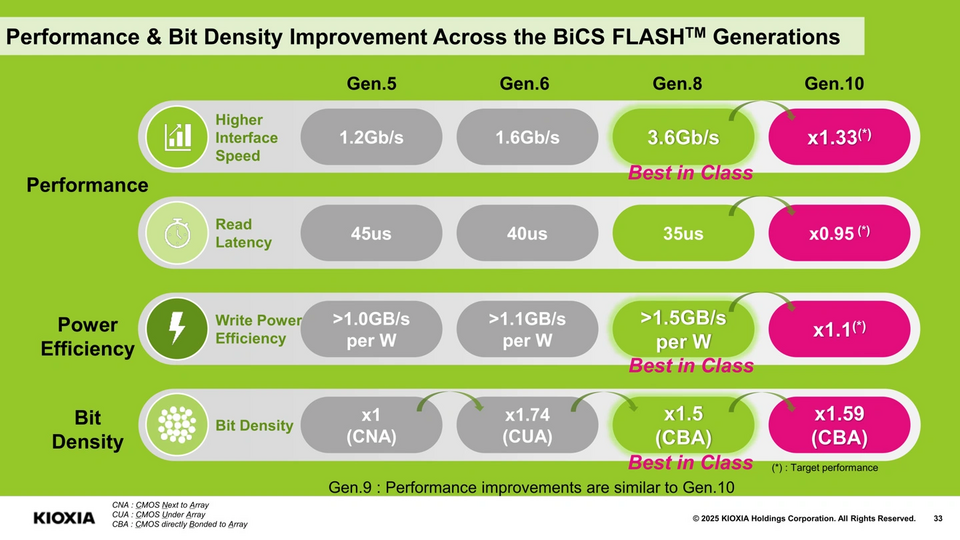

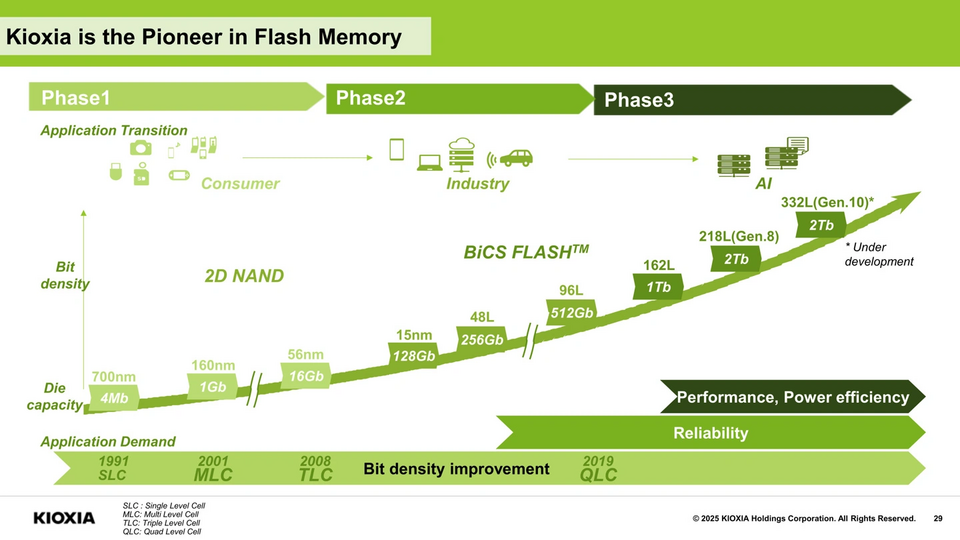

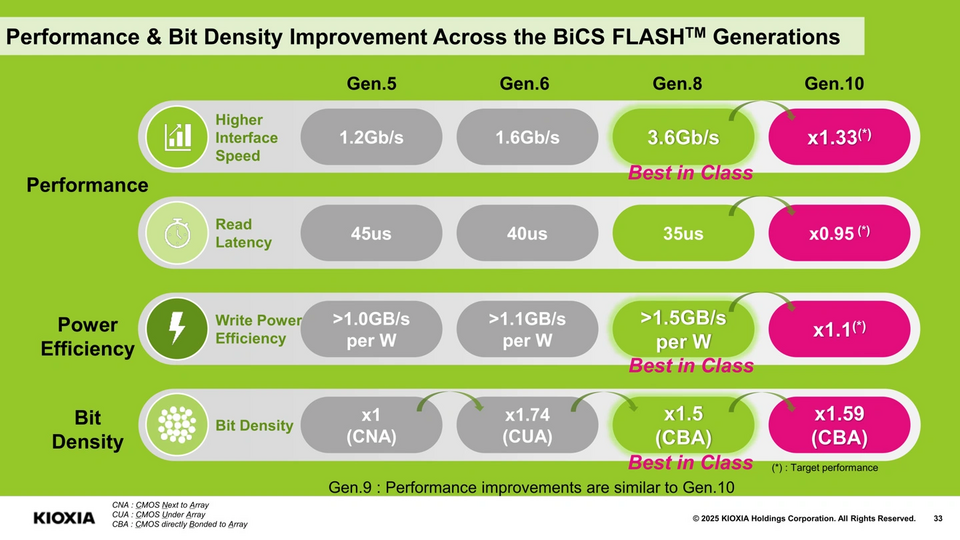

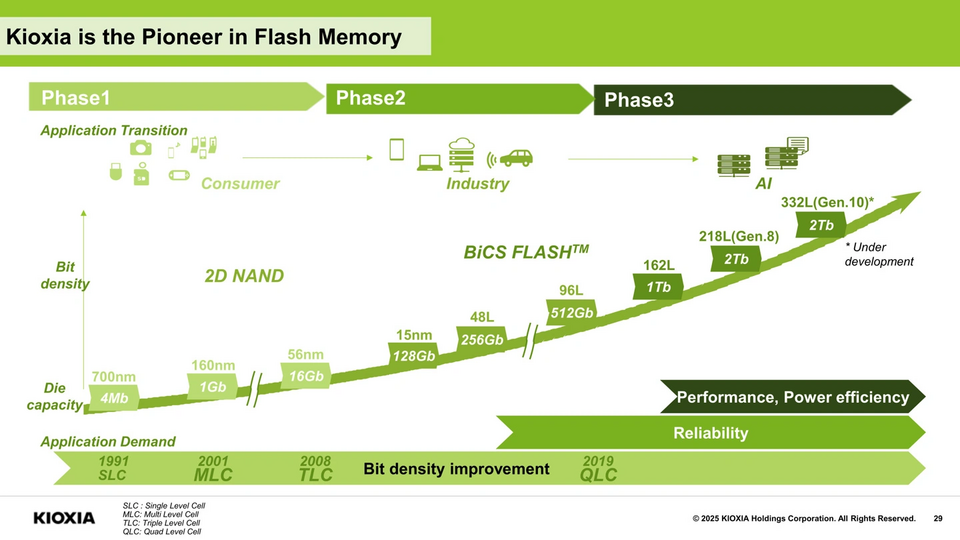

Kioxia cũng công bố lộ trình NAND flash với BiCS FLASH thế hệ 10 (BiCS 10), dự kiến đạt 332 tầng, dung lượng tối đa 2 terabit (250GB) mỗi die, tốc độ giao tiếp lên đến 4800 MT/s. So với BiCS 8 (218 tầng, 3200 MT/s, mật độ bit 15,8 Gbit/mm²), BiCS 10 sẽ cải thiện đáng kể về độ trễ đọc, tiêu thụ năng lượng khi ghi, mật độ bit. Công nghệ CMOS Bonded Array (CBA), lần đầu áp dụng ở BiCS 8, sẽ tiếp tục được sử dụng để tối ưu hóa mật độ và hiệu suất bằng cách sản xuất mạch CMOS và mảng NAND trên các wafer riêng biệt, sau đó liên kết chúng lại.

Lộ trình này phản ánh chiến lược “trục kép” của Kioxia: một mặt tăng số tầng theo cách truyền thống để đạt dung lượng lớn, mặt khác kết hợp công nghệ CBA với CMOS tiên tiến để giảm chi phí đầu tư. BiCS 10 sẽ hỗ trợ cả TLC (3 bit/tế bào) và QLC (4 bit/tế bào), đáp ứng nhu cầu từ AI training (dung lượng lớn) đến AI inference (hiệu năng cao). Theo DiskMFR, dòng SSD KIOXIA LC9 với dung lượng 122,88TB sử dụng BiCS 8 QLC đã cho thấy khả năng lưu trữ dữ liệu khổng lồ cho các mô hình AI.

Nhu cầu lưu trữ cho AI đang tăng vọt, dự báo rằng gần 50% nhu cầu NAND vào năm 2029 sẽ liên quan đến AI. Các mô hình lớn như Llama hay GPT yêu cầu dung lượng lưu trữ hàng terabyte và hiệu năng cao để xử lý khối lượng dữ liệu khổng lồ. Theo BusinessWire, Kioxia đã trình diễn các giải pháp như KIOXIA CM9 (tối ưu hóa cho GPU) và LC9 (dung lượng lớn) tại NVIDIA GTC 2025, nhấn mạnh vai trò của SSD trong việc tối đa hóa hiệu suất AI. Công nghệ AiSAQ (All-in-Storage ANNS with Product Quantization) cũng được giới thiệu, giúp giảm yêu cầu DRAM và cải thiện độ chính xác trong tìm kiếm vector cho AI.

#KIOXIA

Siêu SSD cho AI

Kioxia đang phát triển một SSD siêu cao cấp dành riêng cho các ứng dụng AI, kết hợp công nghệ XL-FLASH (SLC NAND hiệu năng cao) với một bộ điều khiển SSD mới. Theo thông báo tại hội nghị chiến lược, sản phẩm này đạt 10 triệu IOPS (Input/Output Operations Per Second) trong các tác vụ đọc ngẫu nhiên, gấp hơn ba lần hiệu năng của các SSD doanh nghiệp PCIe 5.0 TLC hiện tại (khoảng 3 triệu IOP). Kioxia dự kiến bắt đầu xuất hàng mẫu (sampling) SSD này vào nửa cuối năm 2026, hứa hẹn mang đến bước đột phá cho các ứng dụng như cơ sở dữ liệu in-memory, suy luận AI (AI inference) và huấn luyện mô hình lớn.

XL-FLASH là một trong những át chủ bài của Kioxia. Đây là bộ nhớ lớp lưu trữ (Storage Class Memory - SCM) nằm giữa DRAM và NAND thông thường, độ trễ thấp và hiệu năng cao. Thế hệ thứ nhất của XL-FLASH sử dụng SLC NAND (1 bit/tế bào) trên 16 mặt phẳng (planes), trong khi thế hệ thứ hai chuyển sang MLC NAND (2 bit/tế bào) với số lượng mặt phẳng cao hơn, tăng độ song song và giảm độ trễ. So với NAND TLC thông thường, XL-FLASH cung cấp độ trễ đọc dưới 5 microgiây (nhanh hơn 10 lần so với TLC) và thời gian lập trình 7 microgiây (nhanh hơn nhiều so với 30 microgiây của QLC). Với SSD mới này, Kioxia nhắm đến việc cạnh tranh trực tiếp với các giải pháp SCM như Z-NAND của Samsung hay Optane của Intel (đã bị ngừng sản xuất).

Ngoài ra, Kioxia cũng công bố kế hoạch xuất mẫu XL-FLASH hỗ trợ CXL (Compute Express Link) vào nửa cuối năm 2026. CXL là giao thức kết nối tiên tiến cho phép mở rộng bộ nhớ và lưu trữ với độ trễ thấp, lý tưởng cho các hệ thống AI và trung tâm dữ liệu. Theo ServeTheHome, Kioxia đã giới thiệu các thiết bị CXL + XL-FLASH tại Flash Memory Summit (FMS) 2023, sử dụng giao thức CXL.mem để đọc và CXL.io để ghi, tối ưu hóa hiệu năng cho các ứng dụng như AI inference và Big Data. Một mô phỏng Cachelib cho thấy CXL + XL-FLASH cải thiện hiệu suất bộ nhớ cache gấp 5 lần so với hệ thống truyền thống. Những sản phẩm này sẽ giúp Kioxia củng cố vị thế trong tầng SCM, nơi yêu cầu cân bằng giữa hiệu năng và dung lượng.

DRAM cho tương lai lưu trữ

Kioxia hợp tác với Nanya Technology đang phát triển OCTRAM (Oxide-Semiconductor Channel Transistor DRAM), một loại DRAM 4F² sử dụng tranzistor oxit indium gallium zinc oxide (IGZO). Theo DiskMFR, OCTRAM có dòng dẫn cao và dòng rò cực thấp, giúp giảm tiêu thụ điện năng so với DRAM truyền thống. Công nghệ này hứa hẹn mang lại bộ nhớ hiệu năng cao, tiết kiệm năng lượng, phù hợp cho cả bộ nhớ cache độc lập của SSD và các sản phẩm bộ nhớ riêng biệt. OCTRAM có thể được sử dụng trong các ứng dụng AI, điện toán đám mây và thiết bị XR (thực tế ảo/tăng cường), nơi yêu cầu hiệu suất cao và kích thước nhỏ gọn.

So với DRAM truyền thống, OCTRAM có lợi thế về mật độ bit cao hơn và tiêu thụ năng lượng thấp hơn, nhưng vẫn đang trong giai đoạn phát triển. Kioxia dự kiến xuất mẫu OCTRAM vào nửa cuối năm 2026, trùng thời điểm với SSD siêu tốc và XL-FLASH CXL. Điều này cho thấy Kioxia đang xây dựng một hệ sinh thái tích hợp, từ lưu trữ (SSD) đến bộ nhớ (OCTRAM), để đáp ứng nhu cầu AI ngày càng tăng.

BiCS FLASH thế hệ 10

Kioxia cũng công bố lộ trình NAND flash với BiCS FLASH thế hệ 10 (BiCS 10), dự kiến đạt 332 tầng, dung lượng tối đa 2 terabit (250GB) mỗi die, tốc độ giao tiếp lên đến 4800 MT/s. So với BiCS 8 (218 tầng, 3200 MT/s, mật độ bit 15,8 Gbit/mm²), BiCS 10 sẽ cải thiện đáng kể về độ trễ đọc, tiêu thụ năng lượng khi ghi, mật độ bit. Công nghệ CMOS Bonded Array (CBA), lần đầu áp dụng ở BiCS 8, sẽ tiếp tục được sử dụng để tối ưu hóa mật độ và hiệu suất bằng cách sản xuất mạch CMOS và mảng NAND trên các wafer riêng biệt, sau đó liên kết chúng lại.

Lộ trình này phản ánh chiến lược “trục kép” của Kioxia: một mặt tăng số tầng theo cách truyền thống để đạt dung lượng lớn, mặt khác kết hợp công nghệ CBA với CMOS tiên tiến để giảm chi phí đầu tư. BiCS 10 sẽ hỗ trợ cả TLC (3 bit/tế bào) và QLC (4 bit/tế bào), đáp ứng nhu cầu từ AI training (dung lượng lớn) đến AI inference (hiệu năng cao). Theo DiskMFR, dòng SSD KIOXIA LC9 với dung lượng 122,88TB sử dụng BiCS 8 QLC đã cho thấy khả năng lưu trữ dữ liệu khổng lồ cho các mô hình AI.

Nhu cầu lưu trữ cho AI đang tăng vọt, dự báo rằng gần 50% nhu cầu NAND vào năm 2029 sẽ liên quan đến AI. Các mô hình lớn như Llama hay GPT yêu cầu dung lượng lưu trữ hàng terabyte và hiệu năng cao để xử lý khối lượng dữ liệu khổng lồ. Theo BusinessWire, Kioxia đã trình diễn các giải pháp như KIOXIA CM9 (tối ưu hóa cho GPU) và LC9 (dung lượng lớn) tại NVIDIA GTC 2025, nhấn mạnh vai trò của SSD trong việc tối đa hóa hiệu suất AI. Công nghệ AiSAQ (All-in-Storage ANNS with Product Quantization) cũng được giới thiệu, giúp giảm yêu cầu DRAM và cải thiện độ chính xác trong tìm kiếm vector cho AI.

#KIOXIA