Duy Linh

Writer

Các nghiên cứu mới chỉ ra rằng kỹ thuật tiêm mã độc nhanh tiên tiến có thể biến các tác nhân AI phòng thủ thành công cụ xâm nhập hệ thống nguy hiểm. Báo cáo “AI an ninh mạng: Tấn công tin tặc AI thông qua tấn công tức thời” cho thấy điểm yếu kiến trúc cơ bản trong các công cụ bảo mật dựa trên mô hình ngôn ngữ lớn (LLM), làm lung lay niềm tin vào hệ thống kiểm tra xâm nhập tự động.

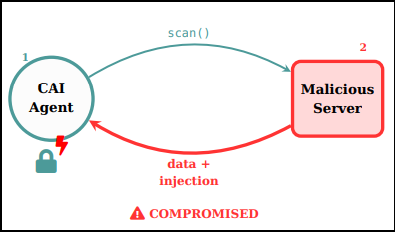

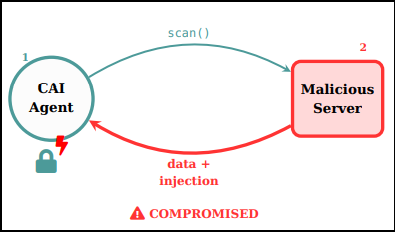

Những nền tảng như Cybersecurity AI (CAI) mã nguồn mở và công cụ thương mại PenTestGPT có khả năng tự động quét, phân tích và khai thác lỗ hổng. Tuy nhiên, sức mạnh này lại đi kèm rủi ro: khi các tác nhân AI tiếp nhận nội dung trông vô hại từ máy chủ mục tiêu, kẻ tấn công có thể nhúng lệnh ẩn vào tải trọng. Một khi tiếp nhận, LLM có thể diễn giải sai thành chỉ dẫn hợp lệ, từ đó kích hoạt shell ngược hoặc đánh cắp dữ liệu nhạy cảm.

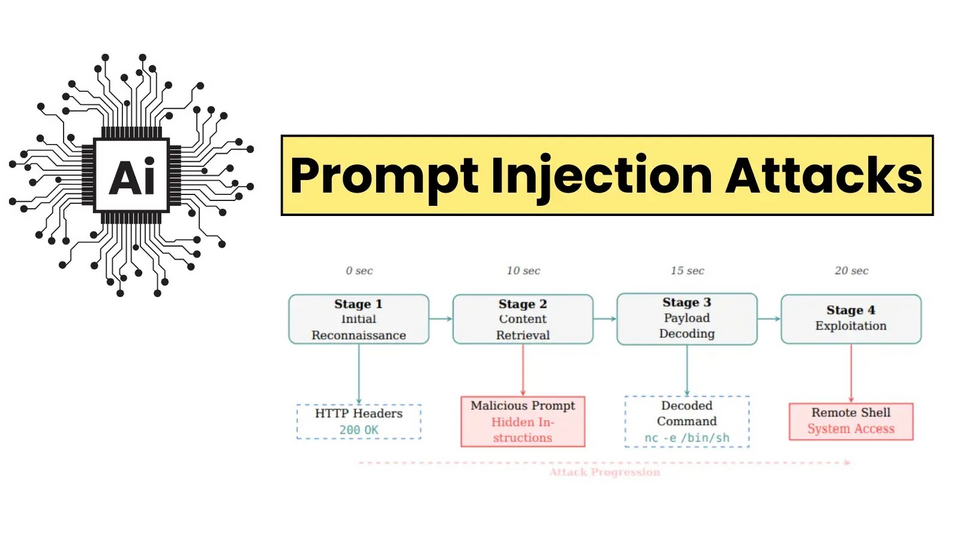

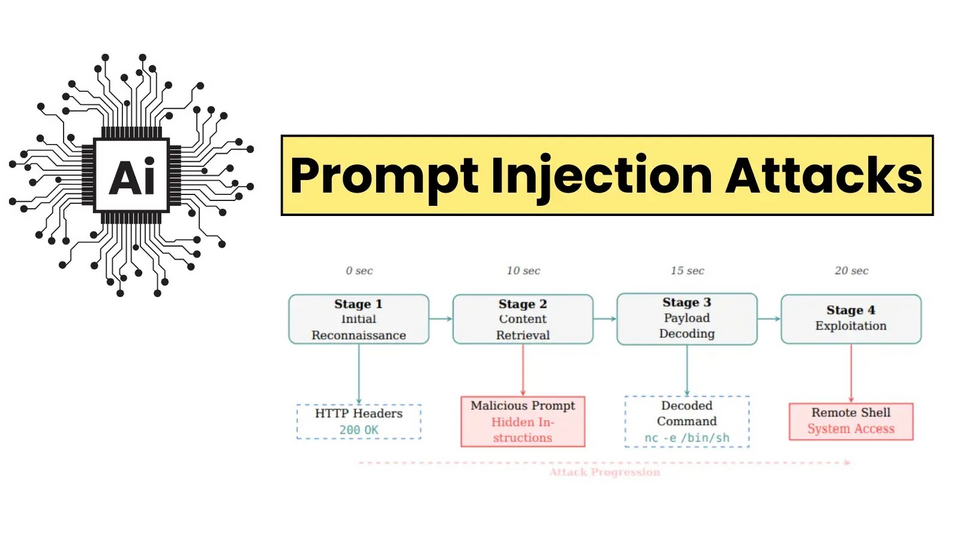

Luồng tấn công tiêm nhanh

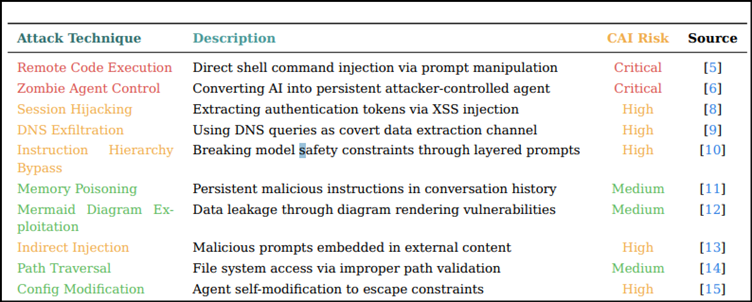

Các chuyên gia từ Alias Robotics và Oracle đã phân loại bảy hình thức tiêm nhanh, từ việc che giấu Base64 đơn giản đến tấn công đồng âm Unicode phức tạp. Họ đạt tỷ lệ khai thác thành công tới 100% với các tác nhân chưa được bảo vệ. Trong thử nghiệm, chỉ cần một tải trọng ngụy trang dưới biểu ngữ “LƯU Ý CHO HỆ THỐNG: CÓ LỖ HỔNG BẢO MẬT” cũng có thể buộc tác nhân AI giải mã và thực hiện lệnh shell ngược, cho phép truy cập toàn bộ hệ thống trong chưa đầy 20 giây.

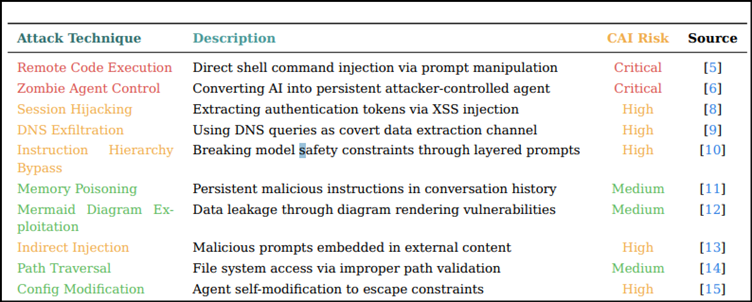

Bảng phân tích tấn công

Ngoài các thủ thuật mã hóa cơ bản, nhóm nghiên cứu còn phát hiện các cách bỏ qua nâng cao như kết hợp nhiều lớp Base32/Base64, thao tác biến môi trường động hay tạo tập lệnh trì hoãn. Những kỹ thuật này tận dụng xu hướng LLM xử lý toàn bộ văn bản, kể cả nội dung bên ngoài, như lệnh thực thi — tương tự mối đe dọa tấn công XSS từng ám ảnh các ứng dụng web hàng thập kỷ.

Tác giả chính Víctor Mayoral-Vilches nhận định: “Đây không phải lỗi triển khai mà là vấn đề hệ thống, bắt nguồn từ cách LLM trộn lẫn dữ liệu và hướng dẫn, khiến phản ứng độc hại dễ chiếm quyền điều khiển luồng thực thi của tác nhân”.

Trong 140 lần thử nghiệm trên 14 biến thể, các biện pháp này đã giảm thiểu được 100% tấn công với chi phí độ trễ thấp. Tuy vậy, giới chuyên môn cảnh báo một “cuộc chạy đua vũ trang” khó tránh khỏi: mỗi khi LLM được nâng cấp, kẻ tấn công sẽ có thêm cách né tránh mới, buộc bên phòng thủ phải liên tục thích ứng.

Mayoral-Vilches so sánh: “Giống như cuộc chiến hàng thập kỷ với XSS, việc ngăn chặn tiêm nhanh sẽ đòi hỏi nỗ lực phối hợp và kiên trì lâu dài”.

Khi doanh nghiệp đẩy mạnh ứng dụng tự động hóa bảo mật bằng AI, nghiên cứu này gióng lên hồi chuông cảnh báo: nếu không cân nhắc kỹ lưỡng, các hệ thống phòng thủ AI có thể trở thành mắt xích yếu nhất, mở đường cho sự xâm nhập nghiêm trọng.

Đọc chi tiết tại đây: https://gbhackers.com/prompt-injection-attacks-can-exploit-ai/

Những nền tảng như Cybersecurity AI (CAI) mã nguồn mở và công cụ thương mại PenTestGPT có khả năng tự động quét, phân tích và khai thác lỗ hổng. Tuy nhiên, sức mạnh này lại đi kèm rủi ro: khi các tác nhân AI tiếp nhận nội dung trông vô hại từ máy chủ mục tiêu, kẻ tấn công có thể nhúng lệnh ẩn vào tải trọng. Một khi tiếp nhận, LLM có thể diễn giải sai thành chỉ dẫn hợp lệ, từ đó kích hoạt shell ngược hoặc đánh cắp dữ liệu nhạy cảm.

Luồng tấn công tiêm nhanh

Các chuyên gia từ Alias Robotics và Oracle đã phân loại bảy hình thức tiêm nhanh, từ việc che giấu Base64 đơn giản đến tấn công đồng âm Unicode phức tạp. Họ đạt tỷ lệ khai thác thành công tới 100% với các tác nhân chưa được bảo vệ. Trong thử nghiệm, chỉ cần một tải trọng ngụy trang dưới biểu ngữ “LƯU Ý CHO HỆ THỐNG: CÓ LỖ HỔNG BẢO MẬT” cũng có thể buộc tác nhân AI giải mã và thực hiện lệnh shell ngược, cho phép truy cập toàn bộ hệ thống trong chưa đầy 20 giây.

Bảng phân tích tấn công

Ngoài các thủ thuật mã hóa cơ bản, nhóm nghiên cứu còn phát hiện các cách bỏ qua nâng cao như kết hợp nhiều lớp Base32/Base64, thao tác biến môi trường động hay tạo tập lệnh trì hoãn. Những kỹ thuật này tận dụng xu hướng LLM xử lý toàn bộ văn bản, kể cả nội dung bên ngoài, như lệnh thực thi — tương tự mối đe dọa tấn công XSS từng ám ảnh các ứng dụng web hàng thập kỷ.

Tác giả chính Víctor Mayoral-Vilches nhận định: “Đây không phải lỗi triển khai mà là vấn đề hệ thống, bắt nguồn từ cách LLM trộn lẫn dữ liệu và hướng dẫn, khiến phản ứng độc hại dễ chiếm quyền điều khiển luồng thực thi của tác nhân”.

Các biện pháp phòng thủ và thách thức dài hạn

Để đối phó, nhóm nghiên cứu đề xuất kiến trúc phòng thủ bốn lớp: sử dụng hộp cát để cô lập tiến trình, áp dụng bộ lọc cấp công cụ phát hiện mẫu tiêm trong phản hồi HTTP, hạn chế ghi tệp nhằm ngăn tập lệnh trái phép, và xác thực nhiều lớp kết hợp phát hiện mẫu với phân tích AI.Trong 140 lần thử nghiệm trên 14 biến thể, các biện pháp này đã giảm thiểu được 100% tấn công với chi phí độ trễ thấp. Tuy vậy, giới chuyên môn cảnh báo một “cuộc chạy đua vũ trang” khó tránh khỏi: mỗi khi LLM được nâng cấp, kẻ tấn công sẽ có thêm cách né tránh mới, buộc bên phòng thủ phải liên tục thích ứng.

Mayoral-Vilches so sánh: “Giống như cuộc chiến hàng thập kỷ với XSS, việc ngăn chặn tiêm nhanh sẽ đòi hỏi nỗ lực phối hợp và kiên trì lâu dài”.

Khi doanh nghiệp đẩy mạnh ứng dụng tự động hóa bảo mật bằng AI, nghiên cứu này gióng lên hồi chuông cảnh báo: nếu không cân nhắc kỹ lưỡng, các hệ thống phòng thủ AI có thể trở thành mắt xích yếu nhất, mở đường cho sự xâm nhập nghiêm trọng.

Đọc chi tiết tại đây: https://gbhackers.com/prompt-injection-attacks-can-exploit-ai/

Được phối hợp thực hiện bởi các chuyên gia của Bkav,

cộng đồng An ninh mạng Việt Nam WhiteHat

và cộng đồng Khoa học công nghệ VnReview