A-Train The Seven

...'cause for once, I didn't hate myself.

Các nhà nghiên cứu thuộc FAIR, bộ phận nghiên cứu AI của Meta, đã công bố bài báo "Global Lyapunov functions: a long-standing open problem in mathematics, with symbolic transformers", báo cáo về việc sử dụng AI để giải quyết bài toán tìm "hàm Lyapunov" đảm bảo tính ổn định, một vấn đề đã làm đau đầu các nhà toán học hơn một thế kỷ.

"Tính ổn định của hệ thống động lực" là một vấn đề cơ bản và quan trọng trong toán học. Kể từ khi Newton và Lagrange bắt đầu nghiên cứu vào thế kỷ 18, nó đã thu hút nhiều nhà toán học, bao gồm cả Poincaré.

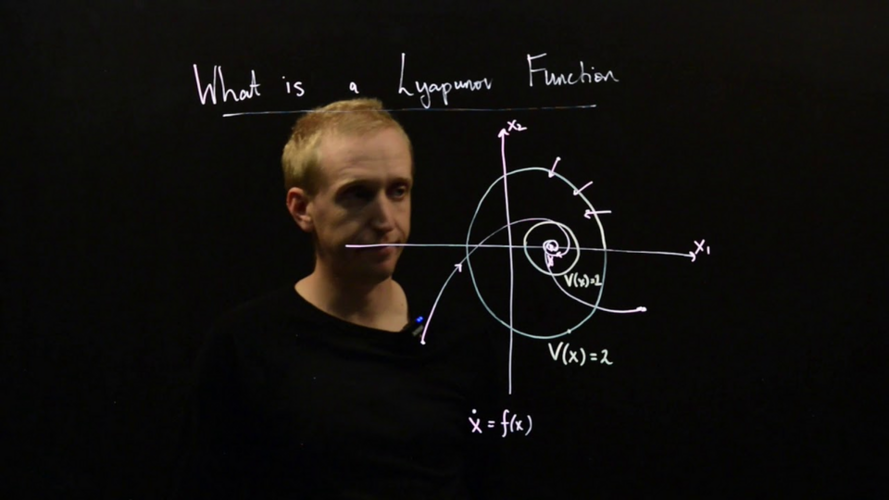

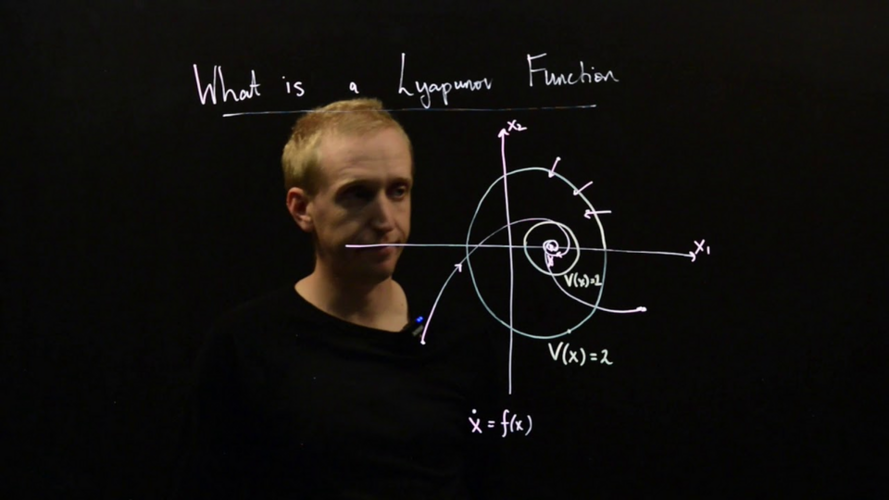

Tính ổn định ở đây đề cập đến tính chất của một hệ thống có khả năng trở về trạng thái ban đầu sau khi bị nhiễu loạn hoặc thay đổi điều kiện ban đầu. Hàm Lyapunov là công cụ để chứng minh tính ổn định này một cách toán học. Nếu hệ thống ổn định, giá trị của hàm này sẽ giảm dần theo thời gian. Ví dụ, một viên bi đặt trong một bát có đáy tròn sẽ ổn định và sẽ trở về vị trí ban đầu nếu bị đẩy nhẹ.

Năm 1892, nhà toán học người Nga Aleksandr Lyapunov đã phát hiện ra rằng để đảm bảo tính ổn định của một hệ thống, cần phải chứng minh sự tồn tại của một hàm tương tự như entropy (sau này được gọi là hàm Lyapunov). Tuy nhiên, khám phá này vẫn còn một thách thức lớn. Việc tìm hàm Lyapunov cho các hệ thống tổng quát là rất khó. Vấn đề này vẫn chưa được giải quyết trong hơn 130 năm.

Nhóm nghiên cứu đã tiếp cận vấn đề này bằng phương pháp học máy. Đầu tiên, họ tạo ngẫu nhiên các hàm Lyapunov và từ đó xây dựng các hệ thống ổn định. Phương pháp này tạo ra một lượng lớn dữ liệu huấn luyện, được sử dụng để huấn luyện một mô hình Transformer.

Mô hình AI mà nhóm nghiên cứu phát triển đã cho thấy hiệu suất đáng kinh ngạc. Nó đạt độ chính xác cao 99% trên tập dữ liệu kiểm tra của hệ thống đa thức và hiệu suất cao 73% trên tập dữ liệu kiểm tra có phân phối khác với dữ liệu huấn luyện. Hơn nữa, bằng cách thêm khoảng 300 nghiệm đã biết vào dữ liệu huấn luyện, hiệu suất đã được cải thiện lên 84%.

Hiệu suất trên các hệ thống thực tế chưa biết cũng đã được kiểm chứng. Đối với hệ thống đa thức, mô hình đã thành công trong việc tìm ra hàm Lyapunov trong khoảng 10% các bài toán được tạo ngẫu nhiên. Con số này gấp khoảng 5 lần hiệu suất của phương pháp số truyền thống (khoảng 2%). Hơn nữa, đối với các hệ thống phi đa thức mà trước đây chưa có phương pháp giải, mô hình cũng tìm được hàm Lyapunov trong khoảng 13% trường hợp.

Tốc độ xử lý của mô hình cũng rất nhanh. Trong khi phương pháp số truyền thống mất trung bình khoảng 16 phút để phân tích một hệ thống, mô hình này có thể đề xuất giải pháp trong vài giây. Nhóm nghiên cứu cũng đã so sánh mô hình với các nhà toán học. Kết quả cho thấy 25 sinh viên năm nhất thạc sĩ toán học có tỷ lệ trả lời đúng khoảng 9% trên một tập bài toán đa thức, trong khi mô hình đạt tỷ lệ 84% trên cùng tập bài toán đó.

"Tính ổn định của hệ thống động lực" là một vấn đề cơ bản và quan trọng trong toán học. Kể từ khi Newton và Lagrange bắt đầu nghiên cứu vào thế kỷ 18, nó đã thu hút nhiều nhà toán học, bao gồm cả Poincaré.

Tính ổn định ở đây đề cập đến tính chất của một hệ thống có khả năng trở về trạng thái ban đầu sau khi bị nhiễu loạn hoặc thay đổi điều kiện ban đầu. Hàm Lyapunov là công cụ để chứng minh tính ổn định này một cách toán học. Nếu hệ thống ổn định, giá trị của hàm này sẽ giảm dần theo thời gian. Ví dụ, một viên bi đặt trong một bát có đáy tròn sẽ ổn định và sẽ trở về vị trí ban đầu nếu bị đẩy nhẹ.

Năm 1892, nhà toán học người Nga Aleksandr Lyapunov đã phát hiện ra rằng để đảm bảo tính ổn định của một hệ thống, cần phải chứng minh sự tồn tại của một hàm tương tự như entropy (sau này được gọi là hàm Lyapunov). Tuy nhiên, khám phá này vẫn còn một thách thức lớn. Việc tìm hàm Lyapunov cho các hệ thống tổng quát là rất khó. Vấn đề này vẫn chưa được giải quyết trong hơn 130 năm.

Nhóm nghiên cứu đã tiếp cận vấn đề này bằng phương pháp học máy. Đầu tiên, họ tạo ngẫu nhiên các hàm Lyapunov và từ đó xây dựng các hệ thống ổn định. Phương pháp này tạo ra một lượng lớn dữ liệu huấn luyện, được sử dụng để huấn luyện một mô hình Transformer.

Mô hình AI mà nhóm nghiên cứu phát triển đã cho thấy hiệu suất đáng kinh ngạc. Nó đạt độ chính xác cao 99% trên tập dữ liệu kiểm tra của hệ thống đa thức và hiệu suất cao 73% trên tập dữ liệu kiểm tra có phân phối khác với dữ liệu huấn luyện. Hơn nữa, bằng cách thêm khoảng 300 nghiệm đã biết vào dữ liệu huấn luyện, hiệu suất đã được cải thiện lên 84%.

Hiệu suất trên các hệ thống thực tế chưa biết cũng đã được kiểm chứng. Đối với hệ thống đa thức, mô hình đã thành công trong việc tìm ra hàm Lyapunov trong khoảng 10% các bài toán được tạo ngẫu nhiên. Con số này gấp khoảng 5 lần hiệu suất của phương pháp số truyền thống (khoảng 2%). Hơn nữa, đối với các hệ thống phi đa thức mà trước đây chưa có phương pháp giải, mô hình cũng tìm được hàm Lyapunov trong khoảng 13% trường hợp.

Tốc độ xử lý của mô hình cũng rất nhanh. Trong khi phương pháp số truyền thống mất trung bình khoảng 16 phút để phân tích một hệ thống, mô hình này có thể đề xuất giải pháp trong vài giây. Nhóm nghiên cứu cũng đã so sánh mô hình với các nhà toán học. Kết quả cho thấy 25 sinh viên năm nhất thạc sĩ toán học có tỷ lệ trả lời đúng khoảng 9% trên một tập bài toán đa thức, trong khi mô hình đạt tỷ lệ 84% trên cùng tập bài toán đó.