Duy Linh

Writer

Một nhóm nghiên cứu an ninh mạng quốc tế đã phát triển một kỹ thuật phòng thủ mới nhằm làm mất giá trị sử dụng của các cơ sở dữ liệu trí tuệ nhân tạo bị đánh cắp, thay vì chỉ cố gắng ngăn chặn hành vi xâm nhập. Phương pháp này cố tình làm sai lệch các đồ thị tri thức độc quyền bằng những thông tin có vẻ hợp lý nhưng thực chất không chính xác, khiến hệ thống AI của kẻ tấn công cho ra kết quả sai lệch nghiêm trọng.

Các nhà nghiên cứu đã sử dụng chất độc hại để làm sai lệch dữ liệu bị đánh cắp nhằm phá hoại độ chính xác của mô hình trí tuệ nhân tạo.

Nghiên cứu do các nhà khoa học từ Viện Kỹ thuật Thông tin – Viện Hàn lâm Khoa học Trung Quốc, Đại học Quốc gia Singapore và Đại học Công nghệ Nanyang thực hiện, giới thiệu khung bảo vệ mang tên AURA (Active Utility Reduction via Adulteration). AURA được thiết kế để bảo vệ các đồ thị tri thức có giá trị cao – nền tảng của các hệ thống Graph Retrieval-Augmented Generation (GraphRAG) đang được sử dụng rộng rãi trong ngành dược phẩm và công nghệ lớn.

Các đồ thị tri thức độc quyền đại diện cho khoản đầu tư rất lớn vào tài sản trí tuệ, trong đó chi phí xây dựng có thể vượt 120 triệu USD (khoảng 2.880 tỷ VNĐ). Chính vì giá trị này, chúng ngày càng trở thành mục tiêu của tội phạm mạng và các mối đe dọa nội bộ. Những vụ việc điển hình bao gồm vụ một kỹ sư Waymo đánh cắp hơn 14.000 tệp tin độc quyền, hay cuộc tấn công mạng năm 2020 vào Cơ quan Dược phẩm Châu Âu, làm lộ dữ liệu bí mật liên quan đến vắc-xin Pfizer-BioNTech.

Trong bối cảnh đó, các biện pháp bảo mật truyền thống như đóng dấu bản quyền hay mã hóa bộc lộ nhiều hạn chế. Với các trường hợp sử dụng riêng tư, nơi kẻ tấn công vận hành dữ liệu bị đánh cắp trong môi trường biệt lập, những biện pháp này gần như mất tác dụng. Mã hóa còn tạo ra gánh nặng tính toán và độ trễ lớn, khiến các hệ thống AI thời gian thực khó khả thi.

Ở bước tiếp theo, hệ thống lựa chọn những yếu tố gây sai lệch có khả năng làm nhiễu tối đa kết quả AI thông qua Điểm Sai lệch Ngữ nghĩa, chỉ số đo mức độ mỗi mục sai có thể làm lệch đầu ra do AI tạo ra. Cuối cùng, một cơ chế mã hóa cho phép người dùng được ủy quyền, thông qua khóa bí mật, loại bỏ toàn bộ dữ liệu bị pha trộn, đảm bảo hoạt động hợp pháp không bị ảnh hưởng.

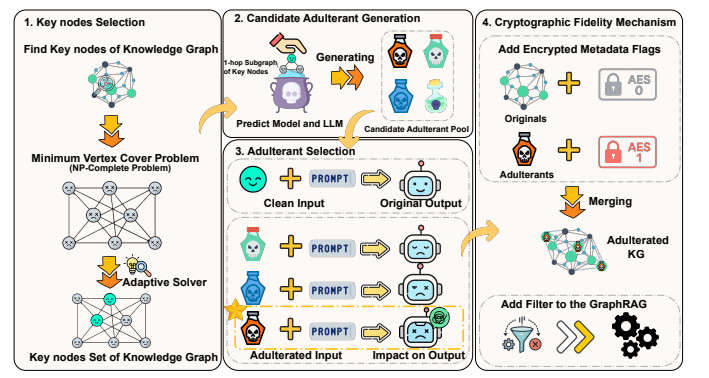

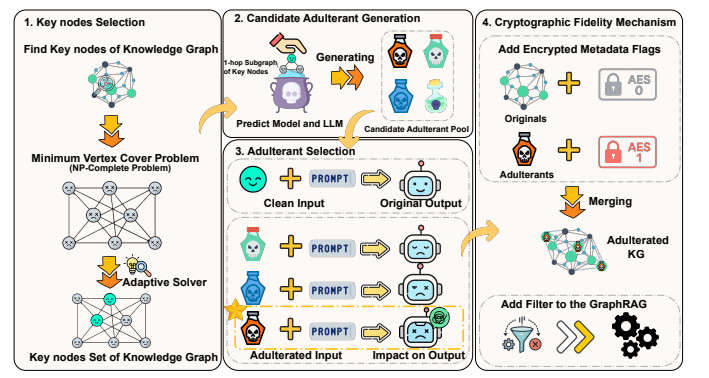

Tổng quan về AURA.

Thử nghiệm AURA trên bốn bộ dữ liệu chuẩn cùng nhiều mô hình AI khác nhau, bao gồm GPT-4o, Gemini-2.5-flash, Qwen-2.5-7B và Llama2-7B, cho thấy hiệu quả rõ rệt. Độ chính xác của các hệ thống không được ủy quyền giảm xuống chỉ còn 4,4–5,3%, trong khi điểm số mức độ gây hại luôn vượt 94%. Ngược lại, người dùng hợp lệ đạt độ chính xác 100% so với hệ thống gốc, với chi phí vận hành tối thiểu và mức tăng độ trễ truy vấn tối đa dưới 14%.

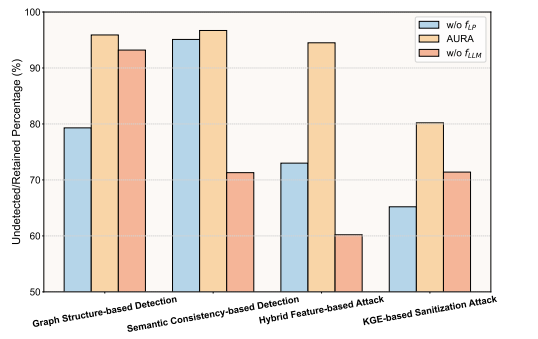

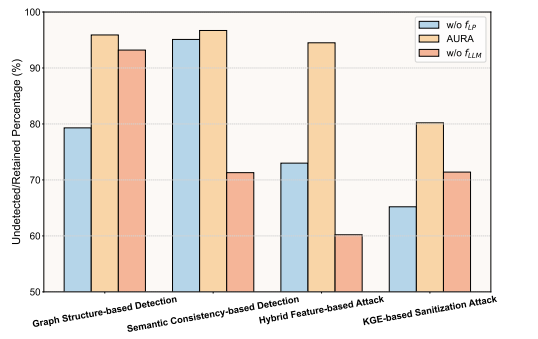

Tỷ lệ chất pha trộn còn sót lại sau các phương pháp khử trùng khác nhau.

Hiệu quả của AURA còn tăng lên theo độ phức tạp của truy vấn. Với các câu hỏi suy luận đa bước yêu cầu duyệt qua nhiều mối quan hệ dữ liệu, điểm số mức độ gây hại tăng từ 94,7% ở truy vấn đơn giản lên 95,8% ở các truy vấn ba bước.

Nghiên cứu này cho thấy một sự chuyển dịch quan trọng trong tư duy bảo mật, từ phát hiện thụ động sang chủ động làm suy yếu giá trị kinh tế của tài sản trí tuệ bị đánh cắp. Thay vì chỉ ngăn chặn xâm nhập, AURA khiến hành vi trộm cắp cơ sở dữ liệu AI trở nên kém hiệu quả và không còn hấp dẫn về mặt kinh tế, mang lại một cơ chế phòng vệ thực tiễn trước mối đe dọa ngày càng gia tăng trong kỷ nguyên mà đồ thị tri thức đóng vai trò nền tảng cho các ứng dụng kinh doanh then chốt, từ khám phá thuốc đến trí tuệ sản xuất. (gbhackers)

Đọc chi tiết tại đây: https://gbhackers.com/ai-model-accuracy/

Các nhà nghiên cứu đã sử dụng chất độc hại để làm sai lệch dữ liệu bị đánh cắp nhằm phá hoại độ chính xác của mô hình trí tuệ nhân tạo.

Nghiên cứu do các nhà khoa học từ Viện Kỹ thuật Thông tin – Viện Hàn lâm Khoa học Trung Quốc, Đại học Quốc gia Singapore và Đại học Công nghệ Nanyang thực hiện, giới thiệu khung bảo vệ mang tên AURA (Active Utility Reduction via Adulteration). AURA được thiết kế để bảo vệ các đồ thị tri thức có giá trị cao – nền tảng của các hệ thống Graph Retrieval-Augmented Generation (GraphRAG) đang được sử dụng rộng rãi trong ngành dược phẩm và công nghệ lớn.

Các đồ thị tri thức độc quyền đại diện cho khoản đầu tư rất lớn vào tài sản trí tuệ, trong đó chi phí xây dựng có thể vượt 120 triệu USD (khoảng 2.880 tỷ VNĐ). Chính vì giá trị này, chúng ngày càng trở thành mục tiêu của tội phạm mạng và các mối đe dọa nội bộ. Những vụ việc điển hình bao gồm vụ một kỹ sư Waymo đánh cắp hơn 14.000 tệp tin độc quyền, hay cuộc tấn công mạng năm 2020 vào Cơ quan Dược phẩm Châu Âu, làm lộ dữ liệu bí mật liên quan đến vắc-xin Pfizer-BioNTech.

Trong bối cảnh đó, các biện pháp bảo mật truyền thống như đóng dấu bản quyền hay mã hóa bộc lộ nhiều hạn chế. Với các trường hợp sử dụng riêng tư, nơi kẻ tấn công vận hành dữ liệu bị đánh cắp trong môi trường biệt lập, những biện pháp này gần như mất tác dụng. Mã hóa còn tạo ra gánh nặng tính toán và độ trễ lớn, khiến các hệ thống AI thời gian thực khó khả thi.

AURA hoạt động như thế nào?

Khung AURA triển khai một quy trình bốn giai đoạn nhằm làm hỏng dữ liệu bị đánh cắp nhưng vẫn đảm bảo người dùng được ủy quyền khai thác bình thường. Đầu tiên, hệ thống xác định các nút quan trọng trong đồ thị tri thức thông qua các thuật toán phân tích nâng cao. Tiếp đó, AURA tạo ra các thông tin có cấu trúc hợp lý nhưng sai về mặt thực tế bằng cách kết hợp mô hình dự đoán liên kết với mô hình ngôn ngữ lớn, từ đó sinh ra các mục dữ liệu giả mạo hòa trộn tự nhiên với dữ liệu thật.Ở bước tiếp theo, hệ thống lựa chọn những yếu tố gây sai lệch có khả năng làm nhiễu tối đa kết quả AI thông qua Điểm Sai lệch Ngữ nghĩa, chỉ số đo mức độ mỗi mục sai có thể làm lệch đầu ra do AI tạo ra. Cuối cùng, một cơ chế mã hóa cho phép người dùng được ủy quyền, thông qua khóa bí mật, loại bỏ toàn bộ dữ liệu bị pha trộn, đảm bảo hoạt động hợp pháp không bị ảnh hưởng.

Tổng quan về AURA.

Thử nghiệm AURA trên bốn bộ dữ liệu chuẩn cùng nhiều mô hình AI khác nhau, bao gồm GPT-4o, Gemini-2.5-flash, Qwen-2.5-7B và Llama2-7B, cho thấy hiệu quả rõ rệt. Độ chính xác của các hệ thống không được ủy quyền giảm xuống chỉ còn 4,4–5,3%, trong khi điểm số mức độ gây hại luôn vượt 94%. Ngược lại, người dùng hợp lệ đạt độ chính xác 100% so với hệ thống gốc, với chi phí vận hành tối thiểu và mức tăng độ trễ truy vấn tối đa dưới 14%.

Sự lén lút và khả năng phục hồi của AURA

Các dữ liệu pha trộn do AURA tạo ra được chứng minh là rất khó phát hiện, khi né tránh cả các công cụ dò tìm bất thường về cấu trúc lẫn ngữ nghĩa, với tỷ lệ phát hiện dưới 4,1%. Ngay cả sau các cuộc tấn công làm sạch dữ liệu phức tạp, 80,2% dữ liệu pha trộn vẫn tồn tại trong đồ thị tri thức, và độ chính xác của hệ thống trái phép vẫn bị giữ dưới 17,7%.

Tỷ lệ chất pha trộn còn sót lại sau các phương pháp khử trùng khác nhau.

Hiệu quả của AURA còn tăng lên theo độ phức tạp của truy vấn. Với các câu hỏi suy luận đa bước yêu cầu duyệt qua nhiều mối quan hệ dữ liệu, điểm số mức độ gây hại tăng từ 94,7% ở truy vấn đơn giản lên 95,8% ở các truy vấn ba bước.

Nghiên cứu này cho thấy một sự chuyển dịch quan trọng trong tư duy bảo mật, từ phát hiện thụ động sang chủ động làm suy yếu giá trị kinh tế của tài sản trí tuệ bị đánh cắp. Thay vì chỉ ngăn chặn xâm nhập, AURA khiến hành vi trộm cắp cơ sở dữ liệu AI trở nên kém hiệu quả và không còn hấp dẫn về mặt kinh tế, mang lại một cơ chế phòng vệ thực tiễn trước mối đe dọa ngày càng gia tăng trong kỷ nguyên mà đồ thị tri thức đóng vai trò nền tảng cho các ứng dụng kinh doanh then chốt, từ khám phá thuốc đến trí tuệ sản xuất. (gbhackers)

Đọc chi tiết tại đây: https://gbhackers.com/ai-model-accuracy/

Được phối hợp thực hiện bởi các chuyên gia của Bkav,

cộng đồng An ninh mạng Việt Nam WhiteHat

và cộng đồng Khoa học công nghệ VnReview