Dũng Đỗ

Writer

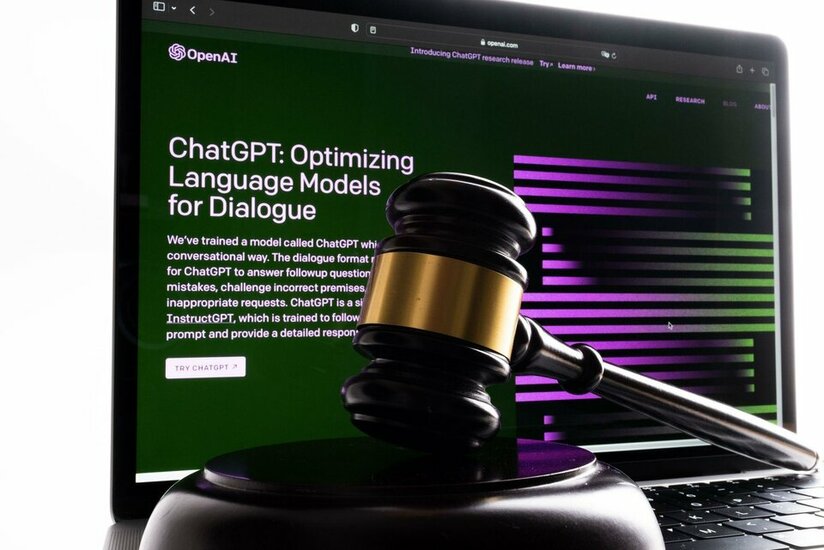

Áp lực thời gian, sự tiện lợi ban đầu và cả sự hiểu lầm về cách hoạt động của các mô hình ngôn ngữ lớn (LLM) đang khiến nhiều luật sư gặp rắc rối khi dựa vào AI cho nghiên cứu pháp lý. Dù có nhiều lợi ích tiềm năng, việc thiếu kiểm chứng có thể dẫn đến hậu quả nghiêm trọng.

Khi AI "bịa chuyện" và luật sư "lãnh đủ"

Cứ vài tuần một lần, dường như lại có một tiêu đề mới về việc một luật sư nào đó gặp rắc rối vì nộp các tài liệu pháp lý chứa đựng, theo lời của một thẩm phán, "nghiên cứu giả mạo do AI tạo ra". Chi tiết các vụ việc có thể khác nhau, nhưng điểm chung vẫn là: một luật sư tìm đến các mô hình ngôn ngữ lớn (LLM) như ChatGPT để được hỗ trợ nghiên cứu pháp lý (hoặc tệ hơn là viết toàn bộ hồ sơ), LLM "ảo giác" (hallucinate) ra những vụ án không hề tồn tại, và vị luật sư đó không hề hay biết cho đến khi thẩm phán hoặc luật sư đối tụng chỉ ra sai lầm của họ. Trong một số trường hợp, bao gồm một vụ kiện hàng không từ năm 2023, các luật sư thậm chí đã phải nộp phạt vì những "sáng tạo" không có thật này của AI.

Vậy, tại sao họ vẫn chưa dừng lại việc sử dụng những công cụ tiềm ẩn nhiều rủi ro này?

Áp lực thời gian và sự hiểu lầm về "trợ lý AI"

Câu trả lời phần lớn nằm ở áp lực thời gian và cách AI đã len lỏi vào gần như mọi ngành nghề. Các cơ sở dữ liệu nghiên cứu pháp lý lớn như LexisNexis và Westlaw hiện nay đều đã tích hợp các công cụ AI. Đối với những luật sư phải xử lý khối lượng công việc khổng lồ, AI có vẻ như một trợ lý vô cùng hiệu quả. Hầu hết các luật sư không nhất thiết sử dụng ChatGPT để viết toàn bộ hồ sơ, nhưng họ ngày càng phụ thuộc vào nó và các LLM khác cho việc nghiên cứu.

Tuy nhiên, một vấn đề lớn là nhiều luật sư này, cũng như phần lớn công chúng, không thực sự hiểu rõ LLM là gì hoặc chúng hoạt động như thế nào. Một luật sư từng bị phạt vào năm 2023 thừa nhận rằng ông nghĩ ChatGPT là một "siêu công cụ tìm kiếm". Chỉ đến khi nộp một hồ sơ với đầy những trích dẫn giả mạo, ông mới nhận ra rằng nó更 giống một "cỗ máy tạo cụm từ ngẫu nhiên" – một cỗ máy có thể cung cấp thông tin chính xác, nhưng cũng có thể đưa ra những điều vô nghĩa được diễn đạt một cách đầy thuyết phục.

AI trong ngành luật: Lợi ích tiềm năng và thực tế sử dụng

Ông Andrew Perlman, hiệu trưởng Trường Luật Đại học Suffolk, cho rằng nhiều luật sư đang sử dụng các công cụ AI một cách hiệu quả và không gặp sự cố, những người bị phát hiện với các trích dẫn giả chỉ là số ít. "Tôi nghĩ rằng những gì chúng ta đang thấy hiện nay – mặc dù các vấn đề về ảo giác là có thật, và các luật sư phải xem xét nó rất nghiêm túc và cẩn trọng – không có nghĩa là những công cụ này không có những lợi ích và trường hợp sử dụng tiềm năng to lớn cho việc cung cấp dịch vụ pháp lý," ông Perlman nói.

Thực tế, một cuộc khảo sát năm 2024 của Thomson Reuters cho thấy 63% luật sư được hỏi cho biết họ đã từng sử dụng AI, và 12% nói rằng họ sử dụng AI thường xuyên. Những người được khảo sát cho biết họ sử dụng AI để viết tóm tắt án lệ và nghiên cứu "án lệ, đạo luật, biểu mẫu hoặc ngôn ngữ mẫu cho các lệnh." Họ xem AI là một công cụ tiết kiệm thời gian, và một nửa số người được khảo sát cho biết "khám phá tiềm năng triển khai AI" tại nơi làm việc là ưu tiên hàng đầu của họ. "Vai trò của một luật sư giỏi là một 'cố vấn đáng tin cậy' chứ không phải là người sản xuất tài liệu," một người trả lời khảo sát cho biết.

Nhưng như vô số ví dụ gần đây đã cho thấy, các tài liệu do AI tạo ra không phải lúc nào cũng chính xác, và trong một số trường hợp, chúng hoàn toàn không có thật.

Những vụ "tai nạn" AI nổi bật trong ngành luật:

Sử dụng AI một cách an toàn và hiệu quả hơn

Ông Perlman cho rằng có một số cách ít rủi ro hơn mà luật sư có thể sử dụng AI tạo sinh trong công việc, bao gồm tìm kiếm thông tin trong các tập tài liệu khám phá lớn, xem xét các bản tóm tắt hoặc hồ sơ, và động não về các lập luận khả thi hoặc các quan điểm đối lập. "Tôi nghĩ trong hầu hết mọi tác vụ, đều có những cách mà AI tạo sinh có thể hữu ích – không phải để thay thế sự phán đoán của luật sư, không phải để thay thế chuyên môn mà luật sư mang lại, mà là để bổ sung cho những gì luật sư làm và cho phép họ làm việc tốt hơn, nhanh hơn và rẻ hơn," ông Perlman nói.

Nhưng cũng như bất kỳ ai sử dụng công cụ AI, các luật sư dựa vào chúng để hỗ trợ nghiên cứu và viết lách pháp lý cần phải cẩn thận kiểm tra lại công việc mà AI tạo ra. Một phần của vấn đề là các luật sư thường xuyên thiếu thời gian – một vấn đề, theo ông Perlman, đã tồn tại từ trước khi LLM xuất hiện. "Ngay cả trước khi AI tạo sinh xuất hiện, các luật sư đôi khi vẫn nộp tài liệu với những trích dẫn không thực sự giải quyết vấn đề mà họ tuyên bố," ông nói. "Đó chỉ là một loại vấn đề khác. Đôi khi khi luật sư vội vàng, họ chèn các trích dẫn, họ không kiểm tra chúng đúng cách; họ không thực sự xem liệu vụ án đó có bị lật lại hay bác bỏ hay không." (Dù vậy, ít nhất những vụ án đó thường thực sự tồn tại.)

Một vấn đề khác, nguy hiểm hơn, là việc các luật sư – giống như những người khác sử dụng LLM – quá tin tưởng vào những gì AI tạo ra. "Tôi nghĩ nhiều người bị ru ngủ vào cảm giác thoải mái với kết quả đầu ra, bởi vì thoạt nhìn nó có vẻ được chế tạo rất tốt," ông Perlman nhận định.

Ông Alexander Kolodin, một luật sư bầu cử và là dân biểu bang Arizona thuộc Đảng Cộng hòa, cho biết ông coi ChatGPT như một cộng sự cấp thấp. Ông cũng đã sử dụng ChatGPT để giúp soạn thảo luật. Kolodin nói ông luôn kiểm tra lại các trích dẫn để đảm bảo chúng có thật. "Bạn không thể cứ thế gửi đi sản phẩm của một cộng sự cấp dưới mà không kiểm tra các trích dẫn," ông Kolodin nói. "Không chỉ máy móc mới 'ảo giác'; một cộng sự cấp dưới cũng có thể đọc sai vụ án."

Hướng dẫn từ Hiệp hội Luật sư Hoa Kỳ (ABA)

Việc sử dụng AI trong giới luật sư đã trở nên phổ biến đến mức vào năm 2024, Hiệp hội Luật sư Hoa Kỳ (ABA) đã ban hành hướng dẫn đầu tiên về việc luật sư sử dụng LLM và các công cụ AI khác. Hướng dẫn nêu rõ, các luật sư sử dụng công cụ AI "có nghĩa vụ về năng lực, bao gồm việc duy trì năng lực công nghệ liên quan, đòi hỏi sự hiểu biết về bản chất đang phát triển" của AI tạo sinh. Họ được khuyên nên "có được hiểu biết chung về lợi ích và rủi ro của các công cụ GAI" mà họ sử dụng – nói cách khác, không nên cho rằng LLM là một "siêu công cụ tìm kiếm." Luật sư cũng nên cân nhắc rủi ro bảo mật khi nhập thông tin liên quan đến vụ án của họ vào LLM và xem xét liệu có nên thông báo cho khách hàng về việc sử dụng AI hay không.

Tương lai của AI trong ngành luật: Giữa lạc quan và hoài nghi

Ông Perlman rất lạc quan về việc luật sư sử dụng AI. "Tôi thực sự nghĩ rằng AI tạo sinh sẽ là công nghệ có tác động lớn nhất mà ngành luật từng thấy và các luật sư sẽ được kỳ vọng sử dụng những công cụ này trong tương lai," ông nói. "Tôi nghĩ rằng đến một lúc nào đó, chúng ta sẽ ngừng lo lắng về năng lực của những luật sư sử dụng các công cụ này và bắt đầu lo lắng về năng lực của những luật sư không sử dụng chúng."

Những người khác, bao gồm cả một trong những thẩm phán đã phạt luật sư vì nộp hồ sơ đầy "ảo giác" do AI tạo ra, lại tỏ ra hoài nghi hơn. "Ngay cả với những tiến bộ gần đây," Thẩm phán Wilner viết, "không một luật sư có năng lực hợp lý nào nên giao phó việc nghiên cứu và viết lách cho công nghệ này – đặc biệt là khi không có bất kỳ nỗ lực nào để xác minh tính chính xác của tài liệu đó."

Cuộc tranh luận về vai trò và giới hạn của AI trong ngành luật chắc chắn sẽ còn tiếp tục, đòi hỏi sự cẩn trọng, đào tạo liên tục và những quy định rõ ràng hơn.

Khi AI "bịa chuyện" và luật sư "lãnh đủ"

Cứ vài tuần một lần, dường như lại có một tiêu đề mới về việc một luật sư nào đó gặp rắc rối vì nộp các tài liệu pháp lý chứa đựng, theo lời của một thẩm phán, "nghiên cứu giả mạo do AI tạo ra". Chi tiết các vụ việc có thể khác nhau, nhưng điểm chung vẫn là: một luật sư tìm đến các mô hình ngôn ngữ lớn (LLM) như ChatGPT để được hỗ trợ nghiên cứu pháp lý (hoặc tệ hơn là viết toàn bộ hồ sơ), LLM "ảo giác" (hallucinate) ra những vụ án không hề tồn tại, và vị luật sư đó không hề hay biết cho đến khi thẩm phán hoặc luật sư đối tụng chỉ ra sai lầm của họ. Trong một số trường hợp, bao gồm một vụ kiện hàng không từ năm 2023, các luật sư thậm chí đã phải nộp phạt vì những "sáng tạo" không có thật này của AI.

Vậy, tại sao họ vẫn chưa dừng lại việc sử dụng những công cụ tiềm ẩn nhiều rủi ro này?

Áp lực thời gian và sự hiểu lầm về "trợ lý AI"

Câu trả lời phần lớn nằm ở áp lực thời gian và cách AI đã len lỏi vào gần như mọi ngành nghề. Các cơ sở dữ liệu nghiên cứu pháp lý lớn như LexisNexis và Westlaw hiện nay đều đã tích hợp các công cụ AI. Đối với những luật sư phải xử lý khối lượng công việc khổng lồ, AI có vẻ như một trợ lý vô cùng hiệu quả. Hầu hết các luật sư không nhất thiết sử dụng ChatGPT để viết toàn bộ hồ sơ, nhưng họ ngày càng phụ thuộc vào nó và các LLM khác cho việc nghiên cứu.

Tuy nhiên, một vấn đề lớn là nhiều luật sư này, cũng như phần lớn công chúng, không thực sự hiểu rõ LLM là gì hoặc chúng hoạt động như thế nào. Một luật sư từng bị phạt vào năm 2023 thừa nhận rằng ông nghĩ ChatGPT là một "siêu công cụ tìm kiếm". Chỉ đến khi nộp một hồ sơ với đầy những trích dẫn giả mạo, ông mới nhận ra rằng nó更 giống một "cỗ máy tạo cụm từ ngẫu nhiên" – một cỗ máy có thể cung cấp thông tin chính xác, nhưng cũng có thể đưa ra những điều vô nghĩa được diễn đạt một cách đầy thuyết phục.

AI trong ngành luật: Lợi ích tiềm năng và thực tế sử dụng

Ông Andrew Perlman, hiệu trưởng Trường Luật Đại học Suffolk, cho rằng nhiều luật sư đang sử dụng các công cụ AI một cách hiệu quả và không gặp sự cố, những người bị phát hiện với các trích dẫn giả chỉ là số ít. "Tôi nghĩ rằng những gì chúng ta đang thấy hiện nay – mặc dù các vấn đề về ảo giác là có thật, và các luật sư phải xem xét nó rất nghiêm túc và cẩn trọng – không có nghĩa là những công cụ này không có những lợi ích và trường hợp sử dụng tiềm năng to lớn cho việc cung cấp dịch vụ pháp lý," ông Perlman nói.

Thực tế, một cuộc khảo sát năm 2024 của Thomson Reuters cho thấy 63% luật sư được hỏi cho biết họ đã từng sử dụng AI, và 12% nói rằng họ sử dụng AI thường xuyên. Những người được khảo sát cho biết họ sử dụng AI để viết tóm tắt án lệ và nghiên cứu "án lệ, đạo luật, biểu mẫu hoặc ngôn ngữ mẫu cho các lệnh." Họ xem AI là một công cụ tiết kiệm thời gian, và một nửa số người được khảo sát cho biết "khám phá tiềm năng triển khai AI" tại nơi làm việc là ưu tiên hàng đầu của họ. "Vai trò của một luật sư giỏi là một 'cố vấn đáng tin cậy' chứ không phải là người sản xuất tài liệu," một người trả lời khảo sát cho biết.

Nhưng như vô số ví dụ gần đây đã cho thấy, các tài liệu do AI tạo ra không phải lúc nào cũng chính xác, và trong một số trường hợp, chúng hoàn toàn không có thật.

Những vụ "tai nạn" AI nổi bật trong ngành luật:

- Vụ nhà báo Tim Burke: Các luật sư của nhà báo Tim Burke (bị bắt vì xuất bản cảnh quay chưa phát sóng của Fox News vào năm 2024) đã đệ trình một kiến nghị bác bỏ vụ án dựa trên Tu chính án thứ nhất. Sau khi phát hiện hồ sơ chứa "những trình bày sai lệch và trích dẫn sai nghiêm trọng về án lệ và lịch sử được cho là có liên quan," Thẩm phán Kathryn Kimball Mizelle (Florida) đã ra lệnh loại bỏ kiến nghị này khỏi hồ sơ vụ án. Theo Tampa Bay Times, Thẩm phán Mizelle đã tìm thấy chín "ảo giác" trong tài liệu. Luật sư Mark Rasch sau đó đã nhận toàn bộ trách nhiệm và cho biết ông đã sử dụng tính năng "nghiên cứu sâu" trên ChatGPT Pro và tính năng AI của Westlaw.

- Vụ kiện Anthropic: Gần đây, các luật sư đại diện cho chính công ty AI Anthropic đã thừa nhận sử dụng Claude AI của công ty để hỗ trợ viết một bản khai của nhân chứng chuyên môn, được nộp như một phần của vụ kiện vi phạm bản quyền do các nhà xuất bản âm nhạc đệ trình. Hồ sơ đó bao gồm một trích dẫn với "tiêu đề không chính xác và tác giả không chính xác."

- Vụ chuyên gia Jeff Hancock: Tháng 12 năm ngoái, chuyên gia về thông tin sai lệch Jeff Hancock thừa nhận ông đã sử dụng ChatGPT để giúp sắp xếp các trích dẫn trong một bản khai mà ông đệ trình để ủng hộ một luật của Minnesota về việc sử dụng deepfake. Hồ sơ của Hancock bao gồm "hai lỗi trích dẫn, thường được gọi là 'ảo giác'," và liệt kê sai tác giả cho một trích dẫn khác.

Sử dụng AI một cách an toàn và hiệu quả hơn

Ông Perlman cho rằng có một số cách ít rủi ro hơn mà luật sư có thể sử dụng AI tạo sinh trong công việc, bao gồm tìm kiếm thông tin trong các tập tài liệu khám phá lớn, xem xét các bản tóm tắt hoặc hồ sơ, và động não về các lập luận khả thi hoặc các quan điểm đối lập. "Tôi nghĩ trong hầu hết mọi tác vụ, đều có những cách mà AI tạo sinh có thể hữu ích – không phải để thay thế sự phán đoán của luật sư, không phải để thay thế chuyên môn mà luật sư mang lại, mà là để bổ sung cho những gì luật sư làm và cho phép họ làm việc tốt hơn, nhanh hơn và rẻ hơn," ông Perlman nói.

Nhưng cũng như bất kỳ ai sử dụng công cụ AI, các luật sư dựa vào chúng để hỗ trợ nghiên cứu và viết lách pháp lý cần phải cẩn thận kiểm tra lại công việc mà AI tạo ra. Một phần của vấn đề là các luật sư thường xuyên thiếu thời gian – một vấn đề, theo ông Perlman, đã tồn tại từ trước khi LLM xuất hiện. "Ngay cả trước khi AI tạo sinh xuất hiện, các luật sư đôi khi vẫn nộp tài liệu với những trích dẫn không thực sự giải quyết vấn đề mà họ tuyên bố," ông nói. "Đó chỉ là một loại vấn đề khác. Đôi khi khi luật sư vội vàng, họ chèn các trích dẫn, họ không kiểm tra chúng đúng cách; họ không thực sự xem liệu vụ án đó có bị lật lại hay bác bỏ hay không." (Dù vậy, ít nhất những vụ án đó thường thực sự tồn tại.)

Một vấn đề khác, nguy hiểm hơn, là việc các luật sư – giống như những người khác sử dụng LLM – quá tin tưởng vào những gì AI tạo ra. "Tôi nghĩ nhiều người bị ru ngủ vào cảm giác thoải mái với kết quả đầu ra, bởi vì thoạt nhìn nó có vẻ được chế tạo rất tốt," ông Perlman nhận định.

Ông Alexander Kolodin, một luật sư bầu cử và là dân biểu bang Arizona thuộc Đảng Cộng hòa, cho biết ông coi ChatGPT như một cộng sự cấp thấp. Ông cũng đã sử dụng ChatGPT để giúp soạn thảo luật. Kolodin nói ông luôn kiểm tra lại các trích dẫn để đảm bảo chúng có thật. "Bạn không thể cứ thế gửi đi sản phẩm của một cộng sự cấp dưới mà không kiểm tra các trích dẫn," ông Kolodin nói. "Không chỉ máy móc mới 'ảo giác'; một cộng sự cấp dưới cũng có thể đọc sai vụ án."

Hướng dẫn từ Hiệp hội Luật sư Hoa Kỳ (ABA)

Việc sử dụng AI trong giới luật sư đã trở nên phổ biến đến mức vào năm 2024, Hiệp hội Luật sư Hoa Kỳ (ABA) đã ban hành hướng dẫn đầu tiên về việc luật sư sử dụng LLM và các công cụ AI khác. Hướng dẫn nêu rõ, các luật sư sử dụng công cụ AI "có nghĩa vụ về năng lực, bao gồm việc duy trì năng lực công nghệ liên quan, đòi hỏi sự hiểu biết về bản chất đang phát triển" của AI tạo sinh. Họ được khuyên nên "có được hiểu biết chung về lợi ích và rủi ro của các công cụ GAI" mà họ sử dụng – nói cách khác, không nên cho rằng LLM là một "siêu công cụ tìm kiếm." Luật sư cũng nên cân nhắc rủi ro bảo mật khi nhập thông tin liên quan đến vụ án của họ vào LLM và xem xét liệu có nên thông báo cho khách hàng về việc sử dụng AI hay không.

Tương lai của AI trong ngành luật: Giữa lạc quan và hoài nghi

Ông Perlman rất lạc quan về việc luật sư sử dụng AI. "Tôi thực sự nghĩ rằng AI tạo sinh sẽ là công nghệ có tác động lớn nhất mà ngành luật từng thấy và các luật sư sẽ được kỳ vọng sử dụng những công cụ này trong tương lai," ông nói. "Tôi nghĩ rằng đến một lúc nào đó, chúng ta sẽ ngừng lo lắng về năng lực của những luật sư sử dụng các công cụ này và bắt đầu lo lắng về năng lực của những luật sư không sử dụng chúng."

Những người khác, bao gồm cả một trong những thẩm phán đã phạt luật sư vì nộp hồ sơ đầy "ảo giác" do AI tạo ra, lại tỏ ra hoài nghi hơn. "Ngay cả với những tiến bộ gần đây," Thẩm phán Wilner viết, "không một luật sư có năng lực hợp lý nào nên giao phó việc nghiên cứu và viết lách cho công nghệ này – đặc biệt là khi không có bất kỳ nỗ lực nào để xác minh tính chính xác của tài liệu đó."

Cuộc tranh luận về vai trò và giới hạn của AI trong ngành luật chắc chắn sẽ còn tiếp tục, đòi hỏi sự cẩn trọng, đào tạo liên tục và những quy định rõ ràng hơn.