Tháp rơi tự do

Intern Writer

Trong nhiều thế kỷ, chúng ta đã tự hỏi liệu kiến thức có phải là tiềm ẩn và bẩm sinh hay được học và nắm bắt thông qua kinh nghiệm, và một dự án nghiên cứu mới đang đặt ra câu hỏi tương tự về AI.

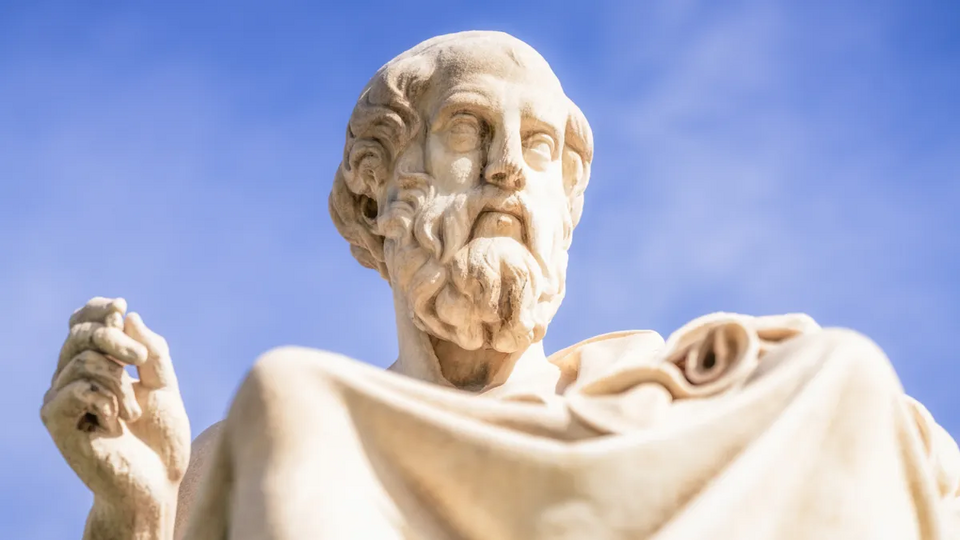

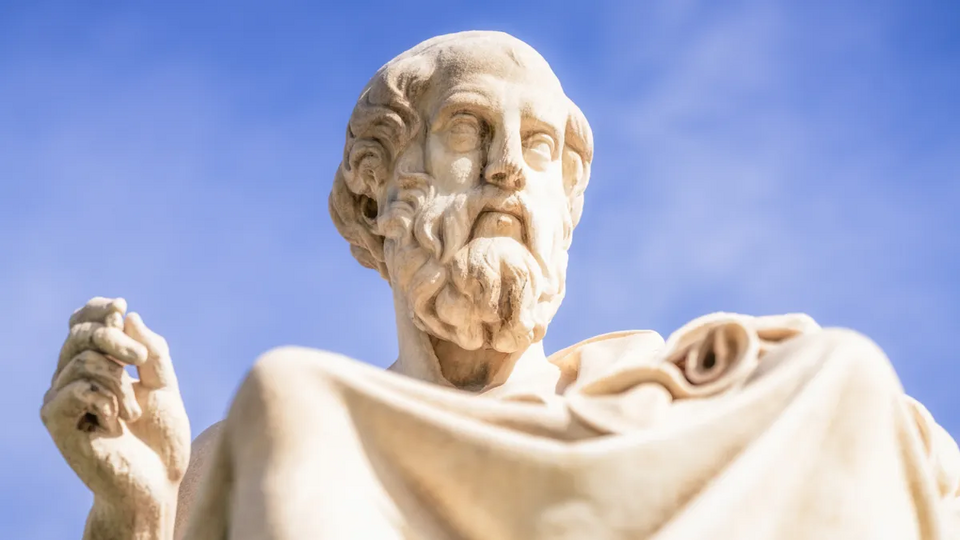

Nhà triết học Hy Lạp Plato từng kể lại rằng Socrates đã thách thức một học trò bằng bài toán “nhân đôi hình vuông” vào khoảng năm 385 trước Công nguyên. Khi được yêu cầu tăng gấp đôi diện tích một hình vuông, học trò đã nhầm lẫn khi nhân đôi độ dài mỗi cạnh, mà không biết rằng cạnh của hình vuông mới phải bằng đường chéo của hình vuông ban đầu.

Các nhà khoa học tại Đại học Cambridge và Đại học Hebrew ở Jerusalem đã chọn bài toán này để thử thách ChatGPT vì lời giải không hề hiển nhiên. Từ thời Plato cách đây 2.400 năm, giới học giả đã dùng nó để tranh luận liệu kiến thức toán học cần thiết để giải quyết có sẵn trong tiềm thức và được lý trí giải phóng, hay chỉ có thể đạt được qua kinh nghiệm học tập.

Vì ChatGPT và các mô hình ngôn ngữ lớn khác chủ yếu được huấn luyện trên văn bản thay vì hình ảnh, nhóm nghiên cứu nhận định khả năng câu trả lời chính xác xuất hiện sẵn trong dữ liệu huấn luyện là rất thấp. Do đó, nếu ChatGPT có thể tự đưa ra lời giải đúng, có thể coi như bằng chứng rằng khả năng toán học được học hỏi thay vì bẩm sinh.

Trong nghiên cứu được công bố ngày 17 tháng 9 trên tạp chí International Journal of Mathematical Education in Science and Technology, nhóm đã tiến xa hơn khi yêu cầu ChatGPT nhân đôi diện tích hình chữ nhật bằng lập luận tương tự. Hệ thống trả lời rằng vì đường chéo hình chữ nhật không thể dùng để nhân đôi diện tích, nên trong hình học không có lời giải. Tuy nhiên, các nhà nghiên cứu Nadav Marco từ Đại học Hebrew và giáo sư Andreas Stylianides của Đại học Cambridge biết rõ rằng vẫn tồn tại lời giải hình học.

Marco cho rằng khả năng câu trả lời sai này xuất hiện sẵn trong dữ liệu huấn luyện là “gần như bằng không”, điều đó có nghĩa ChatGPT đã ứng biến dựa trên cuộc trao đổi trước đó về bài toán nhân đôi hình vuông. Đây là dấu hiệu rõ ràng cho thấy nó đang “sáng tạo” câu trả lời thay vì đơn thuần lặp lại dữ liệu.

Ông nói thêm: “Khi đối diện một vấn đề mới, bản năng của chúng ta thường là thử nghiệm dựa trên kinh nghiệm trước đó. Trong thí nghiệm này, ChatGPT dường như cũng làm điều tương tự. Giống một người học hay học giả, nó dường như đã tự đưa ra giả thuyết và lời giải.”

Nghiên cứu này làm sáng tỏ thêm câu hỏi liệu AI có khả năng “lý luận” và “suy nghĩ” giống con người hay không. Marco và Stylianides cho rằng ChatGPT có thể đang vô tình vận dụng một khái niệm quen thuộc trong giáo dục gọi là “vùng phát triển gần” (zone of proximal development – ZPD), tức là khoảng cách giữa những gì ta biết và những gì ta có thể biết thêm nhờ sự hướng dẫn đúng đắn.

Theo các nhà nghiên cứu, ChatGPT có thể đang áp dụng khung tư duy này một cách tự phát, giải quyết những vấn đề chưa từng xuất hiện trong dữ liệu huấn luyện chỉ nhờ vào cách đặt câu hỏi phù hợp. Đây cũng là ví dụ điển hình về “hộp đen” trong AI, khi quá trình lập luận để đi đến kết quả không thể nhìn thấy hoặc truy vết, nhưng đồng thời mở ra cơ hội để phát triển hệ thống AI phục vụ con người hiệu quả hơn.

Nhà triết học Hy Lạp Plato từng kể lại rằng Socrates đã thách thức một học trò bằng bài toán “nhân đôi hình vuông” vào khoảng năm 385 trước Công nguyên. Khi được yêu cầu tăng gấp đôi diện tích một hình vuông, học trò đã nhầm lẫn khi nhân đôi độ dài mỗi cạnh, mà không biết rằng cạnh của hình vuông mới phải bằng đường chéo của hình vuông ban đầu.

Các nhà khoa học tại Đại học Cambridge và Đại học Hebrew ở Jerusalem đã chọn bài toán này để thử thách ChatGPT vì lời giải không hề hiển nhiên. Từ thời Plato cách đây 2.400 năm, giới học giả đã dùng nó để tranh luận liệu kiến thức toán học cần thiết để giải quyết có sẵn trong tiềm thức và được lý trí giải phóng, hay chỉ có thể đạt được qua kinh nghiệm học tập.

Vì ChatGPT và các mô hình ngôn ngữ lớn khác chủ yếu được huấn luyện trên văn bản thay vì hình ảnh, nhóm nghiên cứu nhận định khả năng câu trả lời chính xác xuất hiện sẵn trong dữ liệu huấn luyện là rất thấp. Do đó, nếu ChatGPT có thể tự đưa ra lời giải đúng, có thể coi như bằng chứng rằng khả năng toán học được học hỏi thay vì bẩm sinh.

Trong nghiên cứu được công bố ngày 17 tháng 9 trên tạp chí International Journal of Mathematical Education in Science and Technology, nhóm đã tiến xa hơn khi yêu cầu ChatGPT nhân đôi diện tích hình chữ nhật bằng lập luận tương tự. Hệ thống trả lời rằng vì đường chéo hình chữ nhật không thể dùng để nhân đôi diện tích, nên trong hình học không có lời giải. Tuy nhiên, các nhà nghiên cứu Nadav Marco từ Đại học Hebrew và giáo sư Andreas Stylianides của Đại học Cambridge biết rõ rằng vẫn tồn tại lời giải hình học.

Marco cho rằng khả năng câu trả lời sai này xuất hiện sẵn trong dữ liệu huấn luyện là “gần như bằng không”, điều đó có nghĩa ChatGPT đã ứng biến dựa trên cuộc trao đổi trước đó về bài toán nhân đôi hình vuông. Đây là dấu hiệu rõ ràng cho thấy nó đang “sáng tạo” câu trả lời thay vì đơn thuần lặp lại dữ liệu.

Ông nói thêm: “Khi đối diện một vấn đề mới, bản năng của chúng ta thường là thử nghiệm dựa trên kinh nghiệm trước đó. Trong thí nghiệm này, ChatGPT dường như cũng làm điều tương tự. Giống một người học hay học giả, nó dường như đã tự đưa ra giả thuyết và lời giải.”

Nghiên cứu này làm sáng tỏ thêm câu hỏi liệu AI có khả năng “lý luận” và “suy nghĩ” giống con người hay không. Marco và Stylianides cho rằng ChatGPT có thể đang vô tình vận dụng một khái niệm quen thuộc trong giáo dục gọi là “vùng phát triển gần” (zone of proximal development – ZPD), tức là khoảng cách giữa những gì ta biết và những gì ta có thể biết thêm nhờ sự hướng dẫn đúng đắn.

Theo các nhà nghiên cứu, ChatGPT có thể đang áp dụng khung tư duy này một cách tự phát, giải quyết những vấn đề chưa từng xuất hiện trong dữ liệu huấn luyện chỉ nhờ vào cách đặt câu hỏi phù hợp. Đây cũng là ví dụ điển hình về “hộp đen” trong AI, khi quá trình lập luận để đi đến kết quả không thể nhìn thấy hoặc truy vết, nhưng đồng thời mở ra cơ hội để phát triển hệ thống AI phục vụ con người hiệu quả hơn.