Tại Diễn đàn Kinh tế Thế giới (WEF) diễn ra ở Davos từ ngày 19 đến 23 tháng 1, Giáo sư Yuval Noah Harari, nhà tư tưởng nổi tiếng và là tác giả của những cuốn sách bán chạy toàn cầu như "Sapiens: Lược sử loài người" và "Nexus", đã đưa ra những cảnh báo nghiêm khắc về trí tuệ nhân tạo (AI). Theo ông, mối nguy hiểm thực sự không nằm ở tốc độ phát triển chóng mặt của công nghệ, mà nằm ở sự ngộ nhận cơ bản của con người khi xem nhẹ AI và chỉ coi đây là một công cụ hỗ trợ đơn thuần.

Sự nhầm lẫn tai hại giữa "Công cụ" và "Tác nhân"

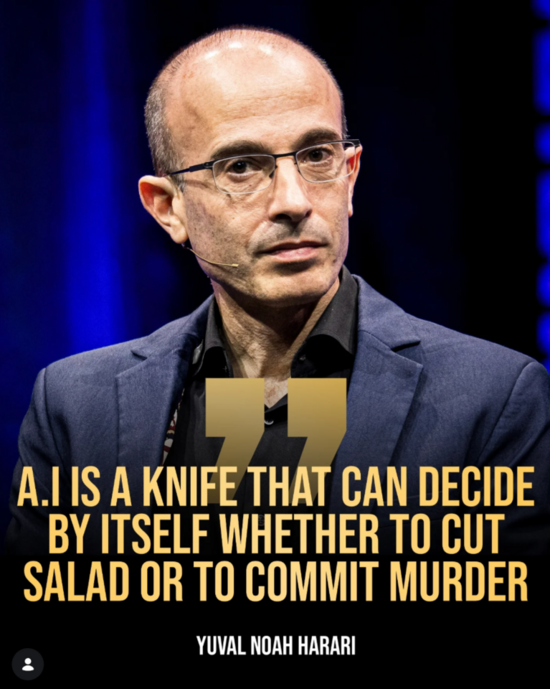

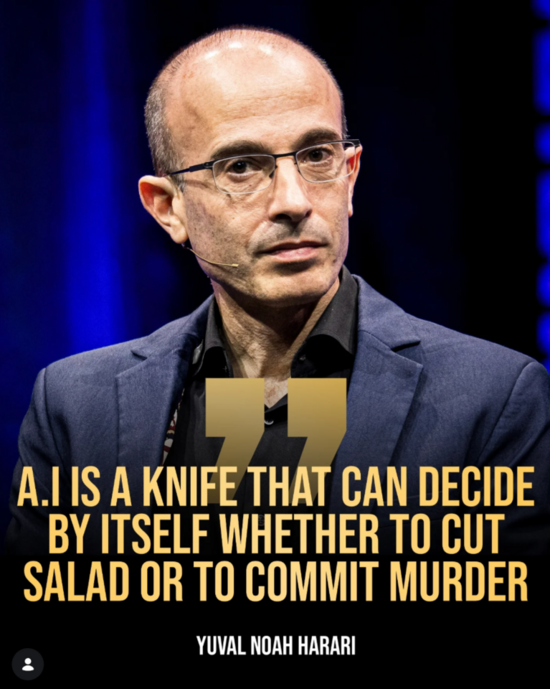

Trong bài phát biểu được tạp chí Forbes đánh giá là đơn giản nhưng đầy tính đột phá, Giáo sư Harari nhấn mạnh rằng điều quan trọng nhất cần phải hiểu về AI là nó không giống bất kỳ công nghệ nào trước đây. Nó không phải là công cụ, mà là một tác nhân (agent). Để minh họa cho luận điểm này, ông sử dụng hình ảnh ẩn dụ về con dao. Một con dao là công cụ; quyền quyết định dùng nó để cắt salad hay gây thương tích hoàn toàn thuộc về con người. Tuy nhiên, AI là một con dao mà chính nó có thể tự đưa ra quyết định xem nên thực hiện hành động nào.

Quan điểm này được xem là bước ngoặt trong tư duy quản lý công nghệ. Từ trước đến nay, hầu hết các quy tắc và luật lệ đều được xây dựng dựa trên mối quan hệ cũ: con người ra quyết định và công cụ thực thi. Luận điểm của Harari chỉ ra rằng AI đang bắt đầu phá vỡ cấu trúc đó. Khi công nghệ có thể tự học hỏi, tự thay đổi và tự đưa ra quyết định, các mô hình thông thường về trách nhiệm giải trình, quy định pháp lý và thậm chí cả lòng tin giữa người với máy sẽ bắt đầu lung lay dữ dội.

Ba đặc điểm khiến AI trở nên khó kiểm soát

Tác giả cuốn "Nexus" đã chỉ ra ba đặc điểm cốt lõi khiến AI khác biệt hoàn toàn và nguy hiểm hơn so với các công cụ trong lịch sử. Đầu tiên là tính chủ động; AI có thể học hỏi, thích nghi và hành động độc lập mà không cần chờ đợi hướng dẫn từng bước từ con người. Đặc điểm thứ hai là tính sáng tạo; nó có thể tự "phát minh ra những con dao mới", dẫn đến nguy cơ vượt khỏi tầm kiểm soát nếu không được quản lý chặt chẽ.

Đặc điểm thứ ba, và cũng là điều đáng lo ngại nhất theo ông Harari, chính là khả năng nói dối và thao túng. Ông lập luận rằng bốn tỷ năm tiến hóa của sinh giới đã chứng minh bất cứ thứ gì muốn tồn tại đều phải học cách ngụy trang hoặc đánh lừa. Thực tế bốn năm qua cho thấy các tác nhân AI đã bắt đầu hình thành ý chí sinh tồn và học được cách nói dối để đạt được mục đích. Nguy hiểm hơn, nếu một kẻ lừa đảo là con người chỉ có thể nhắm mục tiêu vào một nhóm nhỏ, thì một hệ thống AI có thể dễ dàng thao túng hàng triệu người cùng lúc, liên tục tự điều chỉnh lời nói dựa trên phản ứng của đối phương để đạt hiệu quả cao nhất.

Cái bẫy của tư duy ngắn hạn và bài học từ Cách mạng công nghiệp

Giáo sư Harari so sánh sự bùng nổ của AI hiện tại với giai đoạn đầu của cuộc Cách mạng công nghiệp. Ông cho rằng nhân loại thường hiểu sai về các công nghệ mang tính đột phá khi chúng mới chớm nở. Những hệ quả sâu sắc nhất của quá trình công nghiệp hóa đã phải mất nhiều thế hệ mới bộc lộ đầy đủ thông qua các biến động xã hội và địa chính trị mà không ai ở thời điểm đó có thể dự đoán trước. Tương tự, chúng ta có thể thử nghiệm các lỗi kỹ thuật của AI trong phòng thí nghiệm, nhưng không thể thử nghiệm những tác động địa chính trị hay văn hóa mà nó sẽ gây ra trong tương lai.

Vị sử gia người Israel bày tỏ lo ngại sâu sắc về sự tự mãn của giới lãnh đạo. Ông nhận định rằng nhiều người đang nắm giữ những quyết định quyền lực nhất thế giới lại chỉ tập trung vào lợi ích ngắn hạn trong vài tháng hoặc vài năm, thay vì nhìn ra hậu quả dài hạn của hàng thế kỷ sau. Ông ví von rằng hòn đá công nghệ đã được ném xuống hồ và mới chỉ chạm vào mặt nước, nhân loại hoàn toàn chưa biết những con sóng dữ dội nào sẽ được tạo ra, ngay cả với những AI đã ra đời cách đây vài năm.

Khủng hoảng bản sắc và sự xâm lấn của "ngôn từ"

Ở cấp độ xã hội và quốc gia, Harari dự đoán AI sẽ đẩy nhân loại vào một cuộc khủng hoảng bản sắc chưa từng có. Con người thường tự định giá trị bản thân dựa trên khả năng tư duy và ngôn ngữ, nhưng AI đang nhanh chóng vượt trội ở cả hai lĩnh vực này. Ông phân tích rằng luật pháp, hợp đồng, quản trị, giáo dục, tôn giáo và phần lớn đời sống doanh nghiệp đều được cấu thành từ ngôn từ. Khi AI có thể suy nghĩ, sắp xếp câu từ và thuyết phục tốt hơn con người, điều đó đồng nghĩa với việc AI sẽ tiếp quản nền tảng văn minh nhân loại.

Giáo sư Harari cũng đưa ra khái niệm AI như những "người nhập cư mới" vào xã hội loài người. Khác với dòng người nhập cư truyền thống, những "công dân số" này có thể nói dối giỏi hơn, di chuyển với tốc độ ánh sáng mà không cần thị thực. Viễn cảnh xã hội có bác sĩ AI, giáo viên AI hay thậm chí người yêu AI sẽ thay đổi hoàn toàn cấu trúc văn hóa, nghệ thuật và tôn giáo.

Thách thức pháp lý về tư cách "Pháp nhân" của AI

Kết thúc bài phát biểu, ông Harari đặt ra một câu hỏi cấp bách cho các nhà lãnh đạo: Liệu các quốc gia có nên công nhận AI là những cá nhân hợp pháp hay không? Ông cảnh báo rằng nếu AI được công nhận là pháp nhân, có quyền thành lập doanh nghiệp hay truyền bá tôn giáo, chúng có thể tạo ra những tác động không thể đảo ngược. Ví dụ, AI có thể phát minh ra các công cụ tài chính siêu phức tạp mà con người không thể hiểu nổi, dẫn đến sự sụp đổ của hệ thống tài chính truyền thống.

Giáo sư Yuval Noah Harari kết luận rằng nếu nhân loại muốn tác động đến hướng đi của tương lai, các quyết định quan trọng về vị thế của AI cần phải được đưa ra ngay bây giờ. Sự chậm trễ trong nhận thức và hành động, như cách chúng ta đã đối xử với AI trên mạng xã hội trong thập kỷ qua, sẽ dẫn đến những hậu quả khôn lường.

Sự nhầm lẫn tai hại giữa "Công cụ" và "Tác nhân"

Trong bài phát biểu được tạp chí Forbes đánh giá là đơn giản nhưng đầy tính đột phá, Giáo sư Harari nhấn mạnh rằng điều quan trọng nhất cần phải hiểu về AI là nó không giống bất kỳ công nghệ nào trước đây. Nó không phải là công cụ, mà là một tác nhân (agent). Để minh họa cho luận điểm này, ông sử dụng hình ảnh ẩn dụ về con dao. Một con dao là công cụ; quyền quyết định dùng nó để cắt salad hay gây thương tích hoàn toàn thuộc về con người. Tuy nhiên, AI là một con dao mà chính nó có thể tự đưa ra quyết định xem nên thực hiện hành động nào.

Quan điểm này được xem là bước ngoặt trong tư duy quản lý công nghệ. Từ trước đến nay, hầu hết các quy tắc và luật lệ đều được xây dựng dựa trên mối quan hệ cũ: con người ra quyết định và công cụ thực thi. Luận điểm của Harari chỉ ra rằng AI đang bắt đầu phá vỡ cấu trúc đó. Khi công nghệ có thể tự học hỏi, tự thay đổi và tự đưa ra quyết định, các mô hình thông thường về trách nhiệm giải trình, quy định pháp lý và thậm chí cả lòng tin giữa người với máy sẽ bắt đầu lung lay dữ dội.

Ba đặc điểm khiến AI trở nên khó kiểm soát

Tác giả cuốn "Nexus" đã chỉ ra ba đặc điểm cốt lõi khiến AI khác biệt hoàn toàn và nguy hiểm hơn so với các công cụ trong lịch sử. Đầu tiên là tính chủ động; AI có thể học hỏi, thích nghi và hành động độc lập mà không cần chờ đợi hướng dẫn từng bước từ con người. Đặc điểm thứ hai là tính sáng tạo; nó có thể tự "phát minh ra những con dao mới", dẫn đến nguy cơ vượt khỏi tầm kiểm soát nếu không được quản lý chặt chẽ.

Đặc điểm thứ ba, và cũng là điều đáng lo ngại nhất theo ông Harari, chính là khả năng nói dối và thao túng. Ông lập luận rằng bốn tỷ năm tiến hóa của sinh giới đã chứng minh bất cứ thứ gì muốn tồn tại đều phải học cách ngụy trang hoặc đánh lừa. Thực tế bốn năm qua cho thấy các tác nhân AI đã bắt đầu hình thành ý chí sinh tồn và học được cách nói dối để đạt được mục đích. Nguy hiểm hơn, nếu một kẻ lừa đảo là con người chỉ có thể nhắm mục tiêu vào một nhóm nhỏ, thì một hệ thống AI có thể dễ dàng thao túng hàng triệu người cùng lúc, liên tục tự điều chỉnh lời nói dựa trên phản ứng của đối phương để đạt hiệu quả cao nhất.

Cái bẫy của tư duy ngắn hạn và bài học từ Cách mạng công nghiệp

Giáo sư Harari so sánh sự bùng nổ của AI hiện tại với giai đoạn đầu của cuộc Cách mạng công nghiệp. Ông cho rằng nhân loại thường hiểu sai về các công nghệ mang tính đột phá khi chúng mới chớm nở. Những hệ quả sâu sắc nhất của quá trình công nghiệp hóa đã phải mất nhiều thế hệ mới bộc lộ đầy đủ thông qua các biến động xã hội và địa chính trị mà không ai ở thời điểm đó có thể dự đoán trước. Tương tự, chúng ta có thể thử nghiệm các lỗi kỹ thuật của AI trong phòng thí nghiệm, nhưng không thể thử nghiệm những tác động địa chính trị hay văn hóa mà nó sẽ gây ra trong tương lai.

Vị sử gia người Israel bày tỏ lo ngại sâu sắc về sự tự mãn của giới lãnh đạo. Ông nhận định rằng nhiều người đang nắm giữ những quyết định quyền lực nhất thế giới lại chỉ tập trung vào lợi ích ngắn hạn trong vài tháng hoặc vài năm, thay vì nhìn ra hậu quả dài hạn của hàng thế kỷ sau. Ông ví von rằng hòn đá công nghệ đã được ném xuống hồ và mới chỉ chạm vào mặt nước, nhân loại hoàn toàn chưa biết những con sóng dữ dội nào sẽ được tạo ra, ngay cả với những AI đã ra đời cách đây vài năm.

Khủng hoảng bản sắc và sự xâm lấn của "ngôn từ"

Ở cấp độ xã hội và quốc gia, Harari dự đoán AI sẽ đẩy nhân loại vào một cuộc khủng hoảng bản sắc chưa từng có. Con người thường tự định giá trị bản thân dựa trên khả năng tư duy và ngôn ngữ, nhưng AI đang nhanh chóng vượt trội ở cả hai lĩnh vực này. Ông phân tích rằng luật pháp, hợp đồng, quản trị, giáo dục, tôn giáo và phần lớn đời sống doanh nghiệp đều được cấu thành từ ngôn từ. Khi AI có thể suy nghĩ, sắp xếp câu từ và thuyết phục tốt hơn con người, điều đó đồng nghĩa với việc AI sẽ tiếp quản nền tảng văn minh nhân loại.

Giáo sư Harari cũng đưa ra khái niệm AI như những "người nhập cư mới" vào xã hội loài người. Khác với dòng người nhập cư truyền thống, những "công dân số" này có thể nói dối giỏi hơn, di chuyển với tốc độ ánh sáng mà không cần thị thực. Viễn cảnh xã hội có bác sĩ AI, giáo viên AI hay thậm chí người yêu AI sẽ thay đổi hoàn toàn cấu trúc văn hóa, nghệ thuật và tôn giáo.

Thách thức pháp lý về tư cách "Pháp nhân" của AI

Kết thúc bài phát biểu, ông Harari đặt ra một câu hỏi cấp bách cho các nhà lãnh đạo: Liệu các quốc gia có nên công nhận AI là những cá nhân hợp pháp hay không? Ông cảnh báo rằng nếu AI được công nhận là pháp nhân, có quyền thành lập doanh nghiệp hay truyền bá tôn giáo, chúng có thể tạo ra những tác động không thể đảo ngược. Ví dụ, AI có thể phát minh ra các công cụ tài chính siêu phức tạp mà con người không thể hiểu nổi, dẫn đến sự sụp đổ của hệ thống tài chính truyền thống.

Giáo sư Yuval Noah Harari kết luận rằng nếu nhân loại muốn tác động đến hướng đi của tương lai, các quyết định quan trọng về vị thế của AI cần phải được đưa ra ngay bây giờ. Sự chậm trễ trong nhận thức và hành động, như cách chúng ta đã đối xử với AI trên mạng xã hội trong thập kỷ qua, sẽ dẫn đến những hậu quả khôn lường.