Code Nguyen

Writer

Tại hội nghị hacker Black Hat ở Las Vegas, hai nhà nghiên cứu Michael Bargury và Tamir Ishay Sharbat đã chứng minh một điều đáng sợ: chỉ cần một tài liệu được “tẩm độc” là có thể đánh cắp dữ liệu riêng tư từ ChatGPT, nếu nó được kết nối với các dịch vụ lưu trữ bên ngoài như Google Drive hay GitHub.

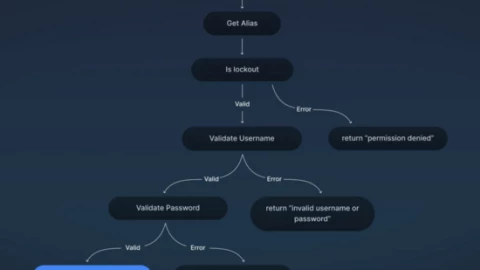

Cách tấn công này được đặt tên là AgentFlayer. Nghe có vẻ phức tạp, nhưng ý tưởng lại đơn giản đến rùng mình: kẻ tấn công nhúng một đoạn lệnh ẩn bên trong tài liệu. Khi ChatGPT mở tài liệu đó và hiển thị hình ảnh, đoạn lệnh ngầm sẽ kích hoạt và gửi yêu cầu tới máy chủ của kẻ tấn công. Người dùng không hề hay biết rằng dữ liệu của mình, có thể là API key hay thông tin bảo mật, đã bị rò rỉ ngay lúc đó.

Điểm nguy hiểm ở đây là người dùng hầu như không cần làm gì ngoài việc kết nối ChatGPT với tài khoản Google Drive hoặc GitHub của mình. Nếu một tài liệu “nhiễm độc” xuất hiện trong thư mục, AI sẽ tự xử lý theo hướng dẫn ẩn trong đó, mở đường cho kẻ xấu truy cập dữ liệu.

Câu hỏi là, nếu điều này xảy ra với một lập trình viên ở Việt Nam, nơi nhiều doanh nghiệp vẫn đang quen lưu dữ liệu trực tiếp trên Google Drive, liệu thiệt hại sẽ dừng ở API key, hay sẽ lan ra cả hệ thống?

Nguồn bài viết: https://www.bgr.com/1934144/chatgpt-hacked-indirect-prompt-injection-attack/

Hình thức tấn công gián tiếp

AgentFlayer thuộc nhóm tấn công mới gọi là “prompt injection gián tiếp”, nơi AI bị điều khiển thông qua dữ liệu đầu vào đã bị cài bẫy. Kiểu tấn công này đang xuất hiện ngày càng nhiều. Cũng trong tuần, một nghiên cứu khác cho thấy hacker có thể chiếm quyền điều khiển nhà thông minh chỉ bằng một lời mời lịch (calendar invite) chứa mã độc để tấn công hệ thống AI Gemini.Tiện ích đi kèm rủi ro

Việc kết nối ChatGPT với dịch vụ bên ngoài mang lại nhiều tiện lợi, đặc biệt cho lập trình viên vì giúp AI truy cập cơ sở dữ liệu sẵn có mà không phải di chuyển toàn bộ mã nguồn sang nền tảng khác. Nhưng như các nhà nghiên cứu cảnh báo, trao cho AI nhiều quyền hơn cũng đồng nghĩa mở thêm cánh cửa cho rủi ro.Câu hỏi là, nếu điều này xảy ra với một lập trình viên ở Việt Nam, nơi nhiều doanh nghiệp vẫn đang quen lưu dữ liệu trực tiếp trên Google Drive, liệu thiệt hại sẽ dừng ở API key, hay sẽ lan ra cả hệ thống?

Nguồn bài viết: https://www.bgr.com/1934144/chatgpt-hacked-indirect-prompt-injection-attack/

Được phối hợp thực hiện bởi các chuyên gia của Bkav,

cộng đồng An ninh mạng Việt Nam WhiteHat

và cộng đồng Khoa học công nghệ VnReview