Trương Công Quang

Writer

Khi AI ngày càng ngốn hàng triệu GPU để vận hành, các trung tâm dữ liệu sẽ phải thay đổi đến mức nào để không bị “nghẽn thở”?

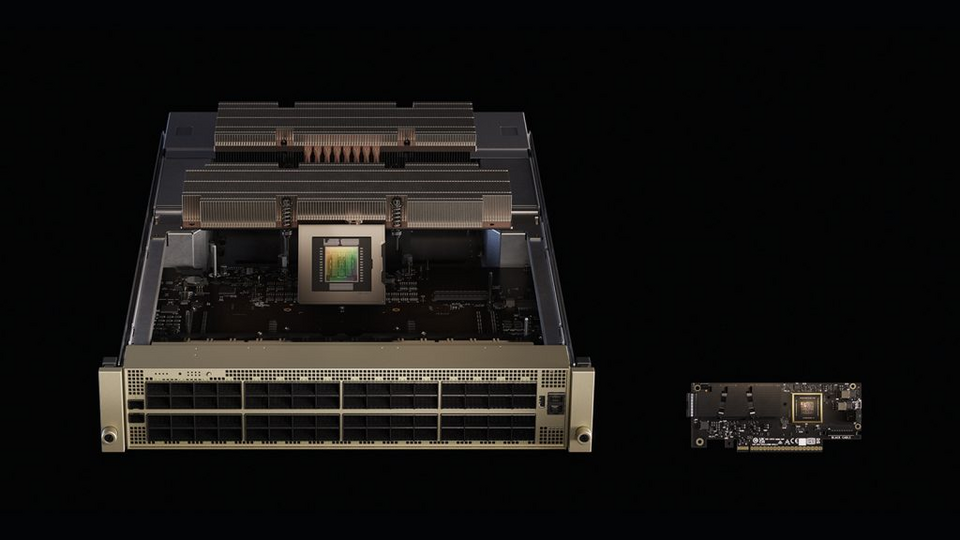

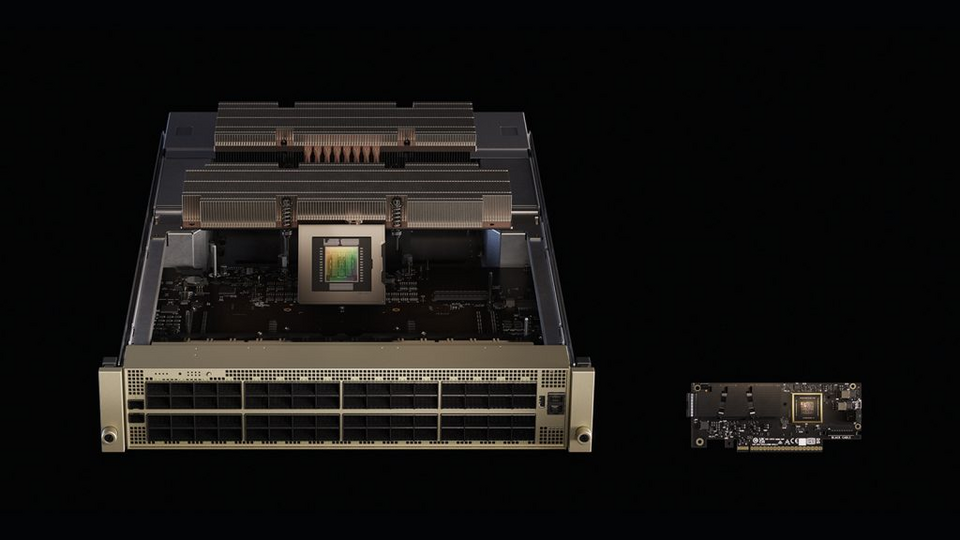

Jensen Huang, CEO NVIDIA, ví các trung tâm dữ liệu AI hiện nay như “nhà máy AI quy mô giga”, còn Spectrum-X chính là “hệ thần kinh” truyền tín hiệu giữa các GPU. Cách ví von không hề cường điệu, vì mục tiêu của Meta và Oracle là xây những hệ thống đủ lớn để huấn luyện các mô hình nghìn tỷ tham số thứ mà chỉ vài năm trước còn được xem là bất khả thi.

Meta thì tích hợp luôn Spectrum-X vào FBOSS hệ điều hành mạng nội bộ của hãng để tạo thế hệ mạng mở linh hoạt hơn, có thể phục vụ cả hàng tỷ người dùng cuối.

Điểm chung của cả hai? Tất cả đều hướng tới mô hình hạ tầng “mở”, cho phép kết nối nhiều hệ thống, nhiều thế hệ phần cứng khác nhau. NVIDIA gọi đây là thiết kế “khối Lego” MGX: CPU, GPU, lưu trữ, mạng muốn ghép kiểu gì cũng được.

AI không chỉ đòi băng thông, mà còn đòi năng lượng khổng lồ. NVIDIA thừa nhận rằng từ một lúc nào đó, bài toán AI không còn là chip mạnh đến đâu, mà là tiêu thụ bao nhiêu điện cho mỗi watt.

Vì thế, họ đang thúc đẩy chuyển hẳn sang hệ thống điện một chiều 800V để giảm thất thoát nhiệt, đồng thời giới thiệu công nghệ điều phối điện năng giúp giảm tải tối đa lên tới 30%. Điều đó có nghĩa là cùng một diện tích trung tâm dữ liệu, có thể nhét thêm hàng nghìn GPU nữa mà không làm quá tải lưới điện.

Meta sẽ dùng FBOSS làm nền tảng chính, nhưng Spectrum-X hỗ trợ cả SONiC, Cumulus, và hệ điều hành của Cisco tức là bất kỳ doanh nghiệp nào cũng có thể tham gia vào “hệ sinh thái thần kinh AI” này, miễn là họ sẵn sàng chuẩn hóa theo chuẩn mới của NVIDIA.

Nếu ngày mai Việt Nam muốn xây dựng một trung tâm AI quốc gia, liệu chúng ta sẽ chọn tự phát triển từ đầu, hay cũng đi theo con đường “chuẩn hóa thần kinh” như Meta và Oracle?

Nguồn: artificialintelligence

Cuộc đua xây “nhà máy AI” toàn cầu: Meta và Oracle chọn NVIDIA làm “hệ thần kinh”

Thay vì tự phát triển mọi thứ từ đầu, Meta và Oracle đã cùng đưa ra một quyết định giống nhau: dùng chung một bộ xương sống cho hạ tầng AI của họ hệ thống mạng Spectrum-X của NVIDIA. Đây không chỉ là thiết bị chuyển mạch Ethernet thông thường, mà là loại được thiết kế riêng để phục vụ các cụm GPU quy mô hàng triệu đơn vị.Jensen Huang, CEO NVIDIA, ví các trung tâm dữ liệu AI hiện nay như “nhà máy AI quy mô giga”, còn Spectrum-X chính là “hệ thần kinh” truyền tín hiệu giữa các GPU. Cách ví von không hề cường điệu, vì mục tiêu của Meta và Oracle là xây những hệ thống đủ lớn để huấn luyện các mô hình nghìn tỷ tham số thứ mà chỉ vài năm trước còn được xem là bất khả thi.

Hai ông lớn triển khai theo hai cách khác nhau

Oracle sẽ kết hợp Spectrum-X với kiến trúc Vera Rubin để xây dựng các cụm AI quy mô lớn hơn nữa, cho phép khách hàng của họ triển khai mô hình mới nhanh hơn mà không tắc nghẽn hạ tầng.Meta thì tích hợp luôn Spectrum-X vào FBOSS hệ điều hành mạng nội bộ của hãng để tạo thế hệ mạng mở linh hoạt hơn, có thể phục vụ cả hàng tỷ người dùng cuối.

Điểm chung của cả hai? Tất cả đều hướng tới mô hình hạ tầng “mở”, cho phép kết nối nhiều hệ thống, nhiều thế hệ phần cứng khác nhau. NVIDIA gọi đây là thiết kế “khối Lego” MGX: CPU, GPU, lưu trữ, mạng muốn ghép kiểu gì cũng được.

AI không chỉ đòi băng thông, mà còn đòi năng lượng khổng lồ. NVIDIA thừa nhận rằng từ một lúc nào đó, bài toán AI không còn là chip mạnh đến đâu, mà là tiêu thụ bao nhiêu điện cho mỗi watt.

Vì thế, họ đang thúc đẩy chuyển hẳn sang hệ thống điện một chiều 800V để giảm thất thoát nhiệt, đồng thời giới thiệu công nghệ điều phối điện năng giúp giảm tải tối đa lên tới 30%. Điều đó có nghĩa là cùng một diện tích trung tâm dữ liệu, có thể nhét thêm hàng nghìn GPU nữa mà không làm quá tải lưới điện.

Mục tiêu cuối cùng: kết nối mọi trung tâm dữ liệu thành một “siêu não toàn cầu”

Spectrum-X không chỉ mở rộng theo chiều dọc (nhiều GPU hơn trong một cụm), mà còn mở rộng theo chiều ngang (kết nối nhiều trung tâm dữ liệu lại với nhau). Với công nghệ XGS, các cơ sở cách nhau hàng trăm kilomet vẫn có thể hoạt động như một siêu máy tính thống nhất.Meta sẽ dùng FBOSS làm nền tảng chính, nhưng Spectrum-X hỗ trợ cả SONiC, Cumulus, và hệ điều hành của Cisco tức là bất kỳ doanh nghiệp nào cũng có thể tham gia vào “hệ sinh thái thần kinh AI” này, miễn là họ sẵn sàng chuẩn hóa theo chuẩn mới của NVIDIA.

Nếu ngày mai Việt Nam muốn xây dựng một trung tâm AI quốc gia, liệu chúng ta sẽ chọn tự phát triển từ đầu, hay cũng đi theo con đường “chuẩn hóa thần kinh” như Meta và Oracle?

Nguồn: artificialintelligence