Hoàng Đức

Writer

Các công ty công nghệ và sản phẩm lớn đôi khi thất bại do quản lý. Vậy công nghệ và quản lý có thể kết hợp được không? Các câu hỏi kiểm tra tương tự được đặt với OpenAI.

Vào ngày 15 tháng 5, chỉ một ngày sau khi phát hành GPT-4o, OpenAI một lần nữa trở thành tâm điểm chú ý. Tuy nhiên, không giống như những đột phá công nghệ trước đây, chủ đề của OpenAI lần này là sự ra đi của nhà khoa học trưởng Ilya Sutskever và nhóm Super Alignment.

Trước đây, nhóm Super Alignment sở hữu 20% tài nguyên sức mạnh tính toán của OpenAI. Vì vậy, không thể tránh khỏi việc khiến mọi người thắc mắc liệu đợt thay đổi nhân sự ngắn hạn và quy mô lớn này của OpenAI có phải là tiền đồn cho sự thay đổi chiến lược phát triển của hãng này hay không?

Trước khi Ilya từ chức, một trong những khác biệt lớn nhất trong OpenAI là thái độ đối với các vấn đề bảo mật AI.

Với sự tương tác giữa những gã khổng lồ công nghệ và các công ty khởi nghiệp, hoạt động nghiên cứu và phát triển công nghệ AI đang tiến lên nhanh chóng và kỷ nguyên AGI đang ngày càng đến gần chúng ta hơn. Một số người tin rằng “OpenAI đang đào tạo một hệ thống AI mạnh mẽ hơn, với mục tiêu cuối cùng là vượt qua trí thông minh của con người”.

Dưới sức mạnh mới chưa biết ẩn chứa những rủi ro chưa biết. Theo lời của một cựu nhân viên, đây có thể là điều tốt nhất từng xảy ra với nhân loại, nhưng cũng có thể là điều tồi tệ nhất nếu chúng ta không hành động cẩn thận.

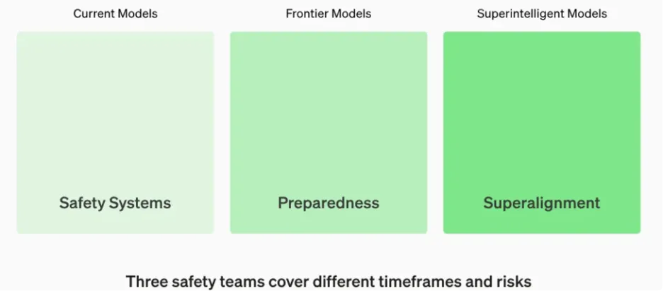

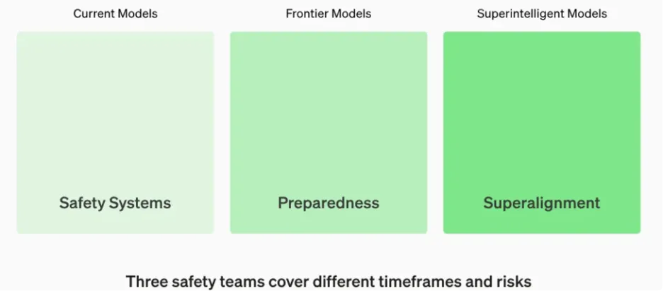

Quy định AI hiện tại chủ yếu tập trung vào sự kết hợp giữa "đánh giá rủi ro và thực hiện các biện pháp giảm thiểu". Sự kết hợp này có thể dễ dàng bị các công ty lớn khai thác và cuối cùng bỏ qua việc giám sát các phòng thí nghiệm AI tiền loại cần được quản lý nhiều nhất. Trước khi nhóm siêu liên kết bị giải tán, OpenAI có ba nhóm để giải quyết các rủi ro về AI ở các khoảng thời gian khác nhau.

Liên kết” hay “siêu liên kết” là thuật ngữ được sử dụng trong lĩnh vực trí tuệ nhân tạo để chỉ nỗ lực đào tạo một hệ thống AI hoạt động trong giới hạn nhu cầu và ưu tiên của con người. Vào ngày 5 tháng 6 năm 2023, nhóm Super Alignment AI lần đầu tiên công bố thành lập. Nhiệm vụ của nhóm là "giải quyết các loại vấn đề bảo mật khác nhau sẽ thực sự phát sinh nếu công ty xây dựng thành công AGI" - tức là các vấn đề bảo mật có thể phát sinh trong tương lai khi mức độ trí tuệ AI tiếp tục tăng lên.

Liên kết” hay “siêu liên kết” là thuật ngữ được sử dụng trong lĩnh vực trí tuệ nhân tạo để chỉ nỗ lực đào tạo một hệ thống AI hoạt động trong giới hạn nhu cầu và ưu tiên của con người. Vào ngày 5 tháng 6 năm 2023, nhóm Super Alignment AI lần đầu tiên công bố thành lập. Nhiệm vụ của nhóm là "giải quyết các loại vấn đề bảo mật khác nhau sẽ thực sự phát sinh nếu công ty xây dựng thành công AGI" - tức là các vấn đề bảo mật có thể phát sinh trong tương lai khi mức độ trí tuệ AI tiếp tục tăng lên.

Ilya, người theo học Geoffray Hinton, cha đỡ đầu của trí tuệ nhân tạo, là một người yêu thích sự an toàn và luôn đặt sự an toàn lên hàng đầu. Năm 2016, Ilya gia nhập OpenAI với tư cách là người đồng sáng lập và giám đốc nghiên cứu, đồng thời giữ chức nhà khoa học trưởng vào năm 2018. Trong quá trình nghiên cứu và phát triển, Ilya luôn chú ý đến vấn đề bảo mật của các mô hình AI lớn.

Mặt khác, Sam Altman là một doanh nhân cam kết phát triển “sản phẩm sáng hơn” để cạnh tranh với nỗ lực của các đối thủ như Google. Theo quan điểm của ông, các vấn đề quản trị bảo mật của AGI ít được ưu tiên hơn nhiều so với việc tung ra “các sản phẩm tỏa sáng”. Mặc dù Altman nhiều lần bày tỏ sự nhấn mạnh đến vấn đề bảo mật trong các cuộc phỏng vấn nhưng xét về mặt hoạt động thực tế, cán cân tài nguyên máy tính vẫn tiếp tục nghiêng về nghiên cứu và phát triển. Đối với Altman, so với việc quản trị an ninh trong tương lai, việc tăng cường nỗ lực để dẫn đầu trong cuộc cạnh tranh AI hiện nay rõ ràng là quan trọng hơn.

Về vấn đề này, William Saunders, cựu nhân viên của OpenAI và là một trong những thành viên của Super Alignment, đã tuyên bố trên một diễn đàn rằng ông đã mất niềm tin vào việc liệu OpenAI có thể hành động có trách nhiệm trong kỷ nguyên AGI hay không.

Vào năm 2021, Dario và Daniela Amodei, trưởng nhóm GPT-3, đã từ chức do có sự khác biệt trong việc "ưu tiên nghiên cứu bảo mật" và quay lại thành lập Anthropic.

Cùng năm đó, Tiến sĩ Paul Christiano, nhà phát minh và giám đốc nghiên cứu an toàn của RLHF, đã từ chức khỏi nhóm an toàn và thành lập một trung tâm nghiên cứu hiệu chuẩn phi lợi nhuận.

Vào tháng 11 năm 2023, một cuộc chiến thâm cung đã nổ ra tại OpenAI về các vấn đề bảo mật và Sam Altman quay trở lại OpenAI 100 giờ sau khi bị sa thải.

Năm 2024, "Game of Thrones" này tiếp tục được dàn dựng.

Vào ngày 15 tháng 2 năm 2024, nhà nghiên cứu bảo mật William Saunders đã tóm tắt công việc của mình tại OpenAI với tư cách là thành viên của nhóm Super Alignment trên diễn đàn EA. Cho biết ông đã từ chức khỏi OpenAI.

Vào ngày 17 tháng 3, Jan Leike từ chức. Jan Leike đã tham gia phát triển một trong những công nghệ cốt lõi của ChatGPT - học tăng cường phản hồi của con người RLHF. Sau khi gia nhập OpenAI, anh là người đóng góp quan trọng từ mô hình mã lớn Codex, InstrucGPT tiền thân của ChatGPT, cho đến ChatGPT và GPT-4.

Vào tháng 4, Daniel Kokotajlo đã từ chức mặc dù từ chối ký thỏa thuận ly thân và tuyên bố công khai trong các cuộc phỏng vấn trên phương tiện truyền thông sau đó rằng "OpenAI đang đào tạo một hệ thống AI mạnh mẽ hơn với mục tiêu cuối cùng là vượt qua trí thông minh của con người". "Đã có sự mất niềm tin vào khả năng lãnh đạo và khả năng xử lý AGI một cách có trách nhiệm của họ".

Vào ngày 11 tháng 4, Leopold Aschenbrenner của đội an ninh và Pavel Izmailov của đội suy luận đã bị sa thải vì nghi ngờ rò rỉ thông tin. Nhà nghiên cứu bảo mật Cullen O'Keefe cũng rời OpenAI.

Vào ngày 15 tháng 5, Ilya, người đồng sáng lập và nhà khoa học trưởng của OpenAI, đã tuyên bố từ chức và tuyên bố trên nền tảng xã hội Chia sẻ thông tin chi tiết”.

Vài giờ sau khi Ilya tuyên bố rời đi, đồng nghiệp của Ilya, Ryan Lowe, đồng giám đốc OpenAI Super Alignment Team, đã tuyên bố từ chức với tốc độ ánh sáng, để lại hai chữ X: "Tôi đã rới OpenAI". Lowe đã gia nhập OpenAI từ năm 2021 và bắt đầu lãnh đạo nhóm Super Alignment vào năm 2023. Những ngày tiếp theo, Jan Leike liên tiếp tiết lộ “nội chuyện” về sự ra đi của đội tôi đang gặp nhiều khó khăn trong vài tháng qua. Chế tạo máy móc thông minh hơn con người vốn là một công việc nguy hiểm… nhưng trong vài năm qua, văn hóa an toàn và quy trình đã nhường chỗ cho sản phẩm sáng bóng”.

Anh tin rằng OpenAI “nên dành nhiều năng lượng hơn để chuẩn bị cho thế hệ mô hình tiếp theo, bao gồm bảo mật, giám sát, sẵn sàng, an toàn, sức mạnh đối kháng, liên kết (siêu), bảo mật, tác động xã hội và các chủ đề liên quan, mà vấn đề rất khó giải quyết và tôi e rằng chúng ta chưa đi đúng hướng".

William Saunders, một trong những thành viên Super Alignment và Daniel Kokotajlo, người đã tham gia thử nghiệm đối thủ GPT-4, đều đã rời OpenAI.

Trong số rất nhiều người đã từ chức, Daniel Kokotajlo và Jan Leike thuộc “nhóm đặc biệt” dám trực tiếp chỉ trích các vấn đề của OpenAI trong lĩnh vực bảo mật và định hướng phát triển. Lý do có thể là “thỏa thuận niêm phong” của OpenAI. Theo cựu nhân viên OpenAI, Kelsey Piper, nhân viên OpenAI được yêu cầu ký thỏa thuận thôi việc với thỏa thuận không chê bai. Nếu họ từ chối ký, quyền lợi cổ phần mà họ nhận được sẽ bị hủy bỏ. Daniel Kokotajlo từ chối ký thỏa thuận.

Sau sự ra đi của Sutskever và Leike, OpenAI xác nhận với CNN rằng họ đã bắt đầu giải tán nhóm Super Alignment của mình trong những tuần gần đây và thay vào đó tích hợp các thành viên nhóm từ nhiều nhóm nghiên cứu khác nhau. Người phát ngôn của OpenAI cho biết cấu trúc này sẽ giúp OpenAI đạt được các mục tiêu siêu liên kết tốt hơn. Trên thực tế, người lãnh đạo mới của ngành kinh doanh này, John Schulma, trước đây chịu trách nhiệm về các vấn đề bảo mật của các sản phẩm hiện có của OpenAI. Việc sáp nhập theo chiều ngang của các đội siêu liên kết theo chiều dọc cũng đồng nghĩa với việc người gác cổng an ninh sẽ biến mất ở một mức độ nhất định trong tương lai.

Một người mới thay thế một người cũ trên thế giới Sam Altman bày tỏ sự tiếc nuối về sự ra đi của Ilya trên nền tảng xã hội Pachoki. Ngoài ra, OpenAI gần đây đã thuê Shivakumar Venkataraman, một người kỳ cựu đã làm việc nhiều năm trong lĩnh vực quảng cáo tìm kiếm của Google.

Kể từ đó, chiến lược phát triển của OpenAI đã đạt được sự nhất quán hời hợt theo từng giai đoạn - với cái giá phải trả là "các bên thống nhất và những khác biệt đối lập". #đạođứcAI

Vào ngày 15 tháng 5, chỉ một ngày sau khi phát hành GPT-4o, OpenAI một lần nữa trở thành tâm điểm chú ý. Tuy nhiên, không giống như những đột phá công nghệ trước đây, chủ đề của OpenAI lần này là sự ra đi của nhà khoa học trưởng Ilya Sutskever và nhóm Super Alignment.

Trước đây, nhóm Super Alignment sở hữu 20% tài nguyên sức mạnh tính toán của OpenAI. Vì vậy, không thể tránh khỏi việc khiến mọi người thắc mắc liệu đợt thay đổi nhân sự ngắn hạn và quy mô lớn này của OpenAI có phải là tiền đồn cho sự thay đổi chiến lược phát triển của hãng này hay không?

Bất đồng lâu dài

Những bất đồng trong nội bộ OpenAI đã tồn tại từ lâu và được công khai trong sự kiện lật đổ CEO Sam Altman vào tháng 11 năm ngoái. Sự ra đi của Ilya Sutskever và những người khác lần này có thể coi là sự tiếp nối của những mâu thuẫn lịch sử.Trước khi Ilya từ chức, một trong những khác biệt lớn nhất trong OpenAI là thái độ đối với các vấn đề bảo mật AI.

Với sự tương tác giữa những gã khổng lồ công nghệ và các công ty khởi nghiệp, hoạt động nghiên cứu và phát triển công nghệ AI đang tiến lên nhanh chóng và kỷ nguyên AGI đang ngày càng đến gần chúng ta hơn. Một số người tin rằng “OpenAI đang đào tạo một hệ thống AI mạnh mẽ hơn, với mục tiêu cuối cùng là vượt qua trí thông minh của con người”.

Dưới sức mạnh mới chưa biết ẩn chứa những rủi ro chưa biết. Theo lời của một cựu nhân viên, đây có thể là điều tốt nhất từng xảy ra với nhân loại, nhưng cũng có thể là điều tồi tệ nhất nếu chúng ta không hành động cẩn thận.

Quy định AI hiện tại chủ yếu tập trung vào sự kết hợp giữa "đánh giá rủi ro và thực hiện các biện pháp giảm thiểu". Sự kết hợp này có thể dễ dàng bị các công ty lớn khai thác và cuối cùng bỏ qua việc giám sát các phòng thí nghiệm AI tiền loại cần được quản lý nhiều nhất. Trước khi nhóm siêu liên kết bị giải tán, OpenAI có ba nhóm để giải quyết các rủi ro về AI ở các khoảng thời gian khác nhau.

Ilya, người theo học Geoffray Hinton, cha đỡ đầu của trí tuệ nhân tạo, là một người yêu thích sự an toàn và luôn đặt sự an toàn lên hàng đầu. Năm 2016, Ilya gia nhập OpenAI với tư cách là người đồng sáng lập và giám đốc nghiên cứu, đồng thời giữ chức nhà khoa học trưởng vào năm 2018. Trong quá trình nghiên cứu và phát triển, Ilya luôn chú ý đến vấn đề bảo mật của các mô hình AI lớn.

Mặt khác, Sam Altman là một doanh nhân cam kết phát triển “sản phẩm sáng hơn” để cạnh tranh với nỗ lực của các đối thủ như Google. Theo quan điểm của ông, các vấn đề quản trị bảo mật của AGI ít được ưu tiên hơn nhiều so với việc tung ra “các sản phẩm tỏa sáng”. Mặc dù Altman nhiều lần bày tỏ sự nhấn mạnh đến vấn đề bảo mật trong các cuộc phỏng vấn nhưng xét về mặt hoạt động thực tế, cán cân tài nguyên máy tính vẫn tiếp tục nghiêng về nghiên cứu và phát triển. Đối với Altman, so với việc quản trị an ninh trong tương lai, việc tăng cường nỗ lực để dẫn đầu trong cuộc cạnh tranh AI hiện nay rõ ràng là quan trọng hơn.

Về vấn đề này, William Saunders, cựu nhân viên của OpenAI và là một trong những thành viên của Super Alignment, đã tuyên bố trên một diễn đàn rằng ông đã mất niềm tin vào việc liệu OpenAI có thể hành động có trách nhiệm trong kỷ nguyên AGI hay không.

William Saunders không đơn độc. Sự thất vọng với việc triển khai bảo mật AGI trong tương lai của OpenAI đã trở thành yếu tố chính dẫn đến sự ra đi của nhiều người trong nhóm của Super. Nhiều người cho rằng có thể Ilya đã nhìn thấy những rủi ro về an ninh của AGI khi rời đi.

OpenAI còn bao nhiêu phần nữa của 'Game of Thrones'?

Dưới bức màn tiến bộ do công nghệ thúc đẩy, các nhóm bảo mật trong tương lai buộc phải “tái cấu trúc”. Trên thực tế, nhân viên an ninh của OpenAI đã liên tục “nhảy việc”.Vào năm 2021, Dario và Daniela Amodei, trưởng nhóm GPT-3, đã từ chức do có sự khác biệt trong việc "ưu tiên nghiên cứu bảo mật" và quay lại thành lập Anthropic.

Cùng năm đó, Tiến sĩ Paul Christiano, nhà phát minh và giám đốc nghiên cứu an toàn của RLHF, đã từ chức khỏi nhóm an toàn và thành lập một trung tâm nghiên cứu hiệu chuẩn phi lợi nhuận.

Vào tháng 11 năm 2023, một cuộc chiến thâm cung đã nổ ra tại OpenAI về các vấn đề bảo mật và Sam Altman quay trở lại OpenAI 100 giờ sau khi bị sa thải.

Năm 2024, "Game of Thrones" này tiếp tục được dàn dựng.

Vào ngày 15 tháng 2 năm 2024, nhà nghiên cứu bảo mật William Saunders đã tóm tắt công việc của mình tại OpenAI với tư cách là thành viên của nhóm Super Alignment trên diễn đàn EA. Cho biết ông đã từ chức khỏi OpenAI.

Vào ngày 17 tháng 3, Jan Leike từ chức. Jan Leike đã tham gia phát triển một trong những công nghệ cốt lõi của ChatGPT - học tăng cường phản hồi của con người RLHF. Sau khi gia nhập OpenAI, anh là người đóng góp quan trọng từ mô hình mã lớn Codex, InstrucGPT tiền thân của ChatGPT, cho đến ChatGPT và GPT-4.

Vào tháng 4, Daniel Kokotajlo đã từ chức mặc dù từ chối ký thỏa thuận ly thân và tuyên bố công khai trong các cuộc phỏng vấn trên phương tiện truyền thông sau đó rằng "OpenAI đang đào tạo một hệ thống AI mạnh mẽ hơn với mục tiêu cuối cùng là vượt qua trí thông minh của con người". "Đã có sự mất niềm tin vào khả năng lãnh đạo và khả năng xử lý AGI một cách có trách nhiệm của họ".

Vào ngày 11 tháng 4, Leopold Aschenbrenner của đội an ninh và Pavel Izmailov của đội suy luận đã bị sa thải vì nghi ngờ rò rỉ thông tin. Nhà nghiên cứu bảo mật Cullen O'Keefe cũng rời OpenAI.

Vào ngày 15 tháng 5, Ilya, người đồng sáng lập và nhà khoa học trưởng của OpenAI, đã tuyên bố từ chức và tuyên bố trên nền tảng xã hội Chia sẻ thông tin chi tiết”.

Vài giờ sau khi Ilya tuyên bố rời đi, đồng nghiệp của Ilya, Ryan Lowe, đồng giám đốc OpenAI Super Alignment Team, đã tuyên bố từ chức với tốc độ ánh sáng, để lại hai chữ X: "Tôi đã rới OpenAI". Lowe đã gia nhập OpenAI từ năm 2021 và bắt đầu lãnh đạo nhóm Super Alignment vào năm 2023. Những ngày tiếp theo, Jan Leike liên tiếp tiết lộ “nội chuyện” về sự ra đi của đội tôi đang gặp nhiều khó khăn trong vài tháng qua. Chế tạo máy móc thông minh hơn con người vốn là một công việc nguy hiểm… nhưng trong vài năm qua, văn hóa an toàn và quy trình đã nhường chỗ cho sản phẩm sáng bóng”.

Anh tin rằng OpenAI “nên dành nhiều năng lượng hơn để chuẩn bị cho thế hệ mô hình tiếp theo, bao gồm bảo mật, giám sát, sẵn sàng, an toàn, sức mạnh đối kháng, liên kết (siêu), bảo mật, tác động xã hội và các chủ đề liên quan, mà vấn đề rất khó giải quyết và tôi e rằng chúng ta chưa đi đúng hướng".

William Saunders, một trong những thành viên Super Alignment và Daniel Kokotajlo, người đã tham gia thử nghiệm đối thủ GPT-4, đều đã rời OpenAI.

Trong số rất nhiều người đã từ chức, Daniel Kokotajlo và Jan Leike thuộc “nhóm đặc biệt” dám trực tiếp chỉ trích các vấn đề của OpenAI trong lĩnh vực bảo mật và định hướng phát triển. Lý do có thể là “thỏa thuận niêm phong” của OpenAI. Theo cựu nhân viên OpenAI, Kelsey Piper, nhân viên OpenAI được yêu cầu ký thỏa thuận thôi việc với thỏa thuận không chê bai. Nếu họ từ chối ký, quyền lợi cổ phần mà họ nhận được sẽ bị hủy bỏ. Daniel Kokotajlo từ chối ký thỏa thuận.

Sau sự ra đi của Sutskever và Leike, OpenAI xác nhận với CNN rằng họ đã bắt đầu giải tán nhóm Super Alignment của mình trong những tuần gần đây và thay vào đó tích hợp các thành viên nhóm từ nhiều nhóm nghiên cứu khác nhau. Người phát ngôn của OpenAI cho biết cấu trúc này sẽ giúp OpenAI đạt được các mục tiêu siêu liên kết tốt hơn. Trên thực tế, người lãnh đạo mới của ngành kinh doanh này, John Schulma, trước đây chịu trách nhiệm về các vấn đề bảo mật của các sản phẩm hiện có của OpenAI. Việc sáp nhập theo chiều ngang của các đội siêu liên kết theo chiều dọc cũng đồng nghĩa với việc người gác cổng an ninh sẽ biến mất ở một mức độ nhất định trong tương lai.

Một người mới thay thế một người cũ trên thế giới Sam Altman bày tỏ sự tiếc nuối về sự ra đi của Ilya trên nền tảng xã hội Pachoki. Ngoài ra, OpenAI gần đây đã thuê Shivakumar Venkataraman, một người kỳ cựu đã làm việc nhiều năm trong lĩnh vực quảng cáo tìm kiếm của Google.

Kể từ đó, chiến lược phát triển của OpenAI đã đạt được sự nhất quán hời hợt theo từng giai đoạn - với cái giá phải trả là "các bên thống nhất và những khác biệt đối lập". #đạođứcAI