Mai Nhung

Writer

Trong một bài viết thẳng thắn và gây chấn động trên trang web cá nhân, ông Dario Amodei, Giám đốc điều hành (CEO) của Anthropic – công ty AI hàng đầu thế giới đứng sau chatbot Claude đối thủ của ChatGPT – đã đưa ra một thừa nhận đáng kinh ngạc: ngay cả những người tạo ra các mô hình Trí tuệ Nhân tạo (AI) tiên tiến nhất hiện nay cũng không thực sự hiểu rõ cơ chế hoạt động bên trong của chúng. Tuyên bố này đến từ lãnh đạo một trong những phòng thí nghiệm AI quan trọng nhất, làm dấy lên những lo ngại sâu sắc về một công nghệ đang ngày càng định hình cuộc sống của chúng ta.

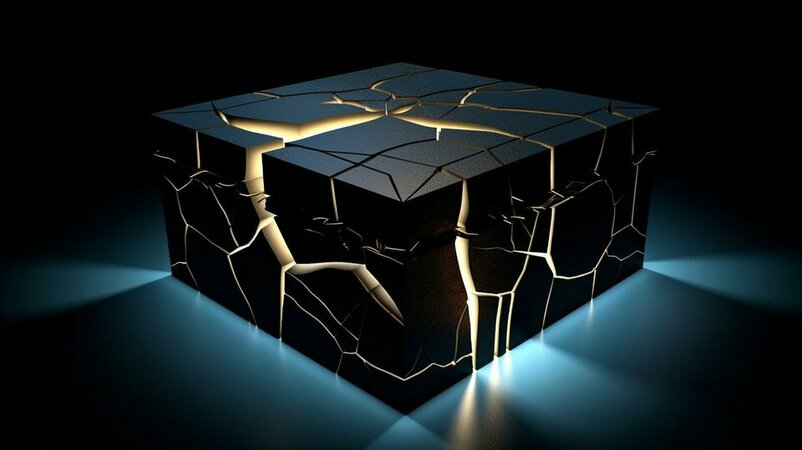

"Hộp đen" AI và quyền được lo lắng

"Khi một hệ thống AI tạo sinh thực hiện một việc gì đó, như tóm tắt một tài liệu tài chính," ông Amodei viết, "chúng ta không hề biết, ở mức độ cụ thể hay chính xác, tại sao nó đưa ra những lựa chọn đó - tại sao nó chọn từ ngữ này thay vì từ ngữ khác, hoặc tại sao đôi khi nó mắc lỗi dù thường xuyên chính xác."

Ông thừa nhận rằng những người ngoài ngành có thể sẽ rất ngạc nhiên khi biết rằng ngay cả những người xây dựng công nghệ cũng "không hiểu cách hoạt động của chính những sáng tạo AI của họ". Và bất kỳ ai cảm thấy lo ngại về sự thiếu hiểu biết nền tảng này, theo ông, đều "có quyền lo lắng", bởi tình trạng này là "về cơ bản chưa từng có trong lịch sử công nghệ."

Nỗ lực "soi não" AI và sứ mệnh an toàn

Chính những lo ngại về bản chất "hộp đen" và các thực hành an toàn tại OpenAI là một phần lý do khiến Dario Amodei và chị gái Daniela rời công ty do Sam Altman điều hành vào cuối năm 2020 để thành lập Anthropic một năm sau đó, với mục tiêu cốt lõi là xây dựng AI an toàn hơn. Giờ đây, Amodei công bố kế hoạch đầy tham vọng của Anthropic: phát triển một dạng "MRI cho AI" (chụp cộng hưởng từ cho AI) trong thập kỷ tới. Mục tiêu không chỉ là tìm hiểu cơ chế hoạt động của AI ở mức độ sâu sắc hơn, mà còn là để ngăn chặn bất kỳ mối nguy hiểm không lường trước nào liên quan đến bản chất bí ẩn hiện tại của nó.

Anthropic không chỉ tập trung vào việc "điều hướng" hành vi AI từ bên ngoài mà còn nghiên cứu "khả năng hấp dẫn" rằng các nhà khoa học cuối cùng có thể hiểu được cách hoạt động bên trong của các hệ thống này "trước khi các mô hình đạt đến mức độ sức mạnh áp đảo". Họ đã tiến hành các thí nghiệm nội bộ, nơi "đội đỏ" cố tình tạo ra lỗi hoặc thiên kiến trong mô hình AI và "đội xanh" sử dụng các công cụ diễn giải để tìm ra và khắc phục.

Lời cảnh tỉnh từ người trong cuộc

Ông Amodei kết luận một cách mạnh mẽ: "AI mạnh mẽ sẽ định hình vận mệnh của nhân loại, và chúng ta xứng đáng hiểu được những sáng tạo của chính mình trước khi chúng biến đổi triệt để nền kinh tế, cuộc sống và tương lai của chúng ta."

Lời cảnh báo này từ một trong những người đi đầu trong lĩnh vực AI đặt ra câu hỏi cấp thiết về trách nhiệm của các công ty công nghệ trong việc phát triển những hệ thống mà ngay cả họ cũng chưa hoàn toàn làm chủ được cơ chế vận hành. Nó cũng nhấn mạnh tầm quan trọng của việc đầu tư nghiên cứu sâu hơn vào tính diễn giải và an toàn của AI trước khi công nghệ này trở nên quá mạnh mẽ để có thể kiểm soát.

"Hộp đen" AI và quyền được lo lắng

"Khi một hệ thống AI tạo sinh thực hiện một việc gì đó, như tóm tắt một tài liệu tài chính," ông Amodei viết, "chúng ta không hề biết, ở mức độ cụ thể hay chính xác, tại sao nó đưa ra những lựa chọn đó - tại sao nó chọn từ ngữ này thay vì từ ngữ khác, hoặc tại sao đôi khi nó mắc lỗi dù thường xuyên chính xác."

Ông thừa nhận rằng những người ngoài ngành có thể sẽ rất ngạc nhiên khi biết rằng ngay cả những người xây dựng công nghệ cũng "không hiểu cách hoạt động của chính những sáng tạo AI của họ". Và bất kỳ ai cảm thấy lo ngại về sự thiếu hiểu biết nền tảng này, theo ông, đều "có quyền lo lắng", bởi tình trạng này là "về cơ bản chưa từng có trong lịch sử công nghệ."

Nỗ lực "soi não" AI và sứ mệnh an toàn

Chính những lo ngại về bản chất "hộp đen" và các thực hành an toàn tại OpenAI là một phần lý do khiến Dario Amodei và chị gái Daniela rời công ty do Sam Altman điều hành vào cuối năm 2020 để thành lập Anthropic một năm sau đó, với mục tiêu cốt lõi là xây dựng AI an toàn hơn. Giờ đây, Amodei công bố kế hoạch đầy tham vọng của Anthropic: phát triển một dạng "MRI cho AI" (chụp cộng hưởng từ cho AI) trong thập kỷ tới. Mục tiêu không chỉ là tìm hiểu cơ chế hoạt động của AI ở mức độ sâu sắc hơn, mà còn là để ngăn chặn bất kỳ mối nguy hiểm không lường trước nào liên quan đến bản chất bí ẩn hiện tại của nó.

Anthropic không chỉ tập trung vào việc "điều hướng" hành vi AI từ bên ngoài mà còn nghiên cứu "khả năng hấp dẫn" rằng các nhà khoa học cuối cùng có thể hiểu được cách hoạt động bên trong của các hệ thống này "trước khi các mô hình đạt đến mức độ sức mạnh áp đảo". Họ đã tiến hành các thí nghiệm nội bộ, nơi "đội đỏ" cố tình tạo ra lỗi hoặc thiên kiến trong mô hình AI và "đội xanh" sử dụng các công cụ diễn giải để tìm ra và khắc phục.

Lời cảnh tỉnh từ người trong cuộc

Ông Amodei kết luận một cách mạnh mẽ: "AI mạnh mẽ sẽ định hình vận mệnh của nhân loại, và chúng ta xứng đáng hiểu được những sáng tạo của chính mình trước khi chúng biến đổi triệt để nền kinh tế, cuộc sống và tương lai của chúng ta."

Lời cảnh báo này từ một trong những người đi đầu trong lĩnh vực AI đặt ra câu hỏi cấp thiết về trách nhiệm của các công ty công nghệ trong việc phát triển những hệ thống mà ngay cả họ cũng chưa hoàn toàn làm chủ được cơ chế vận hành. Nó cũng nhấn mạnh tầm quan trọng của việc đầu tư nghiên cứu sâu hơn vào tính diễn giải và an toàn của AI trước khi công nghệ này trở nên quá mạnh mẽ để có thể kiểm soát.