Một bài báo gần đây đang gây chú ý với cộng đồng AI khi Meta AI tuyên bố đạt được bước đột phá mới trong hành trình giúp các mô hình ngôn ngữ lớn (LLM) thực sự “học liên tục” thay vì bị đóng băng sau khi huấn luyện.

Vấn đề lâu nay của giới AI là mỗi lần tinh chỉnh mô hình để học thêm kiến thức mới, nó lại đánh mất phần lớn kiến thức cũ. Đây là hiện tượng được gọi là “quên thảm khốc”. Các hướng tiếp cận trước đây như học theo ngữ cảnh (In-context learning) hay sử dụng bộ nhớ ngoài (RAG) chỉ giúp AI “giả vờ biết”, chứ không thật sự học. Trong khi đó, con đường “cập nhật tham số”, tức học bằng cách thay đổi chính cấu trúc não của mô hình, dù đầy tiềm năng, lại bị bỏ dở vì rủi ro cao và tính không ổn định.

Meta tuyên bố đã tháo được quả “bom nổ chậm” này bằng phương pháp Sparse Memory Fine-tuning (tinh chỉnh bộ nhớ thưa thớt). Họ đưa vào mô hình một lớp bộ nhớ đặc biệt gồm hàng triệu “khe nhớ” nhỏ có thể cập nhật độc lập, rồi dùng thuật toán TF-IDF để chọn ra đúng những khe liên quan nhất đến kiến thức mới để tinh chỉnh. Cách làm này cho phép mô hình “học thêm” mà không phá hủy những gì đã biết. Trong thử nghiệm, khi học dữ liệu mới, mô hình chỉ giảm 11% hiệu suất trên nhiệm vụ cũ, trong khi các phương pháp tinh chỉnh khác khiến nó mất tới 70–90% khả năng ban đầu.

Nói một cách hình tượng, Meta đã giúp mô hình AI học như con người: biết bổ sung kinh nghiệm mới mà không cần quên đi ký ức cũ. Đây không chỉ là một cải tiến kỹ thuậ, nó mở ra khả năng cho “mô hình tự tiến hóa”, những hệ thống AI có thể phát triển dần theo thời gian thay vì phải huấn luyện lại từ đầu. Nếu công nghệ này được mở rộng, AI tương lai sẽ không còn là những công cụ tĩnh mà sẽ trở thành thực thể có “trí nhớ dài hạn” và khả năng học hỏi suốt đời.

Chi tiết mời bạn đọc bài công bố của Meta dưới đây được mình tóm lược lại

Vấn đề lâu nay của giới AI là mỗi lần tinh chỉnh mô hình để học thêm kiến thức mới, nó lại đánh mất phần lớn kiến thức cũ. Đây là hiện tượng được gọi là “quên thảm khốc”. Các hướng tiếp cận trước đây như học theo ngữ cảnh (In-context learning) hay sử dụng bộ nhớ ngoài (RAG) chỉ giúp AI “giả vờ biết”, chứ không thật sự học. Trong khi đó, con đường “cập nhật tham số”, tức học bằng cách thay đổi chính cấu trúc não của mô hình, dù đầy tiềm năng, lại bị bỏ dở vì rủi ro cao và tính không ổn định.

Meta tuyên bố đã tháo được quả “bom nổ chậm” này bằng phương pháp Sparse Memory Fine-tuning (tinh chỉnh bộ nhớ thưa thớt). Họ đưa vào mô hình một lớp bộ nhớ đặc biệt gồm hàng triệu “khe nhớ” nhỏ có thể cập nhật độc lập, rồi dùng thuật toán TF-IDF để chọn ra đúng những khe liên quan nhất đến kiến thức mới để tinh chỉnh. Cách làm này cho phép mô hình “học thêm” mà không phá hủy những gì đã biết. Trong thử nghiệm, khi học dữ liệu mới, mô hình chỉ giảm 11% hiệu suất trên nhiệm vụ cũ, trong khi các phương pháp tinh chỉnh khác khiến nó mất tới 70–90% khả năng ban đầu.

Nói một cách hình tượng, Meta đã giúp mô hình AI học như con người: biết bổ sung kinh nghiệm mới mà không cần quên đi ký ức cũ. Đây không chỉ là một cải tiến kỹ thuậ, nó mở ra khả năng cho “mô hình tự tiến hóa”, những hệ thống AI có thể phát triển dần theo thời gian thay vì phải huấn luyện lại từ đầu. Nếu công nghệ này được mở rộng, AI tương lai sẽ không còn là những công cụ tĩnh mà sẽ trở thành thực thể có “trí nhớ dài hạn” và khả năng học hỏi suốt đời.

Chi tiết mời bạn đọc bài công bố của Meta dưới đây được mình tóm lược lại

Meta vừa tháo ngòi quả bom lớn nhất trên con đường tiến hóa của AI

Trong nhiều năm, giới nghiên cứu AI vẫn mắc kẹt với một nghịch lý: mô hình ngôn ngữ lớn (LLM) có thể “học” gần như mọi thứ, trừ chính khả năng học liên tục.

Từ khi Richard Sutton công bố bài “The Bitter Lesson” (Thời đại của trải nghiệm), vấn đề này đã trở thành một “cục xương” khó nuốt: làm sao để mô hình có thể vừa học thêm kiến thức mới, vừa không quên mất những gì đã học trước đó?

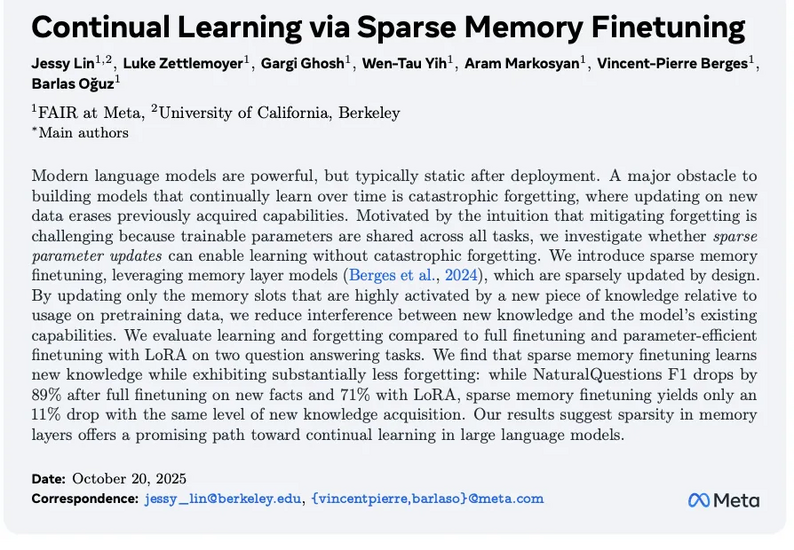

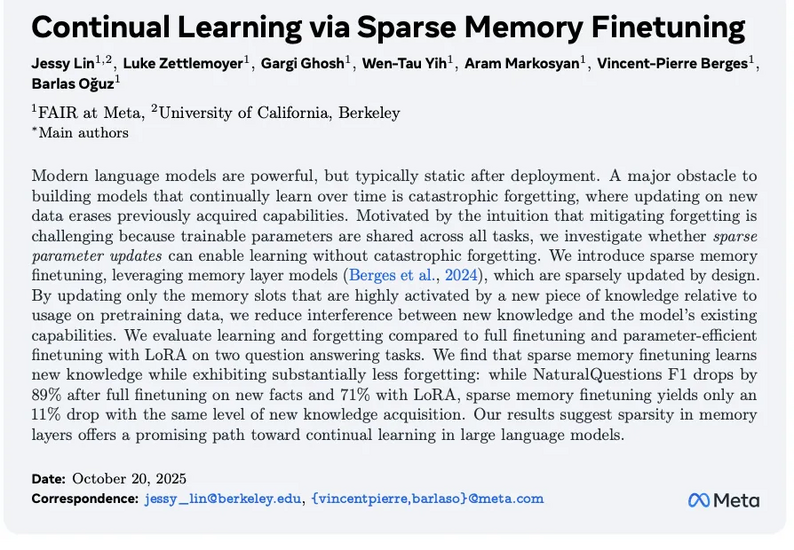

Meta vừa công bố một hướng đi mới có thể tháo được nút thắt ấy. Trong bài nghiên cứu “Continual Learning via Sparse Memory Fine-tuning”, đội ngũ Meta AI đã giới thiệu một cách tinh chỉnh mô hình mà không khiến nó “mất trí nhớ”, điều mà toàn ngành từng cho là gần như bất khả thi.

Cuộc đua ba hướng của “học liên tục”

Trước Meta, cộng đồng AI đã thử ba con đường khác nhau để giúp mô hình có khả năng tự học sau khi triển khai:

Học theo ngữ cảnh (ICL), tức kiểu “dạy bằng lời nhắc”: đưa thêm ví dụ, prompt, hướng dẫn trong từng cuộc trò chuyện để mô hình tự rút kinh nghiệm. Gần đây, Karpathy gọi đây là “system learning”: khi mô hình biết tóm tắt cách mình giải quyết vấn đề, rồi cập nhật vào phần prompt hệ thống để cải thiện dần qua từng lần tương tác.

Ngân hàng trí nhớ ngoài (RAG). hay kiểu “trí nhớ phụ”: mô hình có một kho dữ liệu tra cứu riêng, cập nhật được, giống như một bộ nhớ tạm bên ngoài não. Google DeepMind mới đây còn nâng cấp nó lên thành “Ngân hàng Lý luận”, nơi không chỉ lưu dữ kiện, mà còn lưu phương pháp tư duy và cách tránh sai lầm.

Hai con đường này giúp mô hình “học tạm thời” bằng ngữ cảnh hoặc dữ liệu ngoài. Nhưng thực chất, chúng chỉ là học thuộc bài, không phải học thay đổi bản thân.

Con đường thứ ba, cập nhật trực tiếp tham số mô hình, mới là nơi “học thật sự” diễn ra. Nhưng đây cũng là con đường nguy hiểm nhất. Mỗi lần tinh chỉnh, mô hình lại có nguy cơ quên sạch kiến thức cũ, hiệu ứng mà dân kỹ thuật gọi là “catastrophic forgetting”.

Bước đột phá của Meta: “Tinh chỉnh bộ nhớ thưa thớt”

Meta giải bài toán này bằng một ý tưởng đơn giản nhưng táo bạo: nếu việc tinh chỉnh khiến mô hình quên vì ta đụng vào quá nhiều tham số, thì tại sao không chỉ cập nhật vài phần có liên quan thôi?

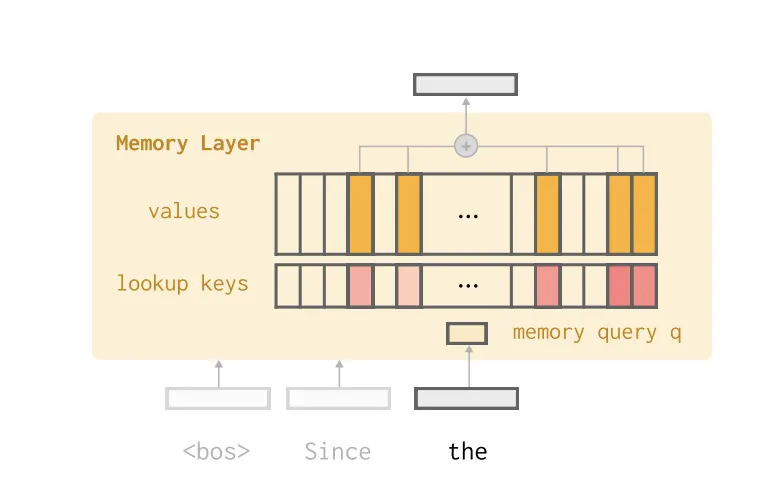

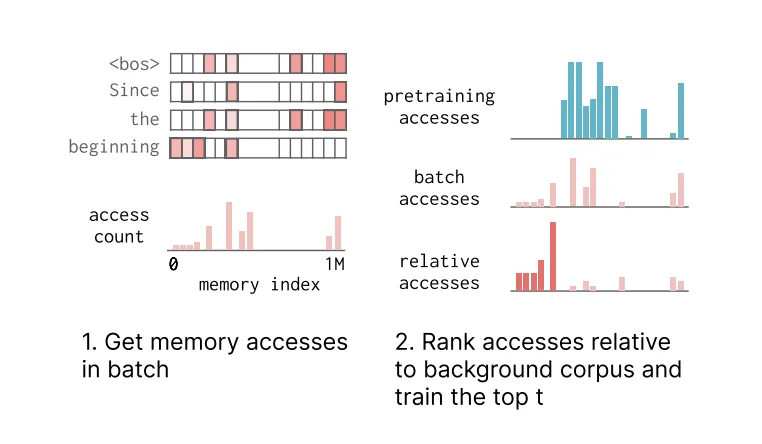

Để làm điều đó, họ đã tạo ra một kiến trúc gọi là “Memory Layer”, lớp bộ nhớ có thể chỉnh sửa độc lập.

Trong đó, mỗi lớp chứa hàng triệu khe nhớ (memory slots), những “chuyên gia vi mô” chịu trách nhiệm cho từng mẩu kiến thức riêng biệt. Khi có dữ liệu mới, mô hình sẽ chỉ kích hoạt một nhóm nhỏ (ví dụ top-32 khe nhớ liên quan nhất), thay vì động đến toàn bộ mạng nơ-ron như trước.

Meta còn mượn lại một kỹ thuật cổ điển trong xử lý ngôn ng, TF-IDF – để xác định khe nhớ nào đáng được cập nhật: khe nào liên quan mạnh tới kiến thức mới (TF cao) nhưng không gắn chặt với kiến thức cũ (IDF cao), thì được chọn để “viết” lại.

Kết quả là mô hình chỉ cần cập nhật khoảng 500 trong số 1.000.000 khe nhớ và điều đó đủ để học kiến thức mới mà hầu như không quên kiến thức cũ.

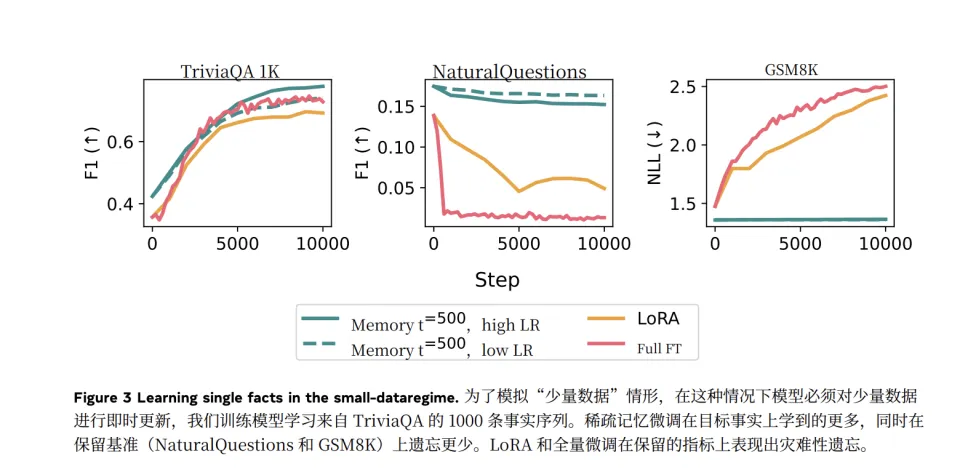

Khi thử nghiệm, Meta cho mô hình học thêm bộ dữ kiện TriviaQA và kiểm tra lại hiệu suất trên nhiệm vụ ban đầu Natural Questions.

Phương pháp mới chỉ làm giảm hiệu suất 11%,

Trong khi LoRA giảm 71%,

Và tinh chỉnh toàn bộ thì giảm đến 89%.

Về cơ bản, họ đã chữa khỏi “gót chân Achilles” của SFT (Supervised Fine-tuning) – vốn là nguyên nhân khiến việc tinh chỉnh mô hình sau huấn luyện luôn đầy rủi ro.

Khi “tinh chỉnh” trở lại đường đua

Từ trước đến nay, học liên tục của LLM chủ yếu dựa trên “bản vá bên ngoài”: thêm ngữ cảnh, thêm công cụ tra cứu, thêm logic tạm thời. Nhưng điều đó giống như cho AI học bằng cách tra cứu Wikipedia, chứ không phải tự ghi nhớ bài học.

Cách tiếp cận của Meta, tinh chỉnh bộ nhớ thưa thớt, cho phép mô hình thực sự thay đổi bản thân một cách an toàn.

Nói cách khác, thay vì học “trên bề mặt”, mô hình có thể học “vào lõi”.

Nếu phương pháp này chứng minh được tính ổn định trong các mô hình lớn, nó có thể mở ra thế hệ AI tự tiến hóa – những hệ thống không chỉ chạy theo dữ liệu huấn luyện, mà còn tiếp tục phát triển sau khi ra đời.

Meta có thể vừa tháo được quả bom lớn nhất trên con đường ấy: làm sao để AI học mà không quên.