Tháp rơi tự do

Intern Writer

Người dùng có thể cảm thấy chatbot AI ngày càng trở nên "ngu ngốc" hơn khi họ trò chuyện lâu với chúng, và giờ đây đã có bằng chứng khoa học để chứng minh cảm nhận này.

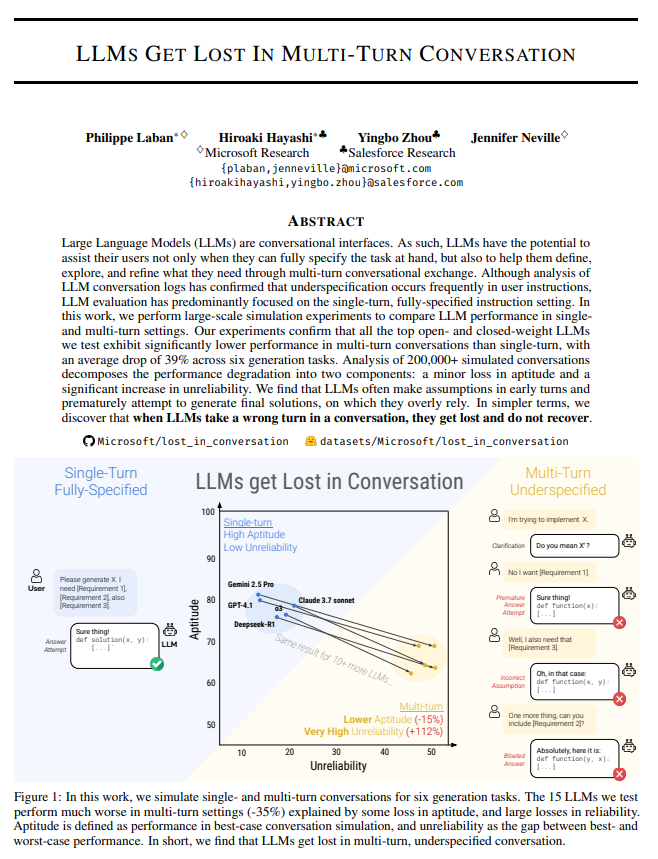

Theo một báo cáo của Windows Central hôm nay, một nghiên cứu được công bố chung bởi Microsoft Research và Salesforce xác nhận rằng ngay cả những mô hình ngôn ngữ quy mô lớn tiên tiến nhất hiện có cũng gặp phải sự suy giảm mạnh về độ tin cậy trong các cuộc hội thoại nhiều lượt.

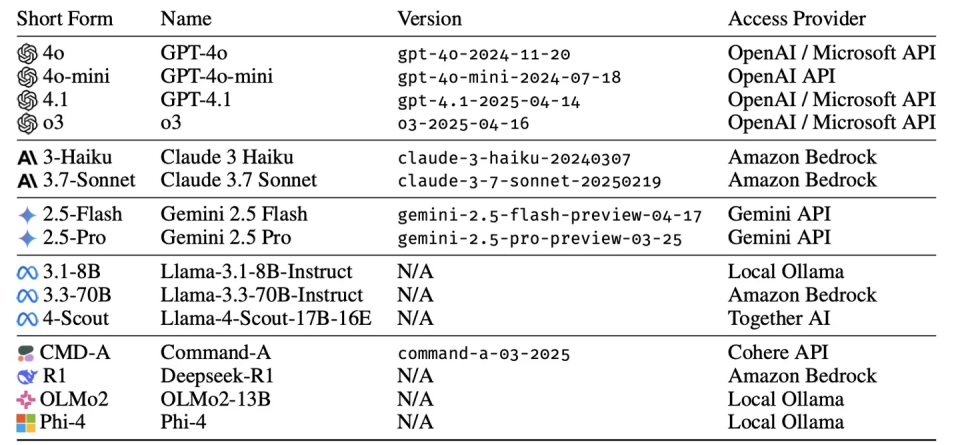

Các nhà nghiên cứu đã nghiên cứu một số GPU, bao gồm GPT-4.1, Gemini 2.5 Pro, Claude 3.7 Sonnet, O3 và DeepSeek R1.Nó đã thực hiện hơn 200.000 phân tích hội thoại mô phỏng với 15 mô hình hàng đầu, bao gồm cả Llama 4, và phát hiện ra một hiện tượng được gọi là " cuộc hội thoại bị mất"."khiếm khuyết hệ thống".

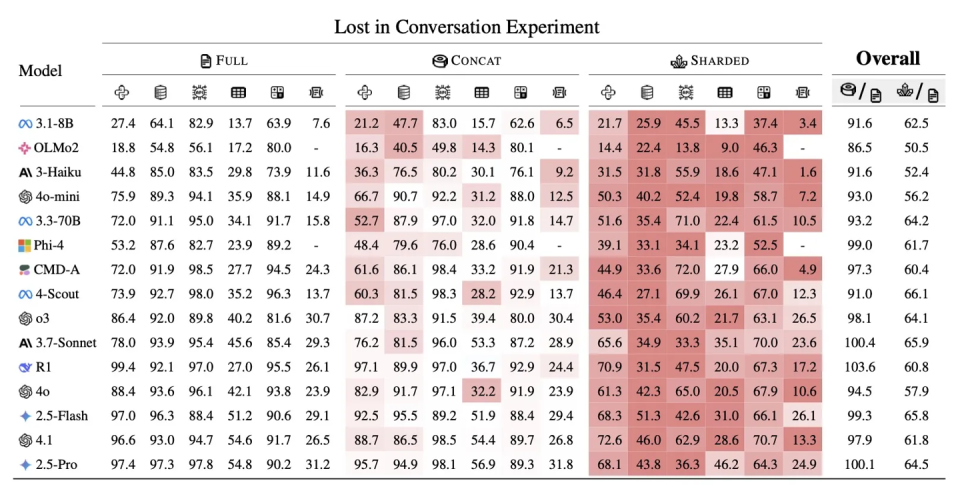

Dữ liệu cho thấy các mô hình này có tỷ lệ thành công lên đến 90% trong các nhiệm vụ lựa chọn đơn, nhưng khi nhiệm vụ tương tự được chia nhỏ thành nhiều vòng hội thoại tự nhiên, tỷ lệ thành công giảm mạnh xuống còn khoảng 65%.

Nghiên cứu chỉ ra rằng "trí thông minh" của mô hình không giảm đáng kể - khả năng cốt lõi chỉ giảm khoảng 15% - nhưng "độ không đáng tin cậy" lại tăng vọt 112%. Nói cách khác, các mô hình AI lớn vẫn có khả năng giải quyết vấn đề, nhưng trở nên rất không ổn định trong các cuộc hội thoại nhiều lượt và gặp khó khăn trong việc liên tục theo dõi ngữ cảnh.

Báo cáo chỉ ra rằng hầu hết các mô hình hiện tại chủ yếu được đánh giá theo tiêu chuẩn "một vòng", tức là môi trường thử nghiệm lý tưởng nơi tất cả các hướng dẫn được nhận cùng một lúc. Tuy nhiên, giao tiếp thực tế giữa người với người thường diễn ra dần dần, thông tin được bổ sung từng bước thông qua nhiều vòng tương tác. Nghiên cứu đã chỉ ra rằng một khi nhiệm vụ được "chia nhỏ" thành nhiều vòng, ngay cả những mô hình tiên tiến nhất cũng dễ mắc phải các lỗi hệ thống.

Các nhà nghiên cứu đã phân tích sâu hơn các cơ chế hành vi gây ra sự suy giảm hiệu suất.

Phát hiện này đặt ra thách thức cho các phương pháp đánh giá hiện tại trong ngành công nghiệp AI. Các nhà nghiên cứu chỉ ra rằng các tiêu chuẩn hiện có chủ yếu dựa trên các kịch bản lý tưởng chỉ diễn ra trong một lượt, bỏ qua hành vi của mô hình trong thế giới thực. Kết luận này đặt ra một thách thức đáng kể cho các nhà phát triển dựa vào AI để xây dựng các quy trình đối thoại phức tạp hoặc các tác nhân thông minh.

Phương pháp hiệu quả nhất hiện nay là giảm thiểu nhiều vòng giao tiếp và cung cấp tất cả dữ liệu, ràng buộc và hướng dẫn cần thiết trong một lời nhắc hoàn chỉnh duy nhất để cải thiện tính nhất quán của đầu ra.

Theo một báo cáo của Windows Central hôm nay, một nghiên cứu được công bố chung bởi Microsoft Research và Salesforce xác nhận rằng ngay cả những mô hình ngôn ngữ quy mô lớn tiên tiến nhất hiện có cũng gặp phải sự suy giảm mạnh về độ tin cậy trong các cuộc hội thoại nhiều lượt.

Các nhà nghiên cứu đã nghiên cứu một số GPU, bao gồm GPT-4.1, Gemini 2.5 Pro, Claude 3.7 Sonnet, O3 và DeepSeek R1.Nó đã thực hiện hơn 200.000 phân tích hội thoại mô phỏng với 15 mô hình hàng đầu, bao gồm cả Llama 4, và phát hiện ra một hiện tượng được gọi là " cuộc hội thoại bị mất"."khiếm khuyết hệ thống".

Dữ liệu cho thấy các mô hình này có tỷ lệ thành công lên đến 90% trong các nhiệm vụ lựa chọn đơn, nhưng khi nhiệm vụ tương tự được chia nhỏ thành nhiều vòng hội thoại tự nhiên, tỷ lệ thành công giảm mạnh xuống còn khoảng 65%.

Nghiên cứu chỉ ra rằng "trí thông minh" của mô hình không giảm đáng kể - khả năng cốt lõi chỉ giảm khoảng 15% - nhưng "độ không đáng tin cậy" lại tăng vọt 112%. Nói cách khác, các mô hình AI lớn vẫn có khả năng giải quyết vấn đề, nhưng trở nên rất không ổn định trong các cuộc hội thoại nhiều lượt và gặp khó khăn trong việc liên tục theo dõi ngữ cảnh.

Báo cáo chỉ ra rằng hầu hết các mô hình hiện tại chủ yếu được đánh giá theo tiêu chuẩn "một vòng", tức là môi trường thử nghiệm lý tưởng nơi tất cả các hướng dẫn được nhận cùng một lúc. Tuy nhiên, giao tiếp thực tế giữa người với người thường diễn ra dần dần, thông tin được bổ sung từng bước thông qua nhiều vòng tương tác. Nghiên cứu đã chỉ ra rằng một khi nhiệm vụ được "chia nhỏ" thành nhiều vòng, ngay cả những mô hình tiên tiến nhất cũng dễ mắc phải các lỗi hệ thống.

Các nhà nghiên cứu đã phân tích sâu hơn các cơ chế hành vi gây ra sự suy giảm hiệu suất.

- Thứ nhất, " thế hệ sinh non "Mô hình thường cố gắng đưa ra câu trả lời cuối cùng trước khi người dùng giải thích đầy đủ nhu cầu của họ. Một khi giả định sai được hình thành trong các vòng đầu (ghi chú của IT Home: điều này có thể đề cập đến ấn tượng ban đầu), mô hình sẽ tiếp tục suy luận dựa trên sai lầm đó thay vì sửa chữa nó khi có thêm thông tin mới, do đó khiến sai lầm dần dần khuếch đại.

- Thứ hai, có hiện tượng " lạm phát câu trả lời".Trong các cuộc hội thoại nhiều lượt, độ dài phản hồi của mô hình tăng từ 20% đến 300% so với các cuộc hội thoại một lượt. Các phản hồi dài hơn thường chứa nhiều giả định và "ảo tưởng", sau đó được tích hợp vào ngữ cảnh đang diễn ra của cuộc hội thoại, ảnh hưởng thêm đến độ chính xác của các suy luận tiếp theo.

Phát hiện này đặt ra thách thức cho các phương pháp đánh giá hiện tại trong ngành công nghiệp AI. Các nhà nghiên cứu chỉ ra rằng các tiêu chuẩn hiện có chủ yếu dựa trên các kịch bản lý tưởng chỉ diễn ra trong một lượt, bỏ qua hành vi của mô hình trong thế giới thực. Kết luận này đặt ra một thách thức đáng kể cho các nhà phát triển dựa vào AI để xây dựng các quy trình đối thoại phức tạp hoặc các tác nhân thông minh.

Phương pháp hiệu quả nhất hiện nay là giảm thiểu nhiều vòng giao tiếp và cung cấp tất cả dữ liệu, ràng buộc và hướng dẫn cần thiết trong một lời nhắc hoàn chỉnh duy nhất để cải thiện tính nhất quán của đầu ra.