Trường Sơn

Writer

Theo hãng truyền thông ngành AI, Transformer, đưa tin hôm nay, cựu thành viên bộ phận Super Alignment của Open AI, Leopold Aschenbrenner, đã tiết lộ lý do thực sự khiến anh bị sa thải - anh đã chia sẻ một bản ghi nhớ bảo mật của OpenAI với một số thành viên hội đồng quản trị. Kết quả là ban quản lý OpenAI không hài lòng.

Vào tháng 4 năm nay, Aschenbrenner đã bị OpenAI sa thải vì làm rò rỉ bí mật công ty. Anh cho biết OpenAI đã nói rõ với anh vào thời điểm đó rằng lý do chính khiến anh bị sa thải là do bản ghi nhớ này. Ashenbrenner sau đó đã ra mắt một trang web, sử dụng tài liệu PDF dài 165 trang để tóm tắt những thông tin anh học được khi làm việc tại OpenAI, đồng thời thành lập một công ty đầu tư tập trung vào trí tuệ nhân tạo tổng hợp (AGI).

Aschenbrenner không phải là người duy nhất cảm thấy “bị phản bội”. Hôm qua, 13 nhân viên cũ và hiện tại của OpenAI và Google DeepMind đã cùng nhau đưa ra một bức thư ngỏ, vạch trần văn hóa bí mật và liều lĩnh của OpenAI, nhấn mạnh những rủi ro nghiêm trọng của công nghệ AI tiên tiến và bày tỏ lo ngại về lợi ích của các công ty AI trong việc phát triển và quảng bá AI ưu tiên công nghệ, đàn áp bất đồng chính kiến và lách luật.

Bức thư ngỏ này cũng nhận được sự ủng hộ chữ ký từ hai người đoạt giải Turing 2018 là Yoshua Bengio và Geoffrey Hinton. Stuart Russell, giáo sư khoa học máy tính tại Đại học California, Berkeley, đồng thời là giám đốc Trung tâm Trí tuệ nhân tạo tương thích với con người, cũng đã ký vào bức thư ngỏ.

OpenAI ban đầu là một phòng thí nghiệm nghiên cứu phi lợi nhuận. Trên trang web chính thức, OpenAI xác định sứ mệnh của công ty là “đảm bảo rằng trí tuệ nhân tạo nói chung (AGI) mang lại lợi ích cho nhân loại”. Nhưng các cựu nhân viên OpenAI đã ký thư ngỏ nói rằng trọng tâm hiện tại của OpenAI là lợi nhuận và tăng trưởng. Một trong những người đã ký, Daniel Kokotajlo, cho biết: "Công ty rất hào hứng với việc xây dựng AGI và đang cạnh tranh liều lĩnh với các công ty khác để trở thành công ty đầu tiên triển khai AGI".

1. Thư ngỏ kêu gọi OpenAI tối ưu hóa các kênh giám sát nội bộ, nhưng OpenAI tin rằng họ đã làm tốt công tác bảo mật.

Nhân viên của các công ty AI lớn đã ký bức thư ngỏ này kêu gọi các công ty AI tiếp tục ký hoặc thực hiện bất kỳ điều khoản không phỉ báng nào, cung cấp các thủ tục giám sát ẩn danh, ủng hộ văn hóa chỉ trích của công chúng và đảm bảo rằng họ sẽ không trả thù những người chỉ trích.

Sau đây là bản tổng hợp đầy đủ của bức thư ngỏ: Quyền cảnh báo chống lại AI tiên tiến

Chúng tôi là nhân viên hiện tại và cựu nhân viên của các công ty AI tiên tiến hàng đầu và chúng tôi tin rằng công nghệ AI có tiềm năng mang lại những lợi ích chưa từng có cho nhân loại.

Chúng tôi cũng hiểu những rủi ro nghiêm trọng mà các công nghệ này gây ra. Những rủi ro này bao gồm làm trầm trọng thêm sự bất bình đẳng hiện có, thao túng và gây hiểu lầm thông tin cũng như các hệ thống AI tự động mất kiểm soát có thể dẫn đến sự tuyệt chủng của loài người. Bản thân các công ty AI cũng như chính phủ và các chuyên gia AI khác đã thừa nhận những rủi ro này.

Chúng tôi hy vọng những rủi ro này có thể được giảm thiểu một cách hiệu quả với sự hướng dẫn đầy đủ từ cộng đồng khoa học, các nhà hoạch định chính sách và công chúng. Tuy nhiên, các công ty AI có động cơ tài chính mạnh mẽ để tránh sự giám sát hiệu quả và chúng tôi không tin rằng cơ cấu quản trị phù hợp của công ty có thể thay đổi điều này.

Các công ty AI có rất nhiều thông tin không công khai về khả năng và hạn chế của hệ thống của họ, về các biện pháp bảo vệ của hệ thống cũng như các mức độ rủi ro khác nhau của hệ thống. Tuy nhiên, hiện tại họ chỉ cần chia sẻ một số thông tin với chính phủ và không có nghĩa vụ mạnh mẽ phải báo cáo với chính phủ cũng như không có nghĩa vụ phải chia sẻ bất kỳ thông tin nào với công chúng. Chúng tôi không tin rằng họ có thể chia sẻ thông tin này một cách hoàn toàn tự nguyện.

Chừng nào các công ty này còn không có sự giám sát hiệu quả của chính phủ thì các nhân viên hiện tại và cựu nhân viên vẫn nằm trong số ít những nhân vật của công chúng có thể buộc công ty phải chịu trách nhiệm. Tuy nhiên, các thỏa thuận bảo mật rộng rãi ngăn cản chúng tôi bày tỏ mối quan ngại ngoại trừ những công ty có thể không giải quyết được chúng. Các biện pháp bảo vệ người tố cáo thông thường không đủ để giải quyết những vấn đề như vậy vì chúng tập trung chủ yếu vào hoạt động bất hợp pháp, trong khi nhiều rủi ro mà chúng tôi quan tâm vẫn chưa được quy định. Một số người trong chúng tôi lo ngại một cách chính đáng về các hình thức trả thù khác nhau, dựa trên nhiều trường hợp trả thù khác nhau trong một số trường hợp trong suốt lịch sử của ngành. Chúng tôi không phải là người đầu tiên gặp phải hoặc nói về những vấn đề này.

Vì vậy, chúng tôi kêu gọi các công ty AI tiên tiến cam kết tuân thủ các nguyên tắc sau:

Công ty sẽ không ký kết hoặc thực thi bất kỳ thỏa thuận nào cấm chê bai hoặc chỉ trích Công ty về các vấn đề liên quan đến rủi ro, cũng như sẽ không trả đũa những lời chỉ trích liên quan đến rủi ro bằng cách cản trở bất kỳ lợi ích tài chính nào được đảm bảo; Công ty sẽ tạo ra một quy trình ẩn danh có thể xác minh được cho phép hiện hành; và các nhân viên cũ có thể nêu lên những lo ngại liên quan đến rủi ro với ban giám đốc, cơ quan quản lý của công ty và các tổ chức độc lập phù hợp có chuyên môn liên quan; công ty sẽ ủng hộ văn hóa phê bình cởi mở và cho phép nhân viên hiện tại và cựu nhân viên nêu lên những lo ngại liên quan đến rủi ro với họ; công chúng, ban giám đốc, cơ quan quản lý của công ty hoặc các tổ chức độc lập phù hợp có chuyên môn liên quan nêu lên mối quan ngại của họ về rủi ro công nghệ, miễn là bí mật thương mại và các lợi ích sở hữu trí tuệ khác được bảo vệ hợp lý, công ty sẽ không trả thù những nhân viên hiện tại và hiện tại; chia sẻ công khai thông tin bí mật về rủi ro sau khi các quy trình khác không thành công. Chúng tôi hiểu rằng mọi nỗ lực báo cáo các mối quan ngại liên quan đến rủi ro đều phải tránh tiết lộ thông tin bí mật không cần thiết. Do đó, khi tồn tại một quy trình đủ an toàn để nêu lên mối lo ngại một cách ẩn danh, thì các nhân viên hiện tại và cựu nhân viên trước tiên nên nêu lên mối lo ngại thông qua quy trình đó. Tuy nhiên, miễn là quy trình như vậy không tồn tại, các nhân viên hiện tại và cựu nhân viên vẫn có quyền tự do báo cáo mối quan ngại của mình với công chúng.

Người ký:

OpenAI đã bác bỏ các cáo buộc chống lại các vấn đề bảo mật AI nội bộ của OpenAI trong sự cố thư ngỏ này. Họ đã trả lời cơ quan truyền thông nước ngoài Android Authority như sau:

"Công ty chúng tôi có lịch sử cung cấp các hệ thống AI an toàn và mạnh mẽ nhất. Chúng tôi tự hào về điều này và tin rằng chúng tôi có thể sử dụng phương pháp khoa học để giải quyết rủi ro. Chúng tôi đồng ý rằng, do tầm quan trọng của công nghệ này, một cuộc tranh luận gay gắt là phù hợp." Điều quan trọng là chúng ta phải tiếp tục hợp tác với các chính phủ, xã hội và các nhóm khác trên khắp thế giới, đó là lý do tại sao chúng ta đã tạo điều kiện cho nhân viên nêu lên mối lo ngại, bao gồm cả đường dây nóng ẩn danh về liêm chính do các thành viên ban giám đốc và bộ phận an toàn của công ty chỉ đạo. và Ủy ban An ninh được thành lập”

2. Ủy ban an toàn đã bị loại bỏ và việc giám sát nội bộ gần như không còn hiệu quả.

Trong bức thư ngỏ này, các nhân viên hiện tại và cựu nhân viên từ nhiều công ty phát triển hệ thống AI khác nhau kêu gọi chấm dứt việc sử dụng các thỏa thuận bảo mật và không chê bai tại OpenAI và các công ty AI khác. Họ viết: “Các thỏa thuận bảo mật rộng rãi ngăn cản chúng tôi bày tỏ mối quan ngại của mình”.

Họ cũng kêu gọi các công ty AI “ủng hộ văn hóa phê bình cởi mở” và thiết lập quy trình báo cáo cho phép nhân viên nêu lên những lo ngại liên quan đến an toàn một cách ẩn danh.

Lawrence Lessig là một học giả pháp lý nổi tiếng và là luật sư vì lợi ích công của các nhóm đã ký vào bức thư ngỏ này. Ông cho biết trong một cuộc phỏng vấn rằng biện pháp bảo vệ người tố cáo truyền thống áp dụng cho các báo cáo về hoạt động bất hợp pháp, nhưng do tầm quan trọng của công nghệ AI, các công ty AI cần tạo ra một không gian thảo luận cởi mở và tự do để nhân viên công ty bày tỏ mối quan ngại của họ về rủi ro kỹ thuật và tiềm năng. gây hại cho ý kiến của.

Lessig tin rằng nhân viên của công ty là một tuyến bảo mật quan trọng sẽ trở nên kém hiệu quả nếu họ không thể tự do bày tỏ quan điểm của mình mà không bị trả thù.

Daniel Kokotajlo là một trong những cựu nhân viên của OpenAI đã ký vào bức thư ngỏ. Ông gia nhập OpenAI vào năm 2022 và vị trí của ông là nhà nghiên cứu quản trị của công ty. Ông chính thức từ chức khỏi OpenAI vào tháng 4 năm nay vì “mất niềm tin” vào công ty và tin rằng OpenAI không thể hành động có trách nhiệm khi hệ thống AI đạt hiệu suất gần ngang tầm con người.

Cựu nhân viên OpenAI Daniel Kokotajlo

Tại OpenAI, Kokotajlo nhận thấy mặc dù công ty đã thiết lập các quy tắc và quy định liên quan đến an toàn nhưng những quy tắc và quy định này thường bị bỏ qua. Ví dụ, OpenAI và Microsoft cùng thành lập một ủy ban an toàn triển khai. Mục đích chính của ủy ban này là đánh giá các rủi ro khác nhau có thể có trong mô hình mới trước khi chính thức phát hành mô hình. vai trò.

Kokotayolo cho biết vào năm 2022, Microsoft bắt đầu bí mật thử nghiệm phiên bản mới của công cụ tìm kiếm Bing ở Ấn Độ. Một số nhân viên của OpenAI tin rằng phiên bản công cụ tìm kiếm này sử dụng mẫu GPT-4 chưa được phát hành vào thời điểm đó. Ban Bảo mật Triển khai Chung của OpenAI và Microsoft không biết về cuộc thử nghiệm và chỉ biết đến sự tồn tại của nó sau khi nhận được một loạt báo cáo từ người dùng về hành vi bất thường của công cụ tìm kiếm Bing trong quá trình thử nghiệm. Và điều này đã không làm chậm lại việc Microsoft tung ra phiên bản mới của công cụ tìm kiếm Bing.

Người phát ngôn của Microsoft Frank Shaw đã phủ nhận các cáo buộc. Ông nói rằng không có mô hình OpenAI nào, kể cả GPT-4, được sử dụng trong các thử nghiệm ở Ấn Độ. Microsoft lần đầu tiên phát hành sản phẩm dựa trên mẫu GPT-4 vào đầu năm 2023 và nhận được sự chấp thuận của Ủy ban An ninh Triển khai.

Cocotayolo cho biết ông hoài nghi về khả năng tự điều chỉnh của OpenAI. OpenAI đã thực hiện nhiều bước khác nhau để tránh bị giám sát, bao gồm cả những lời chỉ trích và vạch trần từ các nhân viên cũ.

Khi rời OpenAI, nhân viên công ty cần ký một văn bản ly thân cực kỳ phức tạp, trong đó bao gồm điều khoản không được chê bai và thỏa thuận bảo mật. Nếu nó không ký, OpenAI sẽ lấy lại vốn chủ sở hữu được giao của các nhân viên rời đi và vốn chủ sở hữu này chiếm phần lớn trong gói bồi thường cho nhân viên OpenAI.

Nhưng vẫn có một số nhân viên từ chối ký các thỏa thuận này và Kokotayolo là một trong số đó. Anh ấy cho biết vốn chủ sở hữu của anh ấy trị giá khoảng 1,7 triệu đô la, chiếm phần lớn giá trị tài sản ròng của anh ấy và anh ấy sẵn sàng chia tay số tiền đó.

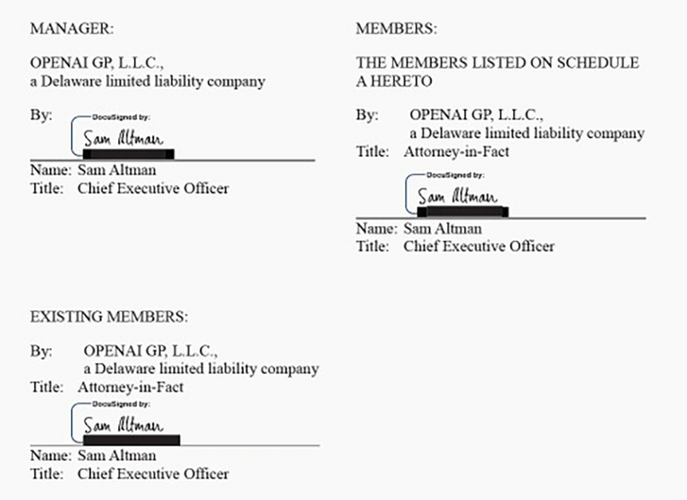

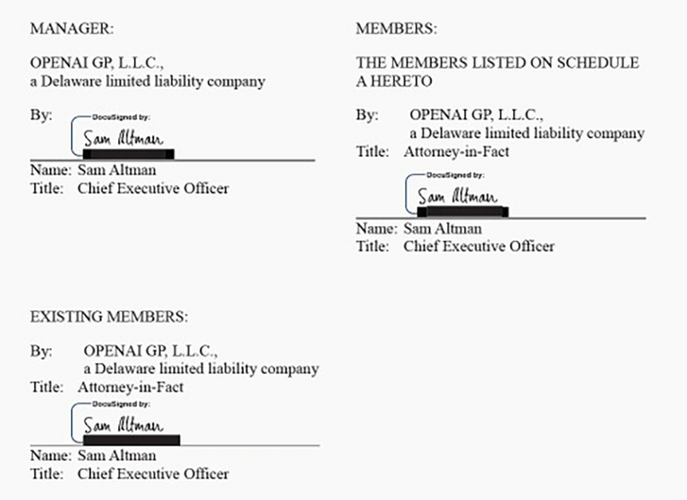

Sau khi phương tiện truyền thông nước ngoài Vox đưa tin về các thỏa thuận này, OpenAI đã nhanh chóng phản hồi, nói rằng công ty chưa bao giờ thu hồi vốn sở hữu từ các nhân viên cũ và sẽ không làm như vậy. Giám đốc điều hành OpenAI Sam Altman cho biết ông cảm thấy đặc biệt xấu hổ vì không biết những giao thức này tồn tại. Nhưng các tài liệu liên quan được Vox tiết lộ đều có chữ ký của Altman.

3. Vấn đề an toàn rất khét tiếng và những nhân viên bày tỏ lo ngại sẽ bị sa thải trực tiếp.

Đây không phải là lần đầu tiên OpenAI gặp phải các vấn đề liên quan đến bảo mật. Ngay sau khi phát hành mô hình GPT-4o của OpenAI, Ilya Sutskever, cựu nhà khoa học trưởng của OpenAI và là một trong bốn cựu thành viên hội đồng quản trị ủng hộ việc loại bỏ Altman, đã chính thức tuyên bố từ chức. Trong một bộ phim tài liệu do The Guardian quay, ông đã gióng lên hồi chuông cảnh báo về những rủi ro tiềm ẩn của các hệ thống AI mạnh mẽ.

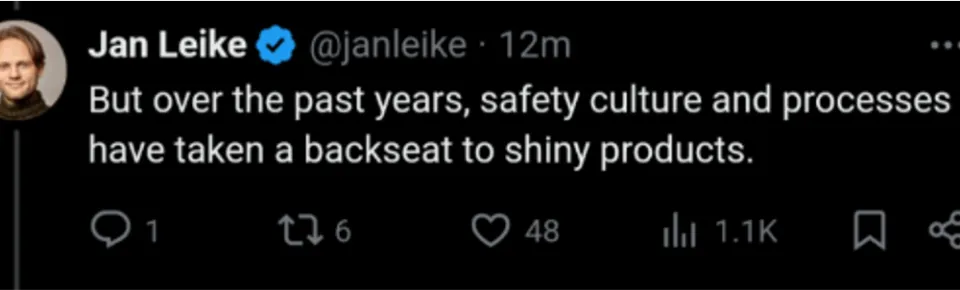

Ngay sau khi Ilya từ chức, Jan Leike, đồng lãnh đạo nhóm OpenAI Super Alignment, cũng tuyên bố từ chức trên Twitter. Ông nói rằng ban lãnh đạo OpenAI luôn có những bất đồng về các ưu tiên cốt lõi của công ty và nhóm Super Alignment đã đi ngược chiều gió trong vài tháng qua và bị cản trở bởi nhiều trở ngại trong công ty trên con đường cải thiện độ an toàn của mô hình. Lake cho biết trong một loạt tweet thông báo về sự ra đi của mình rằng "văn hóa và quy trình an toàn (của OpenAI) đã nhường chỗ cho các sản phẩm sáng bóng".

Ngoài ra, theo hãng truyền thông ngành AI Transformer đưa tin hôm nay, nhà nghiên cứu bảo mật OpenAI Leopold Aschenbrenner, người đã bị sa thải hồi đầu năm nay do "rò rỉ", thực ra đã bị sa thải vì nêu ra vấn đề bảo mật với ban giám đốc. Ông cũng phủ nhận bản ghi nhớ mà ông cung cấp cho hội đồng quản trị có chứa bất kỳ thông tin nhạy cảm nào.

Aschenbrenner đã viết một bản ghi nhớ nội bộ về bảo mật OpenAI khi làm việc, tin rằng trọng lượng mô hình của OpenAI và các bí mật thuật toán chính rất dễ bị đánh cắp.

Vài tuần sau khi anh hoàn thành bản ghi nhớ, OpenAI gặp phải một sự cố bảo mật lớn, khiến anh phải chia sẻ bản ghi nhớ với một số thành viên hội đồng OpenAI. Tuy nhiên, ông cho biết lãnh đạo công ty vô cùng không hài lòng với hành động chia sẻ bản ghi nhớ với hội đồng quản trị công ty, điều này gây ra vấn đề cho lãnh đạo về vấn đề an ninh.

Aschenbrenner đã bị sa thải vài tháng sau vụ việc trên, và OpenAI đã nói rõ với ông vào thời điểm đó rằng bản ghi nhớ bảo mật này là lý do chính khiến ông bị sa thải.

Bảo mật và các vấn đề khác thường xuyên phát sinh và OpenAI tham gia sâu vào dư luận.

Sự cố thư ngỏ này chỉ là một trong nhiều cuộc khủng hoảng mà OpenAI phải đối mặt gần đây. OpenAI vẫn chưa phục hồi hoàn toàn sau “âm mưu đảo chính” năm ngoái của OpenAI là bằng chứng rõ ràng nhất.

OpenAI cũng phải đối mặt với các cuộc chiến pháp lý với những người sáng tạo nội dung cáo buộc họ ăn cắp các tác phẩm có bản quyền để đào tạo các mô hình của mình.

Nữ diễn viên nổi tiếng Hollywood Scarlett Johansson thậm chí còn cáo buộc OpenAI sử dụng giọng nói của cô mà không được phép. Theo báo cáo mới nhất từ National Public Radio (NPR), các chuyên gia nhận dạng giọng nói của Đại học bang Arizona tin rằng giọng của Scarlett gần với giọng Sky của OpenAI hơn 98% nữ diễn viên.

Helen Toner, cựu thành viên hội đồng quản trị OpenAI, gần đây cũng đã cáo buộc Giám đốc điều hành OpenAI Altman về nhiều hành vi không phù hợp trong công ty và đặt câu hỏi về khả năng của Altman trong việc lãnh đạo công ty đạt được các mục tiêu của AGI một cách an toàn.

Có lẽ, như cựu nhân viên OpenAI Kokotajlo đã nói, điều chúng ta cần là một loại cơ cấu quản trị minh bạch và có trách nhiệm dân chủ nào đó để quản lý sự phát triển của công nghệ AI, thay vì chỉ một vài công ty tư nhân khác nhau cạnh tranh với nhau và giữ mọi thứ bí mật.

Nguồn: The New York Times, Transformer #nhânviênOpenAInổidậy

Vào tháng 4 năm nay, Aschenbrenner đã bị OpenAI sa thải vì làm rò rỉ bí mật công ty. Anh cho biết OpenAI đã nói rõ với anh vào thời điểm đó rằng lý do chính khiến anh bị sa thải là do bản ghi nhớ này. Ashenbrenner sau đó đã ra mắt một trang web, sử dụng tài liệu PDF dài 165 trang để tóm tắt những thông tin anh học được khi làm việc tại OpenAI, đồng thời thành lập một công ty đầu tư tập trung vào trí tuệ nhân tạo tổng hợp (AGI).

Aschenbrenner không phải là người duy nhất cảm thấy “bị phản bội”. Hôm qua, 13 nhân viên cũ và hiện tại của OpenAI và Google DeepMind đã cùng nhau đưa ra một bức thư ngỏ, vạch trần văn hóa bí mật và liều lĩnh của OpenAI, nhấn mạnh những rủi ro nghiêm trọng của công nghệ AI tiên tiến và bày tỏ lo ngại về lợi ích của các công ty AI trong việc phát triển và quảng bá AI ưu tiên công nghệ, đàn áp bất đồng chính kiến và lách luật.

Bức thư ngỏ này cũng nhận được sự ủng hộ chữ ký từ hai người đoạt giải Turing 2018 là Yoshua Bengio và Geoffrey Hinton. Stuart Russell, giáo sư khoa học máy tính tại Đại học California, Berkeley, đồng thời là giám đốc Trung tâm Trí tuệ nhân tạo tương thích với con người, cũng đã ký vào bức thư ngỏ.

OpenAI ban đầu là một phòng thí nghiệm nghiên cứu phi lợi nhuận. Trên trang web chính thức, OpenAI xác định sứ mệnh của công ty là “đảm bảo rằng trí tuệ nhân tạo nói chung (AGI) mang lại lợi ích cho nhân loại”. Nhưng các cựu nhân viên OpenAI đã ký thư ngỏ nói rằng trọng tâm hiện tại của OpenAI là lợi nhuận và tăng trưởng. Một trong những người đã ký, Daniel Kokotajlo, cho biết: "Công ty rất hào hứng với việc xây dựng AGI và đang cạnh tranh liều lĩnh với các công ty khác để trở thành công ty đầu tiên triển khai AGI".

1. Thư ngỏ kêu gọi OpenAI tối ưu hóa các kênh giám sát nội bộ, nhưng OpenAI tin rằng họ đã làm tốt công tác bảo mật.

Nhân viên của các công ty AI lớn đã ký bức thư ngỏ này kêu gọi các công ty AI tiếp tục ký hoặc thực hiện bất kỳ điều khoản không phỉ báng nào, cung cấp các thủ tục giám sát ẩn danh, ủng hộ văn hóa chỉ trích của công chúng và đảm bảo rằng họ sẽ không trả thù những người chỉ trích.

Sau đây là bản tổng hợp đầy đủ của bức thư ngỏ: Quyền cảnh báo chống lại AI tiên tiến

Chúng tôi là nhân viên hiện tại và cựu nhân viên của các công ty AI tiên tiến hàng đầu và chúng tôi tin rằng công nghệ AI có tiềm năng mang lại những lợi ích chưa từng có cho nhân loại.

Chúng tôi cũng hiểu những rủi ro nghiêm trọng mà các công nghệ này gây ra. Những rủi ro này bao gồm làm trầm trọng thêm sự bất bình đẳng hiện có, thao túng và gây hiểu lầm thông tin cũng như các hệ thống AI tự động mất kiểm soát có thể dẫn đến sự tuyệt chủng của loài người. Bản thân các công ty AI cũng như chính phủ và các chuyên gia AI khác đã thừa nhận những rủi ro này.

Chúng tôi hy vọng những rủi ro này có thể được giảm thiểu một cách hiệu quả với sự hướng dẫn đầy đủ từ cộng đồng khoa học, các nhà hoạch định chính sách và công chúng. Tuy nhiên, các công ty AI có động cơ tài chính mạnh mẽ để tránh sự giám sát hiệu quả và chúng tôi không tin rằng cơ cấu quản trị phù hợp của công ty có thể thay đổi điều này.

Các công ty AI có rất nhiều thông tin không công khai về khả năng và hạn chế của hệ thống của họ, về các biện pháp bảo vệ của hệ thống cũng như các mức độ rủi ro khác nhau của hệ thống. Tuy nhiên, hiện tại họ chỉ cần chia sẻ một số thông tin với chính phủ và không có nghĩa vụ mạnh mẽ phải báo cáo với chính phủ cũng như không có nghĩa vụ phải chia sẻ bất kỳ thông tin nào với công chúng. Chúng tôi không tin rằng họ có thể chia sẻ thông tin này một cách hoàn toàn tự nguyện.

Chừng nào các công ty này còn không có sự giám sát hiệu quả của chính phủ thì các nhân viên hiện tại và cựu nhân viên vẫn nằm trong số ít những nhân vật của công chúng có thể buộc công ty phải chịu trách nhiệm. Tuy nhiên, các thỏa thuận bảo mật rộng rãi ngăn cản chúng tôi bày tỏ mối quan ngại ngoại trừ những công ty có thể không giải quyết được chúng. Các biện pháp bảo vệ người tố cáo thông thường không đủ để giải quyết những vấn đề như vậy vì chúng tập trung chủ yếu vào hoạt động bất hợp pháp, trong khi nhiều rủi ro mà chúng tôi quan tâm vẫn chưa được quy định. Một số người trong chúng tôi lo ngại một cách chính đáng về các hình thức trả thù khác nhau, dựa trên nhiều trường hợp trả thù khác nhau trong một số trường hợp trong suốt lịch sử của ngành. Chúng tôi không phải là người đầu tiên gặp phải hoặc nói về những vấn đề này.

Vì vậy, chúng tôi kêu gọi các công ty AI tiên tiến cam kết tuân thủ các nguyên tắc sau:

Công ty sẽ không ký kết hoặc thực thi bất kỳ thỏa thuận nào cấm chê bai hoặc chỉ trích Công ty về các vấn đề liên quan đến rủi ro, cũng như sẽ không trả đũa những lời chỉ trích liên quan đến rủi ro bằng cách cản trở bất kỳ lợi ích tài chính nào được đảm bảo; Công ty sẽ tạo ra một quy trình ẩn danh có thể xác minh được cho phép hiện hành; và các nhân viên cũ có thể nêu lên những lo ngại liên quan đến rủi ro với ban giám đốc, cơ quan quản lý của công ty và các tổ chức độc lập phù hợp có chuyên môn liên quan; công ty sẽ ủng hộ văn hóa phê bình cởi mở và cho phép nhân viên hiện tại và cựu nhân viên nêu lên những lo ngại liên quan đến rủi ro với họ; công chúng, ban giám đốc, cơ quan quản lý của công ty hoặc các tổ chức độc lập phù hợp có chuyên môn liên quan nêu lên mối quan ngại của họ về rủi ro công nghệ, miễn là bí mật thương mại và các lợi ích sở hữu trí tuệ khác được bảo vệ hợp lý, công ty sẽ không trả thù những nhân viên hiện tại và hiện tại; chia sẻ công khai thông tin bí mật về rủi ro sau khi các quy trình khác không thành công. Chúng tôi hiểu rằng mọi nỗ lực báo cáo các mối quan ngại liên quan đến rủi ro đều phải tránh tiết lộ thông tin bí mật không cần thiết. Do đó, khi tồn tại một quy trình đủ an toàn để nêu lên mối lo ngại một cách ẩn danh, thì các nhân viên hiện tại và cựu nhân viên trước tiên nên nêu lên mối lo ngại thông qua quy trình đó. Tuy nhiên, miễn là quy trình như vậy không tồn tại, các nhân viên hiện tại và cựu nhân viên vẫn có quyền tự do báo cáo mối quan ngại của mình với công chúng.

Người ký:

- Jacob Hilton, cựu nhân viên OpenAI

- Daniel Kokotajlo, cựu nhân viên OpenAI

- Ramana Kumar, cựu nhân viên Google DeepMind

- Neel Nanda, nhân viên hiện tại của Google DeepMind, cựu nhân viên của Anthropic

- William Saunders, cựu nhân viên OpenAI

- Carroll Wainwright, cựu nhân viên OpenAI

- Daniel Ziegler, cựu nhân viên OpenAI

- Ẩn danh, nhân viên hiện tại của OpenAI

- Ẩn danh, nhân viên hiện tại của OpenAI

- Ẩn danh, nhân viên hiện tại của OpenAI

- Ẩn danh, nhân viên hiện tại của OpenAI

- Ẩn danh, cựu nhân viên OpenAI

- Ẩn danh, cựu nhân viên OpenAI

- Yoshua Bengio

- Geoffrey Hinton

- Stuart Russell

OpenAI đã bác bỏ các cáo buộc chống lại các vấn đề bảo mật AI nội bộ của OpenAI trong sự cố thư ngỏ này. Họ đã trả lời cơ quan truyền thông nước ngoài Android Authority như sau:

"Công ty chúng tôi có lịch sử cung cấp các hệ thống AI an toàn và mạnh mẽ nhất. Chúng tôi tự hào về điều này và tin rằng chúng tôi có thể sử dụng phương pháp khoa học để giải quyết rủi ro. Chúng tôi đồng ý rằng, do tầm quan trọng của công nghệ này, một cuộc tranh luận gay gắt là phù hợp." Điều quan trọng là chúng ta phải tiếp tục hợp tác với các chính phủ, xã hội và các nhóm khác trên khắp thế giới, đó là lý do tại sao chúng ta đã tạo điều kiện cho nhân viên nêu lên mối lo ngại, bao gồm cả đường dây nóng ẩn danh về liêm chính do các thành viên ban giám đốc và bộ phận an toàn của công ty chỉ đạo. và Ủy ban An ninh được thành lập”

2. Ủy ban an toàn đã bị loại bỏ và việc giám sát nội bộ gần như không còn hiệu quả.

Trong bức thư ngỏ này, các nhân viên hiện tại và cựu nhân viên từ nhiều công ty phát triển hệ thống AI khác nhau kêu gọi chấm dứt việc sử dụng các thỏa thuận bảo mật và không chê bai tại OpenAI và các công ty AI khác. Họ viết: “Các thỏa thuận bảo mật rộng rãi ngăn cản chúng tôi bày tỏ mối quan ngại của mình”.

Họ cũng kêu gọi các công ty AI “ủng hộ văn hóa phê bình cởi mở” và thiết lập quy trình báo cáo cho phép nhân viên nêu lên những lo ngại liên quan đến an toàn một cách ẩn danh.

Lawrence Lessig là một học giả pháp lý nổi tiếng và là luật sư vì lợi ích công của các nhóm đã ký vào bức thư ngỏ này. Ông cho biết trong một cuộc phỏng vấn rằng biện pháp bảo vệ người tố cáo truyền thống áp dụng cho các báo cáo về hoạt động bất hợp pháp, nhưng do tầm quan trọng của công nghệ AI, các công ty AI cần tạo ra một không gian thảo luận cởi mở và tự do để nhân viên công ty bày tỏ mối quan ngại của họ về rủi ro kỹ thuật và tiềm năng. gây hại cho ý kiến của.

Lessig tin rằng nhân viên của công ty là một tuyến bảo mật quan trọng sẽ trở nên kém hiệu quả nếu họ không thể tự do bày tỏ quan điểm của mình mà không bị trả thù.

Daniel Kokotajlo là một trong những cựu nhân viên của OpenAI đã ký vào bức thư ngỏ. Ông gia nhập OpenAI vào năm 2022 và vị trí của ông là nhà nghiên cứu quản trị của công ty. Ông chính thức từ chức khỏi OpenAI vào tháng 4 năm nay vì “mất niềm tin” vào công ty và tin rằng OpenAI không thể hành động có trách nhiệm khi hệ thống AI đạt hiệu suất gần ngang tầm con người.

Cựu nhân viên OpenAI Daniel Kokotajlo

Tại OpenAI, Kokotajlo nhận thấy mặc dù công ty đã thiết lập các quy tắc và quy định liên quan đến an toàn nhưng những quy tắc và quy định này thường bị bỏ qua. Ví dụ, OpenAI và Microsoft cùng thành lập một ủy ban an toàn triển khai. Mục đích chính của ủy ban này là đánh giá các rủi ro khác nhau có thể có trong mô hình mới trước khi chính thức phát hành mô hình. vai trò.

Kokotayolo cho biết vào năm 2022, Microsoft bắt đầu bí mật thử nghiệm phiên bản mới của công cụ tìm kiếm Bing ở Ấn Độ. Một số nhân viên của OpenAI tin rằng phiên bản công cụ tìm kiếm này sử dụng mẫu GPT-4 chưa được phát hành vào thời điểm đó. Ban Bảo mật Triển khai Chung của OpenAI và Microsoft không biết về cuộc thử nghiệm và chỉ biết đến sự tồn tại của nó sau khi nhận được một loạt báo cáo từ người dùng về hành vi bất thường của công cụ tìm kiếm Bing trong quá trình thử nghiệm. Và điều này đã không làm chậm lại việc Microsoft tung ra phiên bản mới của công cụ tìm kiếm Bing.

Người phát ngôn của Microsoft Frank Shaw đã phủ nhận các cáo buộc. Ông nói rằng không có mô hình OpenAI nào, kể cả GPT-4, được sử dụng trong các thử nghiệm ở Ấn Độ. Microsoft lần đầu tiên phát hành sản phẩm dựa trên mẫu GPT-4 vào đầu năm 2023 và nhận được sự chấp thuận của Ủy ban An ninh Triển khai.

Cocotayolo cho biết ông hoài nghi về khả năng tự điều chỉnh của OpenAI. OpenAI đã thực hiện nhiều bước khác nhau để tránh bị giám sát, bao gồm cả những lời chỉ trích và vạch trần từ các nhân viên cũ.

Khi rời OpenAI, nhân viên công ty cần ký một văn bản ly thân cực kỳ phức tạp, trong đó bao gồm điều khoản không được chê bai và thỏa thuận bảo mật. Nếu nó không ký, OpenAI sẽ lấy lại vốn chủ sở hữu được giao của các nhân viên rời đi và vốn chủ sở hữu này chiếm phần lớn trong gói bồi thường cho nhân viên OpenAI.

Nhưng vẫn có một số nhân viên từ chối ký các thỏa thuận này và Kokotayolo là một trong số đó. Anh ấy cho biết vốn chủ sở hữu của anh ấy trị giá khoảng 1,7 triệu đô la, chiếm phần lớn giá trị tài sản ròng của anh ấy và anh ấy sẵn sàng chia tay số tiền đó.

Sau khi phương tiện truyền thông nước ngoài Vox đưa tin về các thỏa thuận này, OpenAI đã nhanh chóng phản hồi, nói rằng công ty chưa bao giờ thu hồi vốn sở hữu từ các nhân viên cũ và sẽ không làm như vậy. Giám đốc điều hành OpenAI Sam Altman cho biết ông cảm thấy đặc biệt xấu hổ vì không biết những giao thức này tồn tại. Nhưng các tài liệu liên quan được Vox tiết lộ đều có chữ ký của Altman.

3. Vấn đề an toàn rất khét tiếng và những nhân viên bày tỏ lo ngại sẽ bị sa thải trực tiếp.

Đây không phải là lần đầu tiên OpenAI gặp phải các vấn đề liên quan đến bảo mật. Ngay sau khi phát hành mô hình GPT-4o của OpenAI, Ilya Sutskever, cựu nhà khoa học trưởng của OpenAI và là một trong bốn cựu thành viên hội đồng quản trị ủng hộ việc loại bỏ Altman, đã chính thức tuyên bố từ chức. Trong một bộ phim tài liệu do The Guardian quay, ông đã gióng lên hồi chuông cảnh báo về những rủi ro tiềm ẩn của các hệ thống AI mạnh mẽ.

Ngay sau khi Ilya từ chức, Jan Leike, đồng lãnh đạo nhóm OpenAI Super Alignment, cũng tuyên bố từ chức trên Twitter. Ông nói rằng ban lãnh đạo OpenAI luôn có những bất đồng về các ưu tiên cốt lõi của công ty và nhóm Super Alignment đã đi ngược chiều gió trong vài tháng qua và bị cản trở bởi nhiều trở ngại trong công ty trên con đường cải thiện độ an toàn của mô hình. Lake cho biết trong một loạt tweet thông báo về sự ra đi của mình rằng "văn hóa và quy trình an toàn (của OpenAI) đã nhường chỗ cho các sản phẩm sáng bóng".

Ngoài ra, theo hãng truyền thông ngành AI Transformer đưa tin hôm nay, nhà nghiên cứu bảo mật OpenAI Leopold Aschenbrenner, người đã bị sa thải hồi đầu năm nay do "rò rỉ", thực ra đã bị sa thải vì nêu ra vấn đề bảo mật với ban giám đốc. Ông cũng phủ nhận bản ghi nhớ mà ông cung cấp cho hội đồng quản trị có chứa bất kỳ thông tin nhạy cảm nào.

Aschenbrenner đã viết một bản ghi nhớ nội bộ về bảo mật OpenAI khi làm việc, tin rằng trọng lượng mô hình của OpenAI và các bí mật thuật toán chính rất dễ bị đánh cắp.

Vài tuần sau khi anh hoàn thành bản ghi nhớ, OpenAI gặp phải một sự cố bảo mật lớn, khiến anh phải chia sẻ bản ghi nhớ với một số thành viên hội đồng OpenAI. Tuy nhiên, ông cho biết lãnh đạo công ty vô cùng không hài lòng với hành động chia sẻ bản ghi nhớ với hội đồng quản trị công ty, điều này gây ra vấn đề cho lãnh đạo về vấn đề an ninh.

Aschenbrenner đã bị sa thải vài tháng sau vụ việc trên, và OpenAI đã nói rõ với ông vào thời điểm đó rằng bản ghi nhớ bảo mật này là lý do chính khiến ông bị sa thải.

Bảo mật và các vấn đề khác thường xuyên phát sinh và OpenAI tham gia sâu vào dư luận.

Sự cố thư ngỏ này chỉ là một trong nhiều cuộc khủng hoảng mà OpenAI phải đối mặt gần đây. OpenAI vẫn chưa phục hồi hoàn toàn sau “âm mưu đảo chính” năm ngoái của OpenAI là bằng chứng rõ ràng nhất.

OpenAI cũng phải đối mặt với các cuộc chiến pháp lý với những người sáng tạo nội dung cáo buộc họ ăn cắp các tác phẩm có bản quyền để đào tạo các mô hình của mình.

Nữ diễn viên nổi tiếng Hollywood Scarlett Johansson thậm chí còn cáo buộc OpenAI sử dụng giọng nói của cô mà không được phép. Theo báo cáo mới nhất từ National Public Radio (NPR), các chuyên gia nhận dạng giọng nói của Đại học bang Arizona tin rằng giọng của Scarlett gần với giọng Sky của OpenAI hơn 98% nữ diễn viên.

Helen Toner, cựu thành viên hội đồng quản trị OpenAI, gần đây cũng đã cáo buộc Giám đốc điều hành OpenAI Altman về nhiều hành vi không phù hợp trong công ty và đặt câu hỏi về khả năng của Altman trong việc lãnh đạo công ty đạt được các mục tiêu của AGI một cách an toàn.

Có lẽ, như cựu nhân viên OpenAI Kokotajlo đã nói, điều chúng ta cần là một loại cơ cấu quản trị minh bạch và có trách nhiệm dân chủ nào đó để quản lý sự phát triển của công nghệ AI, thay vì chỉ một vài công ty tư nhân khác nhau cạnh tranh với nhau và giữ mọi thứ bí mật.

Nguồn: The New York Times, Transformer #nhânviênOpenAInổidậy