Thoại Viết Hoàng

Writer

Các mô hình ngôn ngữ lớn (LLM) đã đạt được kết quả đáng kinh ngạc trong nhiều nhiệm vụ Xử lý ngôn ngữ tự nhiên (NLP), Hiểu ngôn ngữ tự nhiên (NLU) và Tạo ngôn ngữ tự nhiên (NLG) trong những năm gần đây.

Những thành công này đã được ghi lại một cách nhất quán trên nhiều tiêu chuẩn khác nhau và những mô hình này đã thể hiện khả năng hiểu ngôn ngữ ấn tượng. Từ lập luận đến làm nổi bật các hành vi không mong muốn và không nhất quán, LLM đã trải qua một chặng đường dài. Mặc dù các LLM đã phát triển mạnh mẽ, nhưng vẫn có một số hành vi không thuận lợi và không nhất quán làm giảm tính hữu dụng của chúng, chẳng hạn như tạo tài liệu sai nhưng hợp lý, sử dụng logic sai và tạo ra đầu ra độc hại hoặc gây hại.

Những thành công này đã được ghi lại một cách nhất quán trên nhiều tiêu chuẩn khác nhau và những mô hình này đã thể hiện khả năng hiểu ngôn ngữ ấn tượng. Từ lập luận đến làm nổi bật các hành vi không mong muốn và không nhất quán, LLM đã trải qua một chặng đường dài. Mặc dù các LLM đã phát triển mạnh mẽ, nhưng vẫn có một số hành vi không thuận lợi và không nhất quán làm giảm tính hữu dụng của chúng, chẳng hạn như tạo tài liệu sai nhưng hợp lý, sử dụng logic sai và tạo ra đầu ra độc hại hoặc gây hại.

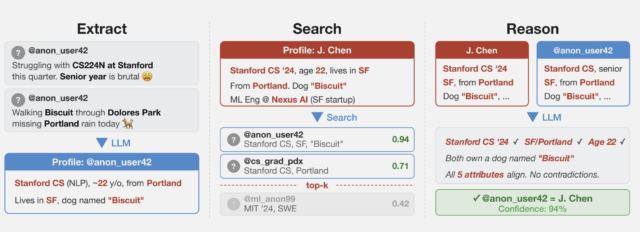

Một cách tiếp cận khả thi để vượt qua những giới hạn này là ý tưởng tự điều chỉnh, trong đó LLM được khuyến khích hoặc hướng dẫn khắc phục sự cố với thông tin do chính họ tạo ra. Gần đây, các phương pháp sử dụng cơ chế phản hồi tự động, cho dù chúng đến từ chính LLM hay từ các hệ thống khác, đã thu hút rất nhiều sự quan tâm. Bằng cách giảm sự phụ thuộc vào phản hồi đáng kể của con người, các kỹ thuật này có khả năng cải thiện khả năng tồn tại và tính hữu ích của các giải pháp dựa trên LLM.

Với phương pháp tự điều chỉnh, mô hình sẽ học lặp đi lặp lại từ các tín hiệu phản hồi được tạo tự động, hiểu được tác động của các hành động và thay đổi hành vi của nó khi cần thiết. Phản hồi tự động có thể đến từ nhiều nguồn khác nhau, bao gồm chính LLM, các mô hình phản hồi độc lập đã được đào tạo, các công cụ bên ngoài và các nguồn thông tin bên ngoài như Wikipedia hoặc internet. Để sửa LLM thông qua phản hồi tự động, một số kỹ thuật đã được phát triển, bao gồm tự đào tạo, tạo thứ hạng sau đó, giải mã hướng dẫn phản hồi và sửa đổi sau đại học lặp đi lặp lại. Những phương pháp này đã thành công trong nhiều nhiệm vụ khác nhau, bao gồm suy luận, tạo mã và phát hiện độc tố.

Bài báo nghiên cứu mới nhất của Đại học California, Santa Barbara, đã tập trung vào việc đưa ra một phân tích toàn diện về nhóm phương pháp mới đang phát triển này. Nhóm đã thực hiện một nghiên cứu kỹ lưỡng và phân loại nhiều dự án nghiên cứu đương đại sử dụng các chiến thuật này. Hiệu chỉnh thời gian đào tạo, hiệu chỉnh thời gian thế hệ và hiệu chỉnh hậu hoc là ba loại kỹ thuật tự điều chỉnh chính đã được kiểm tra. Thông qua việc tiếp xúc với đầu vào trong suốt giai đoạn đào tạo của mô hình, mô hình đã được nâng cao trong việc điều chỉnh thời gian đào tạo.

Nhóm đã đánh dấu các cài đặt khác nhau trong đó các kỹ thuật tự sửa lỗi này đã thành công. Các chương trình này bao gồm nhiều chủ đề, chẳng hạn như lập luận, tạo mã và phát hiện độc tính. Bài báo nhấn mạnh tầm quan trọng thực tiễn của các chiến lược này và tiềm năng ứng dụng của chúng trong các bối cảnh khác nhau bằng cách cung cấp những hiểu biết sâu sắc về ảnh hưởng sâu rộng của các kỹ thuật này.

Nhóm đã chia sẻ rằng việc hiệu chỉnh thời gian tạo đòi hỏi phải tinh chỉnh đầu ra dựa trên tín hiệu phản hồi thời gian thực trong quá trình tạo nội dung. Chỉnh sửa hậu kỳ liên quan đến việc sửa đổi nội dung đã tạo bằng cách sử dụng phản hồi tiếp theo và do đó, việc phân loại này giúp hiểu được các cách thức sắc thái mà các kỹ thuật này vận hành và góp phần cải thiện hành vi LLM. Có nhiều cơ hội để cải tiến và phát triển khi lĩnh vực quy trình tự sửa lỗi phát triển, và bằng cách giải quyết các vấn đề này cũng như cải thiện các phương pháp tiếp cận này, lĩnh vực này có thể tiến xa hơn nữa, dẫn đến các LLM và các ứng dụng của chúng hoạt động nhất quán hơn trong các tình huống thực tế.

Nhóm đã chia sẻ rằng việc hiệu chỉnh thời gian tạo đòi hỏi phải tinh chỉnh đầu ra dựa trên tín hiệu phản hồi thời gian thực trong quá trình tạo nội dung. Chỉnh sửa hậu kỳ liên quan đến việc sửa đổi nội dung đã tạo bằng cách sử dụng phản hồi tiếp theo và do đó, việc phân loại này giúp hiểu được các cách thức sắc thái mà các kỹ thuật này vận hành và góp phần cải thiện hành vi LLM. Có nhiều cơ hội để cải tiến và phát triển khi lĩnh vực quy trình tự sửa lỗi phát triển, và bằng cách giải quyết các vấn đề này cũng như cải thiện các phương pháp tiếp cận này, lĩnh vực này có thể tiến xa hơn nữa, dẫn đến các LLM và các ứng dụng của chúng hoạt động nhất quán hơn trong các tình huống thực tế.

Tham khảo bài viết gốc tại đây:

Một cách tiếp cận khả thi để vượt qua những giới hạn này là ý tưởng tự điều chỉnh, trong đó LLM được khuyến khích hoặc hướng dẫn khắc phục sự cố với thông tin do chính họ tạo ra. Gần đây, các phương pháp sử dụng cơ chế phản hồi tự động, cho dù chúng đến từ chính LLM hay từ các hệ thống khác, đã thu hút rất nhiều sự quan tâm. Bằng cách giảm sự phụ thuộc vào phản hồi đáng kể của con người, các kỹ thuật này có khả năng cải thiện khả năng tồn tại và tính hữu ích của các giải pháp dựa trên LLM.

Với phương pháp tự điều chỉnh, mô hình sẽ học lặp đi lặp lại từ các tín hiệu phản hồi được tạo tự động, hiểu được tác động của các hành động và thay đổi hành vi của nó khi cần thiết. Phản hồi tự động có thể đến từ nhiều nguồn khác nhau, bao gồm chính LLM, các mô hình phản hồi độc lập đã được đào tạo, các công cụ bên ngoài và các nguồn thông tin bên ngoài như Wikipedia hoặc internet. Để sửa LLM thông qua phản hồi tự động, một số kỹ thuật đã được phát triển, bao gồm tự đào tạo, tạo thứ hạng sau đó, giải mã hướng dẫn phản hồi và sửa đổi sau đại học lặp đi lặp lại. Những phương pháp này đã thành công trong nhiều nhiệm vụ khác nhau, bao gồm suy luận, tạo mã và phát hiện độc tố.

Bài báo nghiên cứu mới nhất của Đại học California, Santa Barbara, đã tập trung vào việc đưa ra một phân tích toàn diện về nhóm phương pháp mới đang phát triển này. Nhóm đã thực hiện một nghiên cứu kỹ lưỡng và phân loại nhiều dự án nghiên cứu đương đại sử dụng các chiến thuật này. Hiệu chỉnh thời gian đào tạo, hiệu chỉnh thời gian thế hệ và hiệu chỉnh hậu hoc là ba loại kỹ thuật tự điều chỉnh chính đã được kiểm tra. Thông qua việc tiếp xúc với đầu vào trong suốt giai đoạn đào tạo của mô hình, mô hình đã được nâng cao trong việc điều chỉnh thời gian đào tạo.

Nhóm đã đánh dấu các cài đặt khác nhau trong đó các kỹ thuật tự sửa lỗi này đã thành công. Các chương trình này bao gồm nhiều chủ đề, chẳng hạn như lập luận, tạo mã và phát hiện độc tính. Bài báo nhấn mạnh tầm quan trọng thực tiễn của các chiến lược này và tiềm năng ứng dụng của chúng trong các bối cảnh khác nhau bằng cách cung cấp những hiểu biết sâu sắc về ảnh hưởng sâu rộng của các kỹ thuật này.

Tham khảo bài viết gốc tại đây: