Sóng AI

Writer

Qwen Team, một bộ phận của Alibaba, vừa giới thiệu mô hình lập luận nguồn mở QwQ-32B với 32 tỷ tham số, nhằm cải thiện hiệu suất trong các tác vụ giải quyết vấn đề phức tạp thông qua học tăng cường (RL)1.

Mô hình có sẵn dưới dạng trọng số mở trên Hugging Face và ModelScope với giấy phép Apache 2.0, cho phép sử dụng trong thương mại và nghiên cứu

QwQ-32B là phiên bản mới nhất của QwQ (Qwen-with-Questions), được Alibaba giới thiệu lần đầu vào tháng 11/2024 để cạnh tranh với mô hình o1-preview của OpenAI1.

Mô hình ban đầu có 32 tỷ tham số và độ dài ngữ cảnh 32.000 token, vượt trội o1-preview trong các điểm chuẩn toán học như AIME và MATH, cũng như các tác vụ lập luận khoa học như GPQA1.

QwQ-32B sử dụng phương pháp học tăng cường đa giai đoạn để nâng cao khả năng lập luận toán học, lập trình và giải quyết vấn đề tổng quát

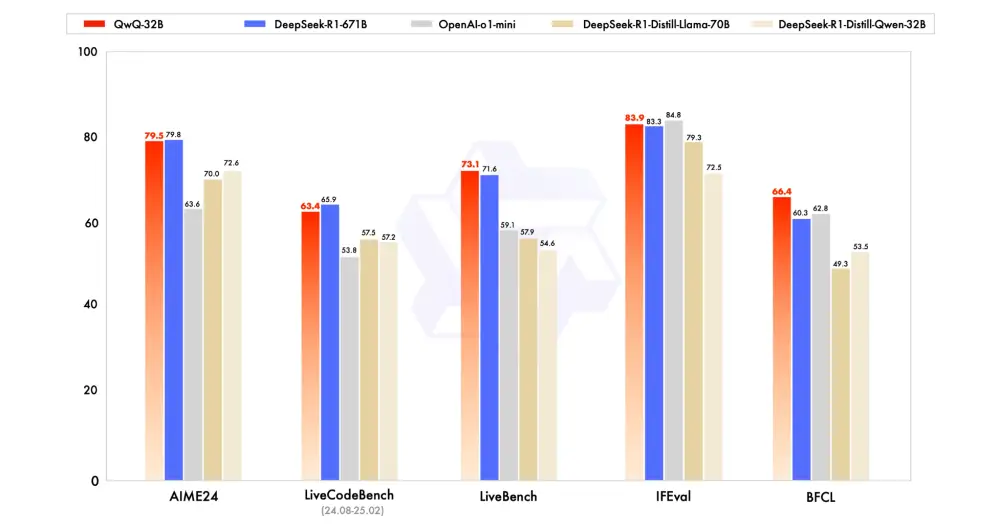

So với DeepSeek-R1 (671 tỷ tham số), QwQ-32B đạt hiệu suất tương đương nhưng chỉ yêu cầu 24 GB vRAM trên GPU, so với hơn 1.500 GB vRAM để chạy DeepSeek R1 đầy đủ

Kiến trúc của QwQ-32B bao gồm 64 lớp transformer với các tối ưu hóa như RoPE, SwiGLU, RMSNorm và Attention QKV bias

Mô hình có độ dài ngữ cảnh mở rộng lên 131.072 token, cho phép xử lý tốt hơn các đầu vào chuỗi dài

Quá trình học tăng cường của QwQ-32B được thực hiện qua hai giai đoạn: tập trung vào toán học và lập trình, sau đó là nâng cao khả năng tổng quát

QwQ-32B có thể hỗ trợ doanh nghiệp trong các lĩnh vực như phân tích dữ liệu tự động, lập kế hoạch chiến lược, phát triển phần mềm và tự động hóa thông minh

Mô hình nhận được phản hồi tích cực từ cộng đồng AI, với nhiều chuyên gia đánh giá cao về tốc độ suy luận và hiệu suất so với các mô hình lớn hơn

QwQ-32B tích hợp khả năng tác nhân, cho phép điều chỉnh động quá trình lập luận dựa trên phản hồi môi trường

Qwen Team coi QwQ-32B là bước đầu tiên trong việc mở rộng học tăng cường để nâng cao khả năng lập luận, với kế hoạch tương lai bao gồm tích hợp tác nhân với RL cho lập luận dài hạn và phát triển hướng tới trí tuệ nhân tạo tổng quát (AGI)

Nguồn: Songai.vn