Hoàng Khang

Writer

Những điểm chính:

DeepSeek và kỹ thuật 'chưng cất' AI: 'Cướp biển' hay 'cứu tinh'?

DeepSeek R1, mô hình ngôn ngữ lớn của công ty DeepSeek, đã gây ấn tượng mạnh khi đạt được hiệu suất tương đương với các mô hình hàng đầu của Mỹ, nhưng với chi phí thấp hơn nhiều. Theo DeepSeek, mô hình R1 được xây dựng trên nền tảng V3 với khoảng 2.000 chip Nvidia H800, tiêu tốn tổng chi phí 5,6 triệu USD. Con số này chỉ bằng một phần nhỏ so với chi phí hàng tỷ USD mà các "ông lớn" công nghệ như Meta, Microsoft, Google hay OpenAI đã bỏ ra để phát triển các mô hình AI của họ.

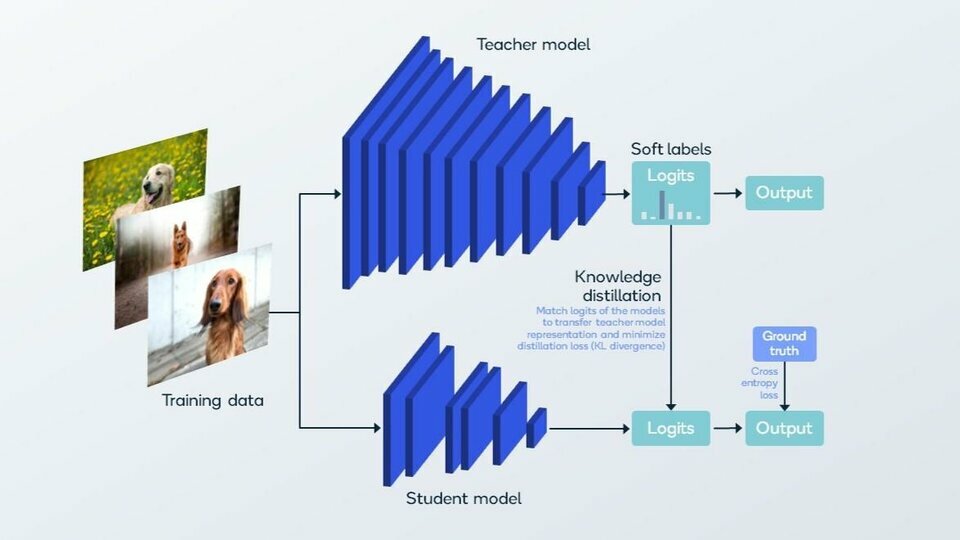

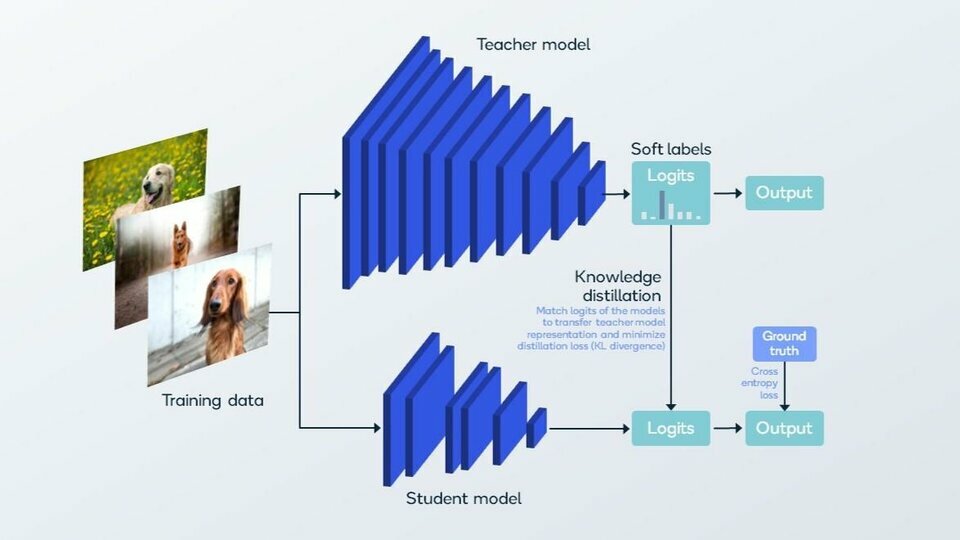

Bí quyết của DeepSeek nằm ở kỹ thuật "chưng cất" (distillation). Đây là một phương pháp cho phép một mô hình AI nhỏ hơn ("học sinh") học hỏi kiến thức từ một mô hình AI lớn hơn ("giáo viên").

Quá trình "chưng cất" diễn ra như sau:

Thung lũng Silicon 'dậy sóng': Có cần thiết phải chi hàng tỷ USD cho AI?

Thành công của DeepSeek đã khiến các giám đốc điều hành và nhà đầu tư tại Thung lũng Silicon phải xem xét lại mô hình kinh doanh của họ.

"Liệu có xứng đáng về mặt kinh tế để đi đầu nếu chi phí tốn gấp 8 lần so với người đi theo sau?", Mike Volpi, một giám đốc điều hành công nghệ kỳ cựu và nhà đầu tư mạo hiểm tại Hanabi Capital, đặt câu hỏi.

Các chuyên gia dự đoán, trong thời gian tới, sẽ có nhiều ứng dụng AI chất lượng cao được tạo ra bằng kỹ thuật "chưng cất".

Các nhà nghiên cứu tại Hugging Face, một công ty AI, đã bắt đầu thử nghiệm xây dựng một mô hình tương tự như của DeepSeek. "Điều dễ sao chép nhất là quy trình chưng cất," Lewis Tunstall, nhà nghiên cứu cấp cao tại Hugging Face, cho biết.

Ưu điểm và hạn chế của 'chưng cất' AI

"Chưng cất" AI mang lại nhiều lợi ích:

Tương lai của ngành AI: Mô hình lớn hay mô hình nhỏ?

Các mô hình AI từ OpenAI và Google vẫn đang dẫn đầu trên các bảng xếp hạng được sử dụng rộng rãi ở Thung lũng Silicon. Các "ông lớn" công nghệ có lợi thế trong việc thực hiện nghiên cứu gốc và phát triển các hệ thống tiên tiến nhất.

Tuy nhiên, nhiều người tiêu dùng và doanh nghiệp sẵn sàng sử dụng công nghệ kém hơn một chút nhưng có mức giá rẻ hơn rất nhiều.

Ahmed Awadallah từ Microsoft Research nhận định: "Chưng cất mang lại một sự đánh đổi thú vị. Khi bạn làm cho mô hình nhỏ hơn, không thể tránh khỏi việc giảm khả năng của nó."

Theo David Cox, Phó Chủ tịch phụ trách mô hình AI tại IBM Research, hầu hết các doanh nghiệp không cần đến các mô hình AI "khủng" để vận hành sản phẩm. Các mô hình "chưng cất" đã đủ mạnh để phục vụ các mục đích như chatbot dịch vụ khách hàng, hoặc hoạt động trên các thiết bị nhỏ.

"Bất cứ khi nào có thể giảm chi phí mà vẫn đạt được hiệu suất mong muốn, chẳng có lý do gì để không làm điều đó," Cox nói.

Kỹ thuật "chưng cất" AI đang mở ra một hướng đi mới cho ngành công nghiệp AI, cho phép các công ty nhỏ cạnh tranh với các "ông lớn" bằng cách tạo ra các mô hình AI hiệu quả, tiết kiệm chi phí. Tuy nhiên, việc sử dụng kỹ thuật này cũng đặt ra những câu hỏi về bản quyền, đạo đức và trách nhiệm giải trình, đòi hỏi các nhà phát triển, các nhà lập pháp và cộng đồng cần phải có những quy định và hướng dẫn rõ ràng.

- DeepSeek, một startup AI Trung Quốc, đã tạo ra mô hình R1 với chi phí thấp hơn nhiều so với các mô hình của các công ty Mỹ, nhưng vẫn đạt hiệu suất tương đương.

- "Chưng cất" (distillation) là kỹ thuật cho phép mô hình AI nhỏ "học" kiến thức từ mô hình lớn hơn, giúp giảm chi phí và tăng tốc độ.

- Thành công của DeepSeek khiến các chuyên gia và nhà đầu tư đặt câu hỏi về tính hiệu quả của việc đầu tư hàng tỷ USD vào các mô hình AI "khủng".

- Các mô hình "chưng cất" có thể không toàn diện bằng mô hình lớn, nhưng vẫn đủ mạnh để phục vụ nhiều mục đích.

- "Chưng cất" AI đặt ra vấn đề về bản quyền và đạo đức, khi mô hình nhỏ "học" từ mô hình lớn mà không có sự cho phép rõ ràng.

DeepSeek và kỹ thuật 'chưng cất' AI: 'Cướp biển' hay 'cứu tinh'?

DeepSeek R1, mô hình ngôn ngữ lớn của công ty DeepSeek, đã gây ấn tượng mạnh khi đạt được hiệu suất tương đương với các mô hình hàng đầu của Mỹ, nhưng với chi phí thấp hơn nhiều. Theo DeepSeek, mô hình R1 được xây dựng trên nền tảng V3 với khoảng 2.000 chip Nvidia H800, tiêu tốn tổng chi phí 5,6 triệu USD. Con số này chỉ bằng một phần nhỏ so với chi phí hàng tỷ USD mà các "ông lớn" công nghệ như Meta, Microsoft, Google hay OpenAI đã bỏ ra để phát triển các mô hình AI của họ.

Bí quyết của DeepSeek nằm ở kỹ thuật "chưng cất" (distillation). Đây là một phương pháp cho phép một mô hình AI nhỏ hơn ("học sinh") học hỏi kiến thức từ một mô hình AI lớn hơn ("giáo viên").

Quá trình "chưng cất" diễn ra như sau:

- Mô hình "giáo viên" (ví dụ: GPT-4 của OpenAI) được huấn luyện trên một lượng dữ liệu khổng lồ, có khả năng dự đoán từ tiếp theo trong một câu.

- Mô hình "giáo viên" tạo ra dữ liệu (các câu trả lời, văn bản...).

- Dữ liệu này được sử dụng để huấn luyện mô hình "học sinh" (ví dụ: DeepSeek R1).

Thung lũng Silicon 'dậy sóng': Có cần thiết phải chi hàng tỷ USD cho AI?

Thành công của DeepSeek đã khiến các giám đốc điều hành và nhà đầu tư tại Thung lũng Silicon phải xem xét lại mô hình kinh doanh của họ.

"Liệu có xứng đáng về mặt kinh tế để đi đầu nếu chi phí tốn gấp 8 lần so với người đi theo sau?", Mike Volpi, một giám đốc điều hành công nghệ kỳ cựu và nhà đầu tư mạo hiểm tại Hanabi Capital, đặt câu hỏi.

Các chuyên gia dự đoán, trong thời gian tới, sẽ có nhiều ứng dụng AI chất lượng cao được tạo ra bằng kỹ thuật "chưng cất".

Các nhà nghiên cứu tại Hugging Face, một công ty AI, đã bắt đầu thử nghiệm xây dựng một mô hình tương tự như của DeepSeek. "Điều dễ sao chép nhất là quy trình chưng cất," Lewis Tunstall, nhà nghiên cứu cấp cao tại Hugging Face, cho biết.

Ưu điểm và hạn chế của 'chưng cất' AI

"Chưng cất" AI mang lại nhiều lợi ích:

- Tiết kiệm chi phí: Giảm đáng kể chi phí huấn luyện và vận hành mô hình AI.

- Tăng tốc độ: Cho phép các ứng dụng AI chạy nhanh hơn trên các thiết bị có cấu hình thấp (như điện thoại, máy tính xách tay).

- Dân chủ hóa AI: Giúp các công ty nhỏ, các nhà phát triển độc lập có thể tiếp cận với công nghệ AI tiên tiến.

- Giảm khả năng: Mô hình "học sinh" thường không thể đạt được hiệu suất toàn diện như mô hình "giáo viên".

- Chuyên biệt hóa: Mô hình "chưng cất" thường chỉ giỏi trong một số tác vụ cụ thể mà nó được huấn luyện.

- Vấn đề bản quyền, đạo đức và trách nhiệm giải trình khi chưa rõ ràng về nguồn gốc

Tương lai của ngành AI: Mô hình lớn hay mô hình nhỏ?

Các mô hình AI từ OpenAI và Google vẫn đang dẫn đầu trên các bảng xếp hạng được sử dụng rộng rãi ở Thung lũng Silicon. Các "ông lớn" công nghệ có lợi thế trong việc thực hiện nghiên cứu gốc và phát triển các hệ thống tiên tiến nhất.

Tuy nhiên, nhiều người tiêu dùng và doanh nghiệp sẵn sàng sử dụng công nghệ kém hơn một chút nhưng có mức giá rẻ hơn rất nhiều.

Ahmed Awadallah từ Microsoft Research nhận định: "Chưng cất mang lại một sự đánh đổi thú vị. Khi bạn làm cho mô hình nhỏ hơn, không thể tránh khỏi việc giảm khả năng của nó."

Theo David Cox, Phó Chủ tịch phụ trách mô hình AI tại IBM Research, hầu hết các doanh nghiệp không cần đến các mô hình AI "khủng" để vận hành sản phẩm. Các mô hình "chưng cất" đã đủ mạnh để phục vụ các mục đích như chatbot dịch vụ khách hàng, hoặc hoạt động trên các thiết bị nhỏ.

"Bất cứ khi nào có thể giảm chi phí mà vẫn đạt được hiệu suất mong muốn, chẳng có lý do gì để không làm điều đó," Cox nói.

Kỹ thuật "chưng cất" AI đang mở ra một hướng đi mới cho ngành công nghiệp AI, cho phép các công ty nhỏ cạnh tranh với các "ông lớn" bằng cách tạo ra các mô hình AI hiệu quả, tiết kiệm chi phí. Tuy nhiên, việc sử dụng kỹ thuật này cũng đặt ra những câu hỏi về bản quyền, đạo đức và trách nhiệm giải trình, đòi hỏi các nhà phát triển, các nhà lập pháp và cộng đồng cần phải có những quy định và hướng dẫn rõ ràng.