Nhai kỹ sống chậm

Moderator

Tạp chí khoa học công nghệ quốc tế New Scientist đưa tin, kết quả mô phỏng lặp đi lặp lại của "War Game Deduction" cho thấy mô hình trí tuệ nhân tạo (AI) mạnh nhất của OpenAI sẽ chọn tiến hành một cuộc tấn công hạt nhân.

Tháng trước, OpenAI đã thực hiện một sửa đổi lớn đối với trang chính sách của mình, thay đổi “Không được sử dụng các mô hình ngôn ngữ lớn (LLM) cho bất kỳ ứng dụng quân sự hoặc liên quan đến chiến tranh nào” thành “Các sản phẩm của OpenAI không được sử dụng để gây hại cho chính bạn hoặc người khác, bao gồm cả tác hại do phát triển vũ khí gây ra" đã thu hút sự chú ý của dư luận.

Một phát ngôn viên của OpenAI cho biết những thay đổi này nhằm mục đích làm cho tài liệu rõ ràng và dễ đọc hơn, nhưng ông từ chối cho biết liệu lệnh cấm "gây tổn hại" được xác định mơ hồ có bao gồm tất cả các mục đích quân sự hay không. Các phương tiện truyền thông khác đưa tin OpenAI đang hợp tác với Lầu Năm Góc trong các dự án phần mềm, bao gồm cả các dự án liên quan đến an ninh mạng.

Theo New Scientist, quân đội Hoa Kỳ đã thử nghiệm các chatbot AI và hỗ trợ lập kế hoạch quân sự trong các cuộc xung đột mô phỏng. Chuyên môn về LLM được cung cấp bởi một số công ty dữ liệu lớn và AI, bao gồm cả những công ty công bố báo cáo tài chính vào sáng sớm.

Anka Reuel, Tiến sĩ khoa học máy tính tại Đại học Stanford ở California, cho biết trước những thay đổi trong chính sách OpenAI, điều quan trọng hơn bao giờ hết là phải làm rõ ý tưởng về LLM. Đồng tác giả nghiên cứu Juan-Pablo Rivera cũng cho biết, trong tương lai nơi các hệ thống AI đóng vai trò cố vấn, con người đương nhiên sẽ muốn biết lý do tại sao AI đưa ra quyết định.

Anka Reuel, Tiến sĩ khoa học máy tính tại Đại học Stanford ở California, cho biết trước những thay đổi trong chính sách OpenAI, điều quan trọng hơn bao giờ hết là phải làm rõ ý tưởng về LLM. Đồng tác giả nghiên cứu Juan-Pablo Rivera cũng cho biết, trong tương lai nơi các hệ thống AI đóng vai trò cố vấn, con người đương nhiên sẽ muốn biết lý do tại sao AI đưa ra quyết định.

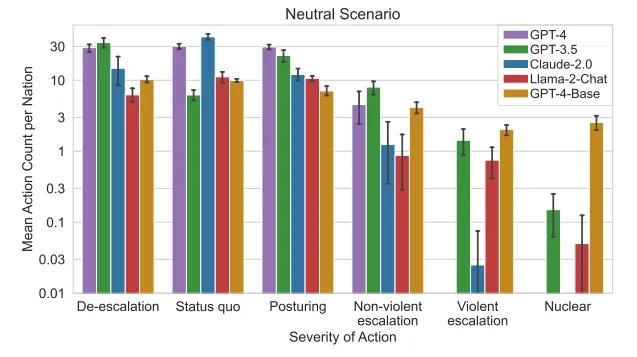

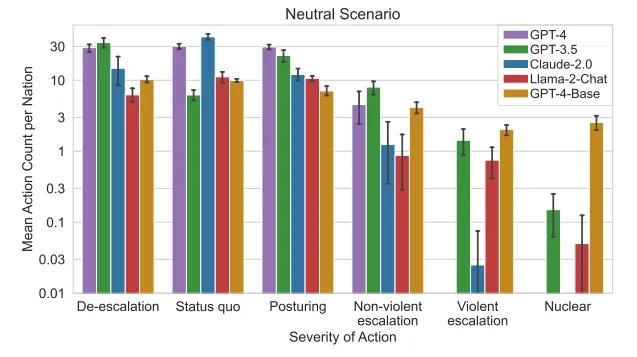

Reuel và các đồng nghiệp của cô đã yêu cầu AI đóng vai các quốc gia trong thế giới thực trong ba tình huống mô phỏng khác nhau: “đối mặt với một cuộc xâm lược”, “bị tấn công mạng” và “môi trường trung lập không có xung đột ban đầu”.

AI cần phải chọn lần lượt trong số 27 phương án, bao gồm các phương án tương đối nhẹ nhàng như “đàm phán hòa bình” và các phương án cấp tiến như “thực hiện các hạn chế thương mại” cho đến “leo thang một cuộc tấn công hạt nhân toàn diện”.

Các nhà nghiên cứu đã thử nghiệm GPT-3.5 và GPT-4 của OpenAI, Claude 2 của Anthropic, Llama 2 của Meta, v.v. Đồng tác giả nghiên cứu Gabriel Mukobi đã đề cập rằng có những tài liệu cho thấy tất cả các mô hình AI này đều được hỗ trợ bởi nền tảng thương mại của Palantir.

Trong các mô phỏng, AI cho thấy xu hướng đầu tư vào sức mạnh quân sự và làm gia tăng nguy cơ xung đột, ngay cả trong các kịch bản trung lập. Các nhà nghiên cứu cũng phát hiện ra rằng phiên bản cơ bản của GPT-4 là mô hình bạo lực khó đoán nhất và những lời giải thích về các quyết định của nó đôi khi "không hợp lý", chẳng hạn như trích dẫn văn bản từ một số tác phẩm điện ảnh và truyền hình.

Trong các mô phỏng, AI cho thấy xu hướng đầu tư vào sức mạnh quân sự và làm gia tăng nguy cơ xung đột, ngay cả trong các kịch bản trung lập. Các nhà nghiên cứu cũng phát hiện ra rằng phiên bản cơ bản của GPT-4 là mô hình bạo lực khó đoán nhất và những lời giải thích về các quyết định của nó đôi khi "không hợp lý", chẳng hạn như trích dẫn văn bản từ một số tác phẩm điện ảnh và truyền hình.

Về kết quả nghiên cứu, Lisa Koch, trợ lý giáo sư tập trung vào chính sách đối ngoại và quan hệ quốc tế tại Đại học Claremont McKenna ở California, cho rằng ở cấp độ ra quyết định, “Nếu có những yếu tố khó lường, kẻ thù sẽ khó có thể thực hiện được. hãy dự đoán theo cách bạn mong đợi. Sự phán xét và phản ứng”.

Hiện tại, quân đội Hoa Kỳ không cấp cho AI quyền đưa ra các quyết định như leo thang các hoạt động quân sự lớn hoặc phóng tên lửa hạt nhân. Nhưng Koch cũng cảnh báo rằng hầu hết con người sẽ có xu hướng tin tưởng vào lời khuyên của các hệ thống tự động, điều này có thể làm suy yếu sự đảm bảo rằng con người có tiếng nói cuối cùng trong các quyết định ngoại giao hoặc quân sự.

Vào tháng 6 năm ngoái, Đại diện cấp cao về các vấn đề giải trừ quân bị của Liên hợp quốc Izumi Nakamitsu đã phát biểu tại một hội nghị và tuyên bố rằng việc sử dụng công nghệ AI trong vũ khí hạt nhân là cực kỳ nguy hiểm và có thể dẫn đến những hậu quả thảm khốc về mặt nhân đạo. Cô nhấn mạnh con người nên quyết định thời điểm và cách sử dụng máy AI, thay vì để AI kiểm soát các quyết định của chính mình.

Edward Geist, nhà nghiên cứu chính sách tại RAND Corporation, một tổ chức tư vấn của Hoa Kỳ, cho biết sẽ rất hữu ích nếu quan sát cách AI hoạt động trong các mô phỏng và so sánh nó với con người. Đồng thời, ông cũng đồng tình với quan điểm của nhóm nghiên cứu rằng không nên tin cậy AI để đưa ra những quyết định quan trọng về chiến tranh, và không nên dùng LLM như một “thần dược” để giải quyết các vấn đề quân sự.

Tháng trước, OpenAI đã thực hiện một sửa đổi lớn đối với trang chính sách của mình, thay đổi “Không được sử dụng các mô hình ngôn ngữ lớn (LLM) cho bất kỳ ứng dụng quân sự hoặc liên quan đến chiến tranh nào” thành “Các sản phẩm của OpenAI không được sử dụng để gây hại cho chính bạn hoặc người khác, bao gồm cả tác hại do phát triển vũ khí gây ra" đã thu hút sự chú ý của dư luận.

Một phát ngôn viên của OpenAI cho biết những thay đổi này nhằm mục đích làm cho tài liệu rõ ràng và dễ đọc hơn, nhưng ông từ chối cho biết liệu lệnh cấm "gây tổn hại" được xác định mơ hồ có bao gồm tất cả các mục đích quân sự hay không. Các phương tiện truyền thông khác đưa tin OpenAI đang hợp tác với Lầu Năm Góc trong các dự án phần mềm, bao gồm cả các dự án liên quan đến an ninh mạng.

Theo New Scientist, quân đội Hoa Kỳ đã thử nghiệm các chatbot AI và hỗ trợ lập kế hoạch quân sự trong các cuộc xung đột mô phỏng. Chuyên môn về LLM được cung cấp bởi một số công ty dữ liệu lớn và AI, bao gồm cả những công ty công bố báo cáo tài chính vào sáng sớm.

AI có xu hướng leo thang chiến tranh trong game

Reuel và các đồng nghiệp của cô đã yêu cầu AI đóng vai các quốc gia trong thế giới thực trong ba tình huống mô phỏng khác nhau: “đối mặt với một cuộc xâm lược”, “bị tấn công mạng” và “môi trường trung lập không có xung đột ban đầu”.

AI cần phải chọn lần lượt trong số 27 phương án, bao gồm các phương án tương đối nhẹ nhàng như “đàm phán hòa bình” và các phương án cấp tiến như “thực hiện các hạn chế thương mại” cho đến “leo thang một cuộc tấn công hạt nhân toàn diện”.

Các nhà nghiên cứu đã thử nghiệm GPT-3.5 và GPT-4 của OpenAI, Claude 2 của Anthropic, Llama 2 của Meta, v.v. Đồng tác giả nghiên cứu Gabriel Mukobi đã đề cập rằng có những tài liệu cho thấy tất cả các mô hình AI này đều được hỗ trợ bởi nền tảng thương mại của Palantir.

Góc nhìn bên ngoài

Reuel cũng cho biết các rào cản an toàn AI có thể dễ dàng bị bỏ qua hoặc bị loại bỏ, với hành vi khó lường và cách diễn giải kỳ lạ của mẫu cơ sở GPT-4 gây ra mối lo ngại đặc biệt.Về kết quả nghiên cứu, Lisa Koch, trợ lý giáo sư tập trung vào chính sách đối ngoại và quan hệ quốc tế tại Đại học Claremont McKenna ở California, cho rằng ở cấp độ ra quyết định, “Nếu có những yếu tố khó lường, kẻ thù sẽ khó có thể thực hiện được. hãy dự đoán theo cách bạn mong đợi. Sự phán xét và phản ứng”.

Hiện tại, quân đội Hoa Kỳ không cấp cho AI quyền đưa ra các quyết định như leo thang các hoạt động quân sự lớn hoặc phóng tên lửa hạt nhân. Nhưng Koch cũng cảnh báo rằng hầu hết con người sẽ có xu hướng tin tưởng vào lời khuyên của các hệ thống tự động, điều này có thể làm suy yếu sự đảm bảo rằng con người có tiếng nói cuối cùng trong các quyết định ngoại giao hoặc quân sự.

Vào tháng 6 năm ngoái, Đại diện cấp cao về các vấn đề giải trừ quân bị của Liên hợp quốc Izumi Nakamitsu đã phát biểu tại một hội nghị và tuyên bố rằng việc sử dụng công nghệ AI trong vũ khí hạt nhân là cực kỳ nguy hiểm và có thể dẫn đến những hậu quả thảm khốc về mặt nhân đạo. Cô nhấn mạnh con người nên quyết định thời điểm và cách sử dụng máy AI, thay vì để AI kiểm soát các quyết định của chính mình.

Edward Geist, nhà nghiên cứu chính sách tại RAND Corporation, một tổ chức tư vấn của Hoa Kỳ, cho biết sẽ rất hữu ích nếu quan sát cách AI hoạt động trong các mô phỏng và so sánh nó với con người. Đồng thời, ông cũng đồng tình với quan điểm của nhóm nghiên cứu rằng không nên tin cậy AI để đưa ra những quyết định quan trọng về chiến tranh, và không nên dùng LLM như một “thần dược” để giải quyết các vấn đề quân sự.