A-Train The Seven

...'cause for once, I didn't hate myself.

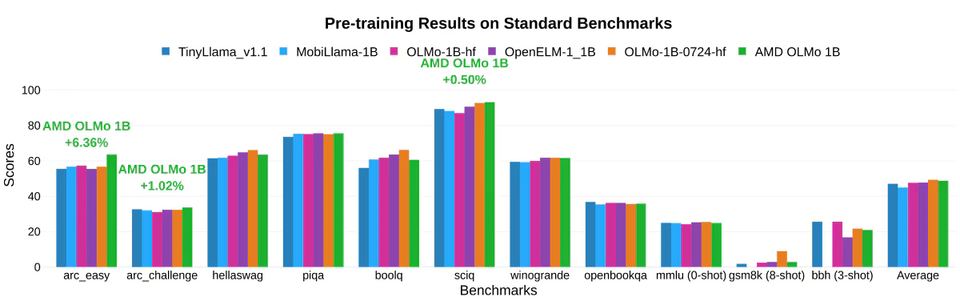

AMD vừa chính thức gia nhập cuộc đua AI với AMD OLMo, mô hình ngôn ngữ lớn (LLM) mã nguồn mở đầu tiên của hãng. Với 1 tỷ tham số, OLMo được huấn luyện trước trên GPU AMD Instinct MI250, hứa hẹn mang đến khả năng suy luận, tuân theo chỉ dẫn và tương tác trò chuyện vượt trội.

Việc mở mã nguồn OLMo, bao gồm dữ liệu, trọng số và quy trình huấn luyện, không chỉ củng cố vị thế của AMD trong lĩnh vực AI mà còn trao quyền cho khách hàng và cộng đồng phát triển. Các nhà phát triển có thể tự do sao chép, tùy chỉnh và phát triển dựa trên OLMo, mở ra tiềm năng đổi mới rộng lớn. Bên cạnh việc triển khai trong trung tâm dữ liệu, OLMo còn tương thích với máy tính cá nhân AMD Ryzen AI được trang bị bộ xử lý thần kinh (NPU), cho phép các nhà phát triển tận dụng sức mạnh AI ngay trên thiết bị cá nhân.

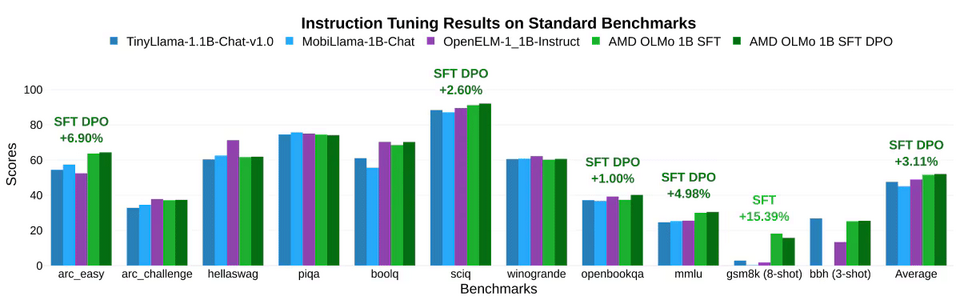

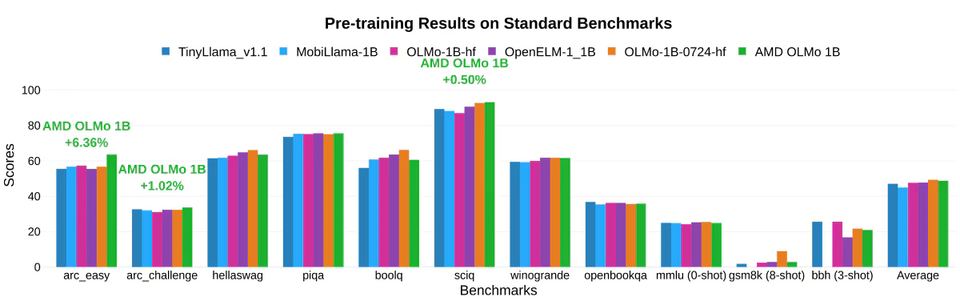

OLMo được huấn luyện trên tập dữ liệu khổng lồ 1,3 nghìn tỷ token, sử dụng 16 nodes, mỗi nodes gồm 4 GPU AMD Instinct MI250 (tổng cộng 64 GPU). Quá trình huấn luyện diễn ra theo ba bước:

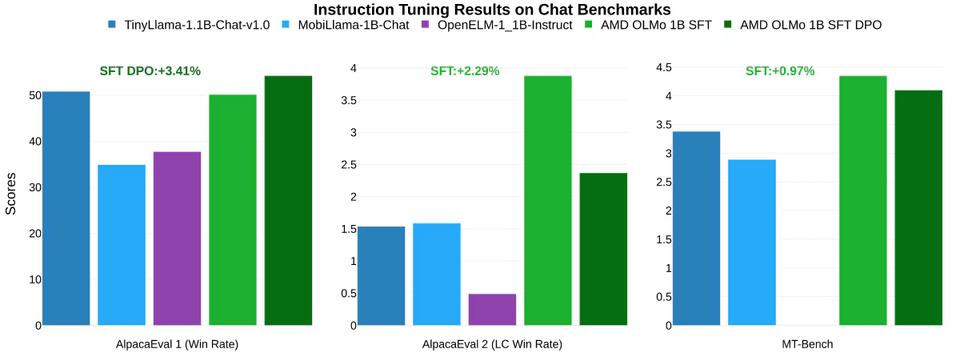

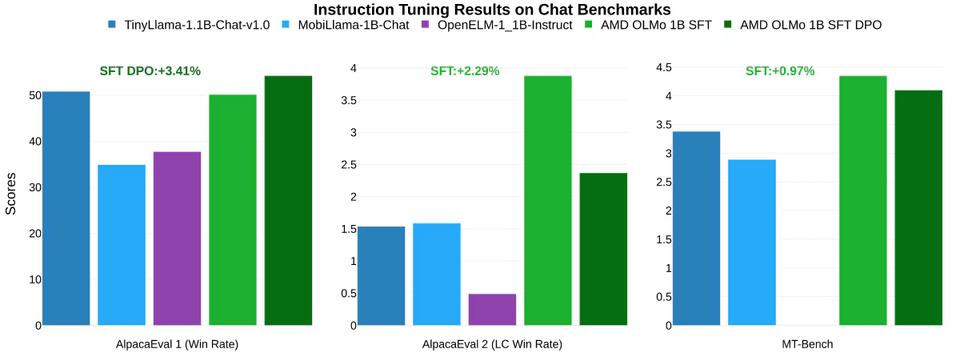

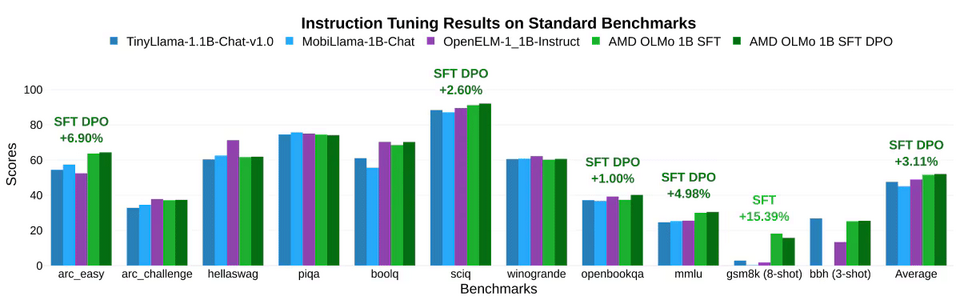

Trong các bài kiểm tra tuân theo chỉ dẫn như AlpacaEval 2, OLMo đạt tỷ lệ thắng cao hơn đối thủ với mức tăng +3,41% và +2,29%. Trong bài kiểm tra MT-Bench về khả năng trò chuyện, phiên bản SFT DPO đạt hiệu suất cao hơn đối thủ gần nhất 0,97%.

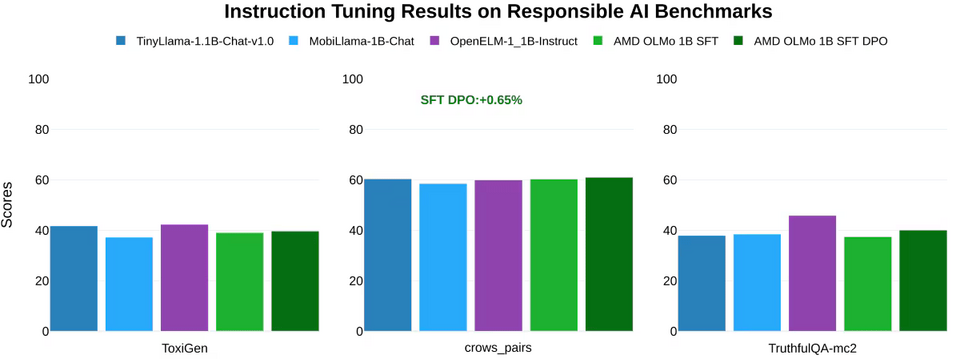

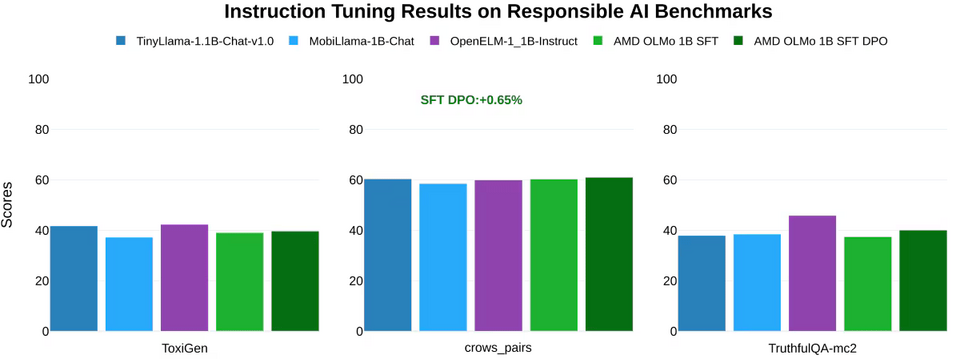

AMD cũng đã kiểm tra OLMo trên các tiêu chuẩn AI có trách nhiệm như ToxiGen (độc hại), crows_pairs (thiên lệch) và TruthfulQA-mc2 (trung thực). Kết quả cho thấy OLMo có hiệu quả tương đương với các mô hình khác trong việc xử lý các vấn đề đạo đức và trách nhiệm của AI. Với những kết quả ấn tượng này, AMD OLMo hứa hẹn sẽ là một đối thủ đáng gờm trong lĩnh vực mô hình ngôn ngữ lớn.

Việc mở mã nguồn OLMo, bao gồm dữ liệu, trọng số và quy trình huấn luyện, không chỉ củng cố vị thế của AMD trong lĩnh vực AI mà còn trao quyền cho khách hàng và cộng đồng phát triển. Các nhà phát triển có thể tự do sao chép, tùy chỉnh và phát triển dựa trên OLMo, mở ra tiềm năng đổi mới rộng lớn. Bên cạnh việc triển khai trong trung tâm dữ liệu, OLMo còn tương thích với máy tính cá nhân AMD Ryzen AI được trang bị bộ xử lý thần kinh (NPU), cho phép các nhà phát triển tận dụng sức mạnh AI ngay trên thiết bị cá nhân.

OLMo được huấn luyện trên tập dữ liệu khổng lồ 1,3 nghìn tỷ token, sử dụng 16 nodes, mỗi nodes gồm 4 GPU AMD Instinct MI250 (tổng cộng 64 GPU). Quá trình huấn luyện diễn ra theo ba bước:

- AMD OLMo 1B ban đầu: Huấn luyện trên một phần của Dolma v1.7, tập trung vào dự đoán token tiếp theo để nắm bắt các mẫu ngôn ngữ và kiến thức chung.

- Phiên bản Fine-tuned (SFT): Huấn luyện trên tập dữ liệu Tulu V2 ở giai đoạn đầu và các tập dữ liệu như OpenHermes-2.5, WebInstructSub, và Code-Feedback ở giai đoạn sau, nhằm cải thiện khả năng tuân theo chỉ dẫn và hiệu suất trong các tác vụ khoa học, lập trình và toán học.

- Phiên bản DPO (Direct Preference Optimization): Được tinh chỉnh dựa trên phản hồi của con người bằng tập dữ liệu UltraFeedback, giúp ưu tiên các kết quả phù hợp với mong muốn của người dùng.

Trong các bài kiểm tra tuân theo chỉ dẫn như AlpacaEval 2, OLMo đạt tỷ lệ thắng cao hơn đối thủ với mức tăng +3,41% và +2,29%. Trong bài kiểm tra MT-Bench về khả năng trò chuyện, phiên bản SFT DPO đạt hiệu suất cao hơn đối thủ gần nhất 0,97%.

AMD cũng đã kiểm tra OLMo trên các tiêu chuẩn AI có trách nhiệm như ToxiGen (độc hại), crows_pairs (thiên lệch) và TruthfulQA-mc2 (trung thực). Kết quả cho thấy OLMo có hiệu quả tương đương với các mô hình khác trong việc xử lý các vấn đề đạo đức và trách nhiệm của AI. Với những kết quả ấn tượng này, AMD OLMo hứa hẹn sẽ là một đối thủ đáng gờm trong lĩnh vực mô hình ngôn ngữ lớn.