Trương Quang

Writer

Nếu ngày mai các doanh nghiệp ở Việt Nam có thêm một lựa chọn GPU mạnh không kém NVIDIA để huấn luyện AI, điều gì sẽ thay đổi?

Điều thú vị là hệ thống của họ không hề lạ mắt hay thử nghiệm, nó giống như bất kỳ cụm doanh nghiệp thông thường nào, chỉ khác là không có linh kiện NVIDIA. Và đó cũng là thông điệp họ muốn gửi đi, rằng việc mở rộng AI không nhất thiết phải xoay quanh GPU của NVIDIA.

Zyphra đánh giá ZAYA1 có khả năng ngang bằng, thậm chí vượt một số mô hình mở quen thuộc trong các bài toán lập luận, toán học và xử lý mã. Với các doanh nghiệp đang gặp khó về nguồn cung hoặc chi phí GPU, đây là một lựa chọn hiếm mà không buộc phải đánh đổi hiệu suất.

Phần lớn tổ chức khi tính ngân sách cho AI đều xem dung lượng bộ nhớ và tốc độ truyền thông mới là yếu tố quyết định. GPU MI300X của AMD có 192GB bộ nhớ băng thông cao cho mỗi GPU, tạo không gian thử nghiệm thoải mái mà không cần vội phân chia song song quá mức. Điều này giúp các dự án giảm rủi ro và bớt thời gian tinh chỉnh.

Trong cấu trúc Zyphra sử dụng, mỗi nút gồm tám GPU MI300X kết nối bằng InfinityFabric và đi kèm một card mạng Pollara. Dữ liệu và điểm kiểm tra được xử lý qua một mạng riêng. Cách tổ chức đơn giản lại đem hiệu quả rõ rệt vì càng ít phức tạp thì chi phí chuyển mạch càng thấp và vòng lặp huấn luyện càng ổn định.

ZAYA1 có 8,3 tỷ tham số, trong đó 760 triệu được kích hoạt mỗi lần. Mô hình được huấn luyện với 12 nghìn tỷ token qua ba giai đoạn và tận dụng cơ chế định tuyến token tinh vi của kiến trúc MoE. Nhờ vậy, chỉ một phần mô hình chạy cùng lúc, vừa tiết kiệm bộ nhớ suy luận vừa giảm chi phí phục vụ.

Zyphra kết hợp hai bộ tối ưu Muon và AdamW. Họ phải tinh chỉnh lại kernel và giảm lưu lượng bộ nhớ để Muon phù hợp với phần cứng AMD. Kích thước lô được tăng dần, phụ thuộc hoàn toàn vào tốc độ pipeline lưu trữ trong việc phân phối token.

Kết quả là ZAYA1 có thể cạnh tranh với các mô hình nổi bật như Qwen3-4B, Gemma3-12B, Llama-3-8B và OLMoE. ZAYA1 còn đặc biệt hợp với những tình huống cần nhiều mô hình nhỏ tách biệt, ví dụ một ngân hàng muốn huấn luyện riêng từng lĩnh vực điều tra mà không cần song song hóa phức tạp ngay từ đầu.

InfinityFabric phát huy tốt nhất khi cả tám GPU cùng tham gia đồng thời và Pollara đạt thông lượng tối đa với các thông điệp lớn. Điều đó buộc Zyphra phải điều chỉnh thêm bộ đệm fusion. Với các bài toán ngữ cảnh dài từ 4k đến 32k token, họ phải dùng cơ chế chú ý vòng lặp và chú ý dạng cây để tránh nghẽn trong giai đoạn giải mã.

Lưu trữ cũng phải thiết kế lại. Mô hình nhỏ gây áp lực IOPS, mô hình lớn cần băng thông cao. Họ gom gọn các phân đoạn dữ liệu để hạn chế đọc phân tán và tăng bộ nhớ đệm trang nhằm rút ngắn thời gian khôi phục điểm kiểm tra.

Trong quá trình huấn luyện kéo dài nhiều tuần, sự cố gần như là điều chắc chắn. Hệ thống Aegis của Zyphra giám sát lỗi phần cứng, tự động sửa lỗi đơn giản và tăng thời gian chờ RCCL để tránh gián đoạn mạng phá vỡ toàn bộ tác vụ. Điểm kiểm tra được phân bổ đều trên GPU thay vì dồn qua một điểm nghẽn, giúp tăng tốc độ lưu lên gấp mười lần.

Không có lời khuyên rằng doanh nghiệp nên bỏ hẳn NVIDIA. Một hướng thực tế hơn là tiếp tục dùng NVIDIA cho sản xuất và dùng AMD cho giai đoạn cần nhiều bộ nhớ hoặc môi trường linh hoạt hơn của ROCm. Sự kết hợp này vừa phân tán rủi ro, vừa tăng tổng khối lượng huấn luyện mà không làm gián đoạn hệ thống hiện tại.

Zyphra đưa ra một số kinh nghiệm đúc kết. Hãy xem hình dạng mô hình là yếu tố có thể điều chỉnh. Thiết kế mạng dựa trên kiểu giao tiếp mô hình thực sự sử dụng. Tăng khả năng chịu lỗi để không lãng phí giờ GPU. Và hiện đại hóa cơ chế điểm kiểm tra để không cản trở tiến độ huấn luyện.

Những gì họ trình bày không phải là tuyên bố hay ưu tiên bên nào, mà chỉ là bản mô tả thực tế về những gì họ đã học được khi xây dựng một mô hình MoE lớn trên GPU AMD. Với nhiều tổ chức đang tìm cách mở rộng AI vượt khỏi một nhà cung cấp duy nhất, đây có thể xem là một bản hướng dẫn hữu ích. (artificialintelligence)

Đọc chi tiết tại đây: https://www.artificialintelligence-...l-using-amd-gpus-for-training-hits-milestone/

Một cách tiếp cận khác để mở rộng AI

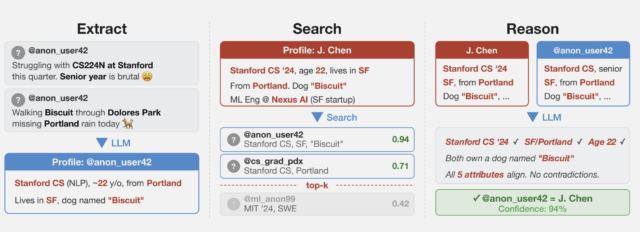

Zyphra, AMD và IBM dành trọn một năm chỉ để trả lời một câu hỏi đơn giản, nhưng có ý nghĩa rất lớn: liệu GPU AMD có thể huấn luyện được mô hình AI quy mô thật sự lớn hay không. Kết quả chính là ZAYA1, mô hình Hỗn hợp chuyên gia (MoE) đầu tiên được xây dựng hoàn toàn từ GPU AMD, mạng AMD và chạy trên hạ tầng IBM Cloud.Điều thú vị là hệ thống của họ không hề lạ mắt hay thử nghiệm, nó giống như bất kỳ cụm doanh nghiệp thông thường nào, chỉ khác là không có linh kiện NVIDIA. Và đó cũng là thông điệp họ muốn gửi đi, rằng việc mở rộng AI không nhất thiết phải xoay quanh GPU của NVIDIA.

Zyphra đánh giá ZAYA1 có khả năng ngang bằng, thậm chí vượt một số mô hình mở quen thuộc trong các bài toán lập luận, toán học và xử lý mã. Với các doanh nghiệp đang gặp khó về nguồn cung hoặc chi phí GPU, đây là một lựa chọn hiếm mà không buộc phải đánh đổi hiệu suất.

Phần lớn tổ chức khi tính ngân sách cho AI đều xem dung lượng bộ nhớ và tốc độ truyền thông mới là yếu tố quyết định. GPU MI300X của AMD có 192GB bộ nhớ băng thông cao cho mỗi GPU, tạo không gian thử nghiệm thoải mái mà không cần vội phân chia song song quá mức. Điều này giúp các dự án giảm rủi ro và bớt thời gian tinh chỉnh.

Trong cấu trúc Zyphra sử dụng, mỗi nút gồm tám GPU MI300X kết nối bằng InfinityFabric và đi kèm một card mạng Pollara. Dữ liệu và điểm kiểm tra được xử lý qua một mạng riêng. Cách tổ chức đơn giản lại đem hiệu quả rõ rệt vì càng ít phức tạp thì chi phí chuyển mạch càng thấp và vòng lặp huấn luyện càng ổn định.

ZAYA1 có 8,3 tỷ tham số, trong đó 760 triệu được kích hoạt mỗi lần. Mô hình được huấn luyện với 12 nghìn tỷ token qua ba giai đoạn và tận dụng cơ chế định tuyến token tinh vi của kiến trúc MoE. Nhờ vậy, chỉ một phần mô hình chạy cùng lúc, vừa tiết kiệm bộ nhớ suy luận vừa giảm chi phí phục vụ.

Zyphra kết hợp hai bộ tối ưu Muon và AdamW. Họ phải tinh chỉnh lại kernel và giảm lưu lượng bộ nhớ để Muon phù hợp với phần cứng AMD. Kích thước lô được tăng dần, phụ thuộc hoàn toàn vào tốc độ pipeline lưu trữ trong việc phân phối token.

Kết quả là ZAYA1 có thể cạnh tranh với các mô hình nổi bật như Qwen3-4B, Gemma3-12B, Llama-3-8B và OLMoE. ZAYA1 còn đặc biệt hợp với những tình huống cần nhiều mô hình nhỏ tách biệt, ví dụ một ngân hàng muốn huấn luyện riêng từng lĩnh vực điều tra mà không cần song song hóa phức tạp ngay từ đầu.

Những chỉnh sửa cần thiết để ROCm hoạt động trơn tru

Zyphra thừa nhận việc chuyển toàn bộ quy trình vốn xây trên NVIDIA sang ROCm không hề dễ. Thay vì đổi “nguyên khối”, họ đo lại năng lực phần cứng AMD và điều chỉnh kích thước mô hình, GEMM và microbatch cho phù hợp với đặc tính tính toán của MI300X.InfinityFabric phát huy tốt nhất khi cả tám GPU cùng tham gia đồng thời và Pollara đạt thông lượng tối đa với các thông điệp lớn. Điều đó buộc Zyphra phải điều chỉnh thêm bộ đệm fusion. Với các bài toán ngữ cảnh dài từ 4k đến 32k token, họ phải dùng cơ chế chú ý vòng lặp và chú ý dạng cây để tránh nghẽn trong giai đoạn giải mã.

Lưu trữ cũng phải thiết kế lại. Mô hình nhỏ gây áp lực IOPS, mô hình lớn cần băng thông cao. Họ gom gọn các phân đoạn dữ liệu để hạn chế đọc phân tán và tăng bộ nhớ đệm trang nhằm rút ngắn thời gian khôi phục điểm kiểm tra.

Trong quá trình huấn luyện kéo dài nhiều tuần, sự cố gần như là điều chắc chắn. Hệ thống Aegis của Zyphra giám sát lỗi phần cứng, tự động sửa lỗi đơn giản và tăng thời gian chờ RCCL để tránh gián đoạn mạng phá vỡ toàn bộ tác vụ. Điểm kiểm tra được phân bổ đều trên GPU thay vì dồn qua một điểm nghẽn, giúp tăng tốc độ lưu lên gấp mười lần.

Ý nghĩa thực tế với chiến lược mua sắm AI

Báo cáo so sánh rất rõ hệ sinh thái NVIDIA và AMD, từ NVLINK và InfinityFabric đến NCCL và RCCL. Thông điệp là hệ sinh thái AMD nay đã đủ trưởng thành để phát triển mô hình AI lớn một cách nghiêm túc.Không có lời khuyên rằng doanh nghiệp nên bỏ hẳn NVIDIA. Một hướng thực tế hơn là tiếp tục dùng NVIDIA cho sản xuất và dùng AMD cho giai đoạn cần nhiều bộ nhớ hoặc môi trường linh hoạt hơn của ROCm. Sự kết hợp này vừa phân tán rủi ro, vừa tăng tổng khối lượng huấn luyện mà không làm gián đoạn hệ thống hiện tại.

Zyphra đưa ra một số kinh nghiệm đúc kết. Hãy xem hình dạng mô hình là yếu tố có thể điều chỉnh. Thiết kế mạng dựa trên kiểu giao tiếp mô hình thực sự sử dụng. Tăng khả năng chịu lỗi để không lãng phí giờ GPU. Và hiện đại hóa cơ chế điểm kiểm tra để không cản trở tiến độ huấn luyện.

Những gì họ trình bày không phải là tuyên bố hay ưu tiên bên nào, mà chỉ là bản mô tả thực tế về những gì họ đã học được khi xây dựng một mô hình MoE lớn trên GPU AMD. Với nhiều tổ chức đang tìm cách mở rộng AI vượt khỏi một nhà cung cấp duy nhất, đây có thể xem là một bản hướng dẫn hữu ích. (artificialintelligence)

Đọc chi tiết tại đây: https://www.artificialintelligence-...l-using-amd-gpus-for-training-hits-milestone/