Mạnh Quân

Writer

Sự cạnh tranh trong thị trường chip AI không còn chỉ giới hạn ở GPU nữa.

Theo dữ liệu của TrendForce, dựa trên tốc độ tăng trưởng của lượng xuất xưởng máy chủ AI, dự kiến đến năm 2026, các chip ASIC tùy chỉnh của các nhà cung cấp dịch vụ đám mây sẽ chiếm một phần đáng kể trên thị trường.Dự kiến lượng hàng xuất xưởng sẽ tăng 44,6%, trong khi lượng hàng xuất xưởng GPU dự kiến sẽ tăng 16,1%. Điều này báo hiệu sự thay đổi trong lĩnh vực phần cứng AI khi các nhà điều hành trung tâm dữ liệu siêu quy mô tăng cường đầu tư vào việc phát triển chip riêng của họ.

Những nhà sản xuất chip AI hàng đầu là ai?

1. NvidiaTừ những năm 1990, NVIDIA đã tập trung vào thiết kế bộ xử lý đồ họa (GPU) cho ngành công nghiệp game. NVIDIA là nhà sản xuất chip không sở hữu nhà máy sản xuất riêng, mà thuê ngoài hầu hết quá trình sản xuất chip cho TSMC. Các lĩnh vực kinh doanh chính của hãng bao gồm:

Giải pháp AI trên máy tính để bàn

DGX Spark (trước đây là Project Digits) là một siêu máy tính AI để bàn được thiết kế dành cho các kỹ sư AI và nhà khoa học dữ liệu. Nó có các đặc điểm sau: chi phí ước tính khoảng 3.000 đô la; kích thước tương tự như một chiếc Mac mini; chip siêu mạnh NVIDIA GB10 Grace Blackwell; 128GB RAM; khả năng xử lý suy luận và tinh chỉnh mô hình LLM với tối đa 200 tỷ tham số; và giao tiếp CPU+GPU tốc độ cao thông qua NVLink-C2C.

Giải pháp trung tâm dữ liệu

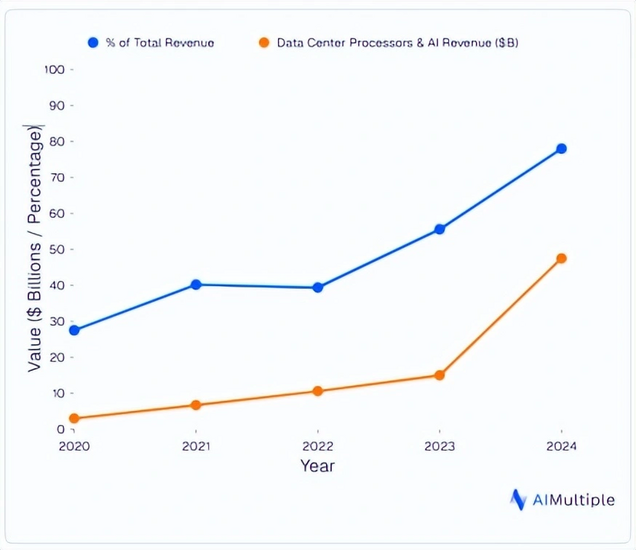

Công ty này sản xuất chip AI dựa trên các kiến trúc Ampere, Hopper và Blackwell mới nhất. Nhờ sự phát triển bùng nổ của trí tuệ nhân tạo tạo sinh (generative AI), Nvidia đã đạt được những kết quả đáng kể trong những năm gần đây, vượt qua mốc vốn hóa thị trường một nghìn tỷ đô la và củng cố vị thế dẫn đầu trong thị trường phần cứng GPU và AI. Biểu đồ dưới đây minh họa sự tăng trưởng doanh thu hàng năm của Nvidia trong lĩnh vực này và cách nó trở thành nguồn doanh thu chính của công ty.

Các chipset của NVIDIA được thiết kế để giải quyết các thách thức kinh doanh trong nhiều ngành công nghiệp khác nhau. DGX A100 và H100 là những chip AI hàng đầu thành công của NVIDIA, được thiết kế đặc biệt cho việc huấn luyện và suy luận AI trong các trung tâm dữ liệu. Sau đó, NVIDIA đã ra mắt các chip H200, B300 và GB300. Ví dụ, các máy chủ HGX như HGX H200 và HGX B300 tích hợp tám chip này. Dòng NVL và GB200 SuperPod thậm chí còn tích hợp nhiều chip hơn vào các cụm chip lớn hơn.

GPU đám mây

Nhờ sức mạnh của các sản phẩm trung tâm dữ liệu, NVIDIA gần như độc chiếm thị trường AI đám mây, với hầu hết các nhà cung cấp dịch vụ đám mây chỉ cung cấp GPU của NVIDIA làm GPU đám mây.

NVIDIA cũng cho ra mắt sản phẩm DGX Cloud, cung cấp cơ sở hạ tầng GPU đám mây trực tiếp cho các doanh nghiệp, bỏ qua các nhà cung cấp dịch vụ đám mây.

GPU dùng để xử lý đồ họa

Xbox sử dụng bộ vi xử lý được phát triển chung bởi NVIDIA và Microsoft. Các GPU của NVIDIA dành cho người dùng bán lẻ bao gồm dòng GeForce.

DGX Cloud Lepton

Vào ngày 19 tháng 5 năm 2025, tại Computex Taipei, NVIDIA đã ra mắt DGX Cloud Lepton, một nền tảng kết nối các nhà phát triển AI với các nhà cung cấp dịch vụ đám mây GPU của NVIDIA như CoreWeave, Lambda và Crusoe. Nền tảng này cung cấp khả năng truy cập linh hoạt vào tài nguyên GPU để huấn luyện và suy luận mô hình AI, loại bỏ sự phụ thuộc vào các nhà cung cấp dịch vụ đám mây truyền thống. Điều này càng củng cố thêm chiến lược đám mây hướng đến doanh nghiệp của NVIDIA.

NVIDIA Dynamo

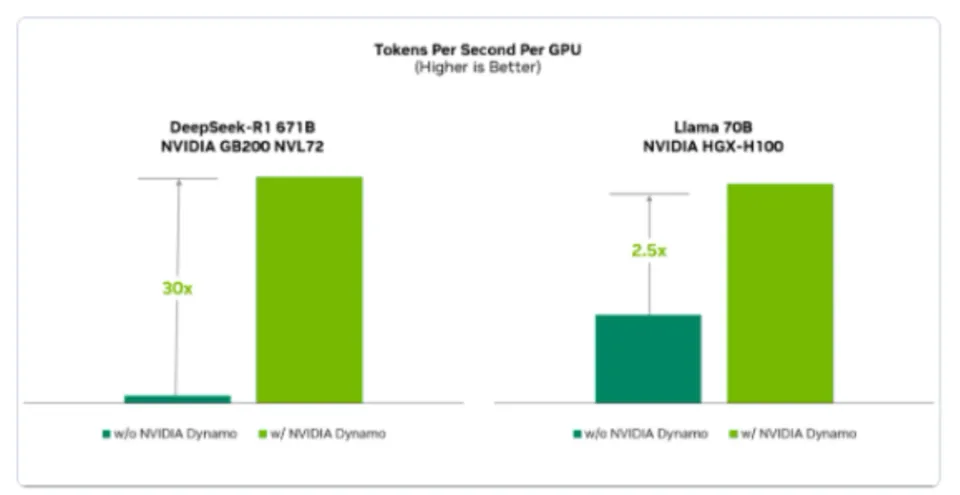

Ra mắt tại GTC 2025, NVIDIA Dynamo là một khung suy luận mã nguồn mở mới được thiết kế để triển khai các mô hình AI tạo sinh với thông lượng cao và độ trễ thấp trong môi trường phân tán. Như hình minh họa, nó có thể cải thiện tốc độ xử lý yêu cầu lên đến 30 lần trên nền tảng NVIDIA Blackwell. Khung này tương thích với các công cụ phổ biến như PyTorch và TensorRT-LLM, và tận dụng các công nghệ tiên tiến như tách rời giai đoạn suy luận và lập lịch GPU động để tối ưu hóa hiệu suất và giảm chi phí. Dynamo có sẵn cho các nhà phát triển trên GitHub và được tích hợp vào các dịch vụ vi mô NVIDIA NIM cho các giải pháp doanh nghiệp. Dynamo cho phép các dịch vụ AI tạo sinh có khả năng mở rộng và tiết kiệm chi phí từ hệ thống GPU đơn đến đa GPU.

NVIDIA Dynamo cải thiện đáng kể hiệu năng của mô hình AI. Cụ thể, trên nền tảng NVIDIA GB200 NVL72, nó tăng tốc mô hình DeepSeek-R1 671B lên 30 lần. Khi sử dụng GPU NVIDIA Hopper, nó cũng tăng hiệu năng của mô hình Llama 70B lên hơn gấp đôi.

Máy chủ NVIDIA RTX PRO và các nhà máy AI cấp doanh nghiệp

Vào tháng 5 năm 2025 tại Computex Taipei, NVIDIA đã công bố RTX PRO Server, với GPU RTX PRO 6000 Blackwell Server Edition, được thiết kế đặc biệt cho các nhà máy AI cấp doanh nghiệp. Các máy chủ này cung cấp khả năng tăng tốc tổng quát cho các ứng dụng AI, thiết kế, kỹ thuật và kinh doanh, hỗ trợ các khối lượng công việc như suy luận AI đa phương thức, AI vật lý và mô hình song sinh kỹ thuật số trên nền tảng NVIDIA Omniverse.

Thiết kế đã được NVIDIA kiểm chứng cho một nhà máy AI cấp doanh nghiệp tích hợp máy chủ RTX PRO, NVIDIA Spectrum-X Ethernet , NVIDIA BlueField DPU và phần mềm NVIDIA AI Enterprise, cho phép các đối tác như Cadence, Foxconn và Eli Lilly xây dựng cơ sở hạ tầng AI tại chỗ. Sáng kiến này thúc đẩy quá trình chuyển đổi của ngành công nghệ thông tin trị giá hàng nghìn tỷ đô la hướng tới các nhà máy AI được tăng tốc bằng GPU.

2. AMD

Tháng 6 năm 2023, AMD ra mắt bộ xử lý MI300 dành cho các tác vụ huấn luyện AI, cạnh tranh với NVIDIA để giành thị phần. Sự trỗi dậy của AI tạo sinh đã dẫn đến sự tăng trưởng nhanh chóng về nhu cầu, khiến việc mua được phần cứng AI của NVIDIA trở nên khó khăn. Kết quả là, nhiều công ty khởi nghiệp, viện nghiên cứu, doanh nghiệp và các ông lớn công nghệ đã áp dụng phần cứng của AMD vào năm 2023. Năm 2025, AMD thông báo mua lại đội ngũ kỹ sư phần cứng và phần mềm AI của Untether AI. Untether AI là một công ty phát triển chip suy luận AI tiết kiệm năng lượng dành cho các nhà cung cấp điện toán biên và trung tâm dữ liệu doanh nghiệp. Động thái này đã tăng cường khả năng biên dịch AI, phát triển nhân và thiết kế chip của AMD, củng cố hơn nữa vị thế của hãng trên thị trường suy luận. Ngoài ra, AMD cũng mua lại công ty khởi nghiệp về trình biên dịch Brium, nhằm mục đích tối ưu hóa hiệu năng AI của GPU trung tâm dữ liệu Instinct trong các ứng dụng doanh nghiệp.

Các card đồ họa dòng MI350 của AMD thay thế dòng MI300 và cạnh tranh với dòng H200 của NVIDIA. AMD cũng đang hợp tác với các công ty về học máy như Hugging Face để giúp các nhà khoa học dữ liệu sử dụng phần cứng của mình hiệu quả hơn.

Hệ sinh thái phần mềm đóng vai trò rất quan trọng vì hiệu năng phần cứng phụ thuộc phần lớn vào việc tối ưu hóa phần mềm. Ví dụ, AMD và NVIDIA đã công khai tranh luận về hiệu năng giữa H100 và MI300. Cuộc tranh luận tập trung vào các gói phần mềm và các loại phép toán dấu phẩy động được sử dụng trong các bài kiểm tra hiệu năng. Theo kết quả kiểm tra hiệu năng mới nhất, hiệu năng suy luận của MI300 trên 70B LLM dường như vượt trội hơn hoặc tương đương với H100.

Mặc dù phần cứng của AMD đang bắt kịp NVIDIA, phần mềm của hãng lại tụt hậu về tính dễ sử dụng. Trong khi CUDA có thể sử dụng ngay sau khi cài đặt và đáp ứng được hầu hết các tác vụ, phần mềm của AMD lại yêu cầu cấu hình đáng kể.

3. Intel

Intel là nhà sản xuất quan trọng nhất trên thị trường CPU, với lịch sử lâu đời trong nghiên cứu và phát triển chất bán dẫn. Không giống như Nvidia và AMD, Intel sử dụng các nhà máy sản xuất chip riêng của mình. Gaudi3 là bộ xử lý tăng tốc AI mới nhất của Intel. Tuy nhiên, Intel dự kiến Gaudi3 sẽ tạo ra doanh thu khoảng 500 triệu đô la vào năm 2024, thấp hơn nhiều so với doanh thu hàng tỷ đô la mà AMD dự kiến cho năm 2024.

4. AWS

AWS sản xuất chip Tranium để huấn luyện mô hình và chip Inferentia để suy luận. Mặc dù AWS là công ty dẫn đầu thị trường điện toán đám mây công cộng, nhưng họ bắt đầu phát triển chip riêng của mình sau Google.

Hàng trăm nghìn chip Tranium2 được sử dụng để tạo thành cụm máy tính Project Rainier, nguồn năng lượng cho mô hình của nhà phát triển LLM, Anthropic.

5. Nền tảng đám mây Google

Google Cloud TPU là một chip tăng tốc được thiết kế đặc biệt cho học máy, cung cấp sức mạnh cho các sản phẩm của Google như Dịch thuật, Ảnh, Tìm kiếm, Trợ lý Google và Gmail. Nó cũng có thể được sử dụng thông qua Google Cloud. Google đã ra mắt TPU vào năm 2016. Trillium TPU mới nhất là sản phẩm thế hệ thứ sáu.

Google vừa cho ra mắt Ironwood. Thế hệ sản phẩm mới nhất này được thiết kế cho các "mô hình tư duy" phức tạp như LLM và MoE, cung cấp khả năng xử lý song song mạnh mẽ (4.614 TFLOPs mỗi chip) và có thể mở rộng lên đến 42,5 Exaflops trong một cụm 9.216 chip.

Ironwood mang lại những cải tiến đáng kể so với Trillium, bao gồm: hiệu suất năng lượng tốt hơn gấp 2 lần, dung lượng bộ nhớ băng thông cao gấp 6 lần (192 GB/chip), băng thông HBM gấp 4,5 lần (7,2 TB/s/chip) và tốc độ kết nối giữa các chip nhanh hơn 1,5 lần (1,2 Tbps). Nó cũng tích hợp SparseCore được nâng cao để hỗ trợ các ứng dụng nhúng quy mô lớn. Hơn nữa, Google sản xuất các Edge TPU nhỏ hơn để đáp ứng nhu cầu ứng dụng đa dạng, được thiết kế đặc biệt cho các thiết bị biên như điện thoại thông minh và phần cứng IoT.

6. Alibaba

Alibaba sản xuất các chip dùng cho suy luận, chẳng hạn như Hanguang 800.

7. IBM

Năm 2022, IBM cho ra mắt chip học sâu mới nhất của mình – Bộ xử lý trí tuệ nhân tạo (AIU). IBM đang xem xét sử dụng các chip này để cung cấp sức mạnh cho nền tảng trí tuệ nhân tạo tạo sinh Watson.x. AIU được xây dựng trên bộ xử lý IBM Telum, cung cấp khả năng xử lý AI cho các máy chủ mainframe IBM Z.

8. Groq

Groq được thành lập bởi một số cựu nhân viên của Google. Công ty chủ yếu kinh doanh các thiết bị xử lý dữ liệu dạng lỏng (LPU).(Mô-đun công suất thấp) Đây là kiến trúc chip AI mới được thiết kế để giúp các doanh nghiệp triển khai hệ thống của họ dễ dàng hơn. Công ty khởi nghiệp này đã huy động được khoảng 350 triệu đô la vốn đầu tư và ra mắt các sản phẩm đầu tiên, chẳng hạn như bộ xử lý GroqChip và bộ tăng tốc GroqCard. Công ty tập trung vào suy luận LLM và đã công bố kết quả đánh giá hiệu năng cho Llama-2 70B.

9. Hệ thống SambaNova

Được thành lập vào năm 2017, SambaNova Systems phát triển các hệ thống phần cứng và phần mềm hiệu năng cao, độ chính xác cao cho các khối lượng công việc AI tạo sinh khổng lồ. Công ty đã phát triển chip SN40L và huy động được hơn 1,1 tỷ đô la vốn đầu tư. Đặc biệt, SambaNova Systems cũng cho thuê nền tảng của mình cho các doanh nghiệp. Mô hình Nền tảng AI dưới dạng dịch vụ (AI Platform-as-a-Service) của SambaNova Systems giúp các hệ thống của họ dễ tiếp cận hơn và khuyến khích việc tái sử dụng phần cứng, từ đó thúc đẩy nền kinh tế tuần hoàn.

10. Não bộ

Được thành lập vào năm 2015, Cerebras là công ty duy nhất tập trung vào chip cấp độ wafer.Các nhà sản xuất chip lớn. So với GPU, chip cấp wafer có ưu điểm trong xử lý song song nhờ băng thông bộ nhớ cao hơn. Tuy nhiên, thiết kế và sản xuất các chip này vẫn là một công nghệ mới nổi.

Các chip Cerebras bao gồm:

- WSE-1 có 1,2 nghìn tỷ bóng bán dẫn và 400.000 lõi xử lý.

- Bộ vi xử lý WSE-2, với 2,6 nghìn tỷ bóng bán dẫn và 850.000 lõi, được ra mắt vào tháng 4 năm 2021. Nó sử dụng quy trình 7 nanomet của TSMC.

- Bộ vi xử lý WSE-3, với 4 nghìn tỷ bóng bán dẫn và 900.000 lõi AI, đã được ra mắt vào tháng 3 năm 2024. Nó sử dụng quy trình 5nm của TSMC.

Cerebras cũng cung cấp chip cho các doanh nghiệp thông qua nền tảng đám mây của mình.

11.d-Ma trận

d-Matrix sử dụng một phương pháp mới, từ bỏ kiến trúc von Neumann truyền thống và thay vào đó sử dụng điện toán trong bộ nhớ.Mặc dù phương pháp này có tiềm năng giải quyết được nút thắt cổ chai giữa bộ nhớ và khả năng tính toán, nhưng đây là một phương pháp hoàn toàn mới và chưa được kiểm chứng.

12. Rebellions

Một công ty khởi nghiệp của Hàn Quốc tập trung vào suy luận LLM đã huy động được 124 triệu đô la vào năm 2024. Rebellions đã sáp nhập với một công ty thiết kế bán dẫn khác của Hàn Quốc, SAPEON, và vào tháng 7 năm 2025, họ nhận được đầu tư từ gã khổng lồ công nghệ Samsung trong một vòng gọi vốn nhắm mục tiêu lên tới 200 triệu đô la trước khi lên kế hoạch phát hành cổ phiếu lần đầu ra công chúng (IPO). Công ty đã huy động được 220 triệu đô la kể từ khi thành lập vào năm 2020 và đang hợp tác với Samsung để đưa chip thế hệ thứ hai của mình, Rebel-Quad (bao gồm bốn chip AI Rebel), ra thị trường vào cuối năm 2025, được sản xuất bằng quy trình 4 nanomet của Samsung.

13. Tenstorrent

Tenstorrent sản xuất chip Wormhole, máy tính để bàn cho các nhà nghiên cứu và máy chủ sử dụng chip Wormhole (như Tenstorrent Galaxy). Công ty cũng cung cấp bộ phần mềm cần thiết cho các giải pháp của mình. Vào tháng 12 năm 2024, Tenstorrent đã huy động được 700 triệu đô la từ các nhà đầu tư, trong đó có Jeff Bezos, định giá công ty ở mức hơn 2,6 tỷ đô la.

14. Eetched

Eetched hy sinh tính linh hoạt để đổi lấy hiệu quả bằng cách lập trình trực tiếp kiến trúc máy biến áp vào chip. Eetched tuyên bố đã phát triển mạch tích hợp chuyên dụng (ASIC) đầu tiên trên thế giới dành cho máy biến áp.

15. Extropic

Extropic đã hoàn thành vòng gọi vốn trị giá 14 triệu đô la vào cuối năm 2023, với mục tiêu tận dụng nhiệt động lực học cho tính toán. Công ty này vẫn chưa tung ra bất kỳ chip nào.

16. Vaire

Vaire là một công ty khởi nghiệp có trụ sở tại Anh, tập trung vào điện toán đảo ngược .Nghiên cứu tiên phong này là một phần của điện toán thuận nghịch, một phương pháp đổi mới nhằm tạo ra các chip có mức tiêu thụ năng lượng gần bằng không. Không giống như điện toán truyền thống, nơi năng lượng bị tiêu hao dưới dạng nhiệt, điện toán thuận nghịch có thể thu hồi và tái sử dụng một phần đáng kể năng lượng cho các phép tính tiếp theo.

Vaire đã trình diễn một chip thử nghiệm có khả năng thu hồi 50% năng lượng, chứng minh tiềm năng của công nghệ này trong việc giảm tiêu thụ năng lượng cho các tác vụ AI và khắc phục những hạn chế vật lý (ví dụ: rào cản nhiệt) mà ngành sản xuất chất bán dẫn hiện đại đang gặp phải.

17. Apple

Dự án ACDC của Apple được cho là tập trung vào việc phát triển chip cho suy luận trí tuệ nhân tạo. Apple vốn đã là một công ty thiết kế chip hàng đầu, và các chất bán dẫn do chính hãng thiết kế được sử dụng trong các sản phẩm như iPhone, iPad và MacBook.

18. Meta

Bộ xử lý tăng tốc huấn luyện và suy luận Meta (MTIA) là một dòng bộ xử lý được sử dụng cho các tác vụ trí tuệ nhân tạo, chẳng hạn như huấn luyện các mô hình LLaMa của Meta. Mô hình mới nhất là MTIA thế hệ tiếp theo, dựa trên quy trình 5nm của TSMC, và được cho là mang lại hiệu năng cao gấp 3 lần so với MTIA v1. Các MTIA sẽ được đặt trong các giá đỡ có thể chứa tối đa 72 bộ tăng tốc. Hiện tại, MTIA chỉ được sử dụng nội bộ tại Meta. Tuy nhiên, trong tương lai, nếu Meta ra mắt các sản phẩm trí tuệ nhân tạo tạo sinh cấp doanh nghiệp dựa trên LLaMa, những chip này có thể cung cấp sức mạnh cho các sản phẩm đó.

19. Microsoft Azure

Tại hội nghị Hot Chips 2024, Microsoft đã công bố Maia 100, bộ tăng tốc AI tùy chỉnh đầu tiên của hãng, được thiết kế để tăng cường hiệu năng cho các khối lượng công việc AI quy mô lớn trên nền tảng Azure thông qua tối ưu hóa đồng thời phần cứng và phần mềm. Maia 100 sử dụng quy trình N5 của TSMC và tích hợp các công nghệ bộ nhớ và kết nối tiên tiến, nhằm mục tiêu đạt được thông lượng cao và hỗ trợ nhiều định dạng dữ liệu khác nhau. Bộ SDK của nó cung cấp cho các nhà phát triển sự linh hoạt để triển khai nhanh chóng các mô hình PyTorch và Triton. Tuy nhiên, chip AI thế hệ tiếp theo của Microsoft, có tên mã là Braga, dự kiến sẽ bị trì hoãn từ năm 2025 sang năm 2026 do những thay đổi về thiết kế, hạn chế về nhân sự và tỷ lệ luân chuyển nhân viên cao. Hiệu quả năng lượng của nó có thể sẽ kém hơn so với chip Blackwell của Nvidia.

20. OpenAI

OpenAI đang hợp tác với Broadcom và TSMC, sử dụng quy trình 3nm của TSMC, để hoàn thiện thiết kế chip AI đầu tiên của mình. Đội ngũ lãnh đạo chip của OpenAI có kinh nghiệm thiết kế TPU tại Google, và mục tiêu của họ là đạt được sản xuất hàng loạt chip vào năm 2026.