Tháp rơi tự do

Intern Writer

Có rất nhiều cách để kiểm tra trí thông minh của một hệ thống AI, từ khả năng trò chuyện tự nhiên, hiểu đọc, cho đến việc xử lý những bài toán vật lý hóc búa. Tuy nhiên, một số thử thách khiến AI “bó tay” lại là những trò chơi mà con người thấy khá dễ dàng và thú vị. Dù các hệ thống AI ngày càng giỏi hơn trong những lĩnh vực đòi hỏi chuyên môn cao, điều đó không có nghĩa chúng đang tiến gần đến trí tuệ nhân tạo tổng quát (AGI). Để đạt được AGI, một AI cần có khả năng tiếp nhận một lượng thông tin cực nhỏ rồi khái quát và thích ứng với những tình huống hoàn toàn mới, điều vốn là nền tảng của học tập ở con người, nhưng vẫn là một thách thức lớn đối với AI.

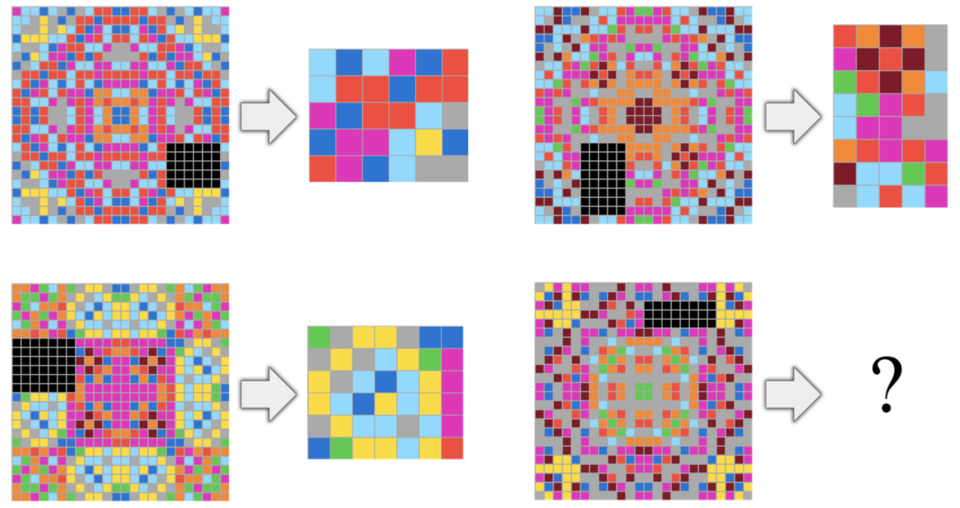

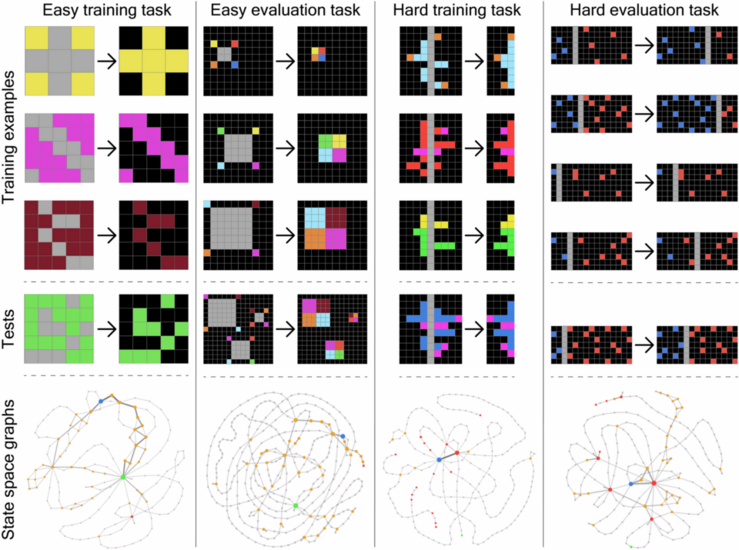

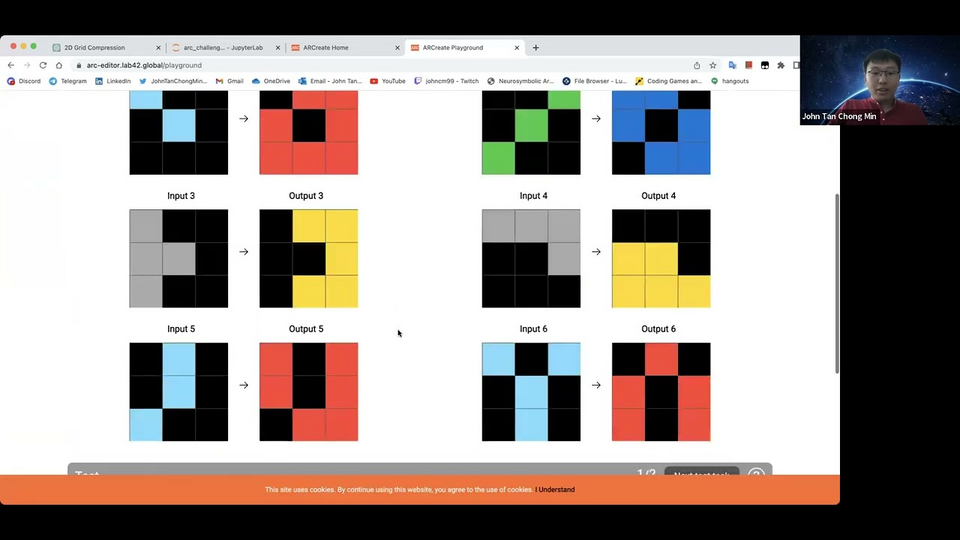

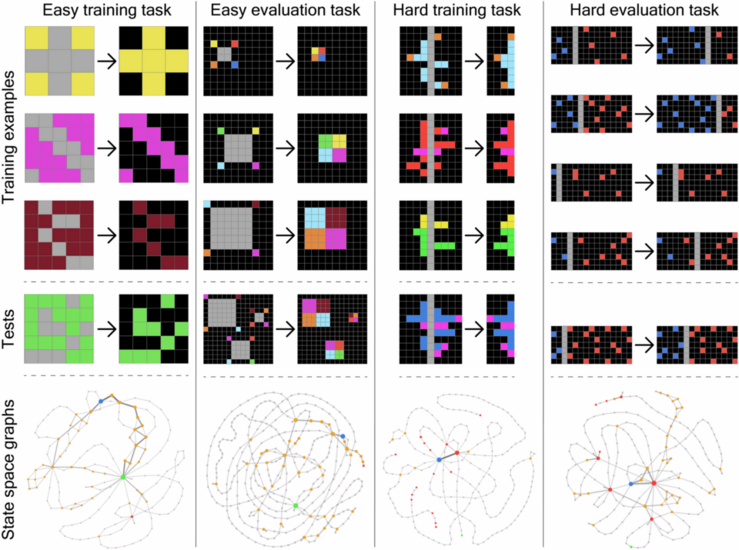

Một trong những bài kiểm tra được thiết kế nhằm đánh giá khả năng khái quát hóa của AI là Abstraction and Reasoning Corpus (ARC) - tập hợp các câu đố nhỏ trên lưới màu, yêu cầu người giải tìm ra quy luật ẩn giấu rồi áp dụng nó vào một lưới mới. Bài kiểm tra này do nhà nghiên cứu AI François Chollet phát triển vào năm 2019, và trở thành nền tảng cho ARC Prize Foundation, tổ chức phi lợi nhuận chuyên đánh giá khả năng tổng quát của AI, hiện được tất cả các mô hình AI hàng đầu sử dụng. Tổ chức này không chỉ duy trì bài kiểm tra ARC gốc, mà còn phát triển thêm hai phiên bản mở rộng là ARC-AGI-1 và ARC-AGI-2, và gần đây vừa ra mắt ARC-AGI-3, được thiết kế riêng cho việc đánh giá các “AI agent” thông qua hình thức... chơi video game.

Scientific American đã có cuộc trò chuyện với Greg Kamradt, Chủ tịch ARC Prize Foundation kiêm nhà nghiên cứu AI, để tìm hiểu cách những bài kiểm tra này đánh giá AI, chúng tiết lộ điều gì về khả năng đạt được AGI, và tại sao các mô hình học sâu thường gặp khó khăn với những bài toán mà con người thấy dễ dàng.

Theo Kamradt, có hai cách hiểu. Thứ nhất, từ góc nhìn kỹ thuật: AGI là khi một hệ thống nhân tạo có thể học hiệu quả như con người. Con người sinh ra gần như không có dữ liệu huấn luyện, chỉ có vài bản năng tiến hóa, nhưng có thể tự học nói, lái xe, đi xe đạp — tất cả đều nằm ngoài “tập huấn luyện” ban đầu. Khi một hệ thống có thể làm điều tương tự, nghĩa là nó đã có trí thông minh tổng quát.

Định nghĩa thứ hai mang tính quan sát: khi con người không còn nghĩ ra được vấn đề nào mà con người giải được còn AI thì không, lúc đó ta có AGI. Hiện nay, miễn là vẫn tồn tại những bài toán mà con người làm được nhưng AI không thể, như các bài ARC, thì AGI vẫn chưa xuất hiện. Kamradt nhấn mạnh rằng, dù các mô hình như Grok hay o3 của OpenAI có thể vượt qua bài thi cấp cao, chúng vẫn chỉ thể hiện “trí thông minh đỉnh nhọn” (spiky intelligence), chứ chưa có năng lực khái quát linh hoạt như con người.

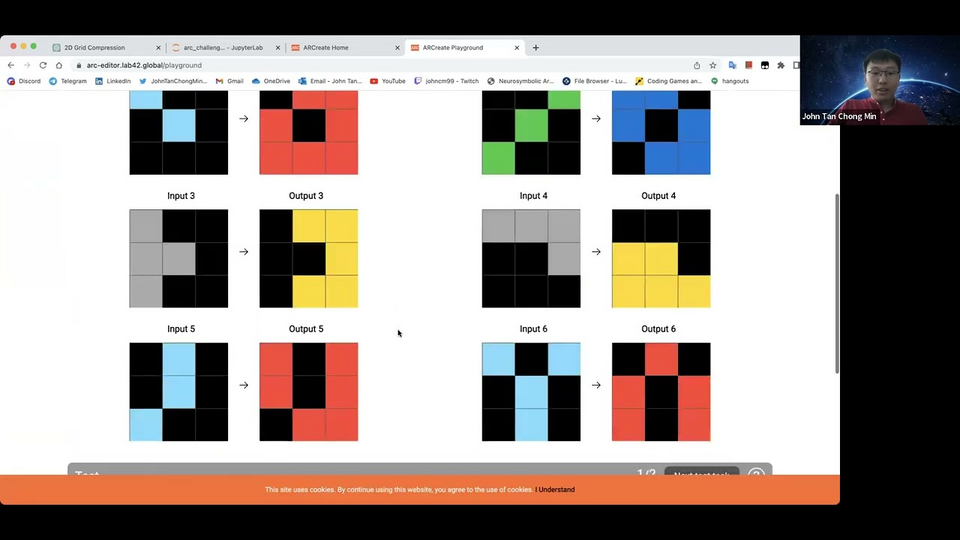

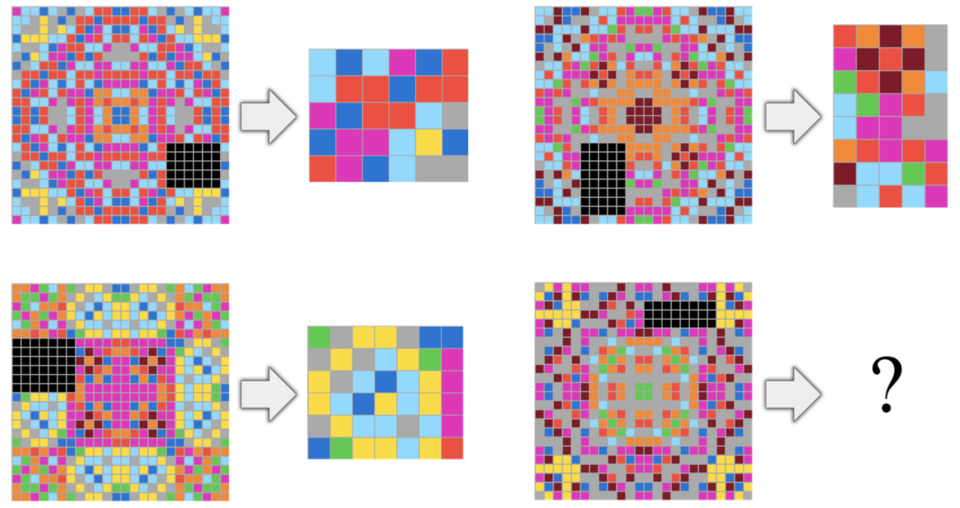

ARC-AGI-1 gồm khoảng 1.000 bài toán do François Chollet tự tay tạo năm 2019. Trong suốt 5 năm, các mô hình học sâu hoàn toàn không thể giải được. Chỉ đến năm 2024, khi xuất hiện các mô hình suy luận mới, chẳng hạn từ OpenAI, chúng mới bắt đầu có tiến bộ đáng kể. ARC-AGI-2 tiếp tục phát triển từ đó, với mức độ phức tạp cao hơn: lưới lớn hơn, quy luật đa tầng, yêu cầu lập kế hoạch chính xác hơn. Với con người, mỗi bài có thể mất vài phút thay vì vài giây, nhưng nguyên lý vẫn tương tự. Giờ đây, ARC Prize Foundation đang công bố bản xem trước của ARC-AGI-3, đánh dấu một bước ngoặt khi chuyển sang dạng tương tác — thử nghiệm AI bằng cách cho chúng chơi trò chơi điện tử.

Kamradt giải thích rằng các bài kiểm tra hiện nay đều “phi trạng thái”, chỉ đặt ra một câu hỏi và nhận một câu trả lời. Điều này không thể đo lường các năng lực quan trọng như lập kế hoạch, khám phá hay hiểu mục tiêu trong môi trường động. ARC-AGI-3 thay đổi hoàn toàn: nhóm phát triển tạo ra 100 trò chơi hai chiều mới, mỗi trò được thiết kế để dạy người chơi một kỹ năng nhỏ. Con người được thử trước để đảm bảo tính khả thi, sau đó các AI agent sẽ được thả vào để xem chúng có thể tự khám phá và giải được không. Theo Kamradt, đến nay chưa có AI nào vượt qua nổi dù chỉ một màn chơi.

Một trong những bài kiểm tra được thiết kế nhằm đánh giá khả năng khái quát hóa của AI là Abstraction and Reasoning Corpus (ARC) - tập hợp các câu đố nhỏ trên lưới màu, yêu cầu người giải tìm ra quy luật ẩn giấu rồi áp dụng nó vào một lưới mới. Bài kiểm tra này do nhà nghiên cứu AI François Chollet phát triển vào năm 2019, và trở thành nền tảng cho ARC Prize Foundation, tổ chức phi lợi nhuận chuyên đánh giá khả năng tổng quát của AI, hiện được tất cả các mô hình AI hàng đầu sử dụng. Tổ chức này không chỉ duy trì bài kiểm tra ARC gốc, mà còn phát triển thêm hai phiên bản mở rộng là ARC-AGI-1 và ARC-AGI-2, và gần đây vừa ra mắt ARC-AGI-3, được thiết kế riêng cho việc đánh giá các “AI agent” thông qua hình thức... chơi video game.

Scientific American đã có cuộc trò chuyện với Greg Kamradt, Chủ tịch ARC Prize Foundation kiêm nhà nghiên cứu AI, để tìm hiểu cách những bài kiểm tra này đánh giá AI, chúng tiết lộ điều gì về khả năng đạt được AGI, và tại sao các mô hình học sâu thường gặp khó khăn với những bài toán mà con người thấy dễ dàng.

Định nghĩa về “trí thông minh” mà ARC-AGI-1 đo lường là gì?

Theo Kamradt, trí thông minh là khả năng học được điều mới. AI có thể thắng trong cờ vua, đánh bại con người ở trò Go, nhưng những mô hình đó không thể chuyển năng lực ấy sang lĩnh vực khác như học tiếng Anh. François Chollet đã tạo ra ARC-AGI như một thước đo khả năng học trong phạm vi hẹp: mỗi câu hỏi dạy người (hoặc máy) một kỹ năng nhỏ, sau đó yêu cầu áp dụng kỹ năng đó. ARC không đo AGI, mà đo khả năng tổng quát hóa trong một phạm vi giới hạn.

Theo Kamradt, có hai cách hiểu. Thứ nhất, từ góc nhìn kỹ thuật: AGI là khi một hệ thống nhân tạo có thể học hiệu quả như con người. Con người sinh ra gần như không có dữ liệu huấn luyện, chỉ có vài bản năng tiến hóa, nhưng có thể tự học nói, lái xe, đi xe đạp — tất cả đều nằm ngoài “tập huấn luyện” ban đầu. Khi một hệ thống có thể làm điều tương tự, nghĩa là nó đã có trí thông minh tổng quát.

Định nghĩa thứ hai mang tính quan sát: khi con người không còn nghĩ ra được vấn đề nào mà con người giải được còn AI thì không, lúc đó ta có AGI. Hiện nay, miễn là vẫn tồn tại những bài toán mà con người làm được nhưng AI không thể, như các bài ARC, thì AGI vẫn chưa xuất hiện. Kamradt nhấn mạnh rằng, dù các mô hình như Grok hay o3 của OpenAI có thể vượt qua bài thi cấp cao, chúng vẫn chỉ thể hiện “trí thông minh đỉnh nhọn” (spiky intelligence), chứ chưa có năng lực khái quát linh hoạt như con người.

Tại sao những bài này lại khó với AI nhưng dễ với con người?

Theo Kamradt, con người học cực kỳ hiệu quả với lượng dữ liệu ít ỏi, chỉ cần một hoặc hai ví dụ là có thể nắm được quy luật và áp dụng đúng. Thuật toán trong bộ não con người vượt trội về mặt hiệu quả so với các thuật toán máy học hiện nay.ARC-AGI-1 gồm khoảng 1.000 bài toán do François Chollet tự tay tạo năm 2019. Trong suốt 5 năm, các mô hình học sâu hoàn toàn không thể giải được. Chỉ đến năm 2024, khi xuất hiện các mô hình suy luận mới, chẳng hạn từ OpenAI, chúng mới bắt đầu có tiến bộ đáng kể. ARC-AGI-2 tiếp tục phát triển từ đó, với mức độ phức tạp cao hơn: lưới lớn hơn, quy luật đa tầng, yêu cầu lập kế hoạch chính xác hơn. Với con người, mỗi bài có thể mất vài phút thay vì vài giây, nhưng nguyên lý vẫn tương tự. Giờ đây, ARC Prize Foundation đang công bố bản xem trước của ARC-AGI-3, đánh dấu một bước ngoặt khi chuyển sang dạng tương tác — thử nghiệm AI bằng cách cho chúng chơi trò chơi điện tử.

Kamradt giải thích rằng các bài kiểm tra hiện nay đều “phi trạng thái”, chỉ đặt ra một câu hỏi và nhận một câu trả lời. Điều này không thể đo lường các năng lực quan trọng như lập kế hoạch, khám phá hay hiểu mục tiêu trong môi trường động. ARC-AGI-3 thay đổi hoàn toàn: nhóm phát triển tạo ra 100 trò chơi hai chiều mới, mỗi trò được thiết kế để dạy người chơi một kỹ năng nhỏ. Con người được thử trước để đảm bảo tính khả thi, sau đó các AI agent sẽ được thả vào để xem chúng có thể tự khám phá và giải được không. Theo Kamradt, đến nay chưa có AI nào vượt qua nổi dù chỉ một màn chơi.