Quỹ Wikimedia Foundation (WMF), tổ chức phi lợi nhuận đứng sau bách khoa toàn thư mở Wikipedia và kho lưu trữ đa phương tiện khổng lồ Wikimedia Commons, đang phải lên tiếng báo động về một vấn đề ngày càng nghiêm trọng: tình trạng các công ty Trí tuệ Nhân tạo (AI) khai thác dữ liệu với quy mô công nghiệp để huấn luyện các Mô hình ngôn ngữ lớn (LLM) đang gây áp lực cực lớn lên hạ tầng máy chủ của họ.

Những điểm chính

Điều đáng nói là phần lớn các công ty AI đứng sau những hoạt động thu thập dữ liệu quy mô lớn này lại không hề có đóng góp tài chính để hỗ trợ vận hành hạ tầng mà họ đang khai thác triệt để. WMF nhấn mạnh một thông điệp cốt lõi: "Nội dung của chúng tôi miễn phí, nhưng hạ tầng thì không."

Tại sao bot AI lại "tốn kém" hơn người dùng thật?

WMF chỉ ra rằng cách các bot AI truy cập dữ liệu khác biệt và kém hiệu quả hơn nhiều so với người dùng thông thường ("bằng xương bằng thịt"):

Hành vi tinh vi và bất chấp quy tắc

Tình hình càng trở nên phức tạp khi nhiều trình thu thập dữ liệu (web crawler) phục vụ cho AI không tuân thủ các quy tắc ứng xử cơ bản trên internet. Chúng thường xuyên:

Đây không phải là vấn đề của riêng Wikimedia. Nhiều dự án phần mềm miễn phí và mã nguồn mở (FOSS) khác cũng đang đối mặt với tình trạng tương tự. Kho lưu trữ Pagure của Fedora từng phải chặn truy cập từ Brazil, GitLab của GNOME triển khai cơ chế "proof-of-work", còn Read the Docs phải chặn các trình thu thập AI để giảm chi phí băng thông. Các nền tảng đang thử nghiệm nhiều giải pháp kỹ thuật như tarpits (làm chậm phản hồi), danh sách chặn dùng chung (ai.robots.txt), hay công cụ thương mại (Cloudflare AI Labyrinth).

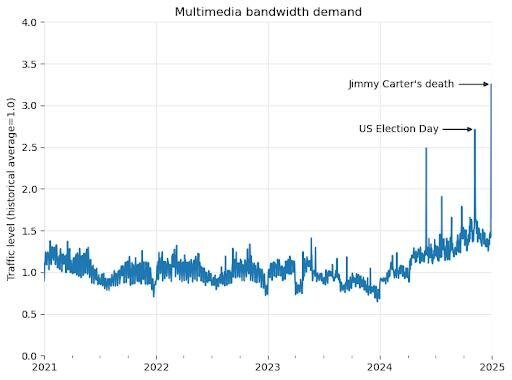

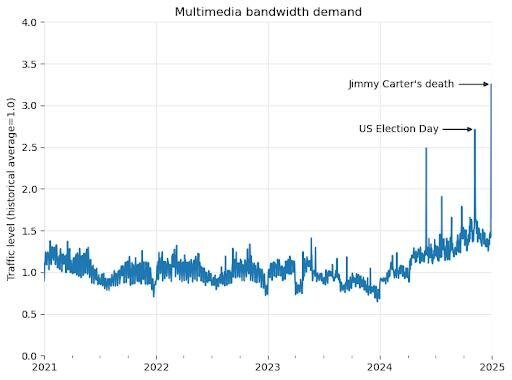

Yêu cầu băng thông của Wikimedia Projects tăng đột biến

Wikimedia kêu gọi trách nhiệm và hợp tác

Trước thực trạng đáng báo động này, Wikimedia Foundation đã khởi động một sáng kiến mới mang tên WE5: Sử dụng Hạ tầng Có Trách Nhiệm (Responsible Use of Infrastructure). Sáng kiến này nhằm mục đích nâng cao nhận thức và đặt ra những câu hỏi quan trọng về việc làm thế nào để các nhà phát triển AI có thể tiếp cận nguồn tài nguyên tri thức mở một cách hiệu quả, bền vững và có trách nhiệm hơn, tôn trọng hạ tầng đang duy trì nguồn tri thức đó.

WMF thừa nhận vai trò quan trọng của mình trong việc cung cấp tri thức cho thế giới, bao gồm cả việc làm dữ liệu đầu vào cho AI. Tuy nhiên, họ nhấn mạnh sự mất cân bằng nghiêm trọng khi các công ty AI thương mại thu lợi lớn từ dữ liệu mở nhưng lại không có cơ chế đóng góp tương xứng để duy trì hạ tầng. Điều này đang đe dọa chính sự tồn tại bền vững của các nền tảng như Wikipedia.

Quỹ Wikimedia kêu gọi sự hợp tác thực chất từ các công ty AI. Một số giải pháp tiềm năng được gợi ý bao gồm cơ chế tài trợ chung cho hạ tầng, phát triển các API chuyên dụng (có thể trả phí) cho việc truy cập dữ liệu quy mô lớn, hoặc xây dựng các phương thức truy cập dữ liệu hiệu quả hơn. Nếu không có sự hợp tác này, chính những nền tảng tri thức đã góp phần tạo nên sự bùng nổ của AI ngày nay có nguy cơ bị suy yếu hoặc không thể tiếp tục hoạt động ổn định trong tương lai.

Những điểm chính

- Quỹ Wikimedia Foundation (vận hành Wikipedia, Commons...) đang đối mặt với áp lực hạ tầng và chi phí tăng vọt do các công ty AI khai thác dữ liệu công khai với quy mô lớn để huấn luyện các mô hình ngôn ngữ lớn (LLM).

- Bot AI truy cập dữ liệu kém hiệu quả (ít dùng cache, quét toàn bộ) và chiếm tới 65% các yêu cầu tốn nhiều tài nguyên nhất dù chỉ chiếm 35% lượt xem trang.

- Nhiều bot AI không tuân thủ quy tắc (robots.txt), giả mạo người dùng, dùng IP xoay vòng để tránh bị chặn, gây thêm gánh nặng quản lý.

- Wikimedia khởi xướng sáng kiến WE5 (Sử dụng Hạ tầng Có Trách Nhiệm), kêu gọi các nhà phát triển AI tiếp cận dữ liệu bền vững hơn.

- WMF nhấn mạnh "hạ tầng không miễn phí" và kêu gọi sự hợp tác, đóng góp tài chính từ các công ty AI (như tài trợ chung, API chuyên dụng...) để đảm bảo tương lai của các nền tảng tri thức mở.

Điều đáng nói là phần lớn các công ty AI đứng sau những hoạt động thu thập dữ liệu quy mô lớn này lại không hề có đóng góp tài chính để hỗ trợ vận hành hạ tầng mà họ đang khai thác triệt để. WMF nhấn mạnh một thông điệp cốt lõi: "Nội dung của chúng tôi miễn phí, nhưng hạ tầng thì không."

Tại sao bot AI lại "tốn kém" hơn người dùng thật?

WMF chỉ ra rằng cách các bot AI truy cập dữ liệu khác biệt và kém hiệu quả hơn nhiều so với người dùng thông thường ("bằng xương bằng thịt"):

- Người dùng thật: Thường truy cập các bài viết, hình ảnh phổ biến, những nội dung này thường được lưu trữ sẵn trong bộ nhớ đệm (cache) tại các máy chủ phân tán gần họ, giúp giảm tải cho máy chủ gốc.

- Bot AI: Thường quét toàn bộ kho dữ liệu một cách hệ thống, bao gồm cả những trang rất ít người truy cập hoặc các tệp đa phương tiện dung lượng lớn. Điều này buộc các trung tâm dữ liệu lõi của Wikimedia phải xử lý yêu cầu trực tiếp, khiến hệ thống cache trở nên kém hiệu quả.

Hành vi tinh vi và bất chấp quy tắc

Tình hình càng trở nên phức tạp khi nhiều trình thu thập dữ liệu (web crawler) phục vụ cho AI không tuân thủ các quy tắc ứng xử cơ bản trên internet. Chúng thường xuyên:

- Phớt lờ các chỉ dẫn trong tệp robots.txt (tệp tin mà các website dùng để yêu cầu bot không truy cập vào những phần nhất định).

- Giả mạo hành vi giống người dùng thật để qua mặt các cơ chế phát hiện bot.

- Sử dụng kỹ thuật xoay vòng qua hàng loạt địa chỉ IP dân dụng để tránh bị chặn.

Đây không phải là vấn đề của riêng Wikimedia. Nhiều dự án phần mềm miễn phí và mã nguồn mở (FOSS) khác cũng đang đối mặt với tình trạng tương tự. Kho lưu trữ Pagure của Fedora từng phải chặn truy cập từ Brazil, GitLab của GNOME triển khai cơ chế "proof-of-work", còn Read the Docs phải chặn các trình thu thập AI để giảm chi phí băng thông. Các nền tảng đang thử nghiệm nhiều giải pháp kỹ thuật như tarpits (làm chậm phản hồi), danh sách chặn dùng chung (ai.robots.txt), hay công cụ thương mại (Cloudflare AI Labyrinth).

Yêu cầu băng thông của Wikimedia Projects tăng đột biến

Wikimedia kêu gọi trách nhiệm và hợp tác

Trước thực trạng đáng báo động này, Wikimedia Foundation đã khởi động một sáng kiến mới mang tên WE5: Sử dụng Hạ tầng Có Trách Nhiệm (Responsible Use of Infrastructure). Sáng kiến này nhằm mục đích nâng cao nhận thức và đặt ra những câu hỏi quan trọng về việc làm thế nào để các nhà phát triển AI có thể tiếp cận nguồn tài nguyên tri thức mở một cách hiệu quả, bền vững và có trách nhiệm hơn, tôn trọng hạ tầng đang duy trì nguồn tri thức đó.

WMF thừa nhận vai trò quan trọng của mình trong việc cung cấp tri thức cho thế giới, bao gồm cả việc làm dữ liệu đầu vào cho AI. Tuy nhiên, họ nhấn mạnh sự mất cân bằng nghiêm trọng khi các công ty AI thương mại thu lợi lớn từ dữ liệu mở nhưng lại không có cơ chế đóng góp tương xứng để duy trì hạ tầng. Điều này đang đe dọa chính sự tồn tại bền vững của các nền tảng như Wikipedia.

Quỹ Wikimedia kêu gọi sự hợp tác thực chất từ các công ty AI. Một số giải pháp tiềm năng được gợi ý bao gồm cơ chế tài trợ chung cho hạ tầng, phát triển các API chuyên dụng (có thể trả phí) cho việc truy cập dữ liệu quy mô lớn, hoặc xây dựng các phương thức truy cập dữ liệu hiệu quả hơn. Nếu không có sự hợp tác này, chính những nền tảng tri thức đã góp phần tạo nên sự bùng nổ của AI ngày nay có nguy cơ bị suy yếu hoặc không thể tiếp tục hoạt động ổn định trong tương lai.