Minh Nguyệt

Intern Writer

Chạy một mô hình AI ngay trên máy tính cá nhân của bạn có thể mang lại nhiều lợi ích đáng kể: độ trễ thấp hơn, khả năng hiểu rõ hơn về nhu cầu cá nhân và sự riêng tư khi giữ dữ liệu trên chính máy của mình. Tuy nhiên, đối với những chiếc laptop trung bình đã qua một năm sử dụng, số lượng mô hình AI hữu ích mà bạn có thể chạy trên máy tính gần như bằng không. Những chiếc laptop này thường chỉ có bộ xử lý từ bốn đến tám nhân, không có chip đồ họa chuyên dụng hay đơn vị xử lý thần kinh, và chỉ có 16 gigabyte RAM, khiến chúng không đủ sức mạnh để xử lý các mô hình ngôn ngữ lớn.

Ngay cả những chiếc laptop PC cao cấp mới nhất, thường được trang bị NPU và GPU, cũng có thể gặp khó khăn. Các mô hình AI lớn nhất hiện nay có hơn một triệu tham số, yêu cầu bộ nhớ lên đến hàng trăm gigabyte. Các phiên bản nhỏ hơn của những mô hình này có sẵn, nhưng thường thiếu đi trí thông minh của các mô hình lớn hơn, mà chỉ các trung tâm dữ liệu AI chuyên dụng mới có thể xử lý.

Tình hình càng trở nên tồi tệ hơn khi xem xét các tính năng AI khác nhằm nâng cao khả năng của mô hình. Các mô hình ngôn ngữ nhỏ chạy trên phần cứng địa phương thường phải giảm bớt hoặc loại bỏ hoàn toàn những tính năng này. Việc tạo ra hình ảnh và video cũng khó khăn khi chạy trên laptop, và cho đến gần đây, chúng thường chỉ dành cho các máy tính để bàn cao cấp.

Để có thể chạy các mô hình AI trên máy tính cá nhân, phần cứng bên trong laptop và phần mềm chạy trên đó cần phải được nâng cấp. Đây là khởi đầu cho một sự thay đổi trong thiết kế laptop, cho phép các kỹ sư có cơ hội từ bỏ những di sản cuối cùng của quá khứ và tái tạo lại máy tính từ đầu.

Một trong những cách rõ ràng nhất để nâng cao hiệu suất AI của PC là trang bị một NPU mạnh mẽ bên cạnh CPU. NPU là một chip chuyên dụng được thiết kế cho các phép toán nhân ma trận mà hầu hết các mô hình AI dựa vào. Những phép toán này có thể thực hiện song song, đó là lý do tại sao GPU, vốn đã tốt hơn CPU trong các tác vụ song song, trở thành lựa chọn hàng đầu cho các trung tâm dữ liệu AI.

Tuy nhiên, vì NPU được thiết kế đặc biệt để xử lý các phép toán ma trận và không phải cho các tác vụ khác như đồ họa 3D, chúng tiết kiệm năng lượng hơn GPU. Điều này rất quan trọng để tăng tốc AI trên công nghệ tiêu dùng di động. NPU cũng thường hỗ trợ tốt hơn cho các phép toán số học độ chính xác thấp hơn so với GPU trên laptop. Các mô hình AI thường sử dụng số học độ chính xác thấp để giảm nhu cầu tính toán và bộ nhớ trên phần cứng di động như laptop.

“Với NPU, toàn bộ cấu trúc thực sự được thiết kế xung quanh loại dữ liệu của các tensor,” Steven Bathiche, một chuyên gia kỹ thuật tại Microsoft cho biết. “NPUs chuyên biệt hơn cho khối lượng công việc đó. Và vì vậy, chúng ta chuyển từ một CPU có thể xử lý ba triệu phép toán mỗi giây sang một NPU trong chip Snapdragon X của Qualcomm, có thể cung cấp các tính năng Copilot+ của Microsoft.”

Trong khi Qualcomm có thể được coi là công ty đầu tiên cung cấp NPU cho laptop Windows, họ đã khởi động một cuộc đua TOPS NPU mà còn có sự tham gia của AMD và Intel, và cuộc cạnh tranh này đang thúc đẩy hiệu suất NPU lên cao hơn. Năm 2023, trước khi Snapdragon X ra mắt, các chip AMD có NPU rất hiếm và những chip đó chỉ cung cấp khoảng 10 TOPS. Ngày nay, AMD và Intel đã có NPU cạnh tranh với Snapdragon, cung cấp từ 40 đến 50 TOPS.

Chiếc máy tính AI Pro Max Plus sắp ra mắt của Dell sẽ nâng cao tiêu chuẩn với NPU AI 100 của Qualcomm, hứa hẹn cung cấp tới 350 TOPS, cải thiện hiệu suất gấp 35 lần so với các NPU tốt nhất hiện có chỉ vài năm trước. Điều này cho thấy rằng các NPU có khả năng hàng nghìn TOPS chỉ còn cách chúng ta vài năm nữa.

Chúng ta cần bao nhiêu TOPS để chạy các mô hình tiên tiến với hàng trăm triệu tham số? Không ai biết chính xác. Hiện tại, không thể chạy những mô hình này trên phần cứng tiêu dùng ngày nay, vì vậy không thể thực hiện các bài kiểm tra thực tế. Nhưng có lý do để tin rằng chúng ta đang ở rất gần khả năng đó. Cũng cần lưu ý rằng các mô hình ngôn ngữ lớn không phải là trường hợp sử dụng duy nhất cho NPU. Vinesh Sukumar, người đứng đầu bộ phận AI và học máy của Qualcomm, cho biết việc tạo ra và chỉnh sửa hình ảnh AI là một ví dụ về nhiệm vụ khó khăn mà không có NPU hoặc GPU cao cấp.

Việc xây dựng các chip cân bằng hơn cho AI là điều cần thiết. Các NPU nhanh hơn sẽ xử lý nhiều token mỗi giây hơn, từ đó mang lại trải nghiệm nhanh hơn và mượt mà hơn khi sử dụng các mô hình AI. Tuy nhiên, còn nhiều yếu tố khác cần xem xét khi chạy AI trên phần cứng địa phương, không chỉ đơn giản là trang bị một NPU lớn hơn.

Mike Clark, kỹ sư thiết kế cấp cao tại AMD, cho biết các công ty thiết kế chip để tăng tốc AI trên PC không thể chỉ đặt cược vào NPU. Điều này một phần vì AI không phải là sự thay thế cho, mà là bổ sung cho các tác vụ mà một PC cần xử lý. “Chúng ta phải giỏi trong việc xử lý độ trễ thấp, các loại dữ liệu nhỏ hơn, và mã nhánh—các khối lượng công việc truyền thống. Chúng ta không thể từ bỏ điều đó, nhưng vẫn muốn giỏi trong AI,” Clark nói. Ông cũng lưu ý rằng “CPU được sử dụng để chuẩn bị dữ liệu” cho các khối lượng công việc AI, có nghĩa là một CPU không đủ mạnh có thể trở thành nút thắt cổ chai.

NPU cũng phải cạnh tranh hoặc hợp tác với GPU. Trên PC, điều này thường có nghĩa là một GPU cao cấp của AMD hoặc Nvidia với nhiều bộ nhớ tích hợp lớn. GPU Nvidia GeForce RTX 5090 có hiệu suất AI lên tới 3,352 TOPS, vượt xa cả Qualcomm AI 100.

Tuy nhiên, điều này đi kèm với một caveat lớn: năng lượng. Mặc dù rất mạnh mẽ, RTX 5090 được thiết kế để tiêu thụ tới 575 watt. Các phiên bản di động cho laptop tiết kiệm hơn nhưng vẫn tiêu thụ tới 175 watt, điều này có thể nhanh chóng làm cạn kiệt pin laptop.

Simon Ng, quản lý sản phẩm AI tại Intel, cho biết công ty đang “nhìn thấy rằng NPU sẽ thực hiện mọi thứ hiệu quả hơn với mức tiêu thụ năng lượng thấp hơn.” Rakesh Anigundi, giám đốc quản lý sản phẩm cho Ryzen AI của AMD, đồng ý. Ông thêm rằng hoạt động tiêu thụ năng lượng thấp là rất quan trọng vì các khối lượng công việc AI thường mất nhiều thời gian hơn để chạy so với các tác vụ đòi hỏi khác, như mã hóa video hoặc xử lý đồ họa. “Bạn sẽ muốn chạy điều này trong một khoảng thời gian dài hơn, chẳng hạn như một trợ lý cá nhân AI, có thể luôn hoạt động và lắng nghe lệnh của bạn,” ông nói.

Những ưu tiên cạnh tranh này có nghĩa là các kiến trúc sư chip và nhà thiết kế hệ thống sẽ cần phải đưa ra những quyết định khó khăn về cách phân bổ silicon và năng lượng trong các PC AI, đặc biệt là những chiếc thường dựa vào nguồn năng lượng từ pin, như laptop.

“Chúng ta phải rất cẩn thận trong cách thiết kế hệ thống trên một chip để đảm bảo rằng một SoC lớn hơn có thể hoạt động theo yêu cầu của chúng ta trong một hình thức mỏng và nhẹ,” Mahesh Subramony, kỹ sư thiết kế cấp cao tại AMD cho biết.

Khi nói đến AI, bộ nhớ cũng rất quan trọng. Việc tích hợp một NPU bên cạnh CPU và GPU sẽ cải thiện hiệu suất của PC trung bình trong các tác vụ AI, nhưng đó không phải là sự thay đổi cách mạng duy nhất mà AI sẽ buộc phải thay đổi kiến trúc PC. Còn một yếu tố khác có thể còn quan trọng hơn: bộ nhớ.

Hầu hết các PC hiện đại có kiến trúc bộ nhớ phân chia, bắt nguồn từ những quyết định được đưa ra cách đây hơn 25 năm. Những hạn chế về băng thông bus đã khiến GPU (và các thẻ mở rộng khác có thể yêu cầu bộ nhớ băng thông cao) phải chuyển sang sử dụng bộ nhớ riêng của GPU thay vì truy cập vào bộ nhớ hệ thống của PC. Kết quả là, các PC mạnh mẽ thường có hai vùng bộ nhớ, bộ nhớ hệ thống và bộ nhớ đồ họa, hoạt động độc lập.

Điều này là một vấn đề cho AI. Các mô hình yêu cầu một lượng lớn bộ nhớ, và toàn bộ mô hình phải được tải vào bộ nhớ cùng một lúc. Kiến trúc PC truyền thống, phân chia bộ nhớ giữa hệ thống và GPU, mâu thuẫn với yêu cầu đó.

“Khi tôi có một GPU rời, tôi có một hệ thống bộ nhớ riêng biệt treo bên cạnh,” Joe Macri, phó chủ tịch và giám đốc công nghệ tại AMD giải thích. “Khi tôi muốn chia sẻ dữ liệu giữa CPU và GPU, tôi phải lấy dữ liệu ra khỏi bộ nhớ của mình, trượt nó qua bus PCI Express, đưa vào bộ nhớ GPU, thực hiện xử lý, rồi lại chuyển tất cả trở lại.” Macri cho biết điều này làm tăng mức tiêu thụ năng lượng và dẫn đến trải nghiệm người dùng chậm chạp.

Giải pháp là một kiến trúc bộ nhớ thống nhất, cung cấp cho tất cả các tài nguyên hệ thống quyền truy cập vào cùng một vùng bộ nhớ qua một bus bộ nhớ nhanh và liên kết. Silicon của Apple có thể là ví dụ gần đây nhất nổi bật về chip có kiến trúc bộ nhớ thống nhất. Tuy nhiên, bộ nhớ thống nhất vẫn hiếm gặp trong các PC hiện đại.

AMD đang theo đuổi hướng đi này trong không gian laptop. Công ty đã công bố một dòng APU mới nhắm đến các laptop cao cấp, Ryzen AI Max, tại CES 2025. Ryzen AI Max đặt các lõi CPU Ryzen của công ty trên cùng một silicon với các lõi GPU mang thương hiệu Radeon, cộng với một NPU có khả năng 50 TOPS, trên một mảnh silicon duy nhất với kiến trúc bộ nhớ thống nhất. Nhờ đó, CPU, GPU và NPU có thể truy cập tối đa 128 GB bộ nhớ hệ thống, được chia sẻ giữa cả ba. AMD tin rằng chiến lược này là lý tưởng cho việc quản lý bộ nhớ và hiệu suất trong các PC tiêu dùng. “Bằng cách đưa tất cả vào dưới một đầu nhiệt duy nhất, toàn bộ mức tiêu thụ năng lượng trở thành thứ mà chúng tôi có thể quản lý,” Subramony cho biết.

Ryzen AI Max đã có mặt trên một số laptop, bao gồm HP Zbook Ultra G1a và Asus ROG Flow Z13. Nó cũng cung cấp sức mạnh cho Framework Desktop và một số mini desktop từ các thương hiệu ít nổi tiếng hơn, như GMKtec EVO-X2 AI mini PC.

Intel và Nvidia cũng sẽ tham gia vào cuộc chơi này, mặc dù theo một cách bất ngờ. Vào tháng 9, hai đối thủ trước đây đã công bố một liên minh để bán các chip kết hợp lõi CPU của Intel với lõi GPU của Nvidia. Mặc dù các chi tiết vẫn chưa được công bố, kiến trúc chip này có khả năng sẽ bao gồm bộ nhớ thống nhất và một NPU của Intel.

Những chip như vậy có khả năng thay đổi đáng kể kiến trúc PC nếu chúng được chấp nhận. Chúng sẽ cung cấp quyền truy cập vào các vùng bộ nhớ lớn hơn nhiều so với trước đây và tích hợp CPU, GPU và NPU vào một mảnh silicon duy nhất có thể được theo dõi và kiểm soát chặt chẽ. Những yếu tố này sẽ giúp dễ dàng hơn trong việc chuyển giao khối lượng công việc AI đến phần cứng phù hợp nhất để thực hiện tại một thời điểm nhất định.

Đáng tiếc là, chúng cũng sẽ làm cho việc nâng cấp và sửa chữa PC trở nên khó khăn hơn, vì các chip với kiến trúc bộ nhớ thống nhất thường gộp CPU, GPU, NPU và bộ nhớ vào một gói duy nhất, không thể tách rời trên bo mạch chính của PC. Điều này trái ngược với các PC truyền thống, nơi CPU, GPU và bộ nhớ có thể được thay thế riêng lẻ.

Cách tiếp cận tích cực của Microsoft đối với AI đang viết lại Windows. MacOS được biết đến với giao diện người dùng hấp dẫn và trực quan, và các chip Silicon của Apple có kiến trúc bộ nhớ thống nhất có thể hữu ích cho AI. Tuy nhiên, GPU của Apple không mạnh mẽ bằng những GPU tốt nhất được sử dụng trong các PC, và các công cụ AI của họ cho các nhà phát triển ít được áp dụng rộng rãi.

Chrissie Cremers, đồng sáng lập công ty tiếp thị tập trung vào AI Aigency Amsterdam, cho biết vào đầu năm nay rằng mặc dù cô ấy thích macOS, nhưng công ty của cô không sử dụng máy tính Mac cho công việc AI. “GPU trong máy tính để bàn Mac của tôi gần như không thể xử lý được quy trình làm việc AI của chúng tôi, và đó không phải là một chiếc máy tính cũ,” cô nói. “Tôi rất muốn họ bắt kịp ở đây, vì họ từng là công cụ sáng tạo.”

Điều này để lại một khoảng trống cho các đối thủ trở thành lựa chọn hàng đầu cho AI trên PC—và Microsoft biết điều đó. Microsoft đã ra mắt các PC Copilot+ tại hội nghị phát triển Build 2024 của công ty. Sự ra mắt gặp một số vấn đề, đặc biệt là việc phát hành không thành công tính năng chính, Windows Recall, sử dụng AI để giúp người dùng tìm kiếm bất cứ điều gì họ đã thấy hoặc nghe trên PC của mình. Tuy nhiên, sự ra mắt đã thành công trong việc thúc đẩy ngành công nghiệp PC hướng tới NPU, khi cả AMD và Intel đều giới thiệu các chip laptop mới với NPU nâng cấp vào cuối năm 2024.

Tại Build 2025, Microsoft cũng đã tiết lộ AI Foundry Local của Windows, một “ngăn xếp thời gian chạy” bao gồm một danh mục các mô hình ngôn ngữ lớn mã nguồn mở phổ biến. Trong khi các mô hình của Microsoft có sẵn, danh mục này bao gồm hàng ngàn mô hình mã nguồn mở từ Alibaba, DeepSeek, Meta, Mistral AI, Nvidia, OpenAI, Stability AI, xAI và nhiều hơn nữa.

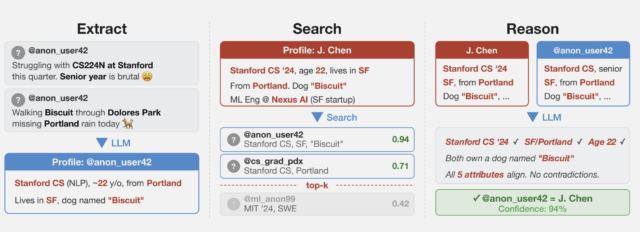

Khi một mô hình được chọn và triển khai vào một ứng dụng, Windows thực hiện các tác vụ AI trên phần cứng địa phương thông qua runtime Windows ML, tự động chỉ định các tác vụ AI đến phần cứng CPU, GPU hoặc NPU phù hợp nhất cho công việc. AI Foundry cũng cung cấp các API cho việc truy xuất kiến thức địa phương và thích ứng hạng thấp (LoRA), các tính năng tiên tiến cho phép các nhà phát triển tùy chỉnh dữ liệu mà một mô hình AI có thể tham khảo và cách mà nó phản hồi. Microsoft cũng đã công bố hỗ trợ cho tìm kiếm ngữ nghĩa trên thiết bị và tạo ra thông tin bổ sung, các tính năng giúp các nhà phát triển xây dựng các công cụ AI tham chiếu thông tin cụ thể trên thiết bị.

“AI Foundry là về việc thông minh. Nó là về việc sử dụng tất cả các bộ xử lý có sẵn, hiệu quả và ưu tiên khối lượng công việc giữa CPU, NPU và các phần khác. Có rất nhiều cơ hội và không gian để cải thiện,” Bathiche nói.

Sự phát triển nhanh chóng của phần cứng PC có khả năng AI không chỉ là một nâng cấp dần dần. Nó báo hiệu một sự thay đổi sắp tới trong ngành công nghiệp PC có khả năng xóa bỏ những di sản cuối cùng của các kiến trúc PC được thiết kế trong những năm 80, 90 và đầu những năm 2000. Sự kết hợp giữa các NPU ngày càng mạnh mẽ, kiến trúc bộ nhớ thống nhất và các kỹ thuật tối ưu hóa phần mềm tinh vi đang thu hẹp khoảng cách hiệu suất giữa AI địa phương và AI dựa trên đám mây với tốc độ khiến ngay cả những người trong ngành cũng ngạc nhiên.

Nó cũng sẽ thúc đẩy các nhà thiết kế chip hướng tới các chip tích hợp hơn nữa có hệ thống bộ nhớ thống nhất và đưa CPU, GPU và NPU vào một mảnh silicon duy nhất—ngay cả trong các laptop và máy tính để bàn cao cấp. Subramony của AMD cho biết mục tiêu là để người dùng “mang theo một trạm làm việc mini trong tay, cho dù đó là cho các khối lượng công việc AI hay cho tính toán cao. Bạn sẽ không cần phải đến đám mây.”

Một sự thay đổi lớn như vậy sẽ không xảy ra ngay lập tức. Tuy nhiên, rõ ràng là nhiều người trong ngành công nghiệp PC đang cam kết tái tạo lại những chiếc máy tính mà chúng ta sử dụng hàng ngày theo cách tối ưu hóa cho AI. Vinesh Sukumar của Qualcomm thậm chí tin rằng các laptop tiêu dùng giá cả phải chăng, giống như các trung tâm dữ liệu, nên hướng tới trí tuệ nhân tạo tổng quát. “Tôi muốn một trí tuệ nhân tạo tổng quát hoàn chỉnh chạy trên các thiết bị Qualcomm,” ông nói. “Đó là điều mà chúng tôi đang cố gắng thúc đẩy.”

Ngay cả những chiếc laptop PC cao cấp mới nhất, thường được trang bị NPU và GPU, cũng có thể gặp khó khăn. Các mô hình AI lớn nhất hiện nay có hơn một triệu tham số, yêu cầu bộ nhớ lên đến hàng trăm gigabyte. Các phiên bản nhỏ hơn của những mô hình này có sẵn, nhưng thường thiếu đi trí thông minh của các mô hình lớn hơn, mà chỉ các trung tâm dữ liệu AI chuyên dụng mới có thể xử lý.

Tình hình càng trở nên tồi tệ hơn khi xem xét các tính năng AI khác nhằm nâng cao khả năng của mô hình. Các mô hình ngôn ngữ nhỏ chạy trên phần cứng địa phương thường phải giảm bớt hoặc loại bỏ hoàn toàn những tính năng này. Việc tạo ra hình ảnh và video cũng khó khăn khi chạy trên laptop, và cho đến gần đây, chúng thường chỉ dành cho các máy tính để bàn cao cấp.

Để có thể chạy các mô hình AI trên máy tính cá nhân, phần cứng bên trong laptop và phần mềm chạy trên đó cần phải được nâng cấp. Đây là khởi đầu cho một sự thay đổi trong thiết kế laptop, cho phép các kỹ sư có cơ hội từ bỏ những di sản cuối cùng của quá khứ và tái tạo lại máy tính từ đầu.

Một trong những cách rõ ràng nhất để nâng cao hiệu suất AI của PC là trang bị một NPU mạnh mẽ bên cạnh CPU. NPU là một chip chuyên dụng được thiết kế cho các phép toán nhân ma trận mà hầu hết các mô hình AI dựa vào. Những phép toán này có thể thực hiện song song, đó là lý do tại sao GPU, vốn đã tốt hơn CPU trong các tác vụ song song, trở thành lựa chọn hàng đầu cho các trung tâm dữ liệu AI.

Tuy nhiên, vì NPU được thiết kế đặc biệt để xử lý các phép toán ma trận và không phải cho các tác vụ khác như đồ họa 3D, chúng tiết kiệm năng lượng hơn GPU. Điều này rất quan trọng để tăng tốc AI trên công nghệ tiêu dùng di động. NPU cũng thường hỗ trợ tốt hơn cho các phép toán số học độ chính xác thấp hơn so với GPU trên laptop. Các mô hình AI thường sử dụng số học độ chính xác thấp để giảm nhu cầu tính toán và bộ nhớ trên phần cứng di động như laptop.

“Với NPU, toàn bộ cấu trúc thực sự được thiết kế xung quanh loại dữ liệu của các tensor,” Steven Bathiche, một chuyên gia kỹ thuật tại Microsoft cho biết. “NPUs chuyên biệt hơn cho khối lượng công việc đó. Và vì vậy, chúng ta chuyển từ một CPU có thể xử lý ba triệu phép toán mỗi giây sang một NPU trong chip Snapdragon X của Qualcomm, có thể cung cấp các tính năng Copilot+ của Microsoft.”

Trong khi Qualcomm có thể được coi là công ty đầu tiên cung cấp NPU cho laptop Windows, họ đã khởi động một cuộc đua TOPS NPU mà còn có sự tham gia của AMD và Intel, và cuộc cạnh tranh này đang thúc đẩy hiệu suất NPU lên cao hơn. Năm 2023, trước khi Snapdragon X ra mắt, các chip AMD có NPU rất hiếm và những chip đó chỉ cung cấp khoảng 10 TOPS. Ngày nay, AMD và Intel đã có NPU cạnh tranh với Snapdragon, cung cấp từ 40 đến 50 TOPS.

Chiếc máy tính AI Pro Max Plus sắp ra mắt của Dell sẽ nâng cao tiêu chuẩn với NPU AI 100 của Qualcomm, hứa hẹn cung cấp tới 350 TOPS, cải thiện hiệu suất gấp 35 lần so với các NPU tốt nhất hiện có chỉ vài năm trước. Điều này cho thấy rằng các NPU có khả năng hàng nghìn TOPS chỉ còn cách chúng ta vài năm nữa.

Chúng ta cần bao nhiêu TOPS để chạy các mô hình tiên tiến với hàng trăm triệu tham số? Không ai biết chính xác. Hiện tại, không thể chạy những mô hình này trên phần cứng tiêu dùng ngày nay, vì vậy không thể thực hiện các bài kiểm tra thực tế. Nhưng có lý do để tin rằng chúng ta đang ở rất gần khả năng đó. Cũng cần lưu ý rằng các mô hình ngôn ngữ lớn không phải là trường hợp sử dụng duy nhất cho NPU. Vinesh Sukumar, người đứng đầu bộ phận AI và học máy của Qualcomm, cho biết việc tạo ra và chỉnh sửa hình ảnh AI là một ví dụ về nhiệm vụ khó khăn mà không có NPU hoặc GPU cao cấp.

Việc xây dựng các chip cân bằng hơn cho AI là điều cần thiết. Các NPU nhanh hơn sẽ xử lý nhiều token mỗi giây hơn, từ đó mang lại trải nghiệm nhanh hơn và mượt mà hơn khi sử dụng các mô hình AI. Tuy nhiên, còn nhiều yếu tố khác cần xem xét khi chạy AI trên phần cứng địa phương, không chỉ đơn giản là trang bị một NPU lớn hơn.

Mike Clark, kỹ sư thiết kế cấp cao tại AMD, cho biết các công ty thiết kế chip để tăng tốc AI trên PC không thể chỉ đặt cược vào NPU. Điều này một phần vì AI không phải là sự thay thế cho, mà là bổ sung cho các tác vụ mà một PC cần xử lý. “Chúng ta phải giỏi trong việc xử lý độ trễ thấp, các loại dữ liệu nhỏ hơn, và mã nhánh—các khối lượng công việc truyền thống. Chúng ta không thể từ bỏ điều đó, nhưng vẫn muốn giỏi trong AI,” Clark nói. Ông cũng lưu ý rằng “CPU được sử dụng để chuẩn bị dữ liệu” cho các khối lượng công việc AI, có nghĩa là một CPU không đủ mạnh có thể trở thành nút thắt cổ chai.

NPU cũng phải cạnh tranh hoặc hợp tác với GPU. Trên PC, điều này thường có nghĩa là một GPU cao cấp của AMD hoặc Nvidia với nhiều bộ nhớ tích hợp lớn. GPU Nvidia GeForce RTX 5090 có hiệu suất AI lên tới 3,352 TOPS, vượt xa cả Qualcomm AI 100.

Tuy nhiên, điều này đi kèm với một caveat lớn: năng lượng. Mặc dù rất mạnh mẽ, RTX 5090 được thiết kế để tiêu thụ tới 575 watt. Các phiên bản di động cho laptop tiết kiệm hơn nhưng vẫn tiêu thụ tới 175 watt, điều này có thể nhanh chóng làm cạn kiệt pin laptop.

Simon Ng, quản lý sản phẩm AI tại Intel, cho biết công ty đang “nhìn thấy rằng NPU sẽ thực hiện mọi thứ hiệu quả hơn với mức tiêu thụ năng lượng thấp hơn.” Rakesh Anigundi, giám đốc quản lý sản phẩm cho Ryzen AI của AMD, đồng ý. Ông thêm rằng hoạt động tiêu thụ năng lượng thấp là rất quan trọng vì các khối lượng công việc AI thường mất nhiều thời gian hơn để chạy so với các tác vụ đòi hỏi khác, như mã hóa video hoặc xử lý đồ họa. “Bạn sẽ muốn chạy điều này trong một khoảng thời gian dài hơn, chẳng hạn như một trợ lý cá nhân AI, có thể luôn hoạt động và lắng nghe lệnh của bạn,” ông nói.

Những ưu tiên cạnh tranh này có nghĩa là các kiến trúc sư chip và nhà thiết kế hệ thống sẽ cần phải đưa ra những quyết định khó khăn về cách phân bổ silicon và năng lượng trong các PC AI, đặc biệt là những chiếc thường dựa vào nguồn năng lượng từ pin, như laptop.

“Chúng ta phải rất cẩn thận trong cách thiết kế hệ thống trên một chip để đảm bảo rằng một SoC lớn hơn có thể hoạt động theo yêu cầu của chúng ta trong một hình thức mỏng và nhẹ,” Mahesh Subramony, kỹ sư thiết kế cấp cao tại AMD cho biết.

Khi nói đến AI, bộ nhớ cũng rất quan trọng. Việc tích hợp một NPU bên cạnh CPU và GPU sẽ cải thiện hiệu suất của PC trung bình trong các tác vụ AI, nhưng đó không phải là sự thay đổi cách mạng duy nhất mà AI sẽ buộc phải thay đổi kiến trúc PC. Còn một yếu tố khác có thể còn quan trọng hơn: bộ nhớ.

Hầu hết các PC hiện đại có kiến trúc bộ nhớ phân chia, bắt nguồn từ những quyết định được đưa ra cách đây hơn 25 năm. Những hạn chế về băng thông bus đã khiến GPU (và các thẻ mở rộng khác có thể yêu cầu bộ nhớ băng thông cao) phải chuyển sang sử dụng bộ nhớ riêng của GPU thay vì truy cập vào bộ nhớ hệ thống của PC. Kết quả là, các PC mạnh mẽ thường có hai vùng bộ nhớ, bộ nhớ hệ thống và bộ nhớ đồ họa, hoạt động độc lập.

Điều này là một vấn đề cho AI. Các mô hình yêu cầu một lượng lớn bộ nhớ, và toàn bộ mô hình phải được tải vào bộ nhớ cùng một lúc. Kiến trúc PC truyền thống, phân chia bộ nhớ giữa hệ thống và GPU, mâu thuẫn với yêu cầu đó.

“Khi tôi có một GPU rời, tôi có một hệ thống bộ nhớ riêng biệt treo bên cạnh,” Joe Macri, phó chủ tịch và giám đốc công nghệ tại AMD giải thích. “Khi tôi muốn chia sẻ dữ liệu giữa CPU và GPU, tôi phải lấy dữ liệu ra khỏi bộ nhớ của mình, trượt nó qua bus PCI Express, đưa vào bộ nhớ GPU, thực hiện xử lý, rồi lại chuyển tất cả trở lại.” Macri cho biết điều này làm tăng mức tiêu thụ năng lượng và dẫn đến trải nghiệm người dùng chậm chạp.

Giải pháp là một kiến trúc bộ nhớ thống nhất, cung cấp cho tất cả các tài nguyên hệ thống quyền truy cập vào cùng một vùng bộ nhớ qua một bus bộ nhớ nhanh và liên kết. Silicon của Apple có thể là ví dụ gần đây nhất nổi bật về chip có kiến trúc bộ nhớ thống nhất. Tuy nhiên, bộ nhớ thống nhất vẫn hiếm gặp trong các PC hiện đại.

AMD đang theo đuổi hướng đi này trong không gian laptop. Công ty đã công bố một dòng APU mới nhắm đến các laptop cao cấp, Ryzen AI Max, tại CES 2025. Ryzen AI Max đặt các lõi CPU Ryzen của công ty trên cùng một silicon với các lõi GPU mang thương hiệu Radeon, cộng với một NPU có khả năng 50 TOPS, trên một mảnh silicon duy nhất với kiến trúc bộ nhớ thống nhất. Nhờ đó, CPU, GPU và NPU có thể truy cập tối đa 128 GB bộ nhớ hệ thống, được chia sẻ giữa cả ba. AMD tin rằng chiến lược này là lý tưởng cho việc quản lý bộ nhớ và hiệu suất trong các PC tiêu dùng. “Bằng cách đưa tất cả vào dưới một đầu nhiệt duy nhất, toàn bộ mức tiêu thụ năng lượng trở thành thứ mà chúng tôi có thể quản lý,” Subramony cho biết.

Ryzen AI Max đã có mặt trên một số laptop, bao gồm HP Zbook Ultra G1a và Asus ROG Flow Z13. Nó cũng cung cấp sức mạnh cho Framework Desktop và một số mini desktop từ các thương hiệu ít nổi tiếng hơn, như GMKtec EVO-X2 AI mini PC.

Intel và Nvidia cũng sẽ tham gia vào cuộc chơi này, mặc dù theo một cách bất ngờ. Vào tháng 9, hai đối thủ trước đây đã công bố một liên minh để bán các chip kết hợp lõi CPU của Intel với lõi GPU của Nvidia. Mặc dù các chi tiết vẫn chưa được công bố, kiến trúc chip này có khả năng sẽ bao gồm bộ nhớ thống nhất và một NPU của Intel.

Những chip như vậy có khả năng thay đổi đáng kể kiến trúc PC nếu chúng được chấp nhận. Chúng sẽ cung cấp quyền truy cập vào các vùng bộ nhớ lớn hơn nhiều so với trước đây và tích hợp CPU, GPU và NPU vào một mảnh silicon duy nhất có thể được theo dõi và kiểm soát chặt chẽ. Những yếu tố này sẽ giúp dễ dàng hơn trong việc chuyển giao khối lượng công việc AI đến phần cứng phù hợp nhất để thực hiện tại một thời điểm nhất định.

Đáng tiếc là, chúng cũng sẽ làm cho việc nâng cấp và sửa chữa PC trở nên khó khăn hơn, vì các chip với kiến trúc bộ nhớ thống nhất thường gộp CPU, GPU, NPU và bộ nhớ vào một gói duy nhất, không thể tách rời trên bo mạch chính của PC. Điều này trái ngược với các PC truyền thống, nơi CPU, GPU và bộ nhớ có thể được thay thế riêng lẻ.

Cách tiếp cận tích cực của Microsoft đối với AI đang viết lại Windows. MacOS được biết đến với giao diện người dùng hấp dẫn và trực quan, và các chip Silicon của Apple có kiến trúc bộ nhớ thống nhất có thể hữu ích cho AI. Tuy nhiên, GPU của Apple không mạnh mẽ bằng những GPU tốt nhất được sử dụng trong các PC, và các công cụ AI của họ cho các nhà phát triển ít được áp dụng rộng rãi.

Chrissie Cremers, đồng sáng lập công ty tiếp thị tập trung vào AI Aigency Amsterdam, cho biết vào đầu năm nay rằng mặc dù cô ấy thích macOS, nhưng công ty của cô không sử dụng máy tính Mac cho công việc AI. “GPU trong máy tính để bàn Mac của tôi gần như không thể xử lý được quy trình làm việc AI của chúng tôi, và đó không phải là một chiếc máy tính cũ,” cô nói. “Tôi rất muốn họ bắt kịp ở đây, vì họ từng là công cụ sáng tạo.”

Điều này để lại một khoảng trống cho các đối thủ trở thành lựa chọn hàng đầu cho AI trên PC—và Microsoft biết điều đó. Microsoft đã ra mắt các PC Copilot+ tại hội nghị phát triển Build 2024 của công ty. Sự ra mắt gặp một số vấn đề, đặc biệt là việc phát hành không thành công tính năng chính, Windows Recall, sử dụng AI để giúp người dùng tìm kiếm bất cứ điều gì họ đã thấy hoặc nghe trên PC của mình. Tuy nhiên, sự ra mắt đã thành công trong việc thúc đẩy ngành công nghiệp PC hướng tới NPU, khi cả AMD và Intel đều giới thiệu các chip laptop mới với NPU nâng cấp vào cuối năm 2024.

Tại Build 2025, Microsoft cũng đã tiết lộ AI Foundry Local của Windows, một “ngăn xếp thời gian chạy” bao gồm một danh mục các mô hình ngôn ngữ lớn mã nguồn mở phổ biến. Trong khi các mô hình của Microsoft có sẵn, danh mục này bao gồm hàng ngàn mô hình mã nguồn mở từ Alibaba, DeepSeek, Meta, Mistral AI, Nvidia, OpenAI, Stability AI, xAI và nhiều hơn nữa.

Khi một mô hình được chọn và triển khai vào một ứng dụng, Windows thực hiện các tác vụ AI trên phần cứng địa phương thông qua runtime Windows ML, tự động chỉ định các tác vụ AI đến phần cứng CPU, GPU hoặc NPU phù hợp nhất cho công việc. AI Foundry cũng cung cấp các API cho việc truy xuất kiến thức địa phương và thích ứng hạng thấp (LoRA), các tính năng tiên tiến cho phép các nhà phát triển tùy chỉnh dữ liệu mà một mô hình AI có thể tham khảo và cách mà nó phản hồi. Microsoft cũng đã công bố hỗ trợ cho tìm kiếm ngữ nghĩa trên thiết bị và tạo ra thông tin bổ sung, các tính năng giúp các nhà phát triển xây dựng các công cụ AI tham chiếu thông tin cụ thể trên thiết bị.

“AI Foundry là về việc thông minh. Nó là về việc sử dụng tất cả các bộ xử lý có sẵn, hiệu quả và ưu tiên khối lượng công việc giữa CPU, NPU và các phần khác. Có rất nhiều cơ hội và không gian để cải thiện,” Bathiche nói.

Sự phát triển nhanh chóng của phần cứng PC có khả năng AI không chỉ là một nâng cấp dần dần. Nó báo hiệu một sự thay đổi sắp tới trong ngành công nghiệp PC có khả năng xóa bỏ những di sản cuối cùng của các kiến trúc PC được thiết kế trong những năm 80, 90 và đầu những năm 2000. Sự kết hợp giữa các NPU ngày càng mạnh mẽ, kiến trúc bộ nhớ thống nhất và các kỹ thuật tối ưu hóa phần mềm tinh vi đang thu hẹp khoảng cách hiệu suất giữa AI địa phương và AI dựa trên đám mây với tốc độ khiến ngay cả những người trong ngành cũng ngạc nhiên.

Nó cũng sẽ thúc đẩy các nhà thiết kế chip hướng tới các chip tích hợp hơn nữa có hệ thống bộ nhớ thống nhất và đưa CPU, GPU và NPU vào một mảnh silicon duy nhất—ngay cả trong các laptop và máy tính để bàn cao cấp. Subramony của AMD cho biết mục tiêu là để người dùng “mang theo một trạm làm việc mini trong tay, cho dù đó là cho các khối lượng công việc AI hay cho tính toán cao. Bạn sẽ không cần phải đến đám mây.”

Một sự thay đổi lớn như vậy sẽ không xảy ra ngay lập tức. Tuy nhiên, rõ ràng là nhiều người trong ngành công nghiệp PC đang cam kết tái tạo lại những chiếc máy tính mà chúng ta sử dụng hàng ngày theo cách tối ưu hóa cho AI. Vinesh Sukumar của Qualcomm thậm chí tin rằng các laptop tiêu dùng giá cả phải chăng, giống như các trung tâm dữ liệu, nên hướng tới trí tuệ nhân tạo tổng quát. “Tôi muốn một trí tuệ nhân tạo tổng quát hoàn chỉnh chạy trên các thiết bị Qualcomm,” ông nói. “Đó là điều mà chúng tôi đang cố gắng thúc đẩy.”