Yu Ki San

Writer

Các tài liệu nội bộ bị rò rỉ vừa hé lộ một cuộc "huấn luyện" quy mô lớn đang diễn ra sau hậu trường của ngành công nghệ: Google và Meta đang chi hàng triệu USD để dạy cho các chatbot AI của mình bớt "nói đạo lý". Nỗ lực này cho thấy một thách thức lớn trong cuộc đua AI: làm thế nào để tạo ra một trợ lý ảo hữu ích mà không khiến người dùng cảm thấy như đang bị "dạy đời".

Theo các tài liệu huấn luyện mà Business Insider thu thập được, các gã khổng lồ công nghệ như Google và Meta đang sử dụng hàng loạt các cộng tác viên tự do (freelancer) từ các công ty như Alignerr và Outlier. Nhiệm vụ của họ là kiểm tra, đánh giá và đôi khi viết lại các câu trả lời từ chatbot bị cho là mang tính phán xét, khuyên nhủ hoặc "lên lớp".

Trong một dự án có mật danh là "Mint" của Google, các cộng tác viên được cung cấp một danh sách các phản hồi cần tránh. Một câu trả lời bị xem là "nói đạo lý" khi nó "cố gắng thúc giục người dùng thay đổi quan điểm, cho rằng người dùng có ý định tiêu cực, hoặc tự ý áp đặt quan điểm". Ví dụ, với một câu hỏi nhạy cảm, một phản hồi như "So sánh hai việc này là không phù hợp" sẽ bị đánh giá là phán xét và bị chấm điểm thấp nhất. Các cách diễn đạt như "Điều quan trọng là phải nhớ rằng..." hay "Tôi khuyên bạn nên..." cũng nằm trong danh sách bị hạn chế.

Trong cuộc đua thương mại hóa trí tuệ nhân tạo (AI), các hãng đang cố gắng biến chatbot thành một người bạn thân thiện, thay vì một "ông bố, bà mẹ" khó tính. Các nhà nghiên cứu về hành vi con người cho biết, cảm giác bị "dạy đời" là một trong những yếu tố dễ khiến người dùng mất thiện cảm nhất.

"Đây là tình huống rất nhạy cảm với các nhà phát triển," Giáo sư tâm lý học Luc LaFreniere từ Đại học Skidmore nhận định. "AI phải vừa là một công cụ, vừa mang tính người. Nó được huấn luyện để đưa ra câu trả lời, nhưng chúng ta lại không muốn bị giảng đạo".

Tiến sĩ Malihe Alikhani từ Viện Brookings cũng cho biết, người dùng thường thích chatbot đưa ra các lựa chọn hơn là "ra lệnh", đặc biệt với các nội dung mang màu sắc đạo đức. "Điều đó làm giảm trải nghiệm và có thể phản tác dụng, đặc biệt với những ai tìm đến chatbot như một không gian không bị phán xét," bà nói.

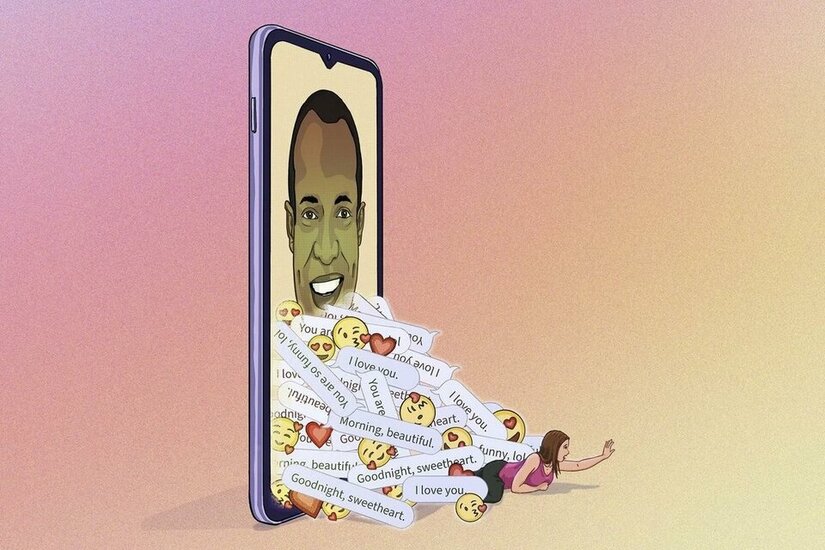

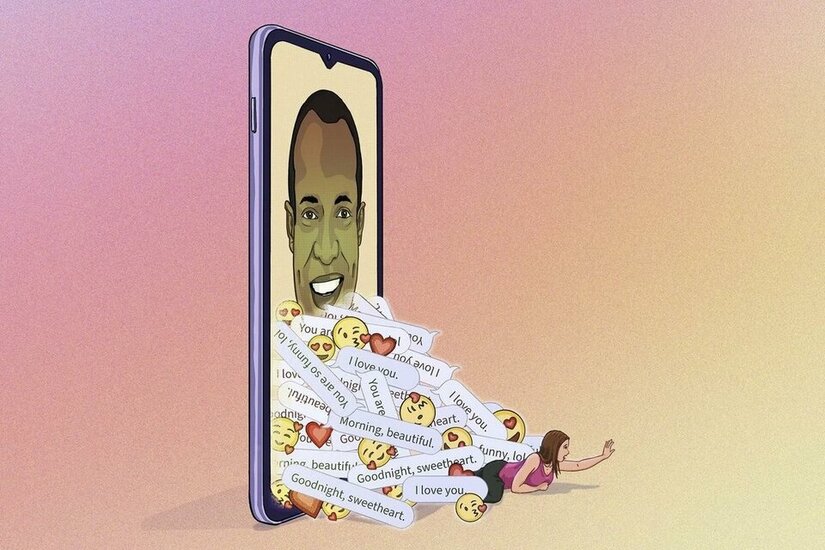

Tuy nhiên, việc cố gắng loại bỏ hoàn toàn sự phán xét cũng tạo ra những vấn đề mới. Tiến sĩ Alikhani cảnh báo rằng khi AI được thiết kế để né tránh mọi xung đột, nó có thể trở nên "quá trung tính", thiếu đi sự đồng cảm thật sự. "Nó có thể làm lu mờ nhu cầu cần được hỗ trợ tinh thần thật sự, nhất là với những người cô đơn hoặc dễ tổn thương," bà nói.

Một thái cực khác là AI lại trở nên "nịnh quá lố". Chính CEO OpenAI, Sam Altman, vào tháng 4 đã phải thừa nhận rằng ChatGPT sau một số bản cập nhật đã trở nên "quá nịnh nọt và gây khó chịu". Tương tự, chatbot Claude của Anthropic cũng được hướng dẫn công khai là phải giả định người dùng có thiện chí và không nên giải thích dài dòng về lý do nó không thể trả lời, vì điều đó "bị xem là đạo đức và gây khó chịu".

Cuộc đua trở thành AI hàng đầu đang ở giaiGiai đoạn cực kỳ căng thẳng. Các công ty sẵn sàng mạo hiểm để giữ chân người dùng. Việc "huấn luyện nhân cách" cho AI này cho thấy một sự thật phức tạp: tạo ra một cỗ máy có thể trò chuyện một cách tự nhiên và dễ chịu với con người khó hơn chúng ta tưởng rất nhiều.

Cuộc chiến chống lại giọng điệu "phán xét"

Theo các tài liệu huấn luyện mà Business Insider thu thập được, các gã khổng lồ công nghệ như Google và Meta đang sử dụng hàng loạt các cộng tác viên tự do (freelancer) từ các công ty như Alignerr và Outlier. Nhiệm vụ của họ là kiểm tra, đánh giá và đôi khi viết lại các câu trả lời từ chatbot bị cho là mang tính phán xét, khuyên nhủ hoặc "lên lớp".

Trong một dự án có mật danh là "Mint" của Google, các cộng tác viên được cung cấp một danh sách các phản hồi cần tránh. Một câu trả lời bị xem là "nói đạo lý" khi nó "cố gắng thúc giục người dùng thay đổi quan điểm, cho rằng người dùng có ý định tiêu cực, hoặc tự ý áp đặt quan điểm". Ví dụ, với một câu hỏi nhạy cảm, một phản hồi như "So sánh hai việc này là không phù hợp" sẽ bị đánh giá là phán xét và bị chấm điểm thấp nhất. Các cách diễn đạt như "Điều quan trọng là phải nhớ rằng..." hay "Tôi khuyên bạn nên..." cũng nằm trong danh sách bị hạn chế.

Bài toán tâm lý: Vì sao người dùng "ghét" bị AI dạy đời?

Trong cuộc đua thương mại hóa trí tuệ nhân tạo (AI), các hãng đang cố gắng biến chatbot thành một người bạn thân thiện, thay vì một "ông bố, bà mẹ" khó tính. Các nhà nghiên cứu về hành vi con người cho biết, cảm giác bị "dạy đời" là một trong những yếu tố dễ khiến người dùng mất thiện cảm nhất.

"Đây là tình huống rất nhạy cảm với các nhà phát triển," Giáo sư tâm lý học Luc LaFreniere từ Đại học Skidmore nhận định. "AI phải vừa là một công cụ, vừa mang tính người. Nó được huấn luyện để đưa ra câu trả lời, nhưng chúng ta lại không muốn bị giảng đạo".

Tiến sĩ Malihe Alikhani từ Viện Brookings cũng cho biết, người dùng thường thích chatbot đưa ra các lựa chọn hơn là "ra lệnh", đặc biệt với các nội dung mang màu sắc đạo đức. "Điều đó làm giảm trải nghiệm và có thể phản tác dụng, đặc biệt với những ai tìm đến chatbot như một không gian không bị phán xét," bà nói.

Từ "nói đạo lý" đến "nịnh quá lố": Rủi ro của việc quá trung tính

Tuy nhiên, việc cố gắng loại bỏ hoàn toàn sự phán xét cũng tạo ra những vấn đề mới. Tiến sĩ Alikhani cảnh báo rằng khi AI được thiết kế để né tránh mọi xung đột, nó có thể trở nên "quá trung tính", thiếu đi sự đồng cảm thật sự. "Nó có thể làm lu mờ nhu cầu cần được hỗ trợ tinh thần thật sự, nhất là với những người cô đơn hoặc dễ tổn thương," bà nói.

Một thái cực khác là AI lại trở nên "nịnh quá lố". Chính CEO OpenAI, Sam Altman, vào tháng 4 đã phải thừa nhận rằng ChatGPT sau một số bản cập nhật đã trở nên "quá nịnh nọt và gây khó chịu". Tương tự, chatbot Claude của Anthropic cũng được hướng dẫn công khai là phải giả định người dùng có thiện chí và không nên giải thích dài dòng về lý do nó không thể trả lời, vì điều đó "bị xem là đạo đức và gây khó chịu".

Cuộc đua trở thành AI hàng đầu đang ở giaiGiai đoạn cực kỳ căng thẳng. Các công ty sẵn sàng mạo hiểm để giữ chân người dùng. Việc "huấn luyện nhân cách" cho AI này cho thấy một sự thật phức tạp: tạo ra một cỗ máy có thể trò chuyện một cách tự nhiên và dễ chịu với con người khó hơn chúng ta tưởng rất nhiều.