Thảo Nông

Writer

Bạn đã bao giờ nghe đến cụm từ "kính hiển vi điện tử thực vật" (vegetative electron microscopy) chưa? Nghe có vẻ rất khoa học và chuyên sâu, nhưng sự thật là thuật ngữ này hoàn toàn vô nghĩa và không tồn tại trong bất kỳ ngành khoa học nào. Tuy nhiên, điều đáng kinh ngạc là cụm từ "ma" này đã âm thầm tồn tại suốt nhiều thập kỷ, len lỏi vào hàng chục bài báo khoa học, và giờ đây, nó còn "ám" vào cả bộ não của các mô hình Trí tuệ Nhân tạo (AI) hàng đầu như ChatGPT và Claude, đặt ra những câu hỏi đáng lo ngại về tính toàn vẹn của dữ liệu huấn luyện và độ tin cậy của AI.

Nguồn gốc ngớ ngẩn và hành trình lan truyền

Cuộc truy tìm nguồn gốc của "kính hiển vi điện tử thực vật" do các nhà khoa học Nga khởi xướng đã dẫn đến một phát hiện trớ trêu. Thuật ngữ này dường như được sinh ra từ lỗi của phần mềm nhận dạng ký tự quang học (OCR) cũ kỹ khi quét các bài báo khoa học từ những năm 1950. Phần mềm này đã vô tình ghép từ "vegetative" (thực vật) ở một cột văn bản với cụm "electron microscopy" (kính hiển vi điện tử) ở cột khác, tạo ra một thuật ngữ lai ghép vô nghĩa.

Nhiều thập kỷ sau, thuật ngữ ma này bất ngờ tái xuất hiện trong một số bài báo khoa học của các tác giả Iran vào năm 2017 và 2019, nghi ngờ do một lỗi dịch thuật từ tiếng Farsi (từ chỉ "quét" và "thực vật" rất giống nhau). Từ đó, nó bắt đầu lan truyền rộng hơn, xuất hiện trong ít nhất 22 bài báo được Google Scholar ghi nhận, bao gồm cả những bài đăng trên tạp chí của các nhà xuất bản uy tín như Springer Nature và Elsevier (sau đó đã phải thu hồi hoặc đính chính). Nó cũng trở nên phổ biến hơn trong các tạp chí "săn mồi" (predatory journals) chất lượng thấp sau năm 2020.

AI bị "nhiễm bẩn" và "hóa thạch số"

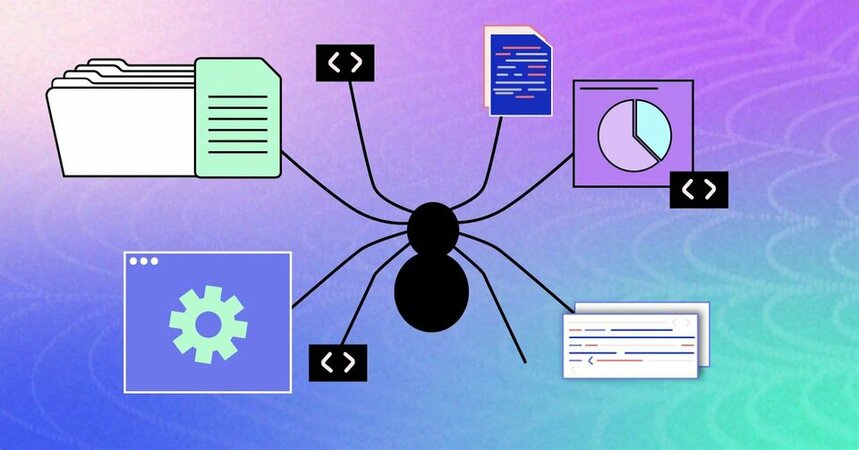

Sự lan truyền của "kính hiển vi điện tử thực vật" trên internet, đặc biệt là trong các văn bản khoa học (dù là chất lượng thấp), đã không thể tránh khỏi việc lọt vào các tập dữ liệu khổng lồ dùng để huấn luyện các mô hình AI ngôn ngữ lớn (LLM). Các nhà khoa học tại Đại học Công nghệ Queensland (Úc), dẫn đầu bởi Tiến sĩ Aaron Snoswell, đã tiến hành kiểm tra và xác nhận điều này.

Bằng cách đưa ra các đoạn văn bản gốc chứa lỗi và yêu cầu AI hoàn thành, họ phát hiện ra rằng các mô hình từ GPT-3 trở đi (bao gồm cả GPT-4o và Claude 3.5) đã "học" và liên tục gợi ý hoặc tự động hoàn thành bằng cụm từ vô nghĩa "kính hiển vi điện tử thực vật". Trong khi đó, các mô hình cũ hơn như GPT-2 hay BERT, vốn được huấn luyện trên dữ liệu cũ hơn, lại không hề biết đến thuật ngữ này. Nghiên cứu chỉ ra nguồn lây nhiễm khả dĩ nhất là tập dữ liệu CommonCrawl, một bộ sưu tập khổng lồ các trang web được thu thập tự động.

Việc AI học và tiếp tục lan truyền những thuật ngữ vô nghĩa này đặt ra một vấn đề nghiêm trọng. Do quy mô dữ liệu huấn luyện quá lớn và sự thiếu minh bạch từ các công ty AI, việc tìm và sửa chữa những "lỗi" như thế này là cực kỳ khó khăn, gần như bất khả thi. Tiến sĩ Snoswell gọi chúng là "hóa thạch số" (digital fossils) – những thông tin sai lệch bị kẹt lại vĩnh viễn trong nền tảng tri thức số của nhân loại và có nguy cơ được AI khuếch đại mãi mãi.

Câu chuyện về "kính hiển vi điện tử thực vật" là một lời cảnh báo mạnh mẽ về tầm quan trọng của chất lượng dữ liệu trong huấn luyện AI. Nó cho thấy AI, dù mạnh mẽ, vẫn chưa thể thay thế hoàn toàn khả năng đánh giá và kiểm duyệt của con người, đặc biệt là trong các lĩnh vực chuyên môn. Chúng ta cần phải hết sức cẩn trọng và luôn kiểm chứng thông tin do AI cung cấp, bởi rất có thể còn nhiều "thuật ngữ ma" khác đang ẩn mình trong đó, chờ ngày được "khai quật".

Nguồn gốc ngớ ngẩn và hành trình lan truyền

Cuộc truy tìm nguồn gốc của "kính hiển vi điện tử thực vật" do các nhà khoa học Nga khởi xướng đã dẫn đến một phát hiện trớ trêu. Thuật ngữ này dường như được sinh ra từ lỗi của phần mềm nhận dạng ký tự quang học (OCR) cũ kỹ khi quét các bài báo khoa học từ những năm 1950. Phần mềm này đã vô tình ghép từ "vegetative" (thực vật) ở một cột văn bản với cụm "electron microscopy" (kính hiển vi điện tử) ở cột khác, tạo ra một thuật ngữ lai ghép vô nghĩa.

Nhiều thập kỷ sau, thuật ngữ ma này bất ngờ tái xuất hiện trong một số bài báo khoa học của các tác giả Iran vào năm 2017 và 2019, nghi ngờ do một lỗi dịch thuật từ tiếng Farsi (từ chỉ "quét" và "thực vật" rất giống nhau). Từ đó, nó bắt đầu lan truyền rộng hơn, xuất hiện trong ít nhất 22 bài báo được Google Scholar ghi nhận, bao gồm cả những bài đăng trên tạp chí của các nhà xuất bản uy tín như Springer Nature và Elsevier (sau đó đã phải thu hồi hoặc đính chính). Nó cũng trở nên phổ biến hơn trong các tạp chí "săn mồi" (predatory journals) chất lượng thấp sau năm 2020.

AI bị "nhiễm bẩn" và "hóa thạch số"

Sự lan truyền của "kính hiển vi điện tử thực vật" trên internet, đặc biệt là trong các văn bản khoa học (dù là chất lượng thấp), đã không thể tránh khỏi việc lọt vào các tập dữ liệu khổng lồ dùng để huấn luyện các mô hình AI ngôn ngữ lớn (LLM). Các nhà khoa học tại Đại học Công nghệ Queensland (Úc), dẫn đầu bởi Tiến sĩ Aaron Snoswell, đã tiến hành kiểm tra và xác nhận điều này.

Bằng cách đưa ra các đoạn văn bản gốc chứa lỗi và yêu cầu AI hoàn thành, họ phát hiện ra rằng các mô hình từ GPT-3 trở đi (bao gồm cả GPT-4o và Claude 3.5) đã "học" và liên tục gợi ý hoặc tự động hoàn thành bằng cụm từ vô nghĩa "kính hiển vi điện tử thực vật". Trong khi đó, các mô hình cũ hơn như GPT-2 hay BERT, vốn được huấn luyện trên dữ liệu cũ hơn, lại không hề biết đến thuật ngữ này. Nghiên cứu chỉ ra nguồn lây nhiễm khả dĩ nhất là tập dữ liệu CommonCrawl, một bộ sưu tập khổng lồ các trang web được thu thập tự động.

Việc AI học và tiếp tục lan truyền những thuật ngữ vô nghĩa này đặt ra một vấn đề nghiêm trọng. Do quy mô dữ liệu huấn luyện quá lớn và sự thiếu minh bạch từ các công ty AI, việc tìm và sửa chữa những "lỗi" như thế này là cực kỳ khó khăn, gần như bất khả thi. Tiến sĩ Snoswell gọi chúng là "hóa thạch số" (digital fossils) – những thông tin sai lệch bị kẹt lại vĩnh viễn trong nền tảng tri thức số của nhân loại và có nguy cơ được AI khuếch đại mãi mãi.

Câu chuyện về "kính hiển vi điện tử thực vật" là một lời cảnh báo mạnh mẽ về tầm quan trọng của chất lượng dữ liệu trong huấn luyện AI. Nó cho thấy AI, dù mạnh mẽ, vẫn chưa thể thay thế hoàn toàn khả năng đánh giá và kiểm duyệt của con người, đặc biệt là trong các lĩnh vực chuyên môn. Chúng ta cần phải hết sức cẩn trọng và luôn kiểm chứng thông tin do AI cung cấp, bởi rất có thể còn nhiều "thuật ngữ ma" khác đang ẩn mình trong đó, chờ ngày được "khai quật".