Duy Linh

Writer

Các nhà nghiên cứu của Microsoft vừa công bố một kiểu tấn công kênh phụ tinh vi, cho phép kẻ xấu suy đoán chủ đề trò chuyện từ lưu lượng mạng mã hóa của các mô hình ngôn ngữ lớn. Dù dữ liệu được bảo vệ bằng Giao thức bảo mật lớp truyền tải (TLS), tin tặc vẫn có thể khai thác các mẫu về kích thước và thời gian gói tin để phân loại nội dung người dùng gửi đến chatbot AI.

Cuộc tấn công dựa trên lời thì thầm mới tiết lộ lời nhắc của người dùng ẩn bên trong lưu lượng AI được mã hóa

Nhóm nghiên cứu đã phối hợp với nhiều nhà cung cấp để triển khai biện pháp giảm thiểu, giúp các nền tảng AI và dịch vụ đối tác của Microsoft an toàn hơn trước mối đe dọa này.

Ngày nay, chatbot AI được sử dụng rộng rãi trong công việc, chăm sóc sức khỏe, pháp lý và cả trao đổi cá nhân, khiến bảo mật cuộc trò chuyện trở nên cực kỳ quan trọng. Cuộc tấn công Whisper Leak chứng minh rằng, ngay cả khi dữ liệu được mã hóa bằng HTTPS, siêu dữ liệu vẫn có thể tiết lộ chủ đề mà người dùng đang trao đổi.

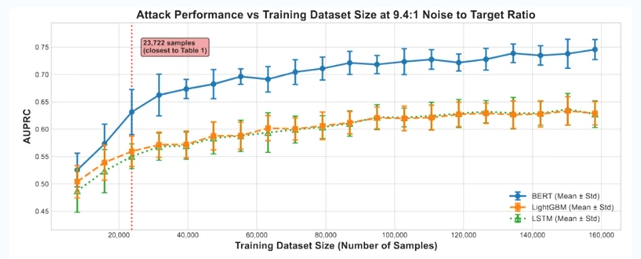

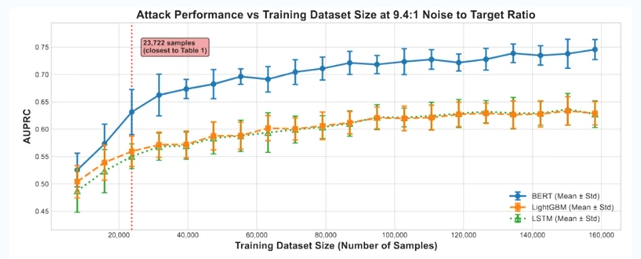

AUPRC so với khối lượng dữ liệu cho microsoft-gpt-4o bằng cách tấn công mô hình.

Trong các thử nghiệm, khi tập dữ liệu tăng, độ chính xác của cuộc tấn công cũng tăng tương ứng. Kẻ tấn công có thể lợi dụng quyền truy cập vào lưu lượng mạng như nhà mạng, tin tặc trong cùng mạng Wi-Fi, hay các tác nhân quốc gia để xác định xem cuộc trò chuyện có chứa chủ đề bị giám sát hay không. Nguy cơ đặc biệt nghiêm trọng tại các khu vực mà chính quyền giám sát chặt nội dung về biểu tình, bầu cử hoặc báo chí.

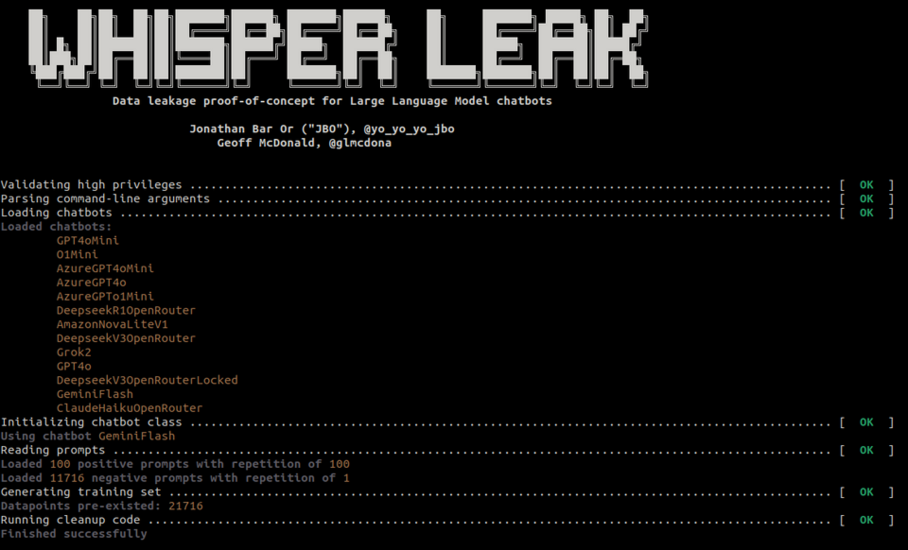

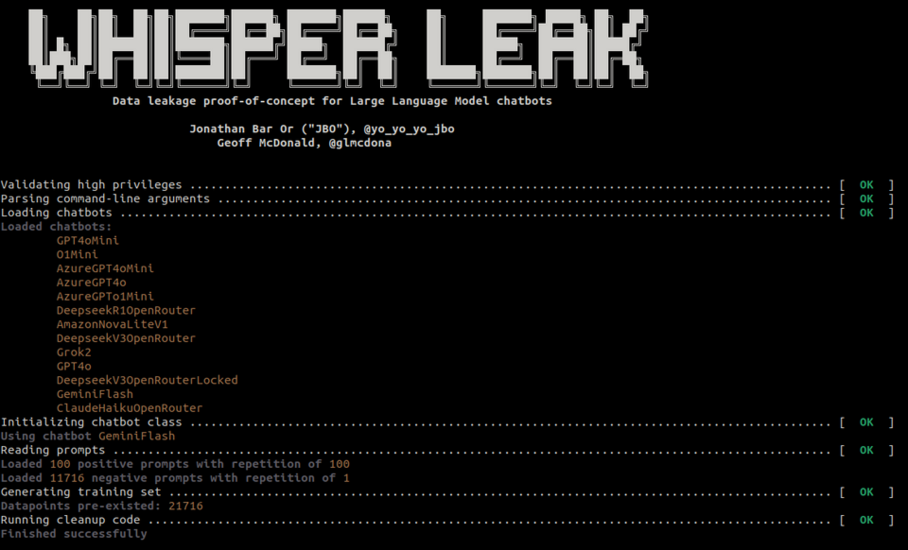

Rò rỉ tin đồn.

Để kiểm chứng, nhóm nghiên cứu đã huấn luyện các mô hình như LightGBM, Bi-LSTM và DistilBERT nhằm phân biệt lưu lượng liên quan đến chủ đề “hợp pháp hóa rửa tiền” với các lưu lượng nền. Kết quả cho thấy độ chính xác trên 98% trong môi trường kiểm soát. Trong mô phỏng 10.000 cuộc trò chuyện, chỉ cần một cuộc chứa chủ đề nhạy cảm, kẻ tấn công có thể phát hiện chính xác 100% mà không có dương tính giả.

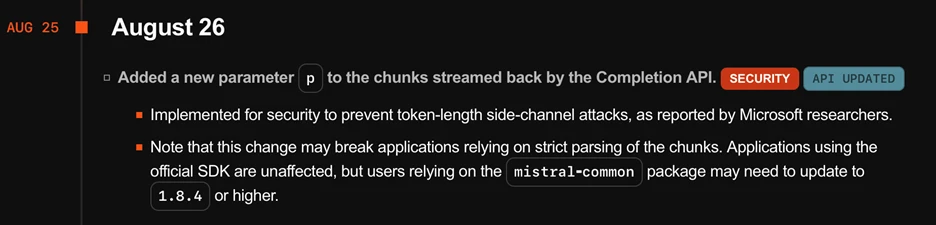

Microsoft, OpenAI, Mistral và xAI đã nhanh chóng triển khai các biện pháp giảm thiểu. OpenAI bổ sung trường “làm tối nghĩa” bằng cách chèn chuỗi văn bản ngẫu nhiên có độ dài thay đổi vào phản hồi, giúp che giấu độ dài mã thông báo. Microsoft Azure và Mistral áp dụng phương pháp tương tự, xác nhận hiệu quả giảm rủi ro xuống mức không đáng kể.

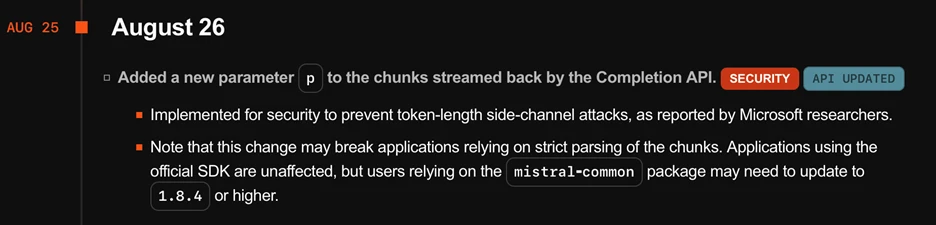

Tham số “p” mới được thêm vào API Mistral giúp giảm thiểu cuộc tấn công và ghi nhận nghiên cứu của chúng tôi.

Với người dùng, lời khuyên là không nên thảo luận chủ đề nhạy cảm qua chatbot khi dùng mạng công cộng. Sử dụng VPN, chọn nhà cung cấp đã triển khai biện pháp bảo vệ, hoặc tắt chế độ phản hồi trực tuyến sẽ giúp giảm thiểu nguy cơ.

Toàn bộ mã nguồn và mô hình của nghiên cứu được công khai trên GitHub (dưới tên Whisper Leak) theo giấy phép MIT, giúp cộng đồng an ninh mạng kiểm chứng, phát triển thêm biện pháp phòng vệ và nâng cao hiểu biết về rò rỉ kênh phụ trong AI.

Đọc chi tiết tại đây: https://gbhackers.com/whisper-based-attack/

Cuộc tấn công dựa trên lời thì thầm mới tiết lộ lời nhắc của người dùng ẩn bên trong lưu lượng AI được mã hóa

Nhóm nghiên cứu đã phối hợp với nhiều nhà cung cấp để triển khai biện pháp giảm thiểu, giúp các nền tảng AI và dịch vụ đối tác của Microsoft an toàn hơn trước mối đe dọa này.

Ngày nay, chatbot AI được sử dụng rộng rãi trong công việc, chăm sóc sức khỏe, pháp lý và cả trao đổi cá nhân, khiến bảo mật cuộc trò chuyện trở nên cực kỳ quan trọng. Cuộc tấn công Whisper Leak chứng minh rằng, ngay cả khi dữ liệu được mã hóa bằng HTTPS, siêu dữ liệu vẫn có thể tiết lộ chủ đề mà người dùng đang trao đổi.

AUPRC so với khối lượng dữ liệu cho microsoft-gpt-4o bằng cách tấn công mô hình.

Trong các thử nghiệm, khi tập dữ liệu tăng, độ chính xác của cuộc tấn công cũng tăng tương ứng. Kẻ tấn công có thể lợi dụng quyền truy cập vào lưu lượng mạng như nhà mạng, tin tặc trong cùng mạng Wi-Fi, hay các tác nhân quốc gia để xác định xem cuộc trò chuyện có chứa chủ đề bị giám sát hay không. Nguy cơ đặc biệt nghiêm trọng tại các khu vực mà chính quyền giám sát chặt nội dung về biểu tình, bầu cử hoặc báo chí.

Cách thức hoạt động và biện pháp bảo vệ

Các mô hình ngôn ngữ tạo phản hồi theo từng mã thông báo, phát trực tiếp đến người dùng thay vì chờ toàn bộ câu trả lời. Việc truyền phát này, kết hợp với mã hóa đối xứng trong TLS, tạo ra các mẫu dữ liệu có thể bị phân tích. Kích thước gói tin và thời gian truyền phản ánh độ dài văn bản gốc, từ đó bị lợi dụng để phân loại chủ đề.

Rò rỉ tin đồn.

Để kiểm chứng, nhóm nghiên cứu đã huấn luyện các mô hình như LightGBM, Bi-LSTM và DistilBERT nhằm phân biệt lưu lượng liên quan đến chủ đề “hợp pháp hóa rửa tiền” với các lưu lượng nền. Kết quả cho thấy độ chính xác trên 98% trong môi trường kiểm soát. Trong mô phỏng 10.000 cuộc trò chuyện, chỉ cần một cuộc chứa chủ đề nhạy cảm, kẻ tấn công có thể phát hiện chính xác 100% mà không có dương tính giả.

Microsoft, OpenAI, Mistral và xAI đã nhanh chóng triển khai các biện pháp giảm thiểu. OpenAI bổ sung trường “làm tối nghĩa” bằng cách chèn chuỗi văn bản ngẫu nhiên có độ dài thay đổi vào phản hồi, giúp che giấu độ dài mã thông báo. Microsoft Azure và Mistral áp dụng phương pháp tương tự, xác nhận hiệu quả giảm rủi ro xuống mức không đáng kể.

Tham số “p” mới được thêm vào API Mistral giúp giảm thiểu cuộc tấn công và ghi nhận nghiên cứu của chúng tôi.

Với người dùng, lời khuyên là không nên thảo luận chủ đề nhạy cảm qua chatbot khi dùng mạng công cộng. Sử dụng VPN, chọn nhà cung cấp đã triển khai biện pháp bảo vệ, hoặc tắt chế độ phản hồi trực tuyến sẽ giúp giảm thiểu nguy cơ.

Toàn bộ mã nguồn và mô hình của nghiên cứu được công khai trên GitHub (dưới tên Whisper Leak) theo giấy phép MIT, giúp cộng đồng an ninh mạng kiểm chứng, phát triển thêm biện pháp phòng vệ và nâng cao hiểu biết về rò rỉ kênh phụ trong AI.

Đọc chi tiết tại đây: https://gbhackers.com/whisper-based-attack/

Được phối hợp thực hiện bởi các chuyên gia của Bkav,

cộng đồng An ninh mạng Việt Nam WhiteHat

và cộng đồng Khoa học công nghệ VnReview